一、TJA1042T/3-CAN通信硬件连接

TJA1042T/3芯片有休眠模式,可以通过中断(低电平)唤醒,因此其STB和RXD引脚上通过上拉电阻接高电平,CAN_EN和CAN_RX引脚在MCU端是接在一起的,这样当CAN_RX引脚有显性电平时,会将STB引脚拉低,此芯片就从休眠模式进入正常模式。

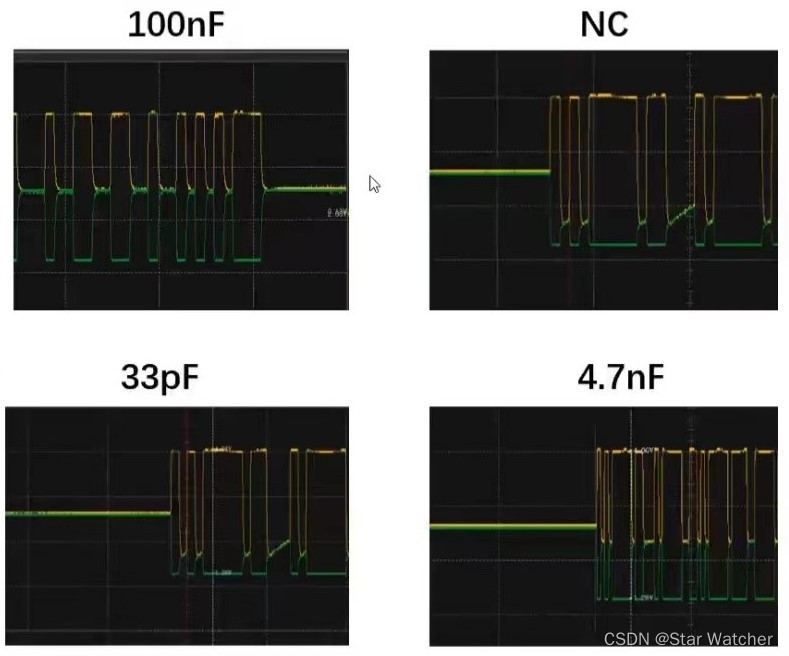

C4的作用为降低差模干扰,稳定隐性电平,其值选择0.1uF最合适,可由下面几幅图片对比得到。

(本设计选用的CAN收发器需要5V供电,为了方便,也可以选择3.3V供电的SIT3051TK。)

从上面四幅图可以看出,只有电容取为100nF时,CANH和CANL的波形是对称的,即两线电平变化幅度和速率相等。

R2、R6两个电阻起到限制瞬间电流的作用,可以提高防护能力。DT5起到抑制瞬间高电压的作用,与DT1组合起来实现差模、共模的防浪涌和静电。

最后的两个自恢复保险丝起到高压防护的作用,选择F1206的封装即可。

本文详细介绍了TJA1042T/3-CAN通信硬件连接设置,包括电容选择、电阻作用以及STM32F407ZGT6的CAN发送与接收过程,涉及CAN通信原理、ID转换和中断管理。

本文详细介绍了TJA1042T/3-CAN通信硬件连接设置,包括电容选择、电阻作用以及STM32F407ZGT6的CAN发送与接收过程,涉及CAN通信原理、ID转换和中断管理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1380

1380

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?