首先对原始数据进行不重叠样本切割(1024的长度) ,正常、内圈故障、滚动体故障和外圈故障每类取100个样本,然后将一维样本经过小波变换转变成图像,也就是生成400张照片,前100张(图像名称0-99.jpg)是正常类型图像,(图像名称100-199.jpg)是内圈故障;(图像名称200-299.jpg)是滚动体故障;(图像名称300-399.jpg)是外圈故障。

目前图像大小是(8,4),代码里有注释,可以修改。

0HP数据集开始位置

0HP数据集截止位置

其它负载(1HP,2HP,3HP数据集与此类似,不再列举)

1.2.JNU数据集(江南大学轴承数据集),表格.csv文件

以600rpm转速数据集为例

首先对原始数据进行不重叠样本切割(1024的长度) ,正常、内圈故障、滚动体故障和外圈故障每类取150个样本,然后将一维样本经过小波变换转变成图像,也就是生成600张照片,前150张(图像名称0-149.jpg)是正常类型图像,(图像名称150-299.jpg)是内圈故障;(图像名称300-449.jpg)是滚动体故障;(图像名称450-599.jpg)是外圈故障。

目前图像大小是(8,4),代码里有注释,可以修改。

江南大学轴承数据集(600rpm数据集开始位置)

江南大学轴承数据集(600rpm数据集截止位置)

对项目感兴趣的,可以关注(两个数据集变换在一起的压缩包)

import numpy as np

import pandas as pd

#from sklearn.model_selection import train_test_split

from collections import Counter

import pywt

import matplotlib.pyplot as plt

from sklearn.preprocessing import MinMaxScaler

#压缩包:https://mbd.pub/o/bread/mbd-ZZ2Ykplt

2.1.灰度图像生成(待续)

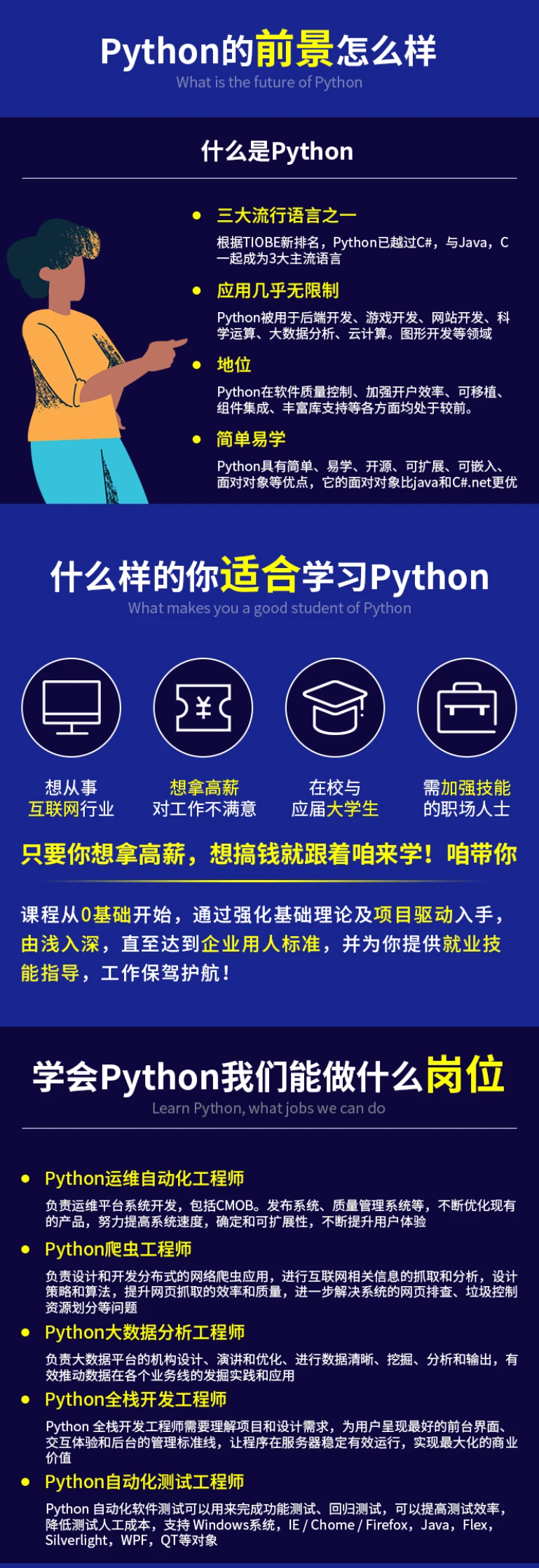

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

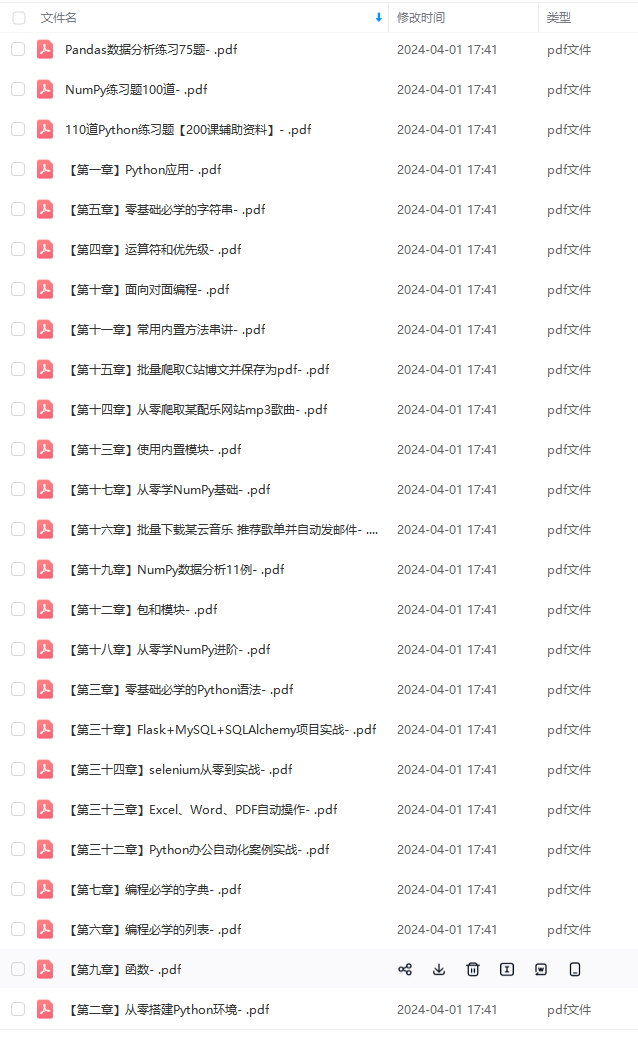

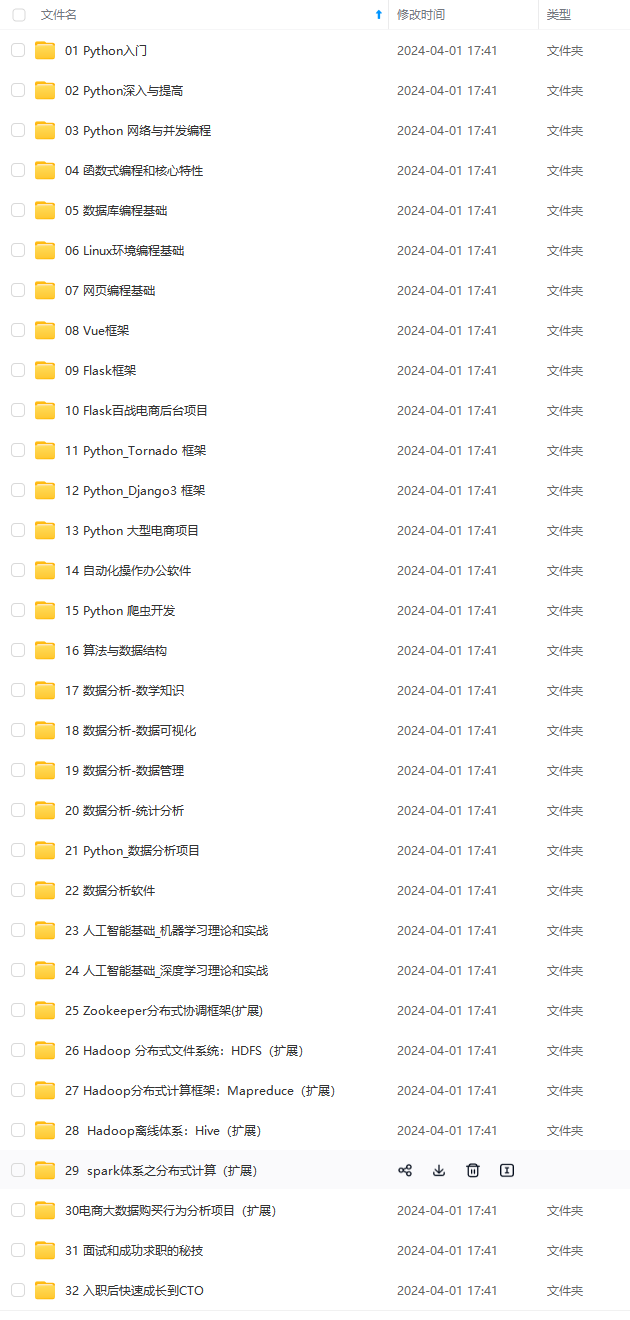

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注Python)

出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新**

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注Python)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?