我们的训练可以通过在训练期间逐渐增加图像大小来进一步加快。之前的许多作品,例如渐进式调整大小(Howard,2018),FixRes(Touvron等,2019)和Mix&Match(Hoffer等,2019),在训练中都使用了较小的图像尺寸;然而,它们通常对所有图像尺寸保持相同的正则化,从而导致精度下降。我们认为对于不同的图像大小保持相同的正则化并不理想:对于同一网络,较小的图像大小会导致较小的网络容量,因此需要较弱的正则化;反之亦然,大图像尺寸需要更强的正则化以对抗过拟合(参见第 4.1 节)。基于这一见解,我们提出了一种改进的渐进学习方法:在早期的训练时期,我们用小图像尺寸和弱正则化(例如,辍学和数据增强)训练网络,然后我们逐渐增加图像尺寸并添加更强的正则化.基于渐进式调整大小 (Howard, 2018),但通过动态调整正则化,我们的方法可以加快训练速度,而不会导致准确率下降。

通过改进的渐进式学习,我们的 EfficientNetV2 在 ImageNet、CIFAR-10、CIFAR-100、Cars 和 Flowers 数据集上取得了不错的成绩。在 ImageNet 上,我们实现了 85.7% 的 top-1 准确率,同时训练速度提高了 3 到 9 倍,并且比以前的模型小了 6.8 倍(图 1)。我们的 EfficientNetV2 和渐进式学习还可以更轻松地在更大的数据集上训练模型。例如,ImageNet21k (Russakovsky et al., 2015) 比 ImageNet ILSVRC2012 大 10 倍左右,但我们的 EfficientNetV2 可以使用 32 个 TPUv3 核心的中等计算资源在两天内完成训练。通过在公共 ImageNet21k 2 上进行预训练,我们的 EfficientNetV2 在 ImageNet ILSVRC2012 上达到了 87.3% 的 top-1 准确率,比最近的 ViT-L/16 的准确率高 2.0%,同时训练速度提高了 5 到 11 倍(图 1)。

我们的贡献有三方面:

• 我们引入了 EfficientNetV2,这是一个新的更小、更快的模型系列。 通过我们的训练感知NAS 和扩展发现,EfficientNetV2 在训练速度和参数效率方面都优于以前的模型。

• 我们提出了一种改进的渐进式学习方法,它可以根据图像大小自适应地调整正则化。 我们表明它可以加快训练速度,同时提高准确性。

• 我们在 ImageNet、CIFAR、Cars 和 Flowers 数据集上展示了比现有技术快 11 倍的训练速度和 6.8 倍的参数效率。

神经架构搜索 (NAS):通过自动化网络设计过程,NAS 已被用于优化图像分类(Zoph 等人,2018 年)、对象检测(Chen 等人,2019 年;Tan 等人, 2020),分割(Liu等人,2019),超参数(Donget等人,2020)和其他应用程序(Elsken等人,2019)。以前的 NAS 工作主要集中在提高 FLOPs 效率(Tan & Le, 2019b;a)或推理效率(Tan et al., 2019; Cai et al., 2019; Wu et al., 2019; Li et al., 2021) .与之前的工作不同,本文使用 NAS 来优化训练和参数效率。

3. EfficientNetV2 架构设计

=======================

在本节中,我们研究了 EfficientNet (Tan & Le, 2019a) 的训练瓶颈,并介绍了我们的训练感知 NAS 和扩展,以及 EfficientNetV2 模型。

3.1. 回顾 EfficientNet

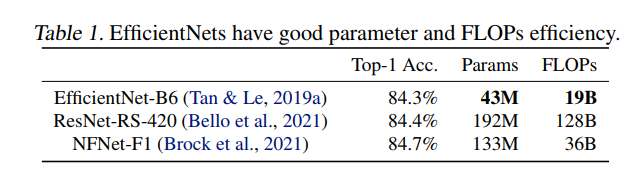

EfficientNet (Tan & Le, 2019a) 是一系列针对 FLOP 和参数效率进行了优化的模型。它利用NAS搜索基线EfficientNet-B0,该基线在精度和FLOP方面具有更好的权衡。然后使用复合缩放策略放大基线模型以获得模型 B1-B7 的家族。虽然最近的工作声称在训练或推理速度方面取得了巨大进步,但它们在参数和 FLOP 效率方面通常比 EfficientNet 差(表 1)。在本文中,我们的目标是在保持参数效率的同时提高训练速度。

3.2.了解训练效率

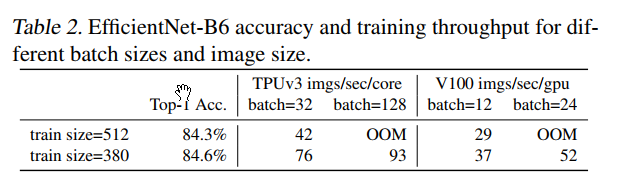

我们研究了 EfficientNet (Tan & Le, 2019a) 的训练瓶颈,以下也称为 EfficientNetV1,以及一些提高训练速度的简单技术。使用非常大的图像尺寸进行训练很慢:正如之前的作品 (Radosavovic et al., 2020) 所指出的那样,EfficientNet 的大图像尺寸会导致大量内存使用。由于 GPU/TPU 上的总内存是固定的,我们必须以较小的批大小训练这些模型,这大大减慢了训练速度。一个简单的改进是应用 FixRes(Touvron 等人,2019 年),通过使用比推理更小的图像尺寸进行训练。如表 2 所示,较小的图像尺寸导致较少的计算并支持大批量,从而将训练速度提高多达 2.2 倍。值得注意的是,正如 (Touvron et al., 2020; Brock et al., 2021) 中所指出的,使用较小的图像尺寸进行训练也会导致准确性稍好一些。但与 (Touvron et al., 2019) 不同的是,我们不会在训练后对任何层进行微调。在第 4 节中,我们将探索更高级的训练方法,通过在训练期间逐步调整图像大小和正则化

Depthwise convolutions在早期层中很慢:EfficientNet 的另一个训练瓶颈来自广泛的Depthwise convolutions(Sifre,2014)。 Depthwise 卷积比常规卷积具有更少的参数和 FLOP,但它们通常不能充分利用现代加速器。最近,Fused-MBConv 在 (Gupta & Tan, 2019) 中提出,后来在 (Gupta & Akin, 2020; Xiong et al., 2020; Li et al., 2021) 中使用,以更好地利用移动或服务器加速器。如图2所示,它用单个常规conv3x3替换了MBConv中的深度conv3x3和扩展conv1x1(Sandler等人,2018; Tan&Le,2019a),如图2所示。为了系统地比较这两个构件,我们逐步替换了原始的MBConv在 EfficientNetB4 中使用 Fused-MBConv(表 3)。在早期阶段 1-3 中应用时,Fused-MBConv 可以在参数和 FLOPs 的开销很小的情况下提高训练速度,但是如果我们用 Fused-MBConv(阶段 1-7)替换所有块,那么它会显着增加参数和 FLOPs,同时也减慢了训练。找到这两个构建块 MBConv 和 Fused-MBConv 的正确组合非常重要,这促使我们利用神经架构搜索来自动搜索最佳组合。

我们的训练可以通过在训练期间逐渐增加图像大小来进一步加快。之前的许多作品,例如渐进式调整大小(Howard,2018),FixRes(Touvron等,2019)和Mix&Match(Hoffer等,2019),在训练中都使用了较小的图像尺寸;然而,它们通常对所有图像尺寸保持相同的正则化,从而导致精度下降。我们认为对于不同的图像大小保持相同的正则化并不理想:对于同一网络,较小的图像大小会导致较小的网络容量,因此需要较弱的正则化;反之亦然,大图像尺寸需要更强的正则化以对抗过拟合(参见第 4.1 节)。基于这一

我们的训练可以通过在训练期间逐渐增加图像大小来进一步加快。之前的许多作品,例如渐进式调整大小(Howard,2018),FixRes(Touvron等,2019)和Mix&Match(Hoffer等,2019),在训练中都使用了较小的图像尺寸;然而,它们通常对所有图像尺寸保持相同的正则化,从而导致精度下降。我们认为对于不同的图像大小保持相同的正则化并不理想:对于同一网络,较小的图像大小会导致较小的网络容量,因此需要较弱的正则化;反之亦然,大图像尺寸需要更强的正则化以对抗过拟合(参见第 4.1 节)。基于这一

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5630

5630

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?