2.4 推荐论文

《Gradient-Based Learning Applied to Document Recognition》

《ImageNet Classification with Deep Convolutional Neural Networks》

三、空洞卷积

3.1 空洞卷积运行原理

空洞卷积也被称为膨胀卷积。感受野是卷积神经网络中非常重要的概念,空洞卷积的目的就在于扩大感受野,以提升模型的性能。空洞卷积的运行原理跟卷积非常类似,唯一不同之处在于空洞卷积引入了一个**扩张率(dilated rate)**的概念,可以认为,普通卷积是空洞卷积的一种情形,普通卷积的扩张率默认为1。

以下分别是dilated rate=1、dilated rate=6、dilated rate=24的空洞卷积案例:

3.2 推荐论文

关于空洞卷积的详细介绍可以查阅大名鼎鼎的DeepLab系列论文,以下分别是DeepLab v2和DeepLab v3。

《DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs》

《Rethinking Atrous Convolution for Semantic Image Segmentation》

四、转置卷积

转置卷积也被称为反卷积,顾名思义,转置卷积的操作与卷积操作是相反的,转置卷积常用于上采样阶段。什么是上采样,之后会有一篇文章专门来介绍常见的上采样方式,包括转置卷积、最近邻插值、双线性插值等等,由于转置卷积更偏向于上采样阶段,而该篇文章会更加偏向于提取特征的卷积方式,因此转置卷积会在之后的上采样篇进行详细阐述。

五、可分离卷积

可分离卷积分为空间可分离卷积和深度可分离卷积。

5.1 空间可分离卷积

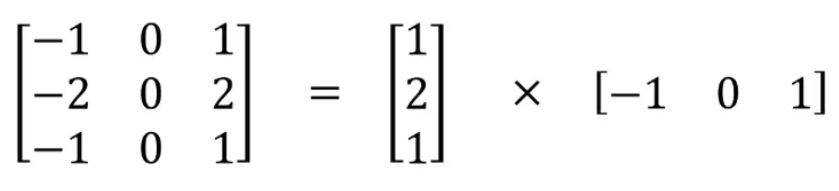

空间可分离卷积是利用矩阵乘法的性质来设计的,具体请看以下的案例,假设卷积核size为3_3,那么这个卷积核可以看作是一个3_1的向量与1*3向量的乘法。这样做的好处在于减少了模型的参数,减少了乘法的计算量。

5.2 深度可分离卷积

重点介绍深度可分离卷积,该卷积我愿称之为卷积神经网络中令人拍案叫绝的操作之一,深度可分离卷积分为2步,第1步是利用每个卷积核分别对输入图像的1个通道进行卷积,第2步是扩充深度,具体的运行原理如图(图来源)所示。

普通的卷积过程是使用与输入图像通道数相同的卷积核将输入图像输出为通道为1的特征图,而深度可分离卷积则是分别使用 3 个卷积核(每个卷积核的大小为 3 x 3 x 1),而不使用大小为 3 x 3 x 3 的卷积核,每个卷积核仅对输入图像的 1 个通道做卷积,这样的卷积每次都得出大小为 5 x 5 x 1 的映射,之后再将这些映射堆叠在一起创建一个 5 x 5 x 3 的图像,最终得出一个大小为 5 x 5 x 3 的输出图像。这样的话,图像的深度保持与原来的一样。

深度可分离卷积的第2步是扩充深度,我们用大小为 1x1x3 的卷积核做 1x1 卷积。每个 1x1x3 卷积核对 5 x 5 x 3 输入图像做卷积后都得出一个大小为 5 x 5 x1 的映射。

做 128 次 1x1 卷积后,就可以得出一个大小为 5 x 5 x 128 的特征图。

深度可分离卷积的完整过程如下图所示。

5.3 推荐论文

《Xception: Deep Learning with Depthwise Separable Convolutions》

六、3D卷积

从名字中就可以明白3D卷积的大致意思了,普通卷积是在2维空间上进行卷积操作,3D卷积无非就是在3维空间上进行卷积操作。可以看到,3D卷积无非是2D卷积在通道维度上进行了扩展,3D 卷积核可以沿着 3 个方向移动(高、宽以及图像的通道),跟2D卷积并没有特别大的区别。如下图(图来源)所示:

七、分组卷积

7.1 分组卷积原理

分组卷积首次提出是在鼎鼎大名的AlexNet,详细了解AlexNet可以看我这篇博客AlexNet,非常详细,分组卷积的提出为了解决GPU算力不足的问题,训练AlexNet时卷积操作不能全部放在同一个GPU处理,因此作者把feature maps分给多个GPU分别进行处理,最后把多个GPU的结果进行融合。在普通卷积中,所有的卷积核一股脑的对输入图进行卷积。

在分组卷积中,卷积核被拆分为不同的组,每一个组都负责具有一定深度的普通卷积的操作。下图(图来源)可以更为直观的表现分组卷积的运行原理。

7.2 推荐论文

推荐大家阅读下面这篇论文AlexNet,该篇论文可以称为是卷积神经网络的开山鼻祖之一,很经典。

《ImageNet Classification with Deep Convolutional Neural Networks》

参考文献

《深度学习入门-基于Python的理论与实现》

《ImageNet Classification with Deep ConvolutionalNeural Networks》

《Gradient-Based Learning Applied to Document Recognition》

《ImageNet Classification with Deep Convolutional Neural Networks》

https://blog.csdn.net/gwplovekimi/article/details/89890510

《Xception: Deep Learning with Depthwise Separable Convolutions》

计划 – 深度学习系列

都2021年了,不会还有人连深度学习还不了解吧?(一)-- 激活函数篇

都2021年了,不会还有人连深度学习还不了解吧?(二)-- 卷积篇

都2021年了,不会还有人连深度学习还不了解吧?(三)-- 损失函数篇

都2021年了,不会还有人连深度学习还不了解吧?(四)-- 上采样篇

都2021年了,不会还有人连深度学习还不了解吧?(五)-- 下采样篇

都2021年了,不会还有人连深度学习还不了解吧?(六)-- Padding篇

都2021年了,不会还有人连深度学习还不了解吧?(七)-- 评估指标篇

最后

各位读者,由于本篇幅度过长,为了避免影响阅读体验,下面我就大概概括了整理了

影响阅读体验,下面我就大概概括了整理了

[外链图片转存中…(img-c2w5vTUQ-1714812514107)]

[外链图片转存中…(img-2xfFdsoc-1714812514108)]

[外链图片转存中…(img-TdkKATaf-1714812514108)]

[外链图片转存中…(img-GIPaRW77-1714812514108)]

3064

3064

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?