先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

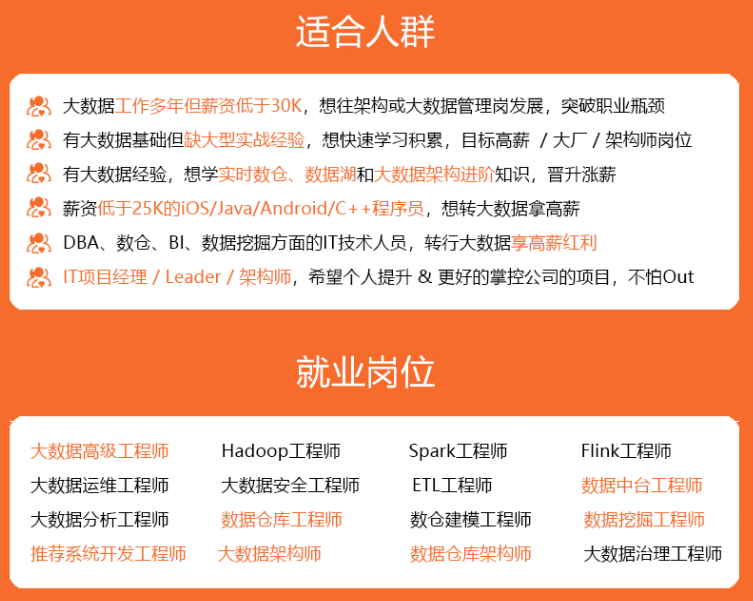

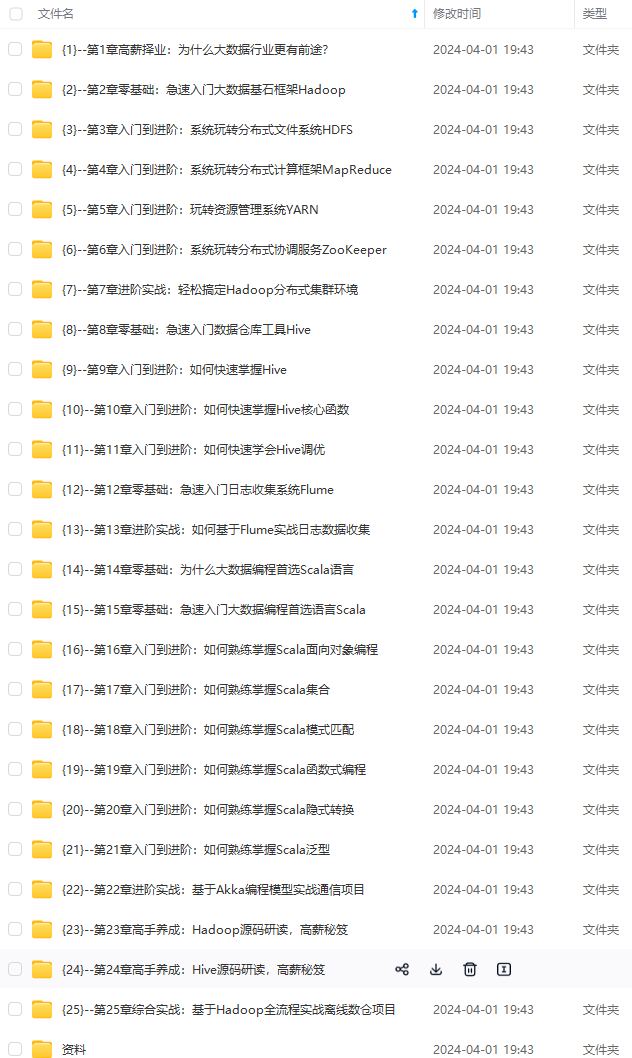

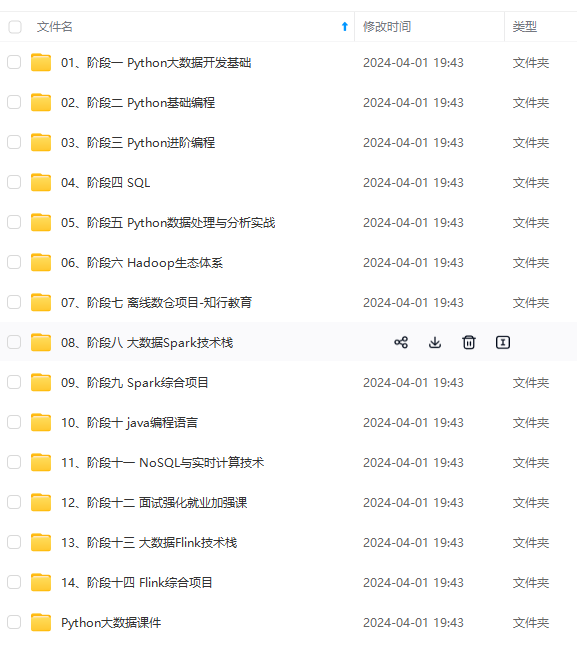

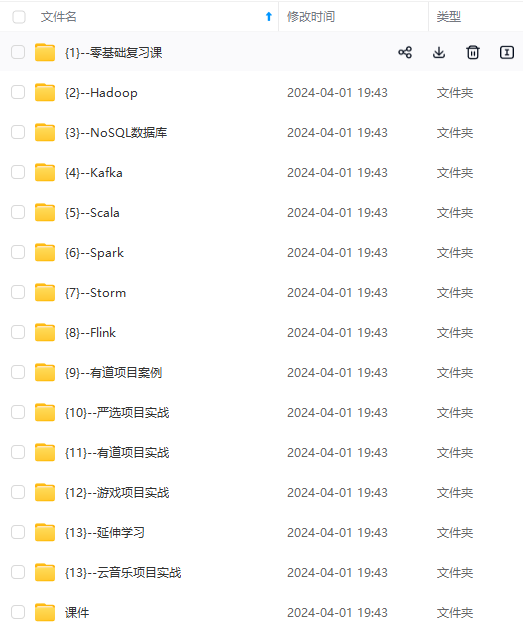

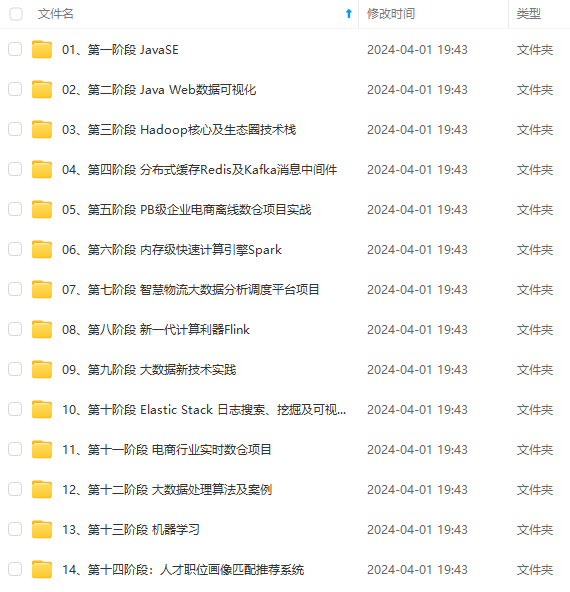

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

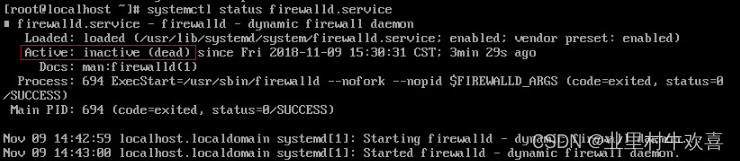

systemctl status firewalld.service

systemctl stop firewalld.service

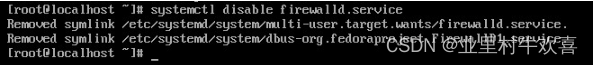

systemctl disable firewalld.service

2.8 设置主机名

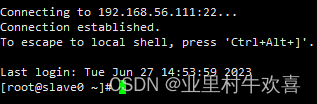

先在master服务器上操作’,输入下面命令

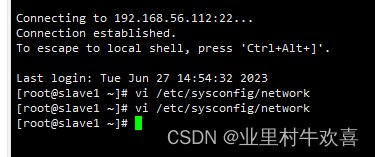

vi /etc/sysconfig/network

再次修改主机名字,将hostname中内容删除掉,增加mastert名字操作

vi /etc/hostname

按照上述操作方法,将其他的虚拟机更改主机名字,对应的slave0,slave1都修改。修改完记得重启验证一下,主机名字是否更变。

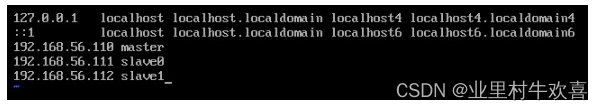

2.9 hosts设置

使用计算机名进行网络访问,需要修改vi /etc/hosts 文件中的主机名与IP地址的对照列表。三台服务器都需要配置一下(master,slave0,slave1)

免密钥登陆配置

首先在master服务器下面生成秘钥

ssh-keygen -t rsa

然后按四次回车,出现下面内容

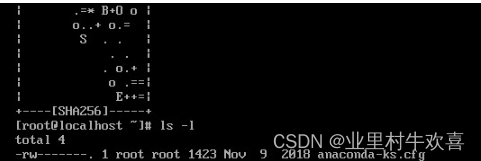

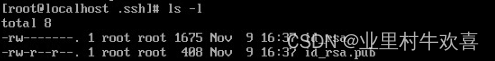

进入根目录文件夹中

cd ~/.ssh

ls -l

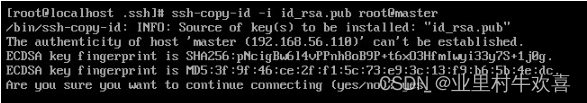

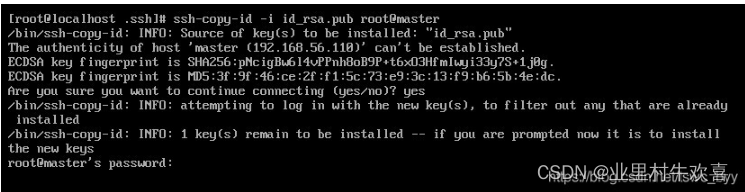

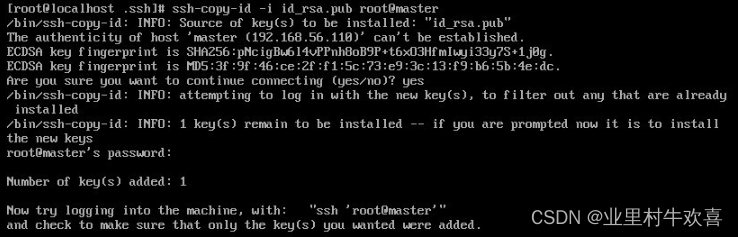

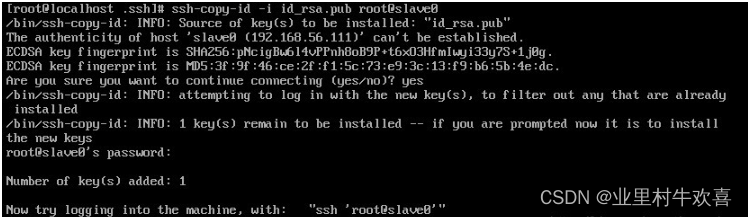

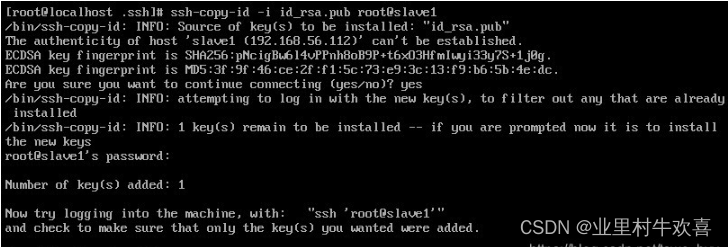

然后输入下面命令把公钥文件发送到自己和其它服务器还有发送自己了。

ssh-copy-id -i id_rsa.pub root@master

输入Yes,一直接收

输入root密码

成功后出现下面内容

然后再分别发送给slave0和slave1

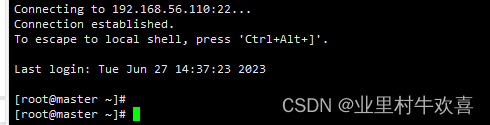

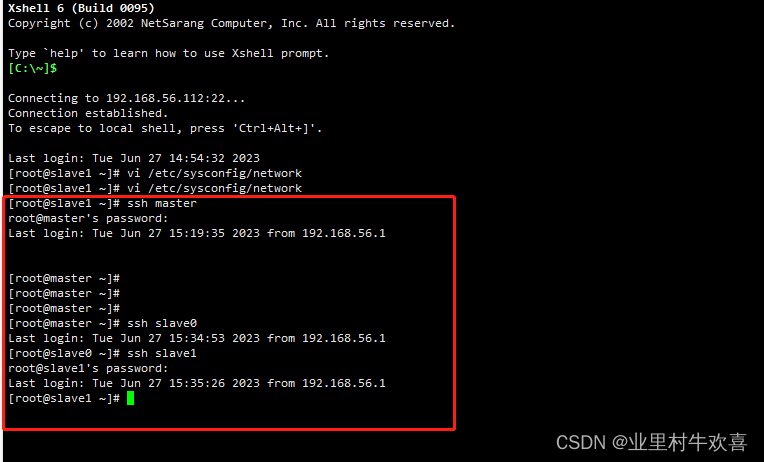

验证是否成功

在master服务器输入下面的命令,都不需要输入密码,就说明成功了,注意每执行完一条命令都用exit退出一下再执行下一条。

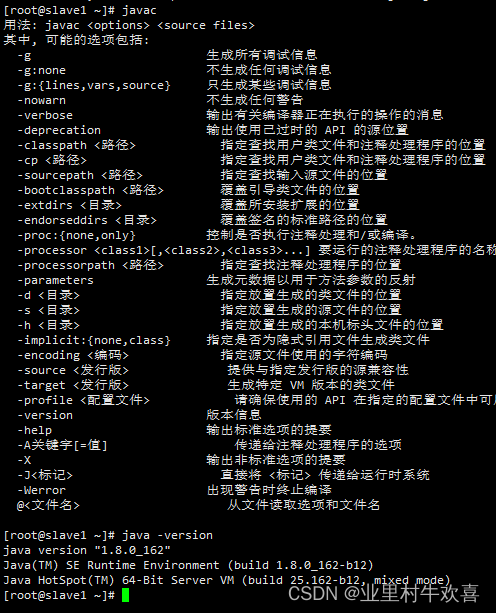

2.10 安装JDK

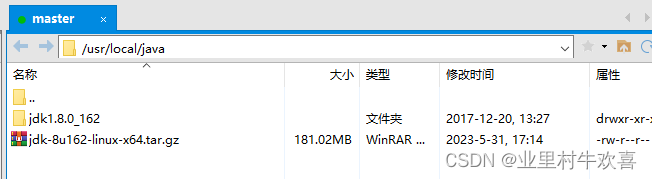

首先在master服务器的usr/local目录下新建一个java文件夹,用下面命令就可以完成

mkdir /usr/local/java

然后用Xftp连接master服务器,打开usr/local/java这个目录,把jdk-8u162-linux-x64.tar复制进去,

使用指令解压

tar -zxvf jdk-8u162-linux-x64.tar.gz

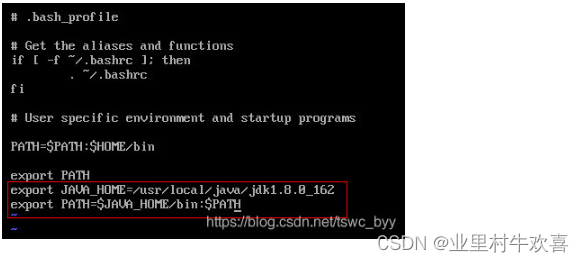

接下来开始配置环境变量,先用cd命令回到总目录

输入下面命令开始配置

增加以下内容,

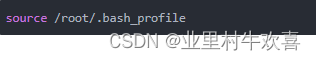

加载环境变量,使用

然后输入java、javac和java -version验证,如果都出现一大堆代码说明配置成功了,如果其中有一个或多个出现不是内部或外部命令,也不是可运行的程序或批处理文件等类似语句,就说明配置失败了,需要重新配置jdk环境。

这样就安装好master服务器的jdk了,但是还没有安装好slave0和slave1的jdk,我们可以用下面命令把master中的jdk复制到slave0上面

scp -r /usr/local/java root@slave0:/usr/local

这时已经把jdk复制到slave0了,但是slave0的环境变量还没有配置,我们同样可以使用下面命令来复制环境变量

scp -r /root/.bash_profile root@slave0:/root

在slave0加载环境变量,同样用java,javac,java-version测试环境。

source /root/.bash_profile

slave1操作和slave0一致,重复操作,进行java测试。

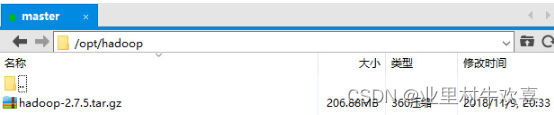

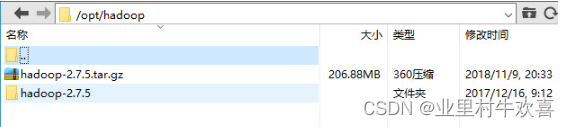

2.11 Hadoop安装与环境配置

先用下面的命令给opt文件夹中新建一个hapoop文件夹,后期配置hadoop文件

mkdir /opt/hadoop

然后把hadoop-2.7.5复制到hadoop文件夹中

使用下面命令进入到hadoop文件夹,进行解压

cd /opt/hadoop

tar -zxvf hadoop-2.7.5.tar.gz

使用mv指令把hadoop-2.7.5文件夹重命名成hadoop

mv hadoop-2.7.5 hadoop

在主服务器master上配置

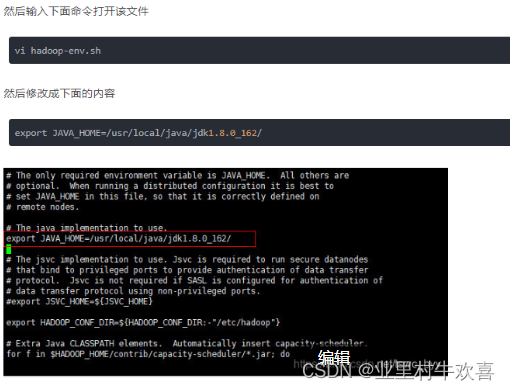

1.配置hadoop-env.sh

该文件设置的是Hadoop运行时需要的环境变量。JAVA_HOME是必须设置的,即使我们当前的系统设置了JAVA_HOME,它也是不认识的,因为Hadoop即使是在本机上执行,它也是把当前执行的环境当成远程服务器。所以这里设置的目的是确保Hadoop能正确的找到jdk。

在hadoop文件中找到hadoop-env.sh文件进行修改,配置java的路径。

2. 配置core-site.xml

core-site.xm所在的目录和上面的目录一样,所以直接使用下面命令打开该文件即可

cd /opt/hadoop/hadoop/etc/hadoop

vi core-site.xml

接着把下面命令写入中,注释不用写

<!-- 指定Hadoop所使用的文件系统schema(URL),HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的储存目录,默认是/tmp/hadoop-${user.name} -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/hadoopdata</value>

</property>

vi hdfs-site.xml

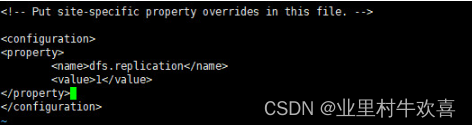

3.配置hdfs-site.xml

hdfs-site.xml所在的目录和上面的目录一样,所以直接使用下面命令打开该文件即可

vi hdfs-site.xml

接着把下面命令写入中,注释不用写

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

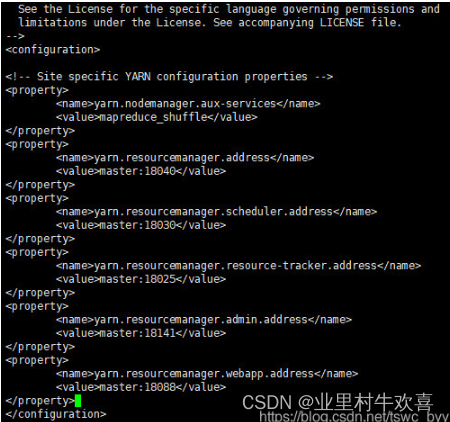

4.配置yarn-site.xml

yarn-site.xml所在的目录和上面的目录一样,所以直接使用下面命令打开该文件即可

vi yarn-site.xml

接着把下面命令写入中,里面自带的注释不用删除

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>master:18040</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:18030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:18025</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:18141</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:18088</value>

</property>

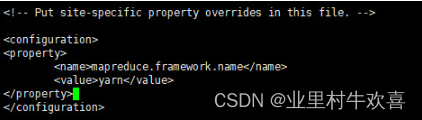

5.配置mapred-site.xml

还是在/opt/hadoop/hadoop/etc/hadoop目录下(也就是上个文件所在的目录),有一个叫 mapred-site.xml.template的文件,把它复制到/opt/hadoop/hadoop/etc/hadoop目录下(也就是mapred-queues.xml.template文件所在的目录)重命名为mapred-site.xml,命令如下

mv mapred-site.xml.template mapred-site.xml

编辑文本

vi mapred-site.xml

接着把下面命令写入中,注释不用写

<!-- 指定mr运行时框架,这里指定在yarn上,默认是local -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

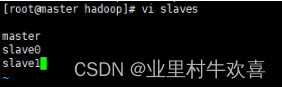

6.配置slaves

slaves 文件给出了 Hadoop 集群的 Slave 节点列表。该文件十分重要,因为启动Hadoop 的时候,系统总是根据当前 slaves 文件中 Slave 节点名称列表启动集群,不在列表中的Slave节点便不会被视为计算节点.

slaves所在的目录和上面的目录一样,所以直接使用下面命令打开该文件即可

cd /opt/hadoop/hadoop/etc/hadoop

vi slaves

增加以下文字内容,进行配置。

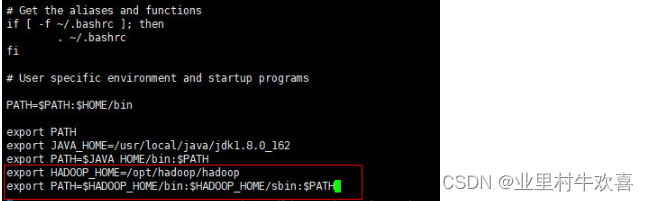

7.配置Hadoop环境变量

先用cd命令回到总目录

编辑环境变量配置

vi /root/.bash_profile

增加以下内容,将Hadoop的环境变量配置到系统中。

export HADOOP_HOME=/opt/hadoop/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

保存文件,使用source功能加载环境变量。

source /root/.bash_profile

8.新建Hadoop运行时产生文件的储存目录

先用cd命令回到总目录

接着用下面命令新建目录

mkdir /opt/hadoop/hadoopdata

9.给slave0和slave1复制Hadoop

用下面命令就可以把master的Hadoop复制到slave0,slavae1上

scp -r /opt/hadoop root@slave0:/opt

scp -r /opt/hadoop root@slave0:/opt

接着用下面命令把master的环境变量复制到slave0,slave1上

scp -r /root/.bash_profile root@slave0:/root

scp -r /root/.bash_profile root@slave1:/root

然后在slave0中输入下面内容使环境变量生效

source /root/.bash_profile

10.格式化文件系统

在master中输入下面命令格式化文件系统,其余俩台服务器不用,注意该命令只能使用一次

hadoop namenode -format

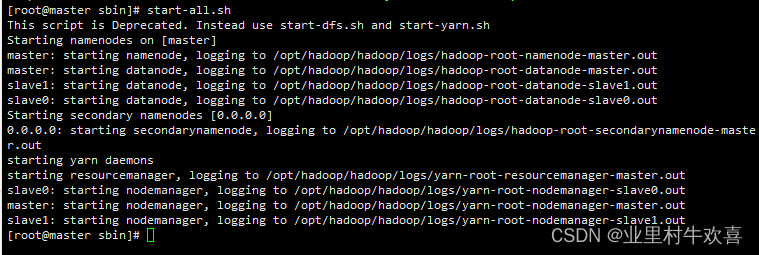

11.启动Hadoop

在master服务器上,先用下面命令进入Hadoop的sbin目录

cd /opt/hadoop/hadoop/sbin

然后输入下面命令启动

start-all.sh

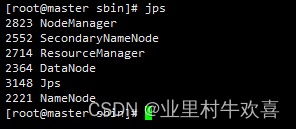

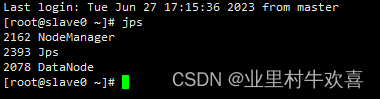

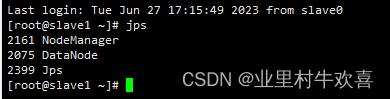

在三台服务器分别输入jps可以判断是否启动成功,出现下面内容说明成功

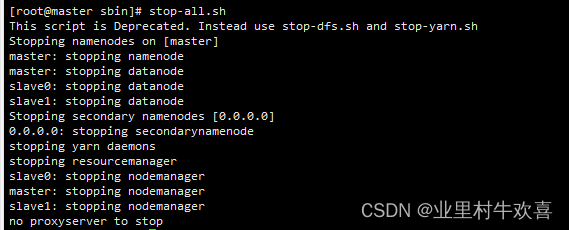

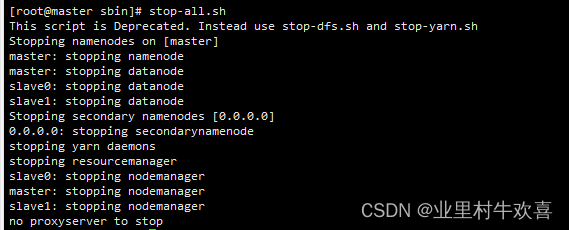

12.关闭Hadoop

只需要在master服务器输入下面命令即可,三个服务器正常停止hadoop的操作。

stop-all.sh

思考和总结:hadoop安装不复杂了,只是需要注意配置nodemanager、yarn的环境还有同步时间,注意配置网络环境还有主机名字。java的配置一定要成功,第一次配置时候少了验证javac的指令,导致后期hadoop启动不了,回查很久才发现是Java的环境配置有问题了,重新验证Java的环境没有错误后,进行Hadoop启动后就可以使用。下期讲解生产环境中,应用hadoop做生产使用。

参考网站:

大数据技术之Hadoop(入门)概述、运行环境搭建、运行模式_@从一到无穷大的博客-CSDN博客

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

``

思考和总结:hadoop安装不复杂了,只是需要注意配置nodemanager、yarn的环境还有同步时间,注意配置网络环境还有主机名字。java的配置一定要成功,第一次配置时候少了验证javac的指令,导致后期hadoop启动不了,回查很久才发现是Java的环境配置有问题了,重新验证Java的环境没有错误后,进行Hadoop启动后就可以使用。下期讲解生产环境中,应用hadoop做生产使用。

参考网站:

大数据技术之Hadoop(入门)概述、运行环境搭建、运行模式_@从一到无穷大的博客-CSDN博客

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)

[外链图片转存中…(img-8I7VC8Tb-1713289531682)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

636

636

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?