既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!

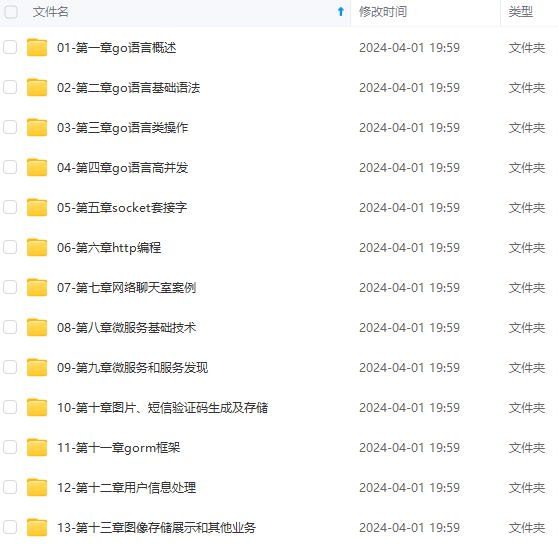

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

词性标注:属于一种文本分类,一般是基于上下文语境的文本分类

句子分割:属于标点符号的分类任务,它的特征一般选取为单独句子标识符的合并链表、数据特征(下一个词是否大写、前一个词是什么、前一个词长度……)

识别对话行为类型:对话行为类型是指问候、问题、回答、断言、说明等

识别文字蕴含:即一个句子是否能得出另外一个句子的结论,这可以认为是真假标签的分类任务。这是一个有挑战的事情

从一句话里提取出十句话的信息,扩充训练样本

按照之前理解的内容,对一句话做处理,最多是切成一个一个的词,再标注上词性,仅此而已,然而事实并非如此,一句话还可以做更多的文章,如下:

什么?还能结构化?

任何语言的每一句话之所以称为“话”,是因为它有一定的句子结构,除了一个个独立的词之外,他们之间还存在着某种关系。如果任何一句话可以由任何词构成,可长可短,那么这是一个非结构化的信息,计算机是很难理解并做计算的,但是如果能够以某种方式把句子转化成结构化的形式,计算机就可以理解了。而如果建立结构化的知识之间的关系图,则所谓的知识图谱 。

实事上,人脑在理解一句话的时候也暗暗地在做着由非结构化到结构化的工作。

比如说:“我下午要和小明在公司讨论一个技术问题”。这是一片非结构化的词语拼成的一句话,但是这里面有很多隐含信息:

1)小明是一个实体

2)参与者有两个:我和小明

3)地点设定是:公司

4)要做的事情是:讨论

5)讨论的内容是:问题

6)这个问题是一个技术问题

7)公司是一个地点

8)讨论是一种行为

9)我和小明有某种关系

10)下午是一个时间

上面这些信息有一些是专门针对这个句子的,有一些是常理性的,对于针对句子的信息有利于理解这句话,对于常理性的信息可以积累下来用来以后理解其他句子。

那么怎么才能把非结构化的句子转成结构化的信息呢?要做的工作除了断句、分词、词性标注之外,还要做的一个关键事情就是分块。

分块

分块就是根据句子中的词和词性,按照某种规则组合在一起形成一个个分块,每个分块代表一个实体。常见的实体包括:组织、人员、地点、日期、时间等

以上面的例子为例,首先我们做名词短语分块(NP-chunking),比如:技术问题。名词短语分块通过词性标记和一些规则就可以识别出来,也可以通过机器学习的方法识别

除了名词短语分块还有很多其他分块:介词短语(PP,比如:以我……)、动词短语(VP,比如:打人)、句子(S,我是人)

分块如何标记和存储呢?

可以采用IOB标记,I(inside,内部)、O(outside,外部)、B(begin, 开始),一个块的开始标记为B,块内的标识符序列标注为I,所有其他标识符标注为O

也可以用树结构来存储分块,用树结构可以解决IOB无法标注的另一类分块,那就是多级分块。多级分块就是一句话可以有多重分块方法,比如:我以我的最高权利惩罚你。这里面“最高权利”、“我的最高权利”、“以我的最高权利”是不同类型分块形成一种多级分块,这是无法通过IOB标记的,但是用树结构可以。这也叫做级联分块。具体树结构举个例子:

(S

(NP 小明)

(VP

(V 追赶)

(NP

(Det 一只)

(N 兔子))))

这是不是让你想到了语法树?

关系抽取

通过上面的分块可以很容易识别出实体,那么关系抽取实际就是找出实体和实体之间的关系,这是自然语言处理一个质的跨越,实体识别让机器认知了一种事物,关系识别让机器掌握了一个真相。

关系抽取的第一个方法就是找到(X, a, Y)这种三元组,其中X和Y都是实体,a是表达关系的字符串,这完全可以通过正则来识别,因为不同语言有这不同的语法规则,所以方法都是不同的,比如中文里的“爱”可以作为这里的a,但是“和”、“因为”等就不能作为这里的a

编程实现

下面介绍部分有关分块的代码,因为中文标注好分块的语料没有找到,所以只能沿用英文语料来说明,但是原理是一样的

conll2000语料中已经有标注好的分块信息,如下:

>>> from nltk.corpus import conll2000

>>> print conll2000.chunked_sents('train.txt')[99]

(S

(PP Over/IN)

(NP a/DT cup/NN)

(PP of/IN)

(NP coffee/NN)

,/,

(NP Mr./NNP Stone/NNP)

(VP told/VBD)

(NP his/PRP$ story/NN)

./.)

我们可以基于这些标注数据做训练,由于这种存储结构比较特殊,所以就不单独基于这种结构实现parser了,只说下跟前面讲的机器学习一样,只要基于这部分数据做训练,然后再用来标注新的语料就行了

这里介绍一下 sklearn 库中的的一个文本分类 demo

以下为笔者自己编辑:

# -*- coding:utf-8 -*-

import numpy as np

from sklearn.naive_bayes import MultinomialNB, BernoulliNB

from sklearn.datasets import fetch_20newsgroups

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.linear_model import RidgeClassifier

from sklearn.neighbors import KNeighborsClassifier

from sklearn.svm import SVC

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

from sklearn import metrics

from time import time

from pprint import pprint

import matplotlib.pyplot as plt

import matplotlib as mpl

def test_clf(clf):

print u'分类器:', clf

alpha_can = np.logspace(-3, 2, 10)

model = GridSearchCV(clf, param_grid={'alpha': alpha_can}, cv=5)

m = alpha_can.size

if hasattr(clf, 'alpha'):

model.set_params(param_grid={'alpha': alpha_can})

m = alpha_can.size

if hasattr(clf, 'n_neighbors'):

neighbors_can = np.arange(1, 15)

model.set_params(param_grid={'n_neighbors': neighbors_can})

m = neighbors_can.size

if hasattr(clf, 'C'):

C_can = np.logspace(1, 3, 3)

gamma_can = np.logspace(-3, 0, 3)

model.set_params(param_grid={'C':C_can, 'gamma':gamma_can})

m = C_can.size * gamma_can.size

if hasattr(clf, 'max_depth'):

max_depth_can = np.arange(4, 10)

model.set_params(param_grid={'max_depth': max_depth_can})

m = max_depth_can.size

t_start = time()

model.fit(x_train, y_train)

t_end = time()

t_train = (t_end - t_start) / (5*m)

print u'5折交叉验证的训练时间为:%.3f秒/(5*%d)=%.3f秒' % ((t_end - t_start), m, t_train)

print u'最优超参数为:', model.best_params_

t_start = time()

y_hat = model.predict(x_test)

t_end = time()

t_test = t_end - t_start

print u'测试时间:%.3f秒' % t_test

acc = metrics.accuracy_score(y_test, y_hat)

print u'测试集准确率:%.2f%%' % (100 * acc)

name = str(clf).split('(')[0]

index = name.find('Classifier')

if index != -1:

name = name[:index] # 去掉末尾的Classifier

if name == 'SVC':

name = 'SVM'

return t_train, t_test, 1-acc, name

if __name__ == "__main__":

print u'开始下载/加载数据...'

t_start = time()

# remove = ('headers', 'footers', 'quotes')

remove = ()

categories = 'alt.atheism', 'talk.religion.misc', 'comp.graphics', 'sci.space'

# categories = None # 若分类所有类别,请注意内存是否够用

data_train = fetch_20newsgroups(subset='train', categories=categories, shuffle=True, random_state=0, remove=remove)

data_test = fetch_20newsgroups(subset='test', categories=categories, shuffle=True, random_state=0, remove=remove)

t_end = time()

print u'下载/加载数据完成,耗时%.3f秒' % (t_end - t_start)

print u'数据类型:', type(data_train)

print u'训练集包含的文本数目:', len(data_train.data)

print u'测试集包含的文本数目:', len(data_test.data)

print u'训练集和测试集使用的%d个类别的名称:' % len(categories)

categories = data_train.target_names

pprint(categories)

y_train = data_train.target

y_test = data_test.target

print u' -- 前10个文本 -- '

for i in np.arange(10):

print u'文本%d(属于类别 - %s):' % (i+1, categories[y_train[i]])

print data_train.data[i]

print '\n\n'

vectorizer = TfidfVectorizer(input='content', stop_words='english', max_df=0.5, sublinear_tf=True)

x_train = vectorizer.fit_transform(data_train.data) # x_train是稀疏的,scipy.sparse.csr.csr_matrix

x_test = vectorizer.transform(data_test.data)

print u'训练集样本个数:%d,特征个数:%d' % x_train.shape

print u'停止词:\n',

pprint(vectorizer.get_stop_words())

feature_names = np.asarray(vectorizer.get_feature_names())

print u'\n\n===================\n分类器的比较:\n'

clfs = (MultinomialNB(), # 0.87(0.017), 0.002, 90.39%

BernoulliNB(), # 1.592(0.032), 0.010, 88.54%

KNeighborsClassifier(), # 19.737(0.282), 0.208, 86.03%

RidgeClassifier(), # 25.6(0.512), 0.003, 89.73%

RandomForestClassifier(n_estimators=200), # 59.319(1.977), 0.248, 77.01%

SVC() # 236.59(5.258), 1.574, 90.10%

)

result = []

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化的资料的朋友,可以添加戳这里获取](https://bbs.csdn.net/topics/618658159)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

1715559408547)]

[外链图片转存中...(img-H3NTyIMQ-1715559408548)]

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化的资料的朋友,可以添加戳这里获取](https://bbs.csdn.net/topics/618658159)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

1817

1817

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?