一、DataLoader简介

官网地址:

1. DataLoder类

class torch.utils.data.DataLoader(dataset, batch_size=1, shuffle=None, sampler=None, batch_sampler=None, num_workers=0, collate_fn=None, pin_memory=False, drop_last=False, timeout=0, worker_init_fn=None, multiprocessing_context=None, generator=None, *, prefetch_factor=None, persistent_workers=False, pin_memory_device='')

由此可见,DataLoder必须需要输入的参数只有\(dataset\)。

2. 参数说明

-

dataset(Dataset): 数据集的储存的路径位置等信息

-

batch_size(int): 每次取数据的数量,比如batchi_size=2,那么每次取2条数据

-

shuffle(bool): True: 打乱数据(可以理解为打牌中洗牌的过程); False: 不打乱。默认为False

-

num_workers(int): 加载数据的进程,多进程会更快。默认为0,即用主进程进行加载。但在windows系统下,num_workers如果非0,可能会出现 BrokenPipeError[Error 32] 错误

-

drop_last(bool): 比如我们从100条数据中每次取3条,到最后会余下1条,如果drop_last=True,那么这条数据会被舍弃(即只要前面99条数据);如果为False,则保留这条数据

二、DataLoader实操

- 数据集仍然采用上一篇的_CIFAR10_数据集

1. DataLoader取数据的逻辑

-

首先import dataset,dataset会返回一个数据的img和target

-

然后import dataloder,并设置\(batch\_size\),比如\(batch\_size=4\),那么dataloder会获取这些数据:dataset[0]=img0, target0; dataset[1]=img1, target1; dataset[2]=img2, target2; dataset[3]=img3, target3. 并分别将其中的4个img和4个target进行打包,并返回打包好的imgs和targets

比如下面这串代码:

import torchvision

from torch.utils.data import DataLoader

#测试集,并将PIL数据转化为tensor类型

test_data=torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor())

#batch_size=4:每次从test_data中取4个数据集并打包

test_loader=DataLoader(dataset=test_data, batch_size=4, shuffle=True, num_workers=0, drop_last=False)

这里的test_loader会取出test_data[0]、test_data[1]、test_data[2]、test_data[3]的img和target,并分别打包。返回两个参数:打包好的imgs,打包好的taregts

2. 如何取出DataLoader中打包好的img、target数据

(1)输出打包好的img、target

代码示例如下:

import torchvision

from torch.utils.data import DataLoader

#测试集,并将PIL数据转化为tensor类型

test_data=torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor())

#batch_size=4:每次从test_data中取4个数据集并打包

test_loader=DataLoader(dataset=test_data, batch_size=4, shuffle=True, num_workers=0, drop_last=False)

#测试数据集中第一章图片及target

img, target=test_data[0]

print(img.shape)

print(target)

#取出test_loader中的图片

for data in test_loader:

imgs,targets = data

print(imgs.shape) #[Run] torch.Size([4, 3, 32, 32]) 4张图片打包,3通道,32×32

print(targets) #[Run] tensor([3, 5, 2, 7]) 4张图,每张图片对应的标签分别是3,5,2,7(某一次print的举例,每次print结果不太一样)

在11行处debug一下可以发现,test_loader中有个叫sampler的采样器,采取的是随机采样的方式,也就是说这batch_size=4时,每次抓取的4张图片都是随机抓取的。

(2)展示图片

用tensorboard就可以可视化了,具体操作改一下上面代码最后的for循环就好了

from torch.utils.tensorboard import SummaryWriter

writer=SummaryWriter("dataloder")

step=0 #tensorboard步长参数

for data in test_loader:

imgs,targets = data

# print(imgs.shape) #[Run] torch.Size([4, 3, 32, 32]) 4张图片打包,3通道,32×32

# print(targets) #[Run] tensor([3, 5, 2, 7]) 4张图,每张图片对应的标签分别是3,5,2,7(某一次print的举例,每次print结果不太一样)

writer.add_images("test_data",imgs,step) #注意这里是add_images,不是add_image。因为这里是加入了64张图

step=step+1

writer.close()

(3)关于shuffle的理解

- 可以理解为一个for循环就是打一次牌,打完一轮牌后,若shuffle=False,那么下一轮每一步抓到的牌都会跟上一轮相同;如果shuffle=True,那么就会进行洗牌,打乱牌的顺序后,下一轮每一步跟上一轮的会有不同。

首先将shuffle设置为False:

test_loader=DataLoader(dataset=test_data, batch_size=64, shuffle=True, num_workers=0, drop_last=False)

然后对(2)的代码进行修改,运行代码:

for epoch in range(2): #假设打两次牌,我们来观察两次牌中间的洗牌情况

step = 0 # tensorboard步长参数

for data in test_loader:

imgs,targets = data

# print(imgs.shape) #[Run] torch.Size([4, 3, 32, 32]) 4张图片打包,3通道,32×32

# print(targets) #[Run] tensor([3, 5, 2, 7]) 4张图,每张图片对应的标签分别是3,5,2,7(某一次print的举例,每次print结果不太一样)

writer.add_images("Epoch: {}".format(epoch),imgs,step) #注意这里是add_images,不是add_image。因为这里是加入了64张图

step=step+1

writer.close()

结果显示,未洗牌时运行的结果是一样的:

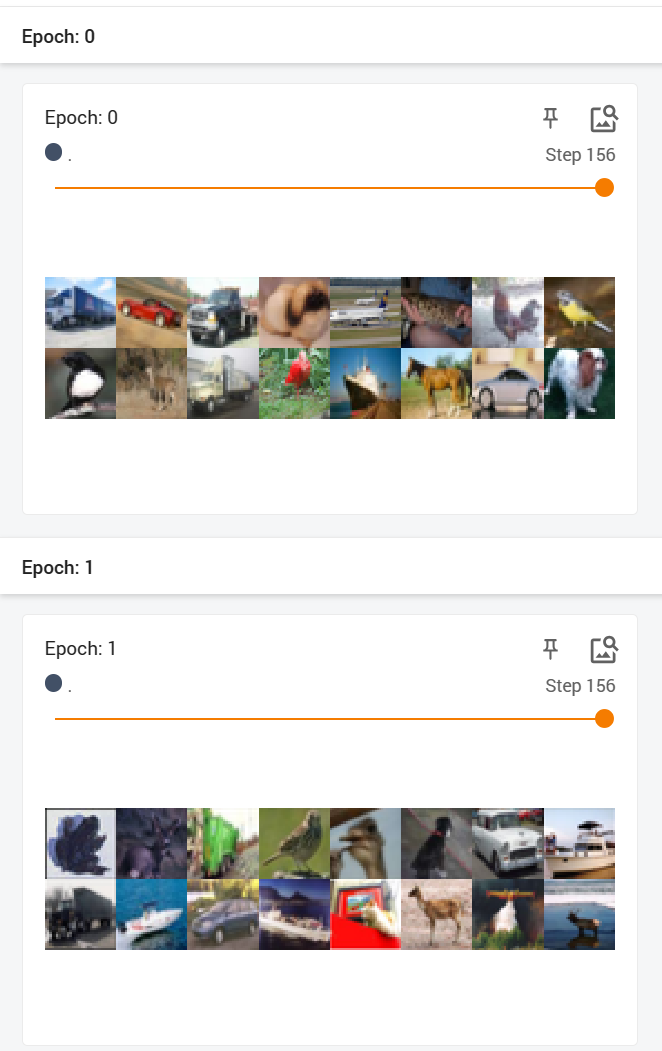

- 将shuffle设置为True,再次运行,可以发现两次结果还是不一样的:

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

五、面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?