张量

Numpy、TensorFlow、Pytorch等框架主要是为了计算张量或是基于张量计算。

标量:0阶张量;12,4,3,

向量:一阶张量;[12,4,3]

矩阵:二阶张量;[ [12,4,3], [11,2,3] ]

多阶张量:多维数组;

可以将张量的阶度理解为多维数组的维度。

神经网络

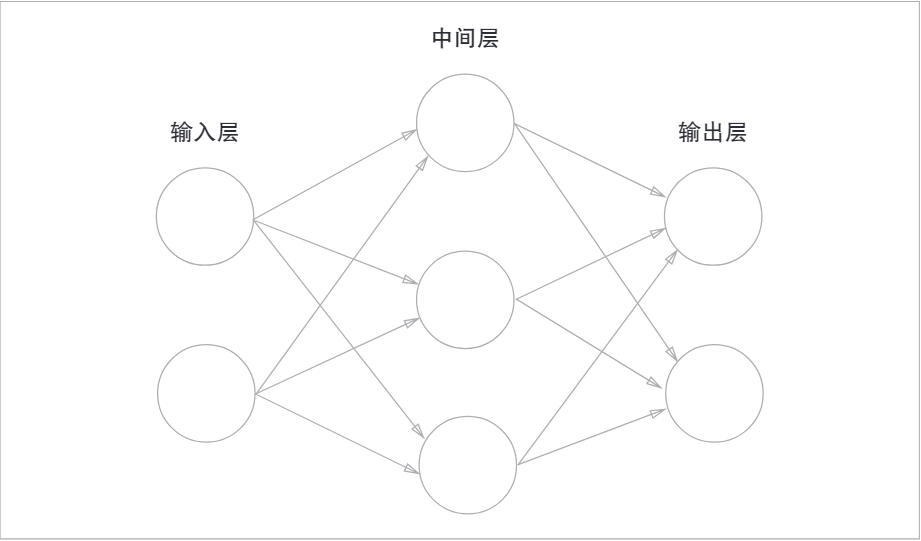

神经网络的图表示:

最左边的一列称为输入层,最右边的一列称为输出层,中间的称为中间层,也叫做隐藏层。

激活函数

概述

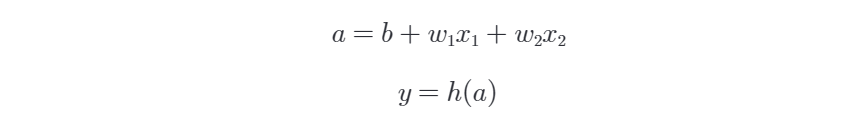

激活函数的作用在于决定如何来激活输入信号的总和。数学表达式如下:

图表示如下:

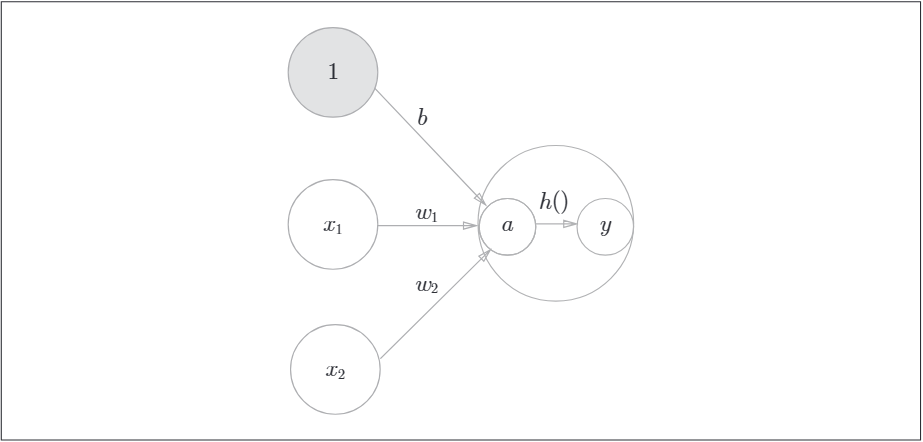

通常神经元用一个○表示,在明确神经网络的动作下,可以明确显示激活函数的计算过程。如下,这两个图是等效的。

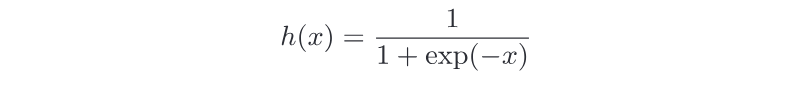

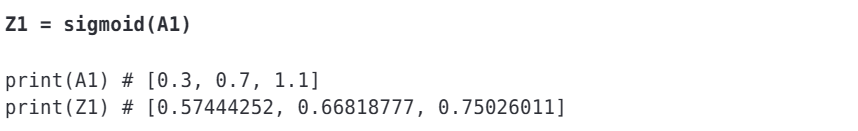

sigmoid函数

神经网络中用sigmoid函数作为激活函数,进行信号的转换,转换后的信号被传送到下一个神经元。

函数表示为:

使用Numpy实现:

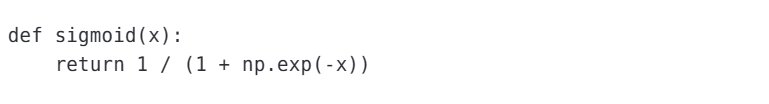

relu函数

relu函数在输入大于0时,直接输出该值;在输入小于等于0时,输出0。函数表示:

使用Numpy实现:

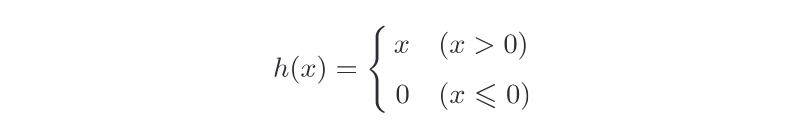

神经网络的实现

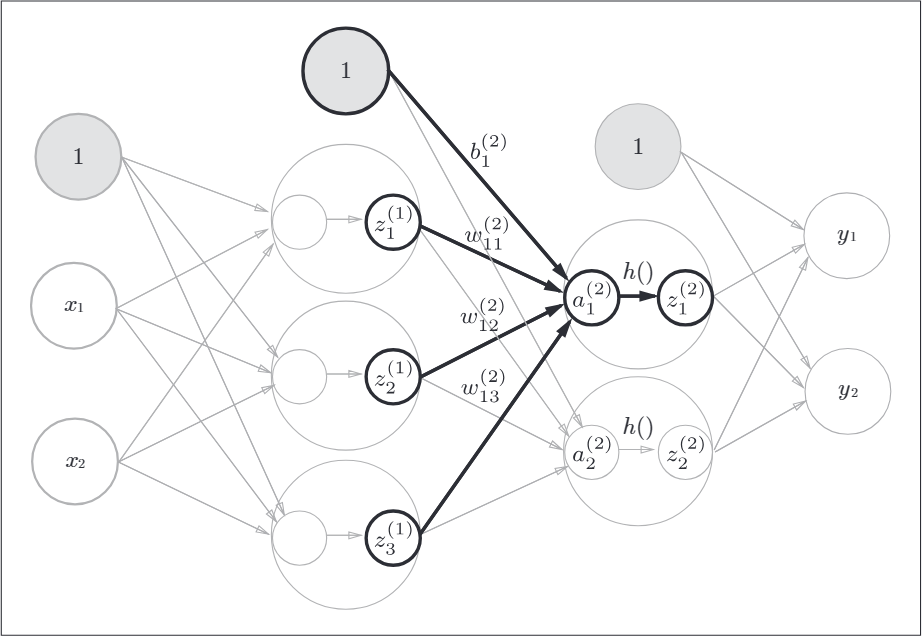

如下是三层神经网络的图表示,第0层神经元到第一层神经元的信号传递:

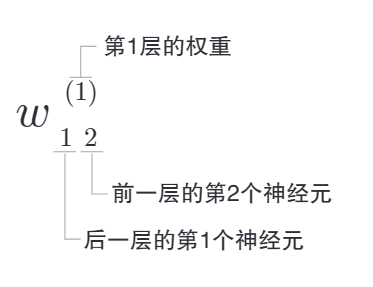

符号解释:

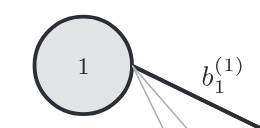

如下表示引入了偏置的神经元"1"。

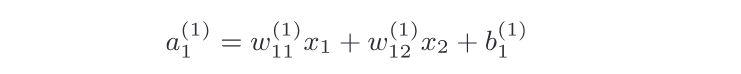

神经元a1的数学表达式如下:

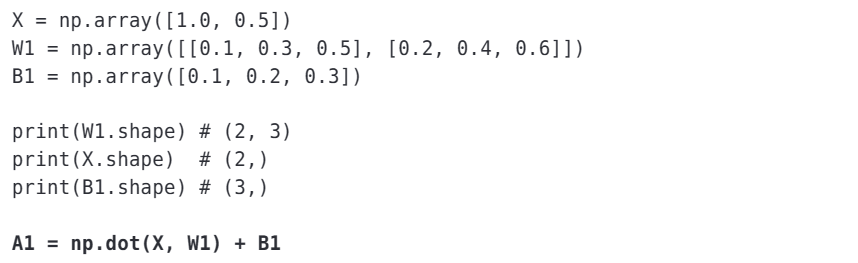

矩阵的乘法运算:

NumPy实现:

中间层(隐藏层)的激活函数可能是不一样的,如上可能是sigmoid函数或是rule函数计算。

第1层神经元到第二层神经元的信号传递,从下图也可以看出来,第二层到输出层的信号传递:

输出层的设计

神经网络可以用在分类问题和回归问题上,不过需要根据情况改变输出层的激活函数。一般而言,回归问题用恒等函数,分类问题用softmax函数。

机器学习的问题大致分为分类问题和回归问题。分类问题是数据属于哪一个类别的问题。而回归问题是根据某个输入预测一个数值的问题。

Affine层

Affine层(也称为全连接层、线性层或密集层)是一种基本的神经网络层,其主要作用是将输入数据与权重矩阵相乘并添加偏置,以进行线性变换。这个线性变换是神经网络中的重要组成部分,它将输入数据映射到另一个空间,以便后续的非线性变换和学习。这可以用以下数学公式表示:

深度神经网络中,通常会有多个Affine层连接在一起,构成网络的一部分。每个Affine层将前一层的输出作为输入,并且可以具有不同的权重和偏置,以捕捉不同的特征和复杂性。通常,在Affine层之后会添加非线性激活函数(如ReLU、Sigmoid或Tanh),以使神经网络能够捕捉更复杂的模式和特征。这些非线性函数使神经网络能够逼近任意复杂的函数。

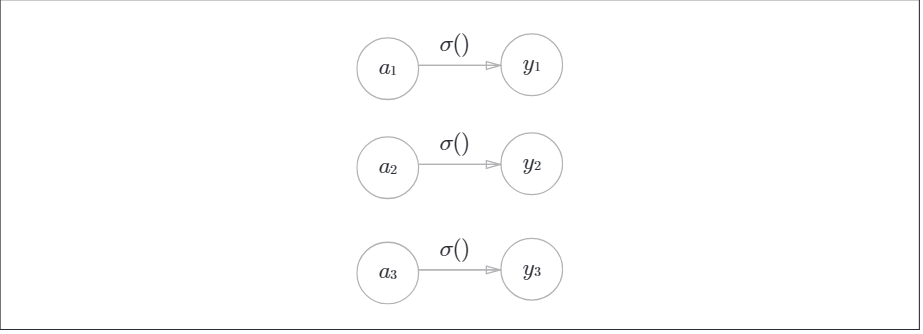

恒等函数和softmax函数

恒等函数会将输入按原样输出,对于输入的信息,不加以任何改动的直接输出。神经网络图表示:

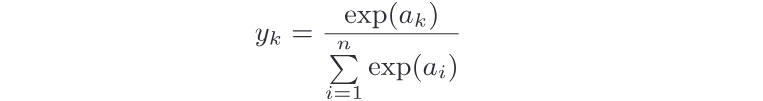

分类问题中的softmax函数,其数学表达式如下,计算第K个神经元的输出:

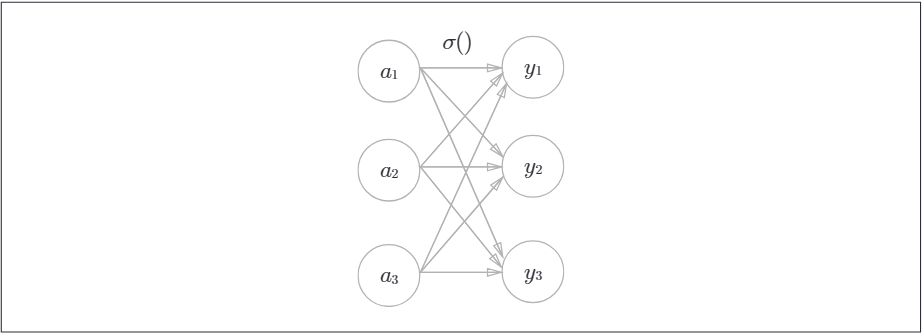

图表示如下,输出层的各个神经元都受到所有输入信号的影响:

softmax函数的python实现:

softmax函数的输出是0.0到1.0之间的实数。并且softmax函数的输出值的总和是1。因此可以把softman函数的输出解释为"概率"。

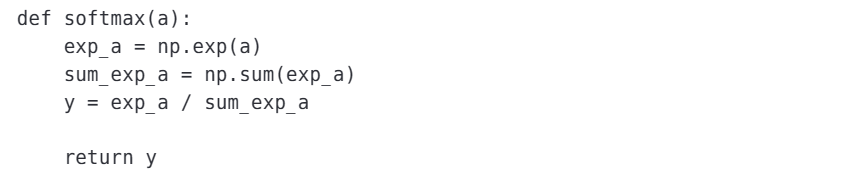

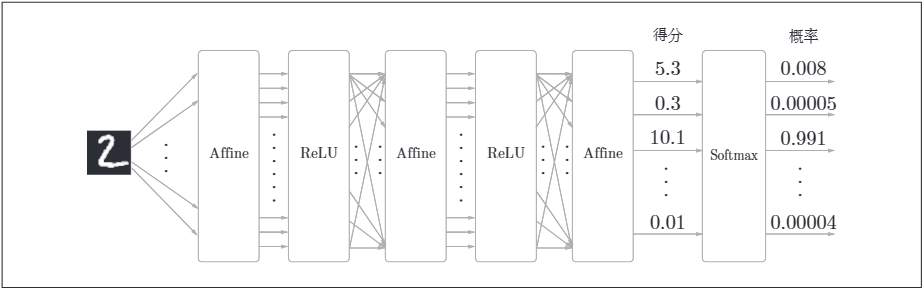

比如在手写数字识别时,Softmax层的输出如下:

输入图像经过Affine层与ReLU层进行转换,10个输入通过Softmax层进行正规化。在这个例子中,"0"的得分时5.3,这个值经过Softmax层转换,输出概率为0.008的值;"2"的得分时10.1,被转换为0.991。

损失函数

损失函数标识神经网络性能的"恶劣程度"的指标,即当前的神经网络对监督数据在多大程度上不拟合,在多大程度上不一致。损失函数的计算可以使用均方误差和交叉熵误差。

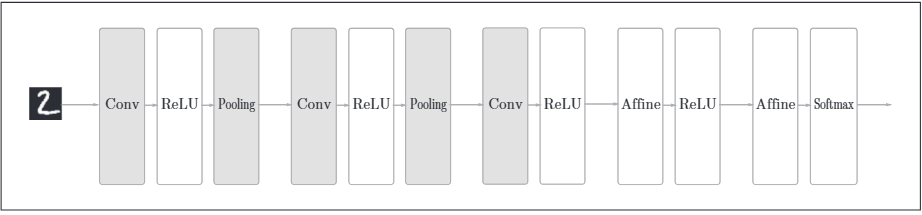

卷积神经网络

卷积神经网络(CNN)增加了卷积层(Convolution)和池化层(Pooling)。其神经网络结构示例如下:

之前的全连接神经网络中忽略了数据的形状,比如,输入数据是图像时,图像通常是高、长、通道三个方向上的3维形状。但是向全连接层输入时,需要将3维数据拉平为1维数据。全连接层会忽视形状,将全部的输入数据作为相同的神经元(同一纬度的神经元)处理,所以无法利用与形状相关的信息。

而卷积层可以保持形状不变。当输入数据是图像时,卷积层会以3维数据的形式接受输入数据,并以3维数据的形式输出至下一层。因此,CNN架构的网络可以正确理解图像等具有形状的数据。

卷积层

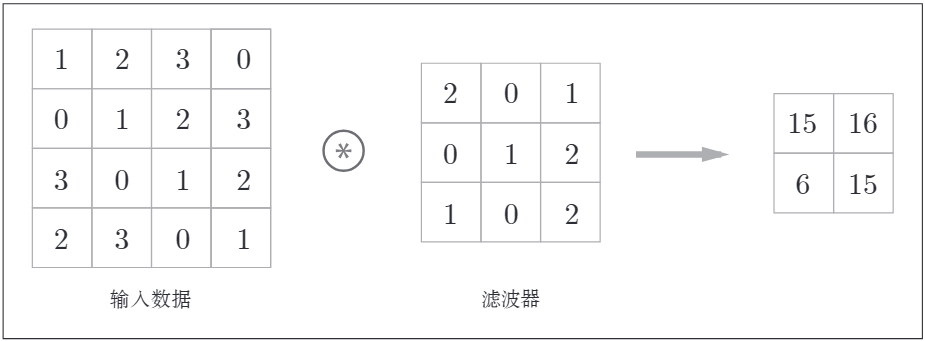

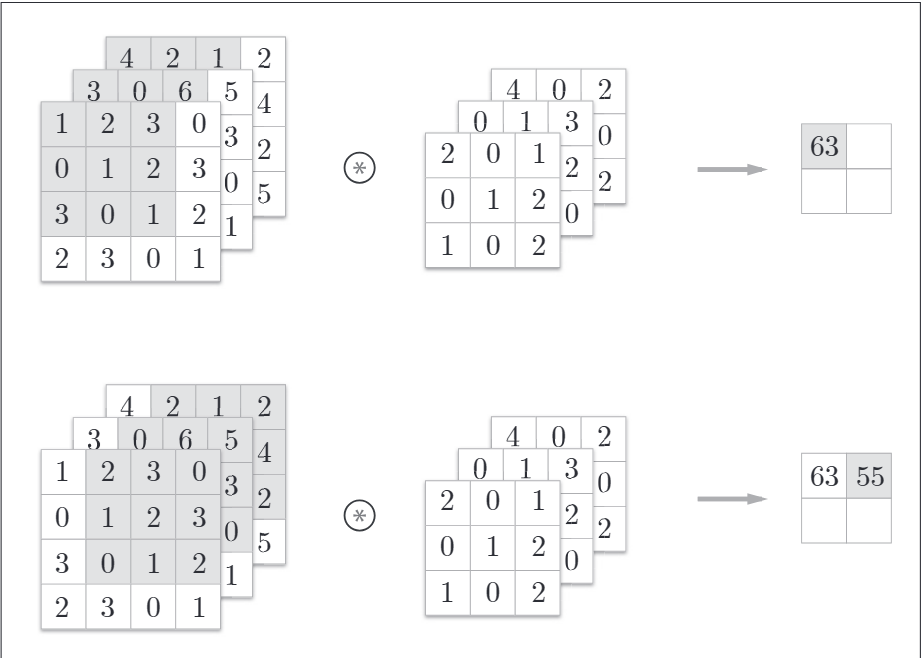

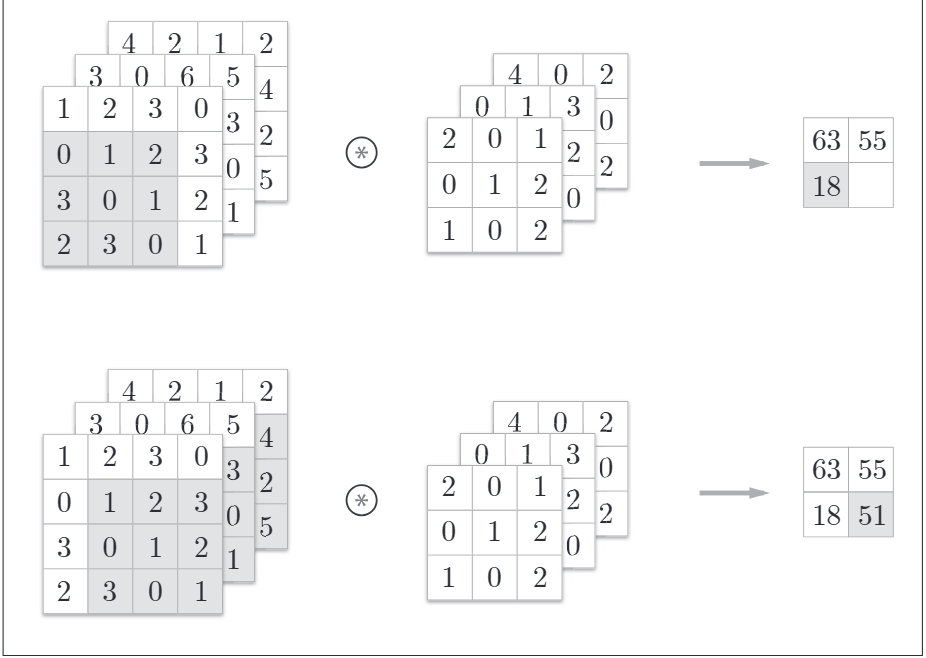

卷积层进行的处理就是卷积运算。卷积运算相当于图像处理中的"滤波器运算"。如下示例:

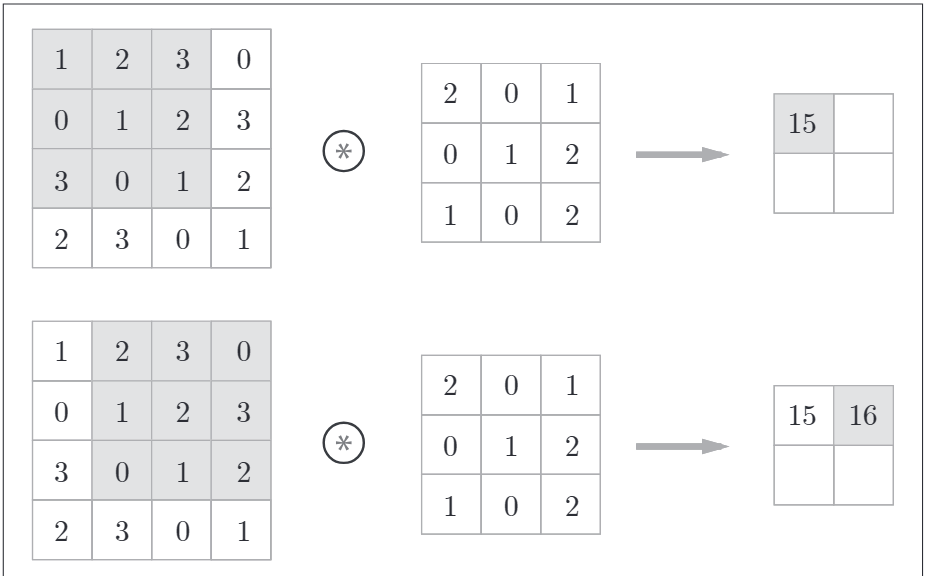

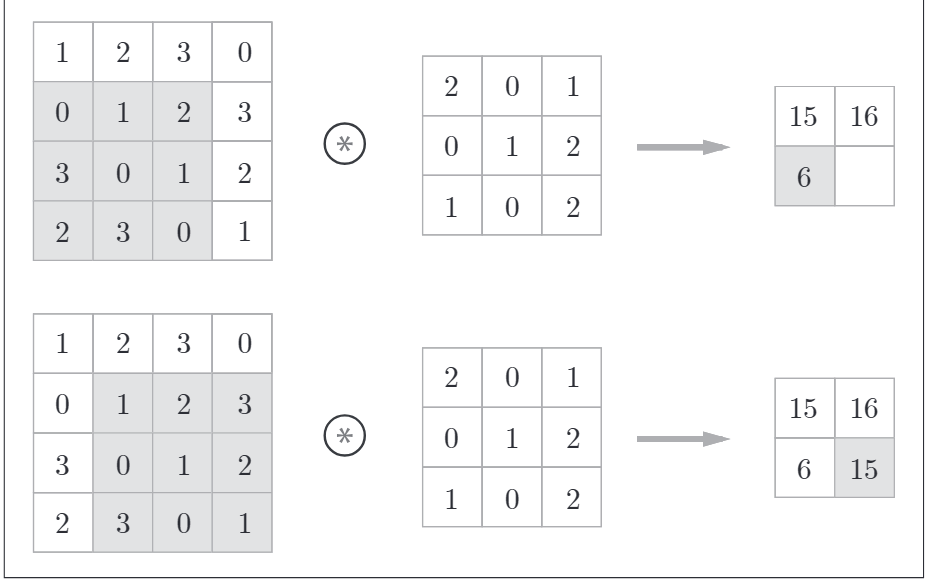

卷积运算对输入数据应用滤波器。计算顺序如下,卷积运算以一定间隔的步幅滑动滤波器的窗口并应用。如下所示:

将各个位置上滤波器的元素与输入的对应元素相乘,然后再求和。最后将结果保存到输出的对应位置。将这个过程在所有的位置运算一遍,就可以得到卷积运算的输出。

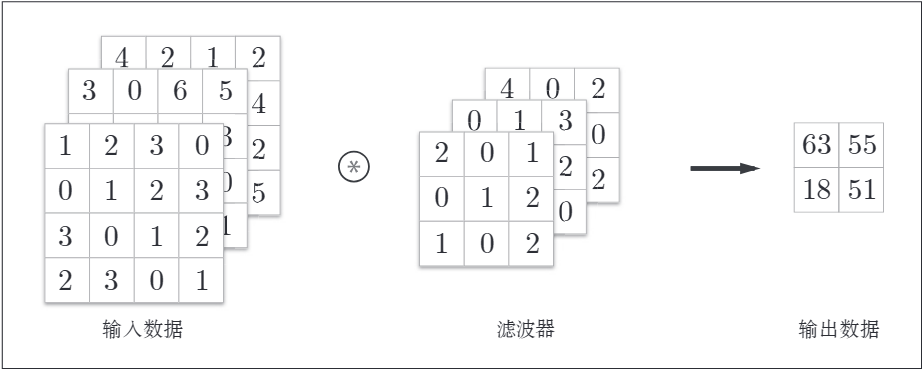

3维数据的卷积运算

之前的卷积运算都是以高、长方向的2维形状为对象的。图像是3维数据,除了高、长方向还有通道方向。增加了通道,会按通道进行输入数据与滤波器的卷积运算。如下是增加了通道方向的3维数据进行卷积运算的例子:

计算顺序如下:

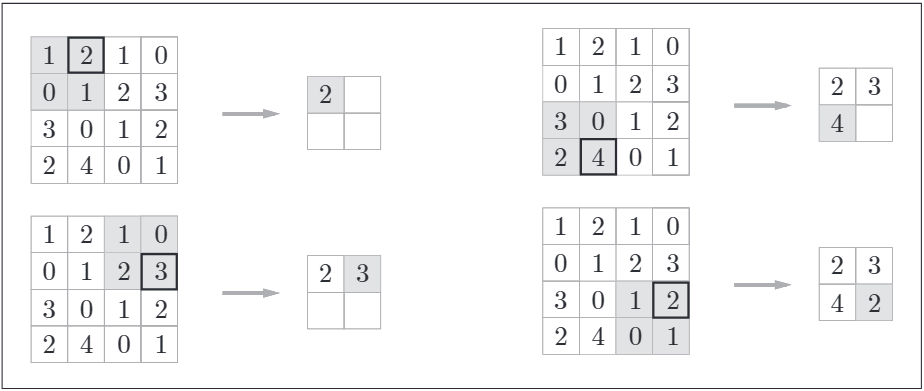

池化层

池化是缩小高、长方向上的空间的运算。如下,将2*2的区域集约成1个元素的处理,缩小空间大小。

最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

五、面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

784

784

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?