这一篇将会介绍,如何把大模型搬到本地,彻底杜绝个人或企业知识泄露和无限token的问题。

本文提到的工具:Ollama + DeepSeek + CherryStudio(可选)

当然如果有条件,可以自行对大模型进行微调,训练更符合自己需要的大模型。这个需要一定的硬件要求和技术能力支撑,不在本篇探讨范围。

老规矩,先看效果

我的电脑配置不高,本地只安装了蒸馏后的deepseek(8b),不是满血版(671b),不过个人使用足够了。

(素颜版,通过cmd查看本地大模型效果)

(高颜版,通过CherryStudio工具查看本地大模型效果)

以下是详细的实现过程:

一、需求拆解

1. 把大模型下载到本地

2. 本地运行大模型

3. 调用大模型(三个场景,其中之一是RAGFlow)

二、用到的工具

Ollama + DeepSeek + CherryStudio(可选,如果仅作为聊天使用,不和RAG结合,这个工具就够了)

三、实现过程

1. 安装Ollama

官网(https://ollama.com/)下载安装即可,傻瓜式操作,一路下一步即可。

2. 配置Ollama

修改系统环境变量,以win11为例。“搜索->编辑环境变量"

新增三个环境变量,分别是OLLMA_HOST、OLLAMA_PORT、OLLAMA_MODELS。

OLLMA_HOST: 允许访问ollama模型的IP,如果没有限制直接写0.0.0.0。

OLLAMA_PORT:访问ollama模型的端口

OLLAMA_MODESL: 本地存放大模型的路径

以下是示例:可根据实际情况修改

OLLAMA_HOST 0.0.0.0OLLAMA_PORT 11434OLLAMA_MODELS E:\soft\ollama_models

2. 用Ollama下载大模型

1) 登录Ollama官网找到对应的模型名称

注意,选好对应的版本,例如8b。

2)本地下载并运行大模型

cmd或者powershell环境,运行"ollama run对应的模型名称",等待即可

ollama run deepseek-r1:8b当出现,”>>Send a message (/? for help)“ 证明安装成功,即可在本地使用了。

3.本地调用大模型三种方式(当然还有其他用法,比如通过obsidian调用)

1) 在cmd或Powershell环境聊天对话

PS:这种方式未接入本地知识库,用的是大模型本身的数据,而且deepseek:r1版模型训练截止日期是2024年7月。所以本地私有的知识,以及24年7月之后发生事,他是不知道的。

按照上篇本地知识库的问题”红烧鲤鱼做法的关键是什么?“,答案是根据之前训练的结果来的。如下:

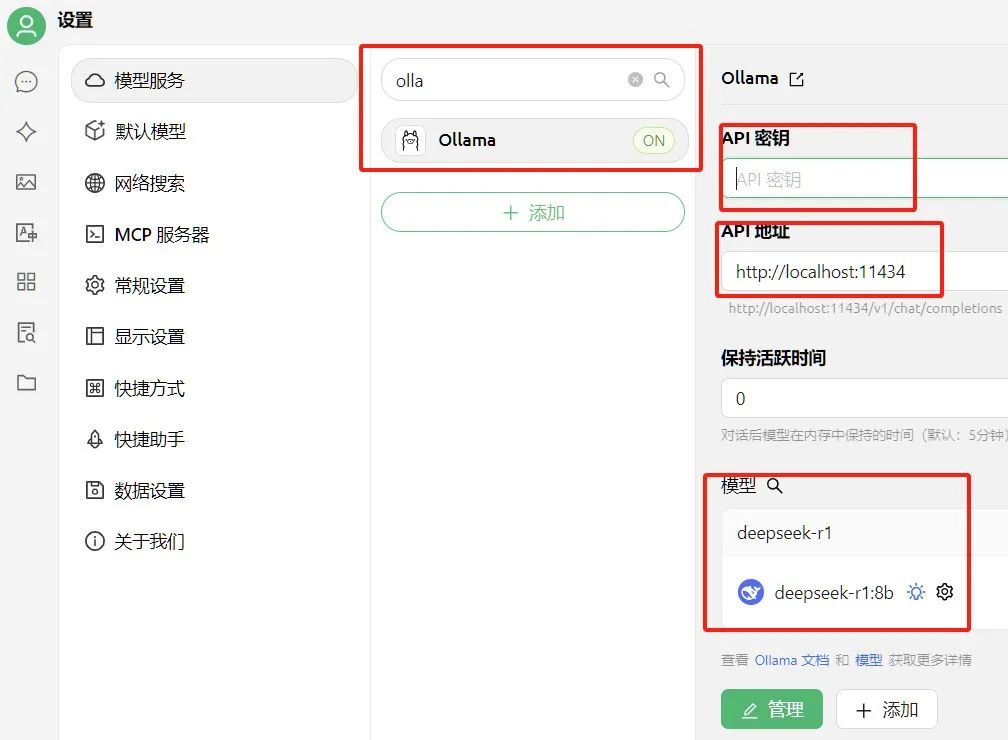

2) 在CherryStudio中配置并调用

-

官网(https://cherry-ai.com/)下载并按照CherryStudio

-

配置本地ollama模型,信息如下

API密钥:因为是本地,所以无需配置,可以无限token

API地址: http://localhost:11434或者http://127.0.0.1:11434

PS:如果是局域网使用,需要配置实际的IP地址或者配置域名。

模型:选择下载好模型,名字必须准确,如果不记得了,使用以下命令查看

cmd>ollama list

(以下是完整的配置信息)

之后在聊天框选中对应的模型即可。

3) 与RAGFlow结合,彻底实现本地知识库隔离,且无限token。

-

启动并登录RAGFLow:通过docker启动RAGFlow并登录

-

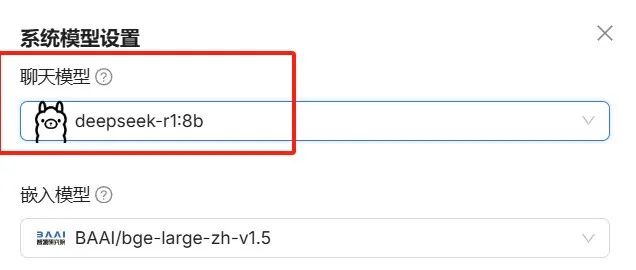

配置备选大模型:头像->配置->模型提供商->ollama

详细配置参数如下:

-

配置使用中的模型:头像->配置->模型提供商->系统模型设置

聊天模型选中ollama的deepseek-r1:8b模型即完成配置。

其他使用方式不变,与上一篇教程一样。

到这一步,已经实现了在本地运行大模型,并且和RAGFlow结合使用,彻底杜绝了私有知识泄露,并且解决了token焦虑问题。希望这篇文章对你有用~~

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

4193

4193

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?