一、为什么需要微调?

在LLM大模型落地到具体的场景中时,经常会感觉,大模型给出的答案比较泛、通用、无法结合私有知识有针对性的回答、有幻觉。为了改善这些问题,企业落地时通常有3种主流方案:调Promot、RAG、微调。这3种方案,理论上效果会越来越好,但成本也会越来越高,由此目前普遍的做法是从左到右依次尝试。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

要讲清楚所有的方案,内容会非常的多,因此得分成几个篇章,本文主要介绍微调。

二、什么情况考虑微调?

1、希望模型回答,具备特定的一种风格,包括特色语气、形式等,且有私有知识能反映这种特征

2、希望进一步提高模型回答准确性,改善幻觉,尤其是单靠prompt、RAG等性价比高的方案或快速工程无法修复的时候。

3、希望对特定细分领域知识回答专业准确,比如法律、医疗、金融,这种通用模型训练时很难获取到的领域数据,且有对应细分领域的数据积累。

4、想用更低的成本,使用更好更新更贵一代的大模型,比如微调gpt3.5,使其具备gpt4的能力。

5、难以在提示中阐明的新任务或技能。

三、微调是什么?

通俗一点的解释:

就是从头重训一个大模型,成本、周期和复杂度都太高了,那我们就不重头训,而是调整下预训练大模型的权重参数,或者输入输出,这样微调下,看看能不能达到效果。

来龙去脉的详细介绍:

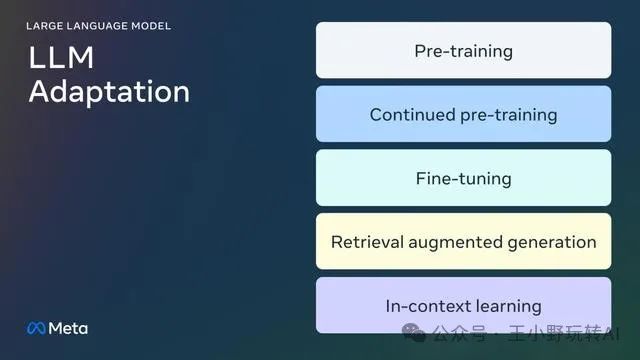

下图是Meta官网于24年8月给出的,一个适配大模型的分步流程图,我们先从这张图了解下微调(Fine-tuning)在流程中所处的环节,并有一个全局环节的概念。

环节1:预训练(Pre-training)

预训练是指我们拿到海量(数万亿级别)的数据集,对大模型使用自监督算法进行训练,生成一个预训练基础模型。这个时候的模型,是一个通用模型,各方面能力都还不错。整个过程较长,至少以月为单位,成千上万个GPU并行工作。比如,Llama 2训练数据量有2万亿toke,而Llama 2 70B版本训成,花费了1,720,320个GPU小时。

(这就是本节开头所说的从头重训一个大模型,成本、周期和复杂度都太高了,因此在企业落地时才有了微调等在内的改善方案)

环节2:继续预训练(Continued pre-training,简称CPT)

继续预训练(也称第二阶段预训练)会用全新的、模型没见过的领域数据进一步训练,继续使用与上个环节相同的 自监督算法, 但会涉及所有模型权重,并将一部分原始数据与新数据混合。

之所有会有这个环节,是因为只做环节1,容易发生“灾难性遗忘”现象,通俗点的解释,就是像人容易忘记以前学的知识一样,模型也容易忘记以前学的知识。而经研究表明,持续的CPT,可以用相对于环节1少很多的成本(成本是比环节1少,但还是很贵),取得一定的改善。

由于CPT成本依然很高,且“灾难性遗忘”还是会发生,所以就有了下个环节,我们本篇的主角“微调”终于登场。

环节3:微调(Fine-tuning)

区别于上面2个环节使用没有人工标注的数据集,微调以监督方式使用相对少量的带注释的数据,这样使得成本更为低廉.

总结下,与预训练相比,微调有两个主要区别:

-

1)训练方式:在包含正确标签/答案/偏好的注释数据集上进行监督训练,而不是自监督训练

-

2)训练数据量:需较少token,千/万量级(对比预训练需数十亿/数万亿),其主要目的是提高能力,如指令遵循、人类对齐、任务执行等。

我们将在本文第三节继续介绍微调细节,下面还是把后续流程环节介绍完。

环节4:检索增强生成( Retrieval-Augmented Generation, 简称RAG)

顾名思义,它是一种通过检索外部知识库来增强大语言模型的生成能力,从而提高答案的精确性和可信度,同时减少误导性信息的产生的技术。主要好处除了成本低,还可以动态的从企业知识库中获取需要的内容。(RAG详细展开又会有很多内容,所以可以蹲蹲我后续对这个方案的介绍,本文就不详细介绍了)

环节5:情境学习( In-context learning , 简称ICL,又称上下文学习)

它不需要优化任何参数,主要是通过任务指令和一些输入输出示例来很好的执行新任务。所以性价比也很高。

正是因为环节4和5这样有性价比的优势,所以本文开头就提到,企业落地时常常会先尝试RAG这样的方案,只在效果仍不符合要求的情况下,且愿意接受更多预算的情况下,会考虑使用本文介绍的调优,甚至是调优+RAG+迭加其它的环节流程。

四、微调有哪些分类?

上文是从微调的流程和环节的角度展开,下面我们按”改动的参数量“这个维度,可以将微调分成两类:

1)完全微调(Full fine-tuning)

模型所有的参数都会更改,包括在AI 1.0时代 小规模参数模型上的传统微调(比如BERT 100-300M 参数)以及 在GPT、Llama等百亿参数量的大模型上的微调。你可能听说过的SFT(有监督的微调) 就是其中一种。

2)参数高效微调(Parameter-Efficient Fine-Tuning,简称PEFT)

微调的总参数量级只有1-6%,在保持预训练模型不变的情况下,只微调少量附加参数,或更新预训练参数的子集。但是在效果上又能获得接近全模型微调的效果,这样的好处是能进一步降低计算和存储成本。比如我们现在常听到的loRA就是其中一种。

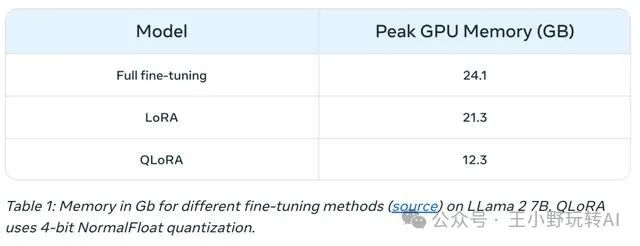

Meta官网列了一张表,列出了Llama 2 7B上三种微调模式(完全微调、LORA和QLoRA)的峰值GPU内存。表明使用PEFT类的算法,即使你的内存有限,也有可能实现微调。

除计算资源外,Meta官网也提出完全调参也更容易出现“灾难性遗忘“现象。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

1064

1064

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?