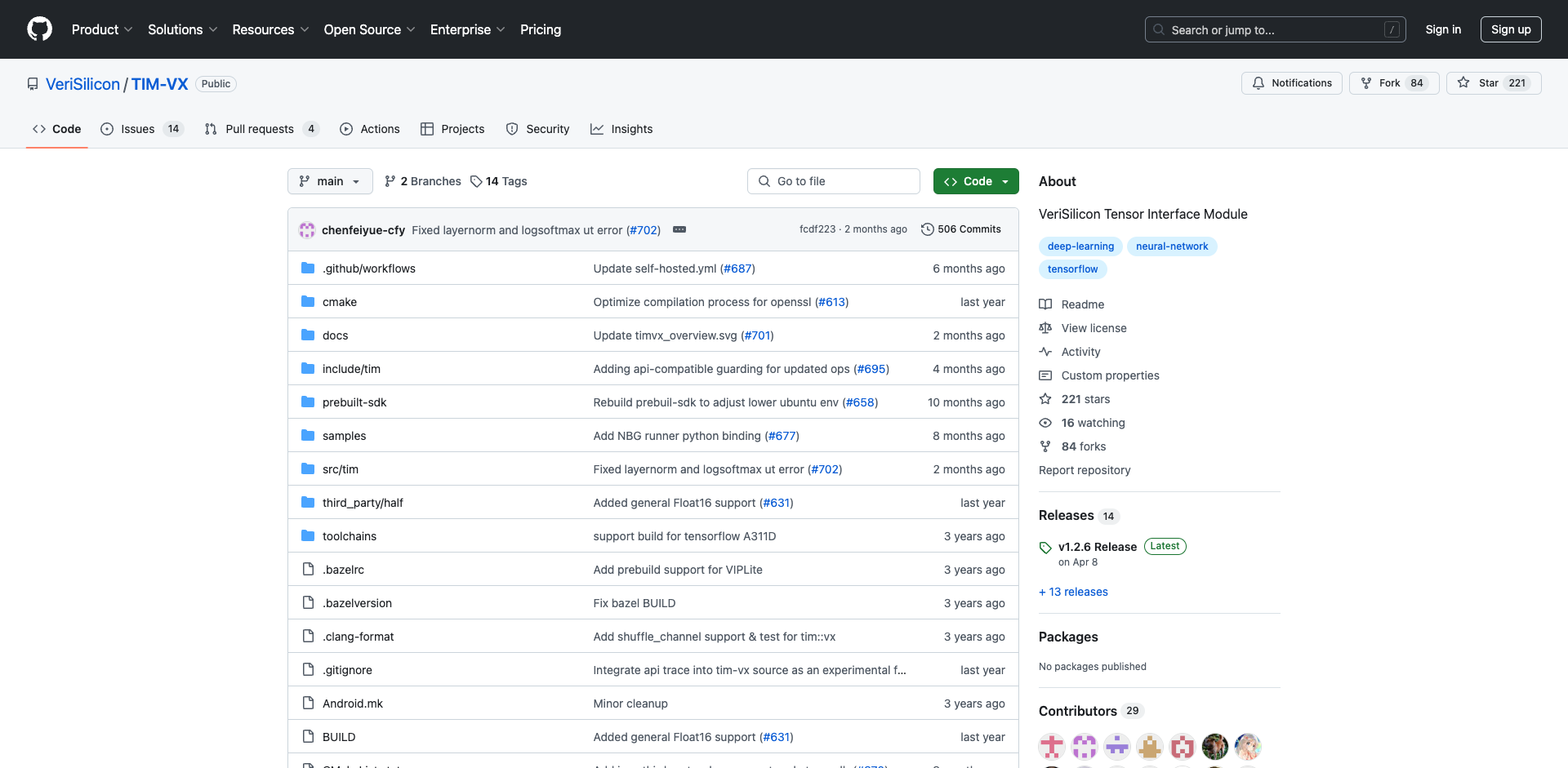

TIM-VX简介

TIM-VX (Tensor Interface Module) 是由芯原微电子(VeriSilicon)开发的一套软件集成模块,旨在简化神经网络在芯原微电子ML加速器上的部署过程。作为一个中间层,TIM-VX连接上层的深度学习框架和底层的硬件加速器,为AI应用提供高效的硬件加速支持。

主要特性

TIM-VX具有以下几个突出特点:

-

丰富的算子支持:提供超过150种神经网络算子,支持量化和浮点数据类型。

-

简洁的C++ API:提供简化的C++ API调用来创建张量和操作。

-

动态图构建:支持动态图构建,并提供形状推理和布局推理功能。

-

自定义层扩展:内置自定义层扩展机制,方便用户扩展新的算子。

-

调试工具:提供一系列用于调试的实用函数。

框架支持

TIM-VX可以作为后端绑定支持多种主流深度学习框架,包括:

- TensorFlow Lite (外部委托)

- Tengine (官方支持)

- TVM (Fork版本)

- Paddle Lite (官方支持)

- OpenCV (官方支持)

- MLIR方言 (开发中)

这种广泛的框架支持使得TIM-VX可以灵活地应用于各类AI应用场景。

技术架构

TIM-VX采用了分层的软件架构设计:

![]()

从上到下主要包含以下几层:

-

应用层:各种深度学习框架和AI应用。

-

TIM-VX API层:提供简洁的C++ API接口。

-

图优化层:执行各种图优化,如算子融合、内存优化等。

-

HAL抽象层:硬件抽象层,屏蔽底层硬件细节。

-

驱动层:NPU硬件驱动。

-

硬件层:VeriSilicon NPU加速器。

这种分层架构使得TIM-VX具有良好的可扩展性和可移植性。

开发指南

环境搭建

TIM-VX支持使用CMake和Bazel两种构建系统。以CMake为例,基本的构建步骤如下:

mkdir host_build

cd host_build

cmake ..

make -j8

make install

构建完成后,所有头文件和库文件会安装到host_build/install目录下。

主要API

TIM-VX提供了简洁的C++ API用于构建神经网络。主要包括以下几类API:

-

上下文(Context)API:用于创建和管理TIM-VX运行环境。

-

图(Graph)API:用于创建计算图。

-

操作(Operation)API:用于添加各种神经网络操作。

-

张量(Tensor)API:用于创建和管理张量数据。

-

量化(Quantization)API:用于设置量化参数。

开发流程

使用TIM-VX开发AI应用的基本流程如下:

-

创建Context和Graph对象。

-

创建输入和输出Tensor。

-

添加各种Operation,构建神经网络。

-

编译Graph。

-

设置输入数据,运行推理。

-

获取输出结果。

这种API设计使得开发者可以灵活地构建各种复杂的神经网络模型。

性能优化

TIM-VX针对VeriSilicon NPU硬件进行了深度优化,主要包括以下几个方面:

-

算子优化:针对NPU指令集优化各类算子实现。

-

内存优化:优化张量内存分配和数据布局,减少内存访问开销。

-

图优化:进行算子融合、常量折叠等图级优化。

-

量化支持:支持INT8/INT16等量化类型,充分利用NPU的定点计算能力。

-

多核调度:支持NPU多核并行计算。

这些优化措施使得TIM-VX可以充分发挥NPU的硬件性能优势。

应用案例

TIM-VX已在多个领域得到成功应用,典型案例包括:

-

智能家电:在NXP i.MX 8M Plus芯片上为智能家电提供AI加速。

-

边缘计算:在AWS SageMaker Edge上实现边缘AI推理加速。

-

智能安防:在Khadas VIM3/VIM3L开发板上实现智能视频分析。

-

工业视觉:结合OpenCV实现工业视觉检测应用加速。

这些案例展示了TIM-VX在各类嵌入式和边缘计算场景下的广泛应用潜力。

未来展望

作为一个活跃发展的开源项目,TIM-VX未来将在以下几个方向持续演进:

-

支持更多深度学习框架,如PyTorch Mobile等。

-

增强对新型神经网络结构的支持,如Transformer等。

-

进一步优化性能和功耗,适应更多边缘计算场景。

-

完善开发工具链,提升开发者体验。

-

扩大硬件支持范围,支持更多NPU IP和SoC平台。

通过持续创新,TIM-VX将为AI应用开发者提供更加强大和易用的神经网络加速解决方案,推动AI技术在各行各业的广泛应用。

总结

TIM-VX作为一个高效的神经网络加速器接口模块,通过提供统一的API抽象和深度的硬件优化,大大简化了AI应用在VeriSilicon NPU上的部署过程。它不仅支持主流深度学习框架,还提供了灵活的扩展机制,能够满足各类AI应用场景的需求。随着边缘AI的快速发展,TIM-VX将在推动AI技术普及和创新方面发挥越来越重要的作用。

无论是对于芯片厂商、设备制造商,还是AI应用开发者,TIM-VX都是一个值得关注和使用的开源项目。它为构建高效的边缘AI解决方案提供了强有力的支持,有望在未来的智能物联网时代扮演更加重要的角色。

文章链接;www.dongaigc.com/a/tim-vx-efficient-nn-accelerator

https://www.dongaigc.com/a/tim-vx-efficient-nn-accelerator

3930

3930

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?