本文是深度学习系列文章的第二篇,我们将深入探讨各种类型的人工神经网络,探索它们独特的特性和应用。

01 神经网络介绍

人工神经网络已经彻底改变了机器学习领域,并成为人工智能的基石,它的设计目的是模仿人类大脑的结构和功能,使计算机能够学习并做出类似人类思维的决策。

人工神经网络首次由神经生理学家沃伦·麦卡洛克和数学家沃尔特·皮茨于1943年提出,之后经历了起起落落,1960年后,随着支持向量机和其他强大的机器学习技术的进步,研究人员对神经网络的兴趣和激情有所下降,这些技术提供了更高的准确性,并具有更坚实的理论基础;神经网络复杂,需要巨大的计算能力和时间来训练,1990年后,计算领域的进步(参考摩尔定律)以及强大的GPU的生产重新引起了一些兴趣。

人工神经网络具有多功能性,适应性和可扩展性,使它们适用于处理大数据集和高度复杂的机器学习任务,如图像分类,语音识别,视频推荐或分析客户情绪等。

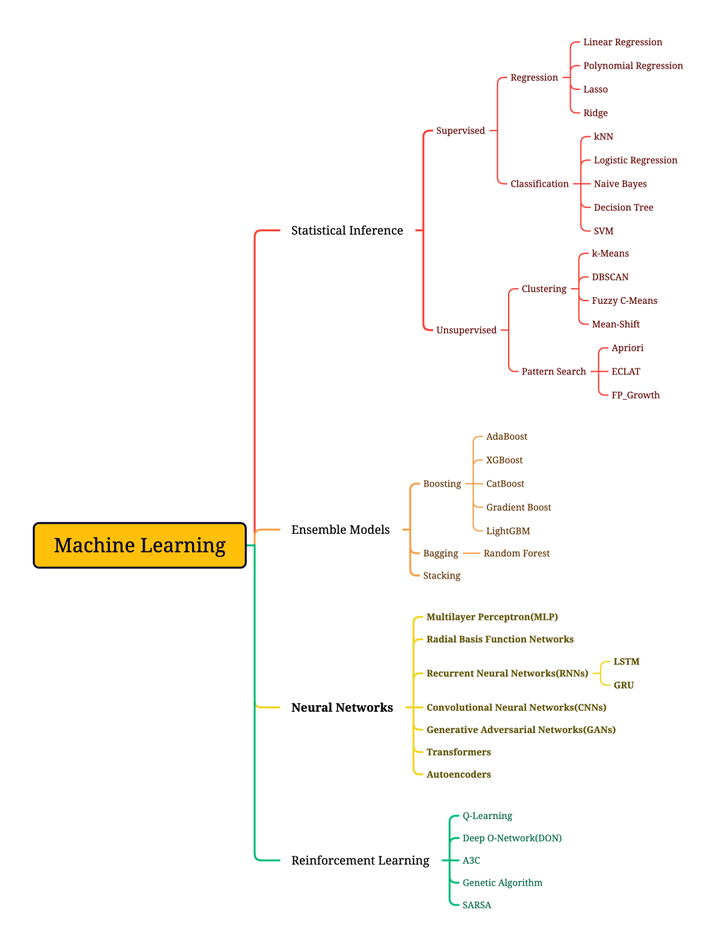

TOP10神经网络分类:

02 麦卡洛-皮茨神经元

麦卡洛-皮茨神经元是第一个数学神经元模型,由Warren McCulloch和Walter Pitts在1943年提出,它是神经科学和数学的结合,尝试通过数学和逻辑来解释神经元的行为,并为后来的人工智能和神经网络研究奠定了基础。

麦卡洛-皮茨神经元采用二进制输出方式,这意味着其输出非0即1,即神经元要么完全激活,要么完全不激活;这种设计灵感来源于生物神经元的“全或无”放电特性,是早期尝试用简化模型理解神经元行为的一种方式。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

399

399

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?