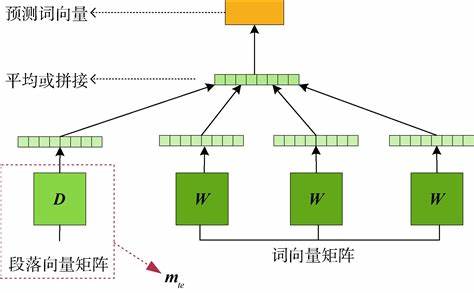

自然语言处理(NLP)的核心挑战在于让机器理解人类语言的丰富含义。词向量(Word Embeddings)技术通过将词语映射到高维实数空间,将离散的符号转化为连续的向量,为NLP任务奠定了坚实基础。在众多词向量模型中,GloVe(Global Vectors for Word Representation)以其独特的设计理念和优异的性能脱颖而出,成为NLP领域不可或缺的工具。

一、词向量:自然语言的数学之舞

1.1 从离散符号到连续空间

-

独热编码的困境: 传统方法使用独热编码表示词语(如“猫”=[0,0,1,0,...,0])。这种方法维度高、稀疏性强,无法表达词语间的任何语义或语法关系。

-

分布式假说: “一个词的含义由其周围的词决定”。词向量模型基于此假说,将语义相似的词映射到向量空间中相近的位置。

-

密集向量优势: 词向量(如“猫”=[0.25, -0.72, 0.83, ..., 0.05])是低维、密集的实数向量。向量间的距离(如余弦相似度)能有效度量词语相似度,并支持向量运算(如“国王 - 男人 + 女人 ≈ 女王”)。

1.2 词向量发展简史

-

神经语言模型(Bengio et al., 2003): 首次提出通过学习神经网络的参数来获取词向量。

-

Word2Vec(Mikolov et al., 2013): 里程碑式工作,包含Skip-gram和CBOW两种高效模型,通过预测上下文词或中心词来训练词向量。

-

GloVe(Pennington et al., 2014): 巧妙结合了全局统计信息(词共现矩阵)和局部上下文窗口训练的优点。

-

上下文相关词向量(ELMo, BERT, GPT): 后续模型(如ELMo, BERT, GPT)能根据词语所在的具体上下文生成动态词向量,性能远超静态词向量(如Word2Vec, GloVe),但GloVe因其简单高效和良好的基础性能,仍被广泛使用。

二、GloVe:全局与局部信息的优雅融合

GloVe的核心思想在于:词语的含义可以通过它们在语料库中与其它词的共现模式来捕捉,且共现概率的比值比概率本身更能区分语义特征。

2.1 共现矩阵:词语关系的全局快照

-

定义: 构建一个

|V| x |V|的矩阵X,其中X_{ij}表示在整个语料库中,词j出现在词i的上下文窗口内的总次数(|V|是词汇表大小)。 -

构建过程:

-

遍历语料库中的每个词(中心词

i)。 -

对于每个中心词,定义其左右一定距离(如5-10词)内的词为其上下文词

j。 -

统计每一对

(i, j)共现的次数,填入矩阵X。 -

通常会对距离较远的上下文词赋予较小的权重(如按

1/d衰减,d是词间距)。

-

-

示例: 考虑句子 “I enjoy playing football and tennis.” (窗口大小=2)

-

X_{enjoy, playing} += 1 -

X_{enjoy, I} += 1/1(距离为1) -

X_{enjoy, football} += 1/1 -

X_{enjoy, and} += 1/2(距离为2) -

X_{playing, enjoy} += 1/1 -

X_{playing, football} += 1/1 -

X_{playing, I} += 1/2 -

X_{playing, and} += 1/1 -

... (以此类推)

-

2.2 GloVe的精髓:共现概率比值的启示

-

关键观察: 假设我们想区分“冰”和“蒸汽”。考虑它们与某些探测词(如“固体”、“气体”、“水”、“时尚”)的共现概率:

-

P(solid|ice)高,P(solid|steam)低 -> 比值P(solid|ice)/P(solid|steam)很大。 -

P(gas|ice)低,P(gas|steam)高 -> 比值P(gas|ice)/P(gas|steam)很小。 -

P(water|ice)和P(water|steam)都比较高 -> 比值 接近1。 -

P(fashion|ice)和P(fashion|steam)都很低 -> 比值 接近1。

-

-

核心洞见: 共现概率的比值

P(k|i)/P(k|j)能够明确地区分相关词(如k=solid, gas)和不相关词(如k=water, fashion),并能区分i和j的不同语义特征(如冰是固体,蒸汽是气体)。 -

GloVe的目标: 词向量的学习目标应该使得词向量之间的点积能够很好地表达共现概率的对数比值。

2.3 GloVe的目标函数:数学之美

基于上述洞见,GloVe模型希望找到词向量 w_i, w_j 和上下文向量 \tilde{w}_k,使得以下关系尽可能成立:

w_i^T \tilde{w}_k + b_i + \tilde{b}_k \approx log(X_{ik})其中:

-

w_i是词i作为中心词时的向量。 -

\tilde{w}_k是词k作为上下文词时的向量(GloVe最终通常使用w_i + \tilde{w}_i作为词i的最终向量)。 -

b_i和\tilde{b}_k是偏置项。 -

log(X_{ik})是词i和词k共现次数的对数。

目标函数(损失函数)J:

J = \sum_{i, j=1}^{|V|} f(X_{ij}) (w_i^T \tilde{w}_j + b_i + \tilde{b}_j - log(X_{ij}))^2-

核心部分:

(w_i^T \tilde{w}_j + b_i + \tilde{b}_j - log(X_{ij}))^2衡量模型预测值w_i^T \tilde{w}_j + b_i + \tilde{b}_j与目标值log(X_{ij})的平方误差。 -

权重函数

f(X_{ij}): GloVe设计的关键创新点!-

作用:

-

避免罕见词噪声:

X_{ij}=0时(词i和j从不共现),log(X_{ij})无定义且无意义。f(0)=0使得这些项不参与计算。 -

平衡高频低频词贡献: 高频词组合(如 “the”, “and”)携带的语义信息通常少于中低频但有意义的组合(如 “ice”, “solid”)。

f(X)应该给高频词组合赋予相对较低的权重,给中低频有意义的组合赋予较高权重。 -

防止权重过大: 对非常高频的词组合,权重也不应无限增长。

-

-

GloVe的 f(x) 定义:

f(x) = \begin{cases}

(x / x_{max})^{\alpha} & \text{if } x < x_{max} \\

1 & \text{otherwise}

\end{cases}-

x_{max}:一个截断阈值(通常设为100)。 -

α:一个经验指数(通常设为3/4)。 -

特性:

-

x=0时,f(x)=0。 -

x < x_{max}时,f(x)随x增长而增长,但呈次线性关系 (x^{3/4}),抑制了高频词组合的权重。 -

x >= x_{max}时,f(x)=1,避免权重过大。

-

-

效果: 这个函数确保了模型主要关注那些频繁共现且具有实际语义信息的词对,有效平衡了数据量和信息密度。

2.4 训练过程:优化目标

-

初始化: 随机初始化所有词向量

w_i,\tilde{w}_j和偏置项b_i,\tilde{b}_j。 -

随机梯度下降(SGD): 这是优化

J的主要方法。

- 每次迭代中,随机采样一个非零的共现计数

X_{ij}(及其对应的词对(i, j))。 - 计算损失函数

J对于当前样本的梯度∇J(w_i, \tilde{w}_j, b_i, \tilde{b}_j)。 - 根据梯度和学习率

η更新参数:

w_i \leftarrow w_i - \eta \cdot \frac{\partial J}{\partial w_i}

\tilde{w}_j \leftarrow \tilde{w}_j - \eta \cdot \frac{\partial J}{\partial \tilde{w}_j}

b_i \leftarrow b_i - \eta \cdot \frac{\partial J}{\partial b_i}

\tilde{b}_j \leftarrow \tilde{b}_j - \eta \cdot \frac{\partial J}{\partial \tilde{b}_j}-

迭代: 重复步骤2直到损失函数收敛或达到预设的迭代次数。

-

最终词向量: 训练完成后,通常将中心词向量和上下文词向量相加作为每个词的最终表示:

w_i^{final} = w_i + \tilde{w}_i。实践表明这能稳定并略微提升性能。

三、GloVe vs. Word2Vec:理念与实践的碰撞

| 特征 | GloVe | Word2Vec (Skip-gram) |

|---|---|---|

| 训练基础 | 全局词共现矩阵 (统计整个语料库) | 局部上下文窗口 (逐句逐词预测) |

| 目标 | 最小化共现计数对数的预测误差 | 最大化上下文词出现的概率 (softmax或负采样) |

| 信息利用 | 显式利用全局统计信息 | 通过多次采样窗口隐式学习统计信息 |

| 训练效率 | 通常更快:矩阵操作高效,易于并行 | 相对慢:需要大量窗口采样和预测 |

| 罕见词 | 处理较好:权重函数 f(x) 降低高频词影响 | 依赖负采样技巧,罕见词学习可能不充分 |

| 向量运算 | 相似度高,都支持类比任务 (king-man+woman≈queen) | 相似度高 |

| 实现 | 需构建/存储(可能很大的)共现矩阵 | 直接处理原始文本流,内存占用可能更友好 |

总结区别:

-

GloVe 像位严谨的统计学家: 它先对整个语料库进行详尽的“人口普查”(构建共现矩阵),然后从中提炼出词语关系的精确数学模型(优化目标函数)。这种方法系统性强,能高效利用全局统计规律。

-

Word2Vec 像位敏锐的观察者: 它不关心整体数据,而是聚焦于一个个具体的语言实例(局部窗口),通过无数次观察局部上下文来归纳词语的用法。这种方法更灵活,直接面向预测任务。

四、动手实践:Python实现简易版GloVe

以下是一个使用PyTorch实现简化版GloVe核心训练过程的代码示例(省略了共现矩阵构建等预处理细节):

import torch

import torch.nn as nn

import torch.optim as optim

class GloVeModel(nn.Module):

def __init__(self, vocab_size, embedding_dim):

super(GloVeModel, self).__init__()

# 中心词嵌入和偏置

self.w_i = nn.Embedding(vocab_size, embedding_dim)

self.b_i = nn.Embedding(vocab_size, 1)

# 上下文词嵌入和偏置

self.w_j = nn.Embedding(vocab_size, embedding_dim)

self.b_j = nn.Embedding(vocab_size, 1)

# 初始化

self.w_i.weight.data.uniform_(-0.5, 0.5)

self.w_j.weight.data.uniform_(-0.5, 0.5)

self.b_i.weight.data.zero_()

self.b_j.weight.data.zero_()

def forward(self, i_idx, j_idx):

"""计算中心词i和上下文词j的组合输出"""

w_i = self.w_i(i_idx) # [batch_size, emb_dim]

b_i = self.b_i(i_idx).squeeze(1) # [batch_size]

w_j = self.w_j(j_idx) # [batch_size, emb_dim]

b_j = self.b_j(j_idx).squeeze(1) # [batch_size]

# 计算点积 + 偏置 (近似 log(X_ij))

return torch.sum(w_i * w_j, dim=1) + b_i + b_j # [batch_size]

def weight_func(x, x_max=100.0, alpha=0.75):

"""计算GloVe权重函数f(x)"""

wx = (x / x_max) ** alpha

wx = torch.min(wx, torch.ones_like(wx)) # min(wx, 1)

return wx

def train_glove(cooccurrences, vocab_size, embedding_dim=100, lr=0.05, x_max=100.0, alpha=0.75, epochs=50):

"""

cooccurrences: 列表,元素为元组 (i_index, j_index, X_ij)

"""

model = GloVeModel(vocab_size, embedding_dim)

optimizer = optim.Adam(model.parameters(), lr=lr)

for epoch in range(epochs):

total_loss = 0.0

# 随机打乱共现对

torch.manual_seed(epoch) # 可重现

indices = torch.randperm(len(cooccurrences))

for idx in indices:

i_idx, j_idx, X_ij = cooccurrences[idx]

# 将索引转换为Tensor

i_idx = torch.tensor([i_idx], dtype=torch.long)

j_idx = torch.tensor([j_idx], dtype=torch.long)

X_ij_tensor = torch.tensor([X_ij], dtype=torch.float)

# 前向传播:模型预测值

model_output = model(i_idx, j_idx)

# 目标值:log(X_ij)

target = torch.log(X_ij_tensor)

# 计算加权损失

weight = weight_func(X_ij_tensor, x_max, alpha)

loss = weight * (model_output - target) ** 2

# 反向传播与优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f"Epoch {epoch+1}/{epochs}, Loss: {total_loss / len(cooccurrences):.4f}")

# 获取最终词向量 (w_i + w_j)

embeddings = model.w_i.weight.data + model.w_j.weight.data

return embeddings.numpy() # 转换为Numpy数组方便使用

# 假设我们有一个小的词汇表 (size=5) 和一些共现数据

vocab = {"apple": 0, "banana": 1, "fruit": 2, "eat": 3, "ripe": 4}

vocab_size = len(vocab)

# 示例共现数据: [(中心词索引, 上下文词索引, 共现次数X_ij)]

cooccurrences = [

(0, 2, 15.0), (2, 0, 15.0), # apple - fruit

(1, 2, 12.0), (2, 1, 12.0), # banana - fruit

(0, 3, 8.0), (3, 0, 8.0), # apple - eat

(1, 3, 7.0), (3, 1, 7.0), # banana - eat

(0, 4, 5.0), (4, 0, 5.0), # apple - ripe

(1, 4, 6.0), (4, 1, 6.0), # banana - ripe

(2, 3, 10.0), (3, 2, 10.0), # fruit - eat

(2, 4, 4.0), (4, 2, 4.0) # fruit - ripe

]

# 训练模型

embeddings = train_glove(cooccurrences, vocab_size, embedding_dim=10, epochs=100)

# 查看结果 (例如,"apple"和"banana"的向量应该比较接近"fruit")

print("Apple vector:", embeddings[0])

print("Banana vector:", embeddings[1])

print("Fruit vector:", embeddings[2])实际应用建议:

-

使用成熟库: 在实际项目中,强烈推荐使用

gensim库 (gensim.models.word2vec支持训练,gensim.downloader提供预训练模型) 或官方 GloVe 实现,它们经过了高度优化,支持大规模语料库训练。 -

预训练模型: 直接下载官方或社区提供的基于维基百科、Common Crawl 等海量语料训练好的 GloVe 词向量 (如

glove.6B.300d.txt包含 40 万词,300 维向量) 是最高效的方式。from gensim.models import KeyedVectors # 下载地址: https://nlp.stanford.edu/projects/glove/ glove_model = KeyedVectors.load_word2vec_format('glove.6B.300d.txt', binary=False, no_header=True) print(glove_model.most_similar('king', topn=5)) # [('queen', 0.7698541283607483), ('prince', 0.684330940246582), ...] result = glove_model.most_similar(positive=['woman', 'king'], negative=['man'], topn=1) print(result[0][0]) # 应该输出 'queen' 或类似词

五、GloVe的应用场景与局限性

应用场景:

-

文本表示基础: 作为下游NLP任务(文本分类、情感分析、命名实体识别、机器翻译)的输入特征。

-

词义相似度/相关度计算: 计算词向量间的余弦相似度,评估词语相似度或寻找近义词。

-

词语类比推理: 解决 “king is to queen as man is to ?” 这类问题。

-

初始化更复杂模型: 为RNN、LSTM、Transformer等模型提供更好的词嵌入初始化起点,加速训练并提升最终性能(尤其在数据有限时)。

-

信息检索与推荐: 计算查询词与文档词的语义相似度,提升搜索和推荐的相关性。

局限性:

-

静态表示: GloVe为每个词生成一个固定的向量,无法处理一词多义(Polysemy)。例如,“bank” (河岸/银行) 在不同上下文中含义不同,但GloVe只能提供一个折中的向量。

-

无法处理新词(OOV): 模型训练完成后,词汇表即固定。遇到未登录词(Out-Of-Vocabulary, OOV)时,只能使用特殊标记(如

<UNK>)或简单启发式方法(如字符级嵌入),效果不佳。 -

依赖共现统计: 模型效果严重依赖于训练语料库的质量、规模和领域适应性。在特定领域(如医疗、法律)应用时,使用通用语料库训练的GloVe效果可能不好,需要领域语料微调或重新训练。

-

上下文无关: 与Word2Vec一样,GloVe缺乏捕捉复杂上下文信息的能力。后续的上下文相关模型(ELMo, BERT)在这方面有质的飞跃。

六、总结:GloVe的遗产与启示

GloVe模型是词向量发展史上的重要里程碑。它通过全局共现矩阵与局部上下文预测思想的巧妙结合,以及对共现概率比值这一关键洞见的数学建模,实现了高效且效果优异的词向量训练。其设计的加权损失函数 f(X_{ij}) 是平衡数据利用的关键创新。

虽然以BERT、GPT为代表的上下文相关预训练语言模型已成为当前NLP的主流,它们能生成动态的、包含丰富上下文信息的词表示,性能远超静态词向量模型,但GloVe并未过时:

-

轻量高效: GloVe模型相对小巧,训练和推理速度快,资源消耗低。在许多对计算资源敏感或不需要复杂上下文建模的场景(如快速构建基线系统、小型应用)中,GloVe仍是实用选择。

-

理论基础清晰: GloVe基于明确的统计动机(共现概率比值)设计,其数学形式和优化目标清晰易懂,为理解词向量学习提供了宝贵的理论视角。

-

优秀的基线: GloVe生成的词向量作为下游任务的输入特征或初始化向量,依然能提供强有力的基线性能。

-

教育价值: 理解GloVe的原理是深入掌握词嵌入技术和现代NLP模型的重要基石。

76

76

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?