神经网络与深度学习实验day11-基于torch用ResNet18模型实现MNIST

5.4 基于残差网络的手写体数字识别实验

残差网络(Residual Network,ResNet)是在神经网络模型中给非线性层增加直连边的方式来缓解梯度消失问题,从而使训练深度神经网络变得更加容易。

在残差网络中,最基本的单位为残差单元。

5.4.1 模型构建

构建ResNet18的残差单元,然后在组建完整的网络。

5.4.1.1 残差单元

残差单元包裹的非线性层的输入和输出形状大小应该一致。

如果一个卷积层的输入特征图和输出特征图的通道数不一致,则其输出与输入特征图无法直接相加。

可以使用1×1大小的卷积将输入特征图的通道数映射为与级联卷积输出特征图的一致通道数。

1×1卷积:与标准卷积完全一样,唯一的特殊点在于卷积核的尺寸是1×1,也就是不去考虑输入数据局部信息之间的关系,而把关注点放在不同通道间。

通过使用1×1卷积,可以起到如下作用:

- 实现信息的跨通道交互与整合。考虑到卷积运算的输入输出都是3个维度(宽、高、多通道),所以1×1卷积实际上就是对每个像素点,在不同的通道上进行线性组合,从而整合不同通道的信息;

- 对卷积核通道数进行降维和升维,减少参数量。经过1×1卷积后的输出保留了输入数据的原有平面结构,通过调控通道数,从而完成升维或降维的作用;

- 利用1×1卷积后的非线性激活函数,在保持特征图尺寸不变的前提下,大幅增加非线性。

定义残差单元ResBlock:

class ResBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1, use_residual=True):

"""

残差单元

输入:

- in_channels:输入通道数

- out_channels:输出通道数

- stride:残差单元的步长,通过调整残差单元中第一个卷积层的步长来控制

- use_residual:用于控制是否使用残差连接

"""

super(ResBlock, self).__init__()

self.stride = stride

self.use_residual = use_residual

# 第一个卷积层,卷积核大小为3×3,可以设置不同输出通道数以及步长

self.conv1 = nn.Conv2d(in_channels, out_channels, 3, padding=1, stride=self.stride, bias=False)

# 第二个卷积层,卷积核大小为3×3,不改变输入特征图的形状,步长为1

self.conv2 = nn.Conv2d(out_channels, out_channels, 3, padding=1, bias=False)

# 如果conv2的输出和此残差块的输入数据形状不一致,则use_1x1conv = True

# 当use_1x1conv = True,添加1个1x1的卷积作用在输入数据上,使其形状变成跟conv2一致

if in_channels != out_channels or stride != 1:

self.use_1x1conv = True

else:

self.use_1x1conv = False

# 当残差单元包裹的非线性层输入和输出通道数不一致时,需要用1×1卷积调整通道数后再进行相加运算

if self.use_1x1conv:

self.shortcut = nn.Conv2d(in_channels, out_channels, 1, stride=self.stride, bias=False)

# 每个卷积层后会接一个批量规范化层,批量规范化的内容在7.5.1中会进行详细介绍

self.bn1 = nn.BatchNorm2d(out_channels)

self.bn2 = nn.BatchNorm2d(out_channels)

if self.use_1x1conv:

self.bn3 = nn.BatchNorm2d(out_channels)

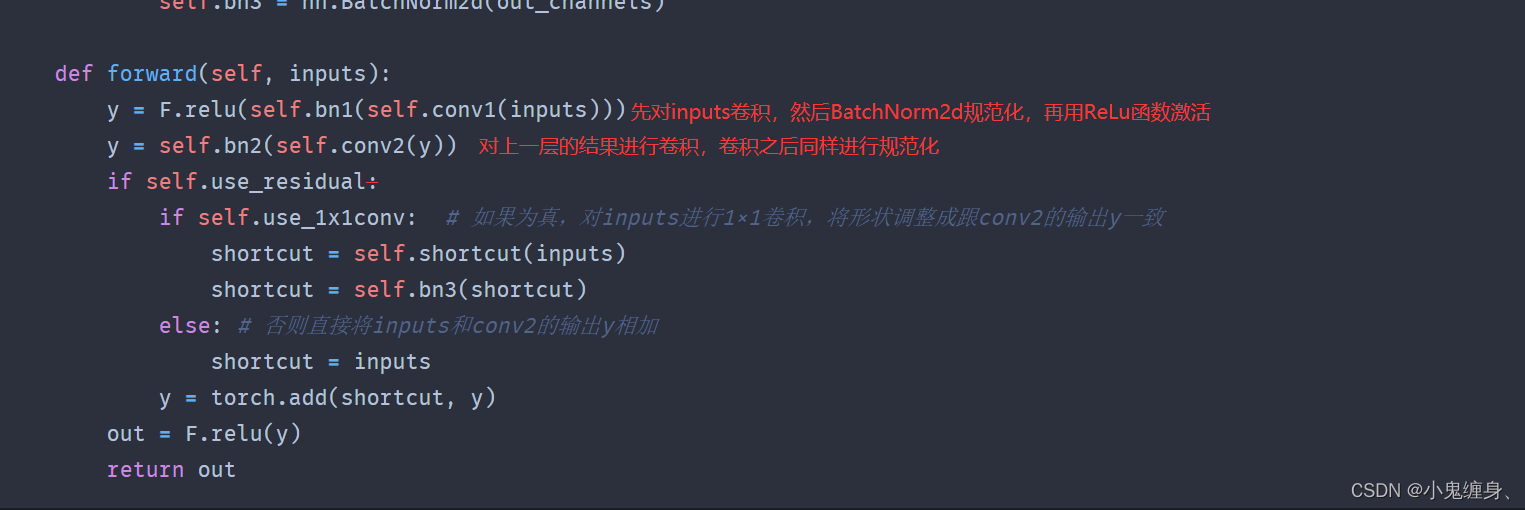

def forward(self, inputs):

y = F.relu(self.bn1(self.conv1(inputs)))

y = self.bn2(self.conv2(y))

if self.use_residual:

if self.use_1x1conv: # 如果为真,对inputs进行1×1卷积,将形状调整成跟conv2的输出y一致

shortcut = self.shortcut(inputs)

shortcut = self.bn3(shortcut)

else: # 否则直接将inputs和conv2的输出y相加

shortcut = inputs

y = torch.add(shortcut, y)

out = F.relu(y)

return out

关于残差单元的几点说明(方便自己理解):

- use_residual:用于控制是否使用残差连接,这个如果设置为False,就说明这不是一个残差单元,而是一个先卷积再规范化再激活,对于结果再卷积再规范化的操作,没有体现残差的特点。在上图所示中,我们设置use_residual为True,从而使得输出残差加到输入中,完成残差连接。

- use_1x1conv,设置为True, 添加1个1x1的卷积作用在输入数据上,使其形状变成跟conv2一致,用来控制不一致通道的问题。

5.4.1.2 残差网络的整体结构

def make_first_module(in_channels):

# 模块一:7*7卷积、批量规范化、汇聚

m1 = nn.Sequential(nn.Conv2d(in_channels, 64, 7, stride=2, padding=3),

nn.BatchNorm2d(64), nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

return m1

def resnet_module(input_channels, out_channels, num_res_blocks, stride=1, use_residual=True):

blk = []

# 根据num_res_blocks,循环生成残差单元

for i in range(num_res_blocks):

if i == 0: # 创建模块中的第一个残差单元

blk.append(ResBlock(input_channels, out_channels,

stride=stride, use_residual=use_residual))

else: # 创建模块中的其他残差单元

blk.append(ResBlock(out_channels, out_channels, use_residual=use_residual))

return blk

def make_modules(use_residual):

# 模块二:包含两个残差单元,输入通道数为64,输出通道数为64,步长为1,特征图大小保持不变

m2 = nn.Sequential(*resnet_module(64, 64, 2, stride=1, use_residual=use_residual))

# 模块三:包含两个残差单元,输入通道数为64,输出通道数为128,步长为2,特征图大小缩小一半。

m3 = nn.Sequential(*resnet_module(64, 128, 2, stride=2, use_residual=use_residual))

# 模块四:包含两个残差单元,输入通道数为128,输出通道数为256,步长为2,特征图大小缩小一半。

m4 = nn.Sequential(*resnet_module(128, 256, 2, stride=2, use_residual=use_residual))

# 模块五:包含两个残差单元,输入通道数为256,输出通道数为512,步长为2,特征图大小缩小一半。

m5 = nn.Sequential(*resnet_module(256, 512, 2, stride=2, use_residual=use_residual))

return m2, m3, m4, m5

# 定义完整网络

class Model_ResNet18(nn.Module):

def __init__(self, in_channels=3, num_classes=10, use_residual=True):

super(Model_ResNet18,self).__init__()

m1 = make_first_module(in_channels)

m2, m3, m4, m5 = make_modules(use_residual)

# 封装模块一到模块6

self.net = nn.Sequential(m1, m2, m3, m4, m5,

# 模块六:汇聚层、全连接层

nn.AdaptiveAvgPool2d(1), nn.Flatten(), nn.Linear(512, num_classes) )

def forward(self, x):

return self.net(x)

5.4.2 没有残差连接的ResNet18

先使用没有残差连接的ResNet18进行实验,先前已经有了整体模型,当我们不想使用残差连接时,我们设置use_residual = False即可。

model = Model_ResNet18(in_channels=1, num_classes=10, use_residual=False)

5.4.2.1 模型训练

训练代码:

# 学习率大小

lr = 0.005

# 批次大小

batch_size = 64

# 加载数据

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

dev_loader = DataLoader(dev_dataset, batch_size=batch_size)

test_loader = DataLoader(test_dataset, batch_size=batch_size)

# 定义网络,不使用残差结构的深层网络

model = Model_ResNet18(in_channels=1, num_classes=10, use_residual=False)

# 定义优化器

optimizer = opti.SGD(model.parameters(),lr=lr)

# 实例化RunnerV3

runner = RunnerV3(model, optimizer, loss_fn, metric)

# 启动训练

log_steps = 15

eval_steps = 15

runner.train(train_loader, dev_loader, num_epochs=5, log_steps=log_steps,

eval_steps=eval_steps, save_path="best_model.pdparams")

训练结果:

可视化训练过程中的误差变化:

#可视化误差

def plot(runner, fig_name):

plt.figure(figsize=(10,5))

plt.subplot(1,2,1)

train_items = runner.train_step_losses[::30]

train_steps=[x[0] for x in train_items]

train_losses = [x[1] for x in train_items]

plt.plot(train_steps, train_losses, color='#8E004D', label="Train loss")

if runner.dev_losses[0][0]!=-1:

dev_steps=[x[0] for x in runner.dev_losses]

dev_losses = [x[1] for x in runner.dev_losses]

plt.plot(dev_steps, dev_losses, color='#E20079', linestyle='--', label="Dev loss")

#绘制坐标轴和图例

plt.ylabel("loss", fontsize='x-large')

plt.xlabel("step", fontsize='x-large')

plt.legend(loc='upper right', fontsize='x-large')

plt.subplot(1,2,2)

#绘制评价准确率变化曲线

if runner.dev_losses[0][0]!=-1:

plt.plot(dev_steps, runner.dev_scores,

color='#E20079', linestyle="--", label="Dev accuracy")

else:

plt.plot(list(range(len(runner.dev_scores))), runner.dev_scores,

color='#E20079', linestyle="--", label="Dev accuracy")

#绘制坐标轴和图例

plt.ylabel("score", fontsize='x-large')

plt.xlabel("step", fontsize='x-large')

plt.legend(loc='lower right', fontsize='x-large')

plt.savefig(fig_name)

plt.show()

plot(runner, 'cnn-loss2.pdf')

注意:关于这部分内容,一些类和函数:比如RunnerV3,loss_fn,metric,所有一些这里没有的函数在我的上一篇文章:神经网络与深度学习day10-LeNet实现mnist 中存在,直接复制本节代码不可运行。可以在之前LeNet完成mnist的代码基础上继续运行本节代码。

5.4.2.2 模型评价

# 加载最优模型

runner.load_model('best_model.pdparams')

# 模型评价

score, loss = runner.evaluate(test_loader)

print("[Test] accuracy/loss: {:.4f}/{:.4f}".format(score, loss))

[Test] accuracy/loss: 0.9750/0.1277

5.4.2.3 模型参数统计

5.4.3 带残差连接的ResNet18

使用残差连接的ResNet18进行实验,先前已经有了整体模型,我们设置use_residual = True即可,可以在代码中看到这一点。

model = Model_ResNet18(in_channels=1, num_classes=10, use_residual=True)

5.4.3.1 模型训练

训练代码:

# 学习率大小

lr = 0.01

# 批次大小

batch_size = 64

# 加载数据

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

dev_loader = DataLoader(dev_dataset, batch_size=batch_size)

test_loader = DataLoader(test_dataset, batch_size=batch_size)

# 定义网络,通过指定use_residual为True,使用残差结构的深层网络

model = Model_ResNet18(in_channels=1, num_classes=10, use_residual=True)

# 定义优化器

optimizer = opti.SGD(model.parameters(),lr=lr)

# 实例化RunnerV3

runner = RunnerV3(model, optimizer, loss_fn, metric)

# 启动训练

log_steps = 15

eval_steps = 15

runner.train(train_loader, dev_loader, num_epochs=5, log_steps=log_steps,

eval_steps=eval_steps, save_path="best_model.pdparams")

# 可视化观察训练集与验证集的Loss变化情况

plot(runner, 'cnn-loss3.pdf')

训练结果:

可视化结果:

5.4.3.2 模型评价

# 加载最优模型

runner.load_model('best_model.pdparams')

# 模型评价

score, loss = runner.evaluate(test_loader)

print("[Test] accuracy/loss: {:.4f}/{:.4f}".format(score, loss))

评价结果:

[Test] accuracy/loss: 0.9800/0.0427

5.4.3.3 模型参数统计

5.4.4 与高层API实现版本的对比实验

飞桨高层 API是对飞桨API的进一步封装与升级,提供了更加简洁易用的API,进一步提升了飞桨的易学易用性。

其中,飞桨高层API封装了以下模块:

- Model类,支持仅用几行代码完成模型的训练;

- 图像预处理模块,包含数十种数据处理函数,基本涵盖了常用的数据处理、数据增强方法;

- 计算机视觉领域和自然语言处理领域的常用模型,包括但不限于mobilenet、resnet、yolov3、cyclegan、bert、transformer、seq2seq等等,同时发布了对应模型的预训练模型,可以直接使用这些模型或者在此基础上完成二次开发。

飞桨高层 API主要包含在paddle.vision和paddle.text目录中。

对于Reset18这种比较经典的图像分类网络,飞桨高层API中都为大家提供了实现好的版本,大家可以不再从头开始实现。

这里为高层API版本的resnet18模型和自定义的resnet18模型赋予相同的权重,并使用相同的输入数据,观察输出结果是否一致。

对比代码:

import warnings

#warnings.filterwarnings("ignore")

# 使用飞桨HAPI中实现的resnet18模型,该模型默认输入通道数为3,输出类别数1000

hapi_model = resnet18(pretrained=True)

# 自定义的resnet18模型

model = Model_ResNet18(in_channels=3, num_classes=1000, use_residual=True)

# 获取网络的权重

params = hapi_model.state_dict()

# 用来保存参数名映射后的网络权重

new_params = {}

# 将参数名进行映射

for key in params:

print(key)

if 'layer' in key:

if 'downsample.0' in key:

new_params['net.' + key[5:8] + '.bn3.' + key[-6:]] = params[key]

elif 'downsample.1' in key:

new_params['net.' + key[5:8] + '.bn3.' + key[22:]] = params[key]

else:

new_params['net.' + key[5:]] = params[key]

elif 'conv1.weight' == key:

new_params['net.0.0.weight'] = params[key]

elif 'bn1' in key:

new_params['net.0.1' + key[3:]] = params[key]

elif 'fc' in key:

new_params['net.7' + key[2:]] = params[key]

#补充缺失项

if(key=='conv1.weight'):

new_params['net.0.0.bias'] = model_dict['net.0.0.bias']

if(key=='layer2.0.bn1.weight'):

new_params['net.2.0.shortcut.weight'] = model_dict['net.2.0.shortcut.weight']

if(key=='layer3.0.bn1.weight'):

new_params['net.3.0.shortcut.weight'] = model_dict['net.3.0.shortcut.weight']

if(key=='layer4.0.bn1.weight'):

new_params['net.4.0.shortcut.weight'] = model_dict['net.4.0.shortcut.weight']

# 将飞桨HAPI中实现的resnet18模型的权重参数赋予自定义的resnet18模型,保持两者一致

model.load_state_dict(new_params)

#model.load_state_dict(torch.load("best_model.pdparams"))

#model.load_state_dict(new_params)

# 这里用np.random创建一个随机数组作为测试数据

inputs = np.random.randn(*[3,3,32,32])

inputs = inputs.astype('float32')

x = torch.tensor(inputs)

output = model(x)

hapi_out = hapi_model(x)

# 计算两个模型输出的差异

diff = output - hapi_out

# 取差异最大的值

max_diff = torch.max(diff)

print(max_diff)

先给出最终结果:

说一下对比和我的一些浅薄看法(可能多余了):

对于这部分参数名映射来说:

参数名映射其实想要将torchvision.models下的resnet18的模型值转化为自定义ResNet18的模型参数值,从而将resnet18的模型参数映射到自定义ResNet18的模型参数下,再通过传入相同的值,观察两者的输出结果,其中,由于自定义ResNet18的参数值有122个,resnet18给出的参数值只有119个从而导致与model.state_dict()中的参数数目不同,产生错误:

一开始我以为我没有改对的时候,我就用paddle运行了一下邱老师的标准程序,其中加入了一些print:

from paddle.vision.models import resnet18

import warnings

#warnings.filterwarnings("ignore")

# 使用飞桨HAPI中实现的resnet18模型,该模型默认输入通道数为3,输出类别数1000

hapi_model = resnet18()

# 自定义的resnet18模型

model = Model_ResNet18(in_channels=3, num_classes=1000, use_residual=True)

# 获取网络的权重

params = hapi_model.state_dict()

# 用来保存参数名映射后的网络权重

new_params = {}

# 将参数名进行映射

for key in params:

if 'layer' in key:

if 'downsample.0' in key:

new_params['net.' + key[5:8] + '.shortcut' + key[-7:]] = params[key]

elif 'downsample.1' in key:

new_params['net.' + key[5:8] + '.shorcutt' + key[23:]] = params[key]

else:

new_params['net.' + key[5:]] = params[key]

elif 'conv1.weight' == key:

new_params['net.0.0.weight'] = params[key]

elif 'bn1' in key:

new_params['net.0.1' + key[3:]] = params[key]

elif 'fc' in key:

new_params['net.7' + key[2:]] = params[key]

# 将飞桨HAPI中实现的resnet18模型的权重参数赋予自定义的resnet18模型,保持两者一致

print(len(params))

print("******************")

print(len(new_params))

print(len(model.state_dict()))

model.set_state_dict(new_params)

# 这里用np.random创建一个随机数组作为测试数据

inputs = np.random.randn(*[1,3,32,32])

inputs = inputs.astype('float32')

x = paddle.to_tensor(inputs)

output = model(x)

hapi_out = hapi_model(x)

# 计算两个模型输出的差异

diff = output - hapi_out

# 取差异最大的值

max_diff = paddle.max(diff)

print(max_diff)

得到的结果:

这里模型参数量的不一致,我归纳为Torch和Paddle内置的函数不一致的问题可以看到的是,目标模型有110个参数,而只传入了model下102个参数,有8个参数失去了关键字(key)所以邱老师的程序也会提醒MissingKey错误,但是可能由于Paddle的执行方法,依然能够对后边的代码进行执行,从而得到了最后的Tensor(1)结果,对于一些参数没有赋key值然后训练,个人第一方面是因为Torch代码转化过来是因为MissingKey导致我无法看到最后的输出结果,另一方面感觉最后的结果不是很准确,于是我又将丢失关键字的参数,对其key值保持不变,即下边代码:

#补充缺失项

if(key=='conv1.weight'):

new_params['net.0.0.bias'] = model_dict['net.0.0.bias']

if(key=='layer2.0.bn1.weight'):

new_params['net.2.0.shortcut.weight'] = model_dict['net.2.0.shortcut.weight']

if(key=='layer3.0.bn1.weight'):

new_params['net.3.0.shortcut.weight'] = model_dict['net.3.0.shortcut.weight']

if(key=='layer4.0.bn1.weight'):

new_params['net.4.0.shortcut.weight'] = model_dict['net.4.0.shortcut.weight']

最终得到了最后的Tensor(12),我将原因归结为这部分参数的问题,因为在resnet18中没有这些参数,但是我们自定义的ResNet18中出现了这些参数,从而导致最终结果的不一致性。

总结

总结一下本次实验,通过ResNet经典残差网络完成了Mnist手写数字的识别,我确实体会到了残差网络的优越性和想法的新颖,放在几年前,我可能还是个只在画圆圈和方块的孩子,而大佬已经把圆圈和方块变成残差网络了,对于残差网络的学习,我觉得我还是不够深入,重新过一边课本,然后仔细看看一些细节,对于与高层API的对比torch.nn.models中的resnet18模型,虽然出了一些问题,好歹找到了错误的原因,对我来说分析代码改代码的能力还是有所提升的。今天的总结就到这里,以下是参考博客:

References:

NNDL 实验5(上) - HBU_DAVID - 博客园 (cnblogs.com)

NNDL 实验5(下) - HBU_DAVID - 博客园 (cnblogs.com)

5.3 基于LeNet实现手写体数字识别实验

附:感谢Paddle官网提供的深度学习平台。

这里是老师的博客:

NNDL 实验六 卷积神经网络(4)ResNet18实现MNIST

3557

3557

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?