Abstract

作者提出基于运动特征的模型近年来未被完全开发,现有的很多算法往往假设物体线性运动,因此对于非线性或遮挡情况效果不好,需要高帧率的视频。作者强调了observation对于恢复丢失的track以及减小线性运动模型带来的误差的重要性,提出了OC-SORT,并且在KITTI、DanceTrack上实现SOTA。

1. Introduction

作者希望设计一个运动模型来应对多目标跟踪任务中出现的遮挡及非线性运动问题,目前大部分运动模型误差来源于假设物体线性运动。作者希望在不利用外貌特征的前提下解决这些问题并提高跟踪的鲁棒性。

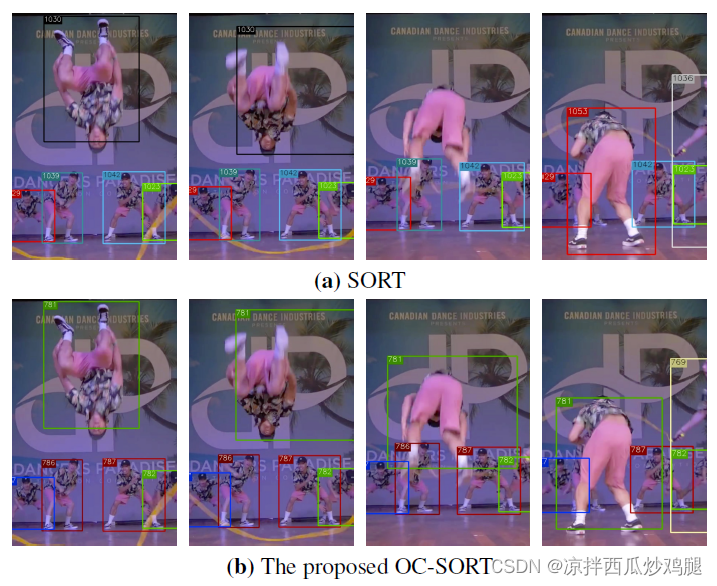

SORT是一个常用的运动模型算法,使用卡尔曼滤波来估计物体的运动。不同于estimation-centric的SORT方法,作者提出了observation-centric的方法,解决了SORT带来的三大问题:

- sensitive to state noise:对于高帧率视频,目标位移的噪声可能就和位移大小本身差不多,会提高对噪声的敏感性

- error accumulation:当没有新的检测结果与当前轨迹匹配时,误差会不断累积

- estimation-centric:SORT依赖于卡尔曼滤波的预测,observations仅仅作为辅助

为了解决上述问题,作者提出了本文的三项创新点:

- observation-centric online smoothing(OOS):对于跟踪中断后又重新与检测结果匹配的轨迹,对该目标上次消失前最后一次观测到再次被重新观测之间建立一个虚拟轨迹,并利用该轨迹来平滑卡尔曼滤波参数

- observation-centric momentum(OCM):在cost matrix中加入了轨迹方向的一致性,证明了对相隔比较大的两点之间的方向进行估计可以减少噪声

- observation-centric recovery(OCR):为了减少在短时内目标因遮挡成为inactive的问题,作者提出了根据它们新就旧观测进行恢复的策略

OC-SORT的贡献可总结为以下三点:

- 分析了SORT的三大limitations

- 提出OC-SORT并创新性设计了OOS、OCM、OCR

- 在MOT基准上达到新SOTA

2. Related Works

回顾了一些经典的motion models,以及基于检测的跟踪,利用外观信息的跟踪,以及基于Transformer的跟踪方法,但是这些方法在很多情况下都有局限性。

3. Rethinking SORT

3.1 Background

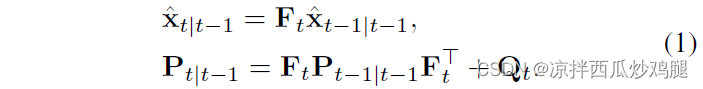

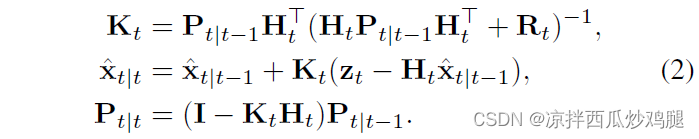

介绍了Kalman Filter和SORT,KF可分解为预测与更新两部分,在预测部份通过t-1帧的信息预测第t帧,计算公式如下

并利用第t帧的观测信息来更新当前帧的状态,如下所示

SORT是一个基于KF的运动模型,其中的状态

x

\rm{x}

x为包含7个元素的元组

x

=

[

u

,

v

,

s

,

r

,

u

˙

,

v

˙

,

s

˙

]

\rm{x} = [u, v, s, r, \dot{u}, \dot{v}, \dot{s}]

x=[u,v,s,r,u˙,v˙,s˙],

(

u

,

v

)

(u, v)

(u,v)代表二维坐标,

s

s

s代表尺度,

r

r

r代表bbox的比例,后三项为导数。观测结果

z

=

[

u

,

v

,

w

,

h

,

c

]

T

\rm{z} = [u, v, w, h, c]^T

z=[u,v,w,h,c]T,其中

(

u

,

v

)

(u,v)

(u,v)为坐标,

(

w

,

h

)

(w, h)

(w,h)为宽高,

c

c

c为置信度。

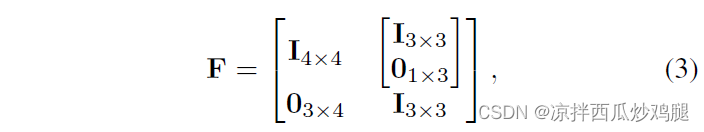

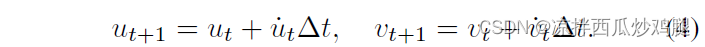

SORT使用线性运动模型,因此transition model可以表示为

从而可以得到相邻两帧的位置关系

当视频帧率较高的时候,SORT在非线性运动情况下也能达到较好的效果,因为在较短的时间间隔内,物体可认为是线性运动。

3.2 Limitations of SORT

3.2.1 Sensitive to State Noise

假设物体坐标的满足

u

∼

N

(

μ

u

,

σ

u

2

)

,

v

∼

N

(

μ

v

,

σ

v

2

)

u \sim N(\mu_u, \sigma_u^2), v \sim N(\mu_v, \sigma_v^2)

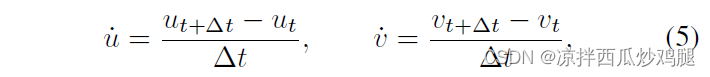

u∼N(μu,σu2),v∼N(μv,σv2),由于线性运动,可以得到速度如下

从而速度估计结果满足

δ

u

˙

∼

N

(

0

,

2

σ

u

2

(

Δ

t

)

2

)

,

δ

v

˙

∼

N

(

0

,

2

σ

v

2

(

Δ

t

)

2

)

\delta_{\dot{u}} \sim N(0, \frac{2\sigma_u^2}{(\Delta t)^2}), \delta_{\dot{v}} \sim N(0, \frac{2\sigma_v^2}{(\Delta t)^2})

δu˙∼N(0,(Δt)22σu2),δv˙∼N(0,(Δt)22σv2),因此通过连续帧估计速度得到的噪声值最大。

3.2.2 Temporal Error Magnification

对于公式(5)的分析,我们假设前后两帧的运动估计是相互独立的,但对于KF,当前状态的位置估计量依赖于先前状态。当观测结果存在时,可以利用观测结果来指导KF的更新阶段。但当观测结果不存在时,KF只能基于自己的预测来进行更新。

考虑一段在第t帧与第t+T帧之间被遮挡的轨迹,假设速度的噪声分布

δ

u

t

˙

∼

N

(

0

,

2

σ

u

2

)

,

δ

v

t

˙

∼

N

(

0

,

2

σ

v

2

)

\delta_{\dot{u_t}} \sim N(0,2\sigma_u^2), \delta_{\dot{v_t}} \sim N(0,2\sigma_v^2)

δut˙∼N(0,2σu2),δvt˙∼N(0,2σv2),第t+T帧的位置估计为

其噪声分布满足

δ

u

˙

t

+

T

∼

N

(

0

,

2

T

2

σ

u

2

)

,

δ

v

˙

t

+

T

∼

N

(

0

,

2

T

2

σ

v

2

)

\delta_{\dot{u}_{t+T}} \sim N(0,2T^2\sigma_u^2), \delta_{\dot{v}_{t+T}} \sim N(0,2T^2\sigma_v^2)

δu˙t+T∼N(0,2T2σu2),δv˙t+T∼N(0,2T2σv2),可见在没有观测结果的情况下,噪声会不断累积放大。

3.2.3 Estimation-Centric

KF的一个很大的问题在于它是以estimation为中心的,外部的observation只是用于辅助更新,对于一个鲁棒的跟踪器,其往往需要更多关注观察的结果而非KF的状态估计。

4 Observation-Centric SORT

4.1 Observation-centric Online Smoothing (OOS)

当一个轨迹中断后,重新与观测结果关联时,作者使用OOS为该对象构建一条虚拟轨迹,从跟踪丢失之前的最后一个检测开始,到新匹配到检测结束。沿着这个虚拟轨迹,平滑卡尔曼滤波器参数,以获得更好的目标位置估计。

4.2 ObservationCentric Momentum (OCM)

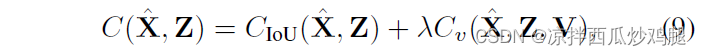

线性运动模型假定速度方向一致,然而由于物体的非线性运动和状态噪声,这种假设往往不成立。较短的时间间隔内物体可认为是线性运动,但是由于噪声的存在,很难去充分利用物体运动方向的连续性信息。作者提出了OCM,将动量添加到成本矩阵中,如下所示

X

^

\hat{X}

X^为目标的估计状态矩阵,

Z

Z

Z为检测的状态矩阵,

V

V

V是包含由之前两次时差观测值计算的现有轨迹的方向。

C

I

o

U

(

,

)

C_{\rm{IoU}}( , )

CIoU(,)计算负对检测框和预测值之间的IoU值,

C

v

C_v

Cv计算轨迹的方向和由轨迹的历史检测和新检测形成的方向,

λ

λ

λ是权重因子。该方法使用与轨迹相关的检测值进行方向计算,以避免估计状态下的误差累积,我们可以自己权衡观测点之间的时间差。在线性运动模型下,噪声大小与两个观测点的时间差成正比。在很短的时间间隔内,轨迹可以近似看成线性的,所以时间差不能太大。

4.3 ObservationCentric Recovery (OCR)

由于检测器的不可靠,检测物体发生重叠和非线性运动,常常发生轨迹中断。作者提出OCR,轨迹的回复依赖于检测值而不是错误的估计值。当轨迹丢失后检测目标再出现时,直接将丢失轨迹时检测值和重新出现的检测值相关联以恢复轨迹。

5 Experiments

5.1 Experimental Setup

介绍了在数据集、实现、评价标准的一些内容。

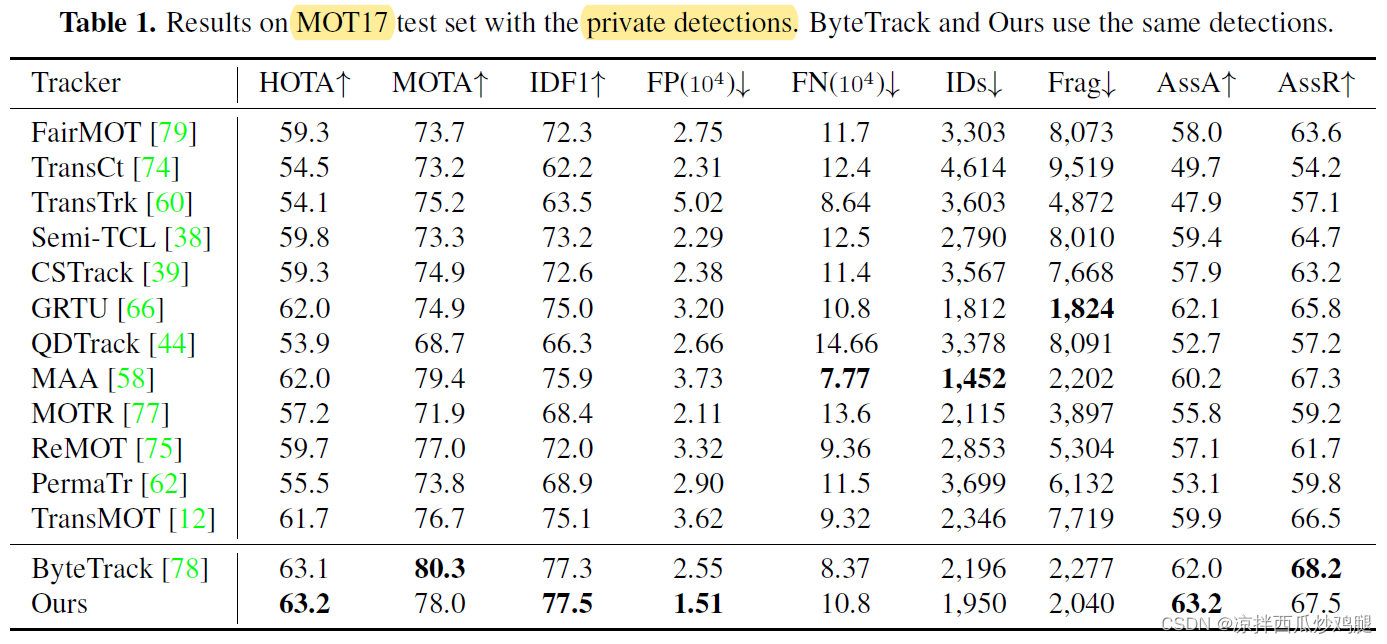

5.2 Benchmark Results

- MOT17,私有检测

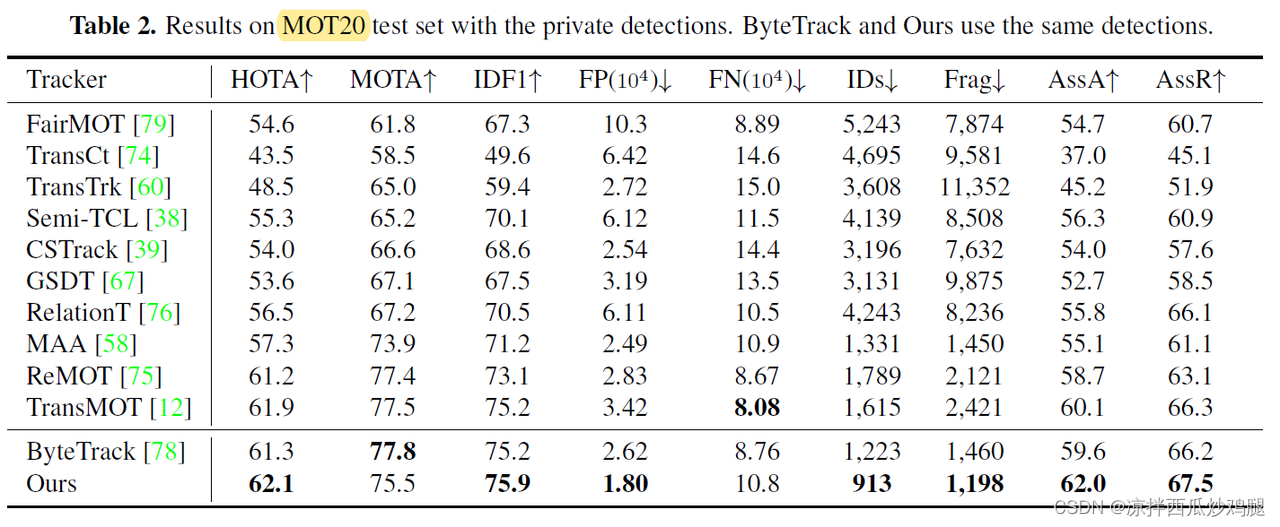

- MOT20,私有检测

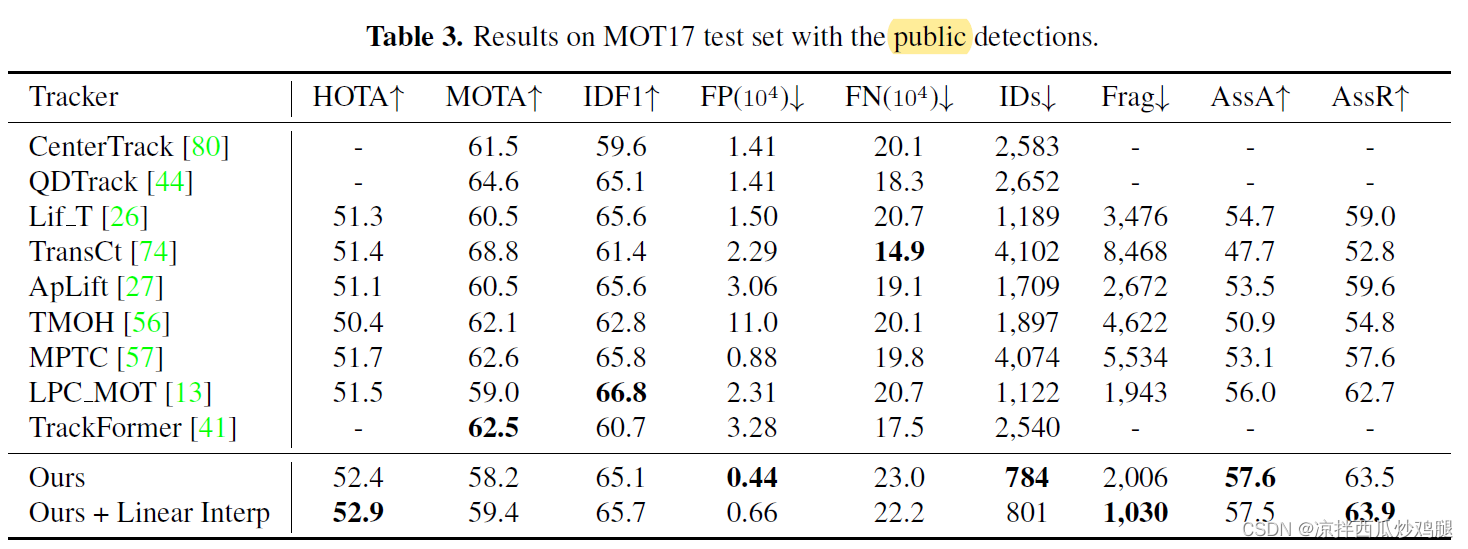

- MOT17,公共检测

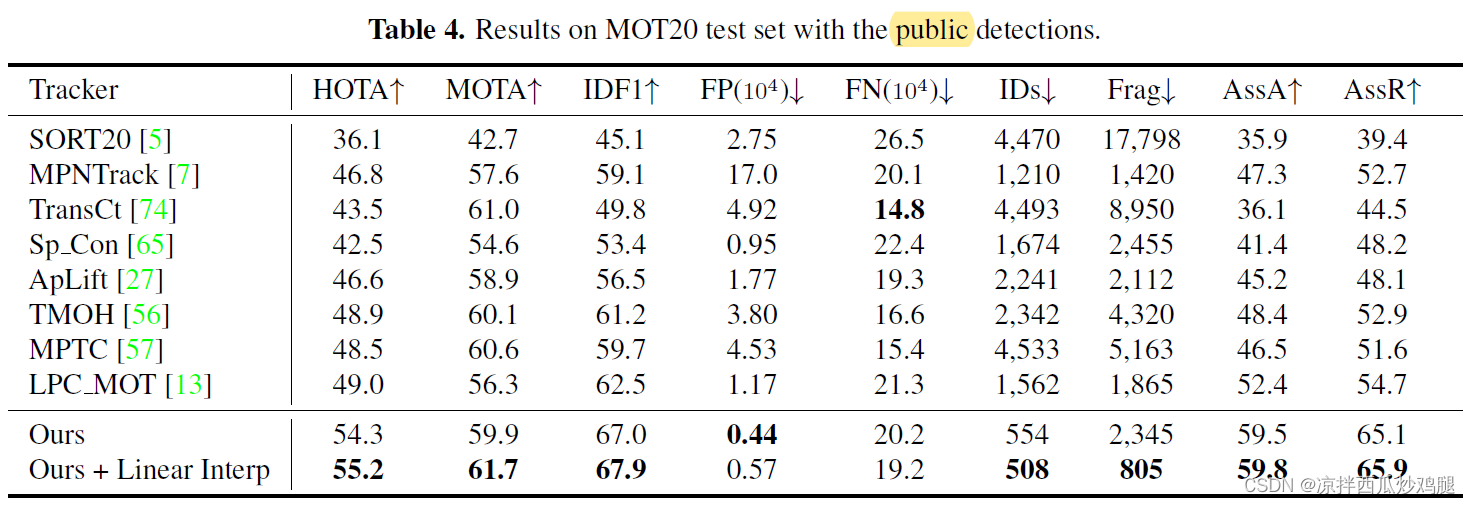

- MOT20,公共检测

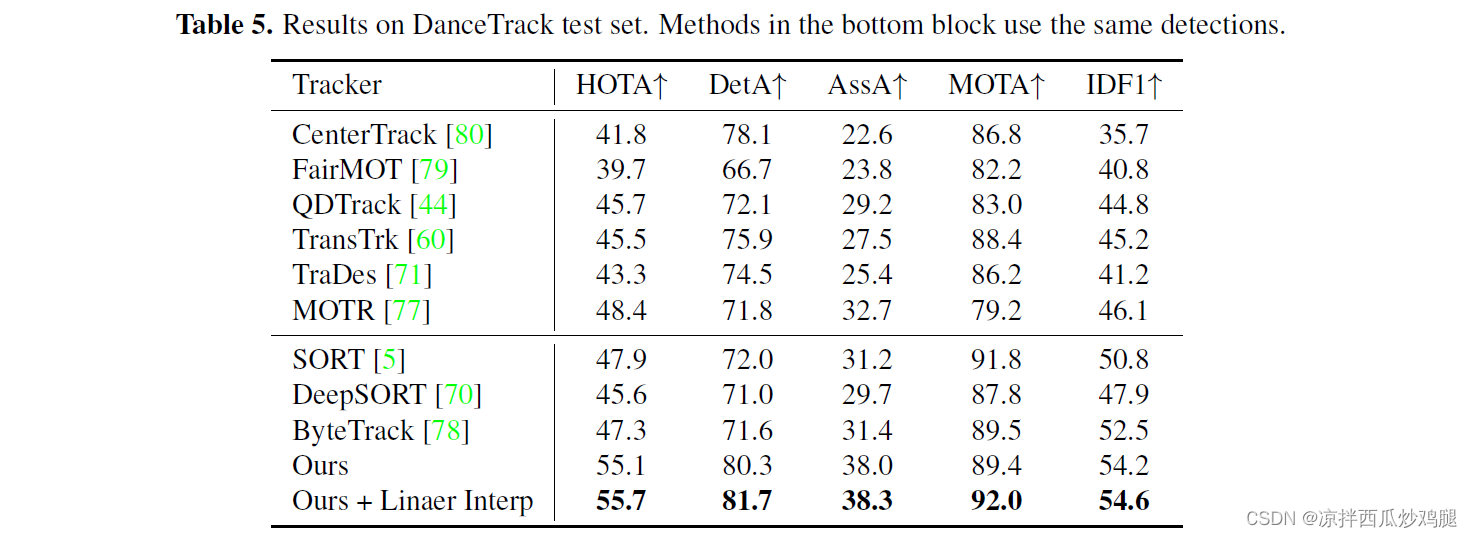

- DanceTrack测试集

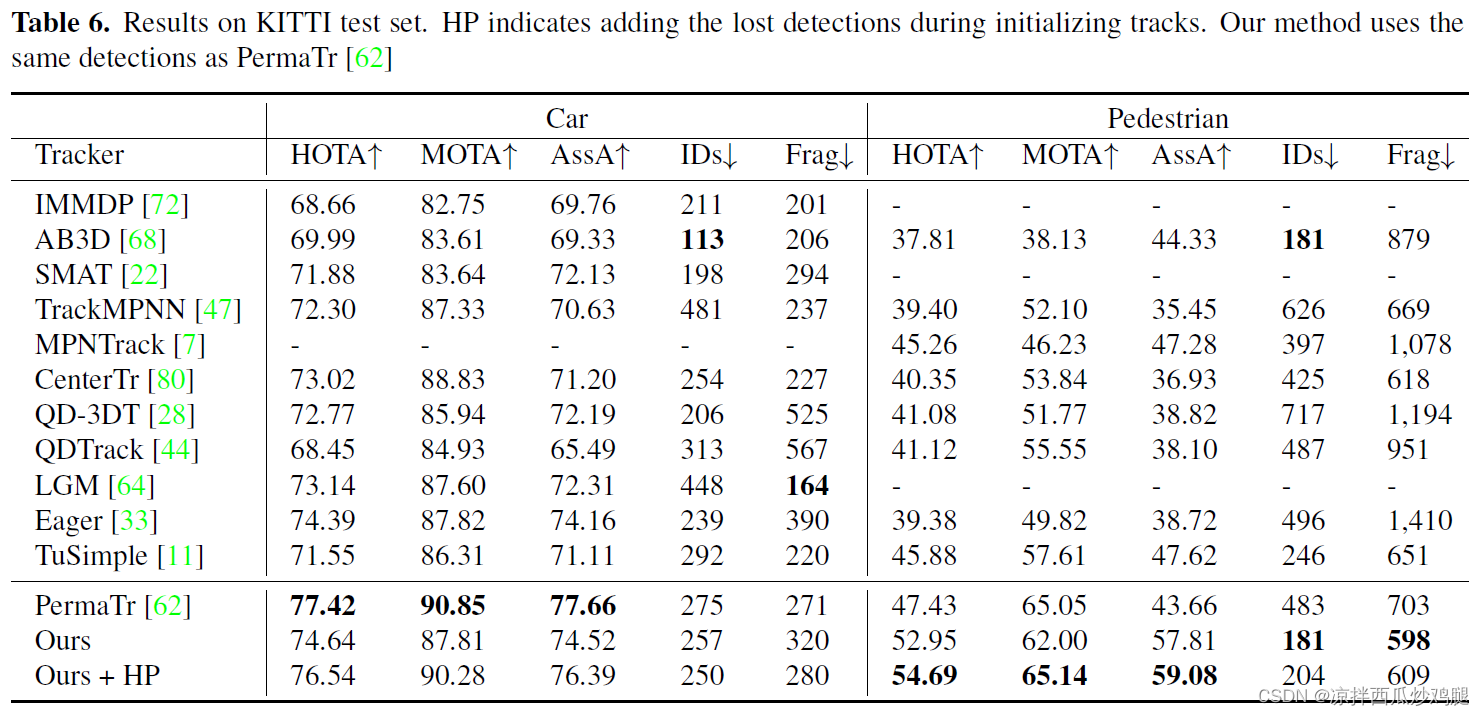

- KITTI测试集

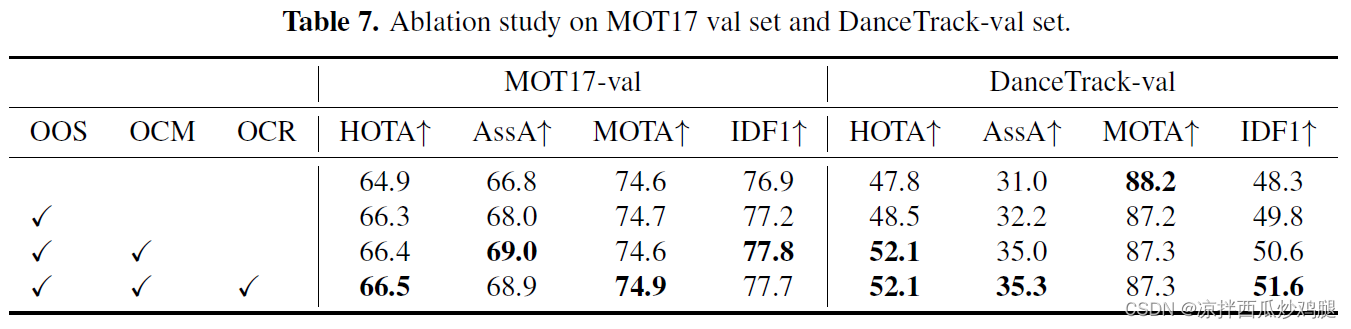

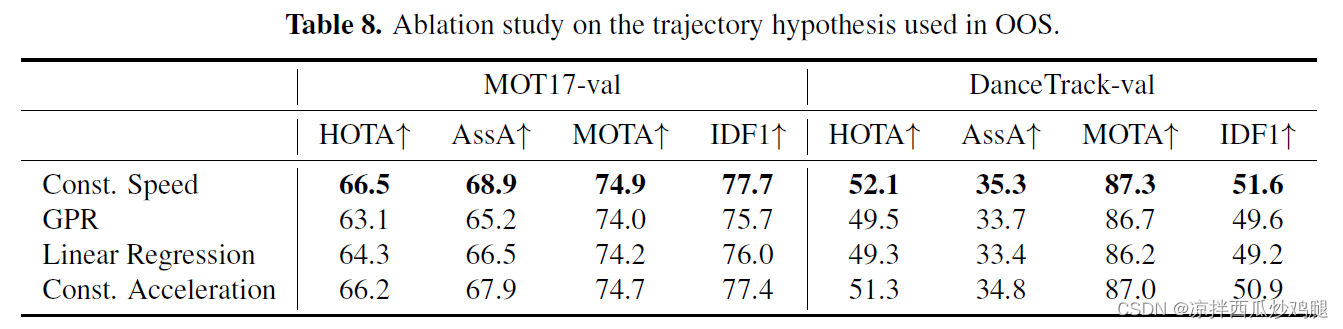

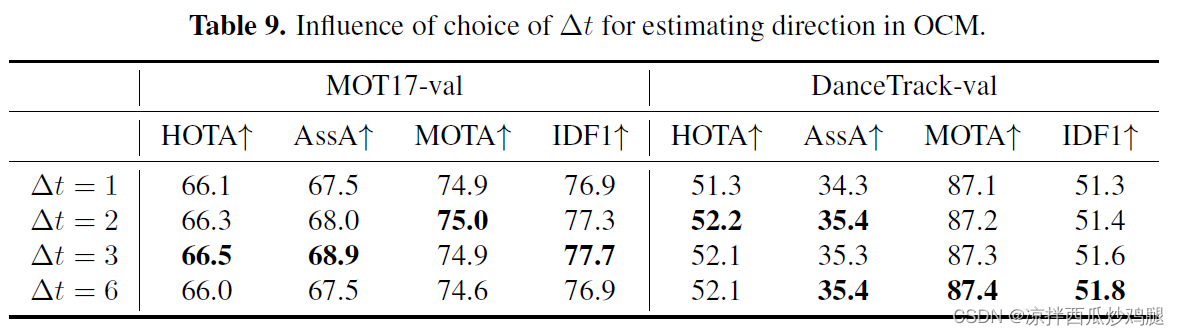

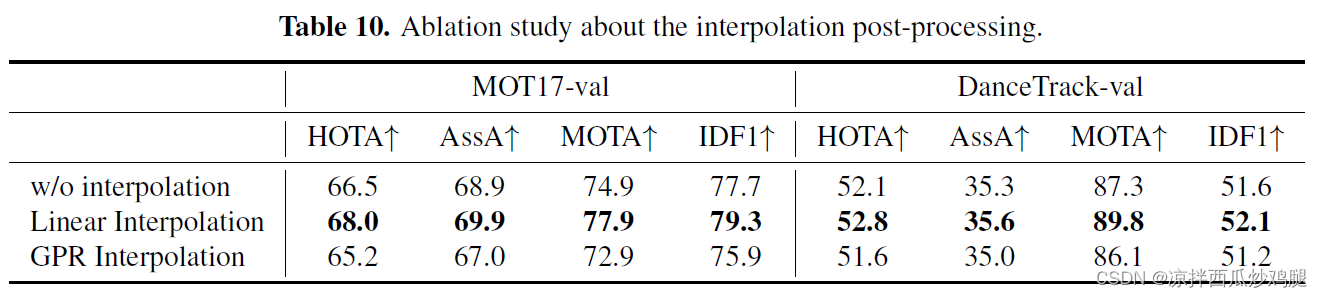

5.3 Ablation Study

- OOS、OCM、OCR组件消融实验

- OOS虚拟轨迹假设类型消融实验

- OCM中

Δ

t

\Delta t

Δt取值消融实验

- 后处理插值方法消融实验

6 Conclusion

分析了SORT的不足之处,提出了基于观测结果的OC-SORT,在非线性运动以及遮挡情况下取得了较好的效果。

391

391

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?