编辑 | 计算机视觉life

点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

本文只做学术分享,如有侵权,联系删文

论文信息

题目:InstantSplat: Sparse-view SfM-free Gaussian Splatting in Seconds

作者:Zhiwen Fan, Wenyan Cong, Kairun Wen, Kevin Wang, Jian Zhang, Xinghao Ding, Danfei Xu, Boris Ivanovic, Marco Pavone, Georgios Pavlakos, Zhangyang Wang, Yue Wang

机构:德克萨斯大学奥斯汀分校、英伟达研究院、厦门大学、佐治亚理工学院、斯坦福大学和南加州大学

原文链接:https://arxiv.org/html/2403.20309v2

源码链接:https://instantsplat.github.io/

内容速览

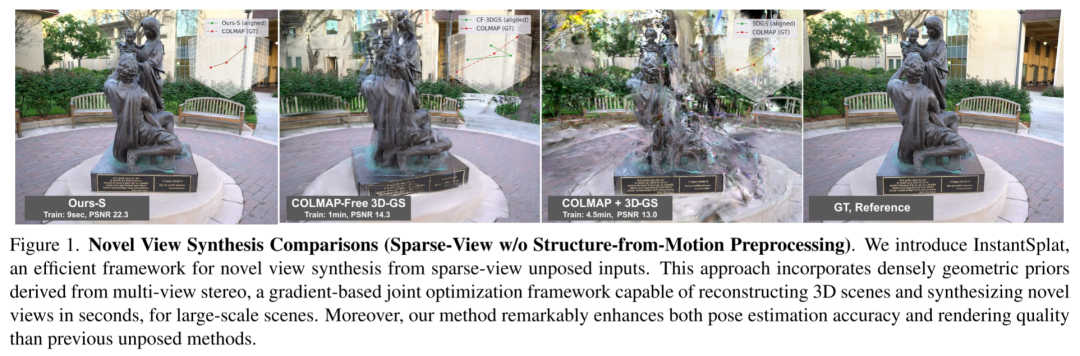

作者介绍了InstantSplat,它提供了一个高效且可靠的框架,用于处理稀疏视图数据。

作者研究了3D-GS的局限性,针对SfM预处理和复杂的ADC的关键问题,InstantSplat将显式的3D-GS与基于学习的MVS的几何先验相结合。

作者的实验在包括MVImgNet、Tanks and Temples、MipNeRF360以及野外互联网数据的多个数据集上进行,实验结果表明作者的方法不仅将优化时间从NoPe-NeRF的33分钟减少到作者的S版本仅需10.4秒,而且在结构相似性指数(SSIM)上实现了62%的改进,并在姿态度量上取得了显著提升。

摘要

在3D计算机视觉领域,从稀疏图像集合中进行新视角合成(NVS)技术已取得显著进展,但其依赖于使用结构从运动(SfM)进行精确的相机参数初始估计。例如,最近开发的高斯溅射技术严重依赖于SfM派生点和姿态的准确性。然而,SfM过程既耗时又经常在稀疏视图场景中不可靠,其中匹配特征稀缺,导致累积误差和跨数据集的有限泛化能力。在本研究中,作者引入了一个新颖高效的框架,以增强从稀疏视图图像的稳健NVS。作者的框架InstantSplat,集成了多视图立体(MVS)预测和基于点的表示,以在几秒内从稀疏视图数据构建大规模场景的3D高斯。

InstantSplat通过像素对齐生成所有训练视图中的密集表面点,并使用像素对齐确定初始相机参数。尽管MVS点不是全局准确的,并且所有视图的像素级预测导致高斯数量过多,从而产生了一个过度参数化的视图表示,这既影响了训练速度又影响了准确性。为解决这一问题,作者采用了基于网格的、感知置信度的Farthest Point Sampling,以并行方式策略性地在代表性位置放置点原语。接下来,作者通过基于梯度的联合优化框架从自监督中提高姿态精度和调整场景参数。通过采用这种简化的框架,InstantSplat实现了训练时间的大幅减少——从数小时减少到仅仅几秒钟——并在各种视图数量的不同数据集中展示了稳健的性能。

1. 引言

新视角合成(Novel-view synthesis, NVS)一直是计算机视觉领域长期追求的目标。它涉及到在任意视点渲染在训练期间未见过的图像。然而,以“随意”的方式捕获场景,使用有限的观察视图(称为稀疏视图)和低成本传感器(如智能手机),则更具挑战性。因此,采用一种能直接从少量未校准图像重建3D场景的高效框架对于扩展3D内容创作、数字孪生构建、节能机器人和增强现实应用至关重要。

尽管最近的进步已经显示出在减少所需训练视图数量方面的显著进展,但稀疏视图合成(Sparse-view synthesis, SVS)中的一个重大挑战仍未解决:稀疏输入数据通常缺乏足够的重叠,阻碍了像COLMAP这样的结构从运动(Structure from Motion, SfM)流程估计准确的相机参数。先前在SVS领域的研究通常假设即使在稀疏视图场景中也能精确地获得相机姿态,这是通过利用密集视图进行预计算实现的,但这种假设很少有效。此外,SfM步骤中的累积误差可能传播到后续步骤,导致次优的重建和视图合成。另一系列研究探索了无姿态设置,如NeRFmm、Nope-NeRF和CF3DGS。它们也假设了密集的数据覆盖,通常来源于视频序列。这样的密集数据需要一个广泛的优化过程,通常需要数小时来优化单个3D场景。

最近,3D高斯溅射(3D Gaussian Splatting, 3D-GS)被引入作为一种表达性强且高效的场景表示技术,促进了高速和高保真的训练和渲染。该方法利用一组各向异性的3D高斯,这些高斯在COLMAP派生的点上初始化。优化过程由多视图光度损失驱动,并由自适应密度控制(Adaptive Density Control, ADC)补充,这是一种启发式规则,控制3D原语的创建或删除。然而,由于COLMAP创建的点的数量不同,ADC参数需要针对每个场景进行调整,并且显著影响3D-GS的性能。如表1所示,仅仅降低密集化阈值以促进产生更多的原语就显著提高了“自行车场景”的重建质量。因此,尽管3D-GS在视图合成性能上取得了最先进的成果,但由于视图稀疏性和对COLMAP的依赖,3D-GS仍然存在问题。

在本文中,作者介绍了InstantSplat,它提供了一个高效且可靠的框架,用于处理稀疏视图数据。作者研究了3D-GS的局限性,并确定了关键问题,包括上述的SfM预处理和复杂的ADC。为此,InstantSplat将显式的3D-GS与基于学习的MVS的几何先验相结合。首先,它利用DUSt3R生成一组密集覆盖和像素对齐的点,捕获足够的场景几何形状,用于3D-GS原语初始化。然而,这些过度参数化的原语阻碍了3D-GS优化的性能和速度。为解决这个问题,作者引入了一个并行网格划分策略,并采用最远点采样作为下采样器,仅保留置信度高的高斯。其次,作者通过基于梯度的联合优化框架同时优化高斯属性和相机参数,以同时细化场景表示和相机轨迹。这使作者能够纠正MVS步骤中的累积误差,并在不需要ADC的情况下生成精确的场景表示。作者的实验在包括MVImgNet、Tanks and Temples、MipNeRF360以及野外互联网数据的多个数据集上进行,表明作者的方法不仅将优化时间从NoPe-NeRF的33分钟减少到作者的S版本仅需10.4秒,而且在结构相似性指数(SSIM)上实现了62%的改进,并在姿态度量上取得了显著提升。

3. 方法

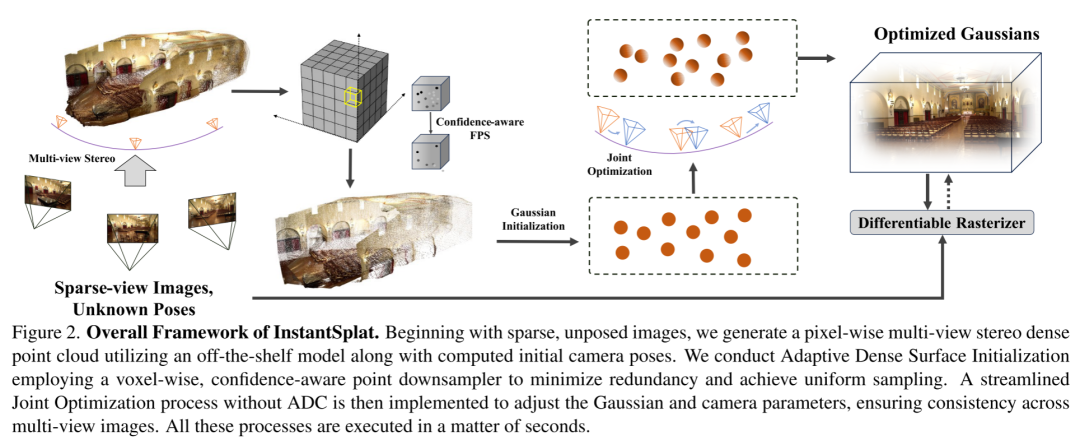

首先,作者讨论将多视图立体(MVS)与3D高斯溅射(3D-GS)整合到一起的总体流程,以解决依赖于结构从运动(SfM)的稀疏视图重建和训练效率问题(第3.1节)。接着,作者提出一个高效的、感知置信度的点下采样器,用以解决场景过度参数化问题(第3.2节)。作者同样展示一个基于梯度的联合优化框架,该框架依赖于光度损失以自监督的方式对齐高斯和相机参数(第3.3节)。InstantSplat的概览见图2。

3.1 多视图立体与高斯溅射的结合

3D高斯溅射(3D-GS)是一种显式的3D场景表示方法,它使用一组3D高斯来模拟场景。一个3D高斯由均值向量 和协方差矩阵 参数化:

为了表示与视图方向相关的属性,每个高斯附着有球谐系数,并通过对颜色 的计算来渲染,其中 是3D点到相机的距离, 是颜色值。颜色的计算通过球谐基函数 完成,并且颜色 通过以下方式渲染:

其中 是从第 个高斯的球谐系数计算出的颜色, 是通过学习到的每个高斯的不透明度参数乘以2D高斯得到的。2D协方差矩阵是通过将3D协方差矩阵投影到相机坐标系来计算的。3D协方差矩阵被分解为缩放矩阵和旋转矩阵。总结来说,3D-GS使用一组3D高斯 来表示场景,每个3D高斯 的特征由位置 ,一系列球谐系数 ,不透明度 ,旋转 和缩放 确定。

尽管3D-GS在渲染上是高效的,但基于点的3D-GS面临着由于COLMAP的稀疏SfM点或随机初始化的高斯带来的优化问题。SfM在匹配特征稀缺时通常失败,特别是在处理稀疏视图数据时。此外,从COLMAP到GS优化的顺序处理流程缺乏一个纠错机制来解决累积误差,这就需要在GS中仔细选择超参数。例如,自适应密度控制(Adaptive Density Control, ADC)需要一个复杂的策略来确定何时、何地以及如何生成新的高斯,作者在表1中展示了一个例子。

为了解决与自适应密度控制(ADC)相关的敏感性问题,作者寻求一种能够缓解ADC敏感性问题的密集立体点云。然而,传统的立体匹配流程效率较低,并且比SfM过程需要更多的时间。幸运的是,基于深度学习的密集立体框架的发展已经将预测与比例相关的深度图的时间缩短到毫秒级,尽管它们仍然假设已知的相机参数。最近,DUSt3R仅接受两张图像作为输入,并直接生成每个像素的点图和置信度图作为输出。然后可以利用非常高效的后处理优化来解决每视图像素到3D映射和增量相对姿态的问题。具体来说,DUSt3R的训练目标是基于两个输入视图的未投影和归一化的点图的回归:

其中视图 , 和 分别是预测值和真实值。为了处理预测值和真实值之间的比例模糊性,DUSt3R通过比例因子 和 归一化预测和真实点图,这些因子简单地表示所有有效点到原点的平均距离,记为 。然后,像素级的置信度 被定义并优化为:

其中 是一个超参数,控制正则化项,鼓励网络在更困难的区域进行外推。

恢复相机参数

作者从像素格到点图的1:1映射中获得,作者可以建立从2D到相机坐标系的映射。作者首先基于Weiszfeld算法解决一个简单的优化问题,以计算每台相机的焦距:

其中 和 表示中心化的像素索引。假设与COLMAP用于单场景捕获的单相机设置类似,作者提出通过所有训练视图的平均值来稳定估计的焦距: 。结果 表示在后续流程中使用的计算出的焦距。相对变换 可以通过RANSAC使用PnP对每对图像进行计算。

对全局对齐的姿态进行配对

DUSt3R最初以图像对为输入,如果从场景捕获超过两个视图,则需要后处理来对齐比例。根本原因是预测的点图在其自己的标准化尺度内,并且每个独立计算的相对姿态的不对齐导致显著的尺度变化,从而产生不准确的相机姿态。与DUSt3R类似,作者首先为所有N个输入视图构建一个完整的连通图 ,其中顶点 和每条边 表示图像 和 之间的共享视觉内容。为了将最初预测的点图 转换为全局对齐的点图 ,作者更新点图、变换矩阵和比例因子:对于完整的图,任何图像对 ,点图 和置信度图 。为了清晰起见,让作者定义 和 , 和 。边的变换矩阵 的优化、比例因子 和点图 由下式给出:

这里,作者稍微滥用了符号,如果 ,则使用 表示 。对于给定的对 ,相同的刚性变换 应该对齐两个点图 和 与世界坐标点图 和 ,因为根据定义 和 都是在相同的坐标框架中表达的。为了避免平凡最优解 ,DUSt3R强制执行 。这个后处理步骤在几秒钟内得到了全局对齐的点云,其中每视图的点和置信度图可以实时在现代GPU上推断出来。

对齐点云后,作者开始整合过程,通过将每个点作为原语初始化3D高斯。然而,由于像素级预测,密集的立体点云高度过度参数化,伴随着次优的姿态估计。如表4的第一行所示,作者观察到从像素级点图初始化的相机姿态与COLMAP处理所有密集序列时产生的姿态有显著差异。这表明简单的整合会产生次优结果。

3.2 自适应密集表面点初始化

作者的目标是从像素级预测开始减少点的冗余。具体来说,作者提出利用前一步骤中得到的初始场景尺度和置信度图 来执行自适应点云下采样。这种方法旨在实现准确、均匀且简洁的初始化。然而,简单的全局或基于网格的基于置信度的下采样可能导致场景块的丢失(见图3),这激发了作者设计更自适应的采样策略。

自适应体素网格划分

给定 个点,作者动态地将空间划分为 个自适应网格。每个网格,或体素 ,是根据每个维度( )的场景范围被划分为 个相等的段来定义的,从而产生自适应网格边界。每个点 根据其坐标落在体素边界内被分配到一个体素:

感知置信度的点云下采样

在每个体素 内,对一组点 进行下采样。作者提出一个高效的点下采样器,确保在保持高质量表面点的同时实现均匀性。与利用置信度得分或采用最远点采样(FPS)不同,作者在每个体素内使用FPS,并行执行计算。这种方法选择在采样过程中已选择点中最远的点,从而确保空间多样性。而不是仅依赖于点云中的点置信度来选择子集,观察到原始点云在训练图像重叠区域中存在偏差。这种偏差导致不均匀分布,仅基于置信度的采样可能导致空区域的出现。

作者首先在每个体素 中随机选择一个点 ,然后使用以下过程进行下采样:

对于 到 执行以下步骤:

其中 是体素中最终返回的点集, 表示欧几里得距离, 是体素 中的点数。这一步确保了每个网格内的均匀性和点云的准确性,有效提高了后续处理的数据质量。

3.3 联合优化对齐

作者基于采样的点云初始化高斯,采用3D-GS中描述的启发式规则。为了缓解由噪声点云和不准确相机姿态引起的问题,作者引入了一个自校正机制。这个机制通过使用光度损失,适用于相机和高斯参数的梯度优化。

自我监督下的梯度优化

给定多个视图和一个由一组高斯 表示的粗糙3D模型,以及初始相机姿态 ,作者探索使用梯度下降来最小化真实像素和模型渲染之间的残差。具体来说,作者对所有高斯参数和相机参数进行联合优化。这种调整允许 在目标视图位置 处减少光度误差。公式如下:

在测试视图上对齐相机姿态

与常规方法不同,在常规方法中测试视图的精确相机姿态通常是已知的,并且在与训练视图相同的坐标系统中估计(如3D-GS和NeRF中所见),作者的场景涉及具有未知或嘈杂姿态的测试视图。类似于基于NeRF的工作,作者保持在训练视图上训练的GS模型,在冻结状态下,同时优化测试视图的相机姿态。这个优化过程专注于最小化合成图像与实际测试视图之间的光度差异,目的是实现更精确的对齐以进行评估。这个过程对每张图片执行500次迭代。

4. 实验

4.1 实验设置

数据集

实验遵循先前无姿态方法的实验设置,作者使用了“坦克和庙宇”数据集中的所有八个场景,并使用不同数量的视图。此外,作者还从MVImgNet数据集中提取了七个户外场景,包括轿车、SUV、自行车、椅子、梯子、长凳和桌子等多样化的场景类型。作者还首次尝试在MipNeRF360数据集上进行评估,并使用12个训练视图。作者也在野外数据上测试了InstantSplat,包括从Sora视频中提取的帧、使用NASA网站上的Perseverance漫游者的导航立体相机数据,以及从DL3DV10K数据集中随机抽取的三个训练视图。作者将发布代码和数据。

训练/测试数据集划分

作者从每个数据集中均匀采样24幅图像,用于训练和评估,以覆盖整个数据集。测试图像(12幅,不包括首尾图像)对于所有设置都是均匀选择的,而N个训练图像是从剩余的12幅图像中均匀选择的,用于稀疏视图训练。具体来说,作者从MVImgNet和坦克与庙宇数据集中均匀采样了24幅图像,而MipNeRF360数据集的采样是从前48帧中进行的,因为它是从不同高度捕获的完整360度旋转。作者变化稀疏视图的数量N从3到12,以评估所有采用的算法。

度量标准

作者在基准数据集上评估了两项任务:新视角合成和相机姿态估计。对于新视角合成,作者使用了包括峰值信噪比(PSNR)、结构相似性指数(SSIM)和学习感知图像块相似性(LPIPS)在内的标准评估指标。作者报告了相机旋转和平移误差,重点关注绝对轨迹误差(ATE)和相对姿态误差(RPE)。

基线比较

在无姿态方法上,作者的比较包括Nope-NeRF和CF-3DGS,它们都支持单目深度图和真实相机内参。作者还考虑了NeRFmm,它涉及NeRF和所有相机参数的联合优化。此外,作者将作者的方法与使用COLMAP进行预先计算相机参数的3D-GS和FSGS进行了比较。

实现细节

作者的实现利用了PyTorch框架。对于作者的“粗到细”(Ours-S)方法,优化迭代设置为200次,而对于作者的“特大”(Ours-XL)方法,迭代次数为1000次,以实现质量和训练效率的平衡。作者使用DUSt3R以512的分辨率预测多视图立体深度图。为了公平比较,作者在一块Nvidia A100 GPU上进行实验。

4.2 实验结果

在“坦克和庙宇”数据集上,作者对新视角合成和姿态估计任务进行了定量和定性评估。评估结果总结在表2和图4中。Nope-NeRF利用多层感知器(MLPs)在渲染质量和姿态估计精度方面取得了有希望的结果。然而,它倾向于产生过度模糊的图像(见图4的第三列),这归因于其几何场的严格约束,并显示出对单个场景的长时间训练和推理时间(约3秒每帧)用于渲染一张图像。CF-3DGS采用高斯溅射,并集成了局部和全局优化阶段,具有自适应密度控制和不透明度重置策略,在新视点上渲染时容易出现伪影,这是由于复杂的优化过程加上错误的位姿估计所致,如图4所示。此外,Nope-NeRF和CF-3DGS都假设已知且准确的焦距。NeRFmm,旨在同时优化相机参数和辐射场,由于简单的联合优化固有挑战,倾向于产生次优结果。位姿指标揭示了由于稀疏观测和估计不准确的位姿而产生的伪影,如表2所示。这个问题对于依赖于类似于SLAM的密集视频序列的CF-3DGS和Nope-NeRF特别有害,因此在将密集视频帧采样为稀疏多视图图像时遇到困难。相反,作者的方法以MVS场景结构初始化,并采用基于梯度的联合优化过程,提供了增强的鲁棒性和更优越的性能。在MVImgnet数据集上使用三个训练图像进行的额外实验,以及在MipNeRF360数据集上使用12个训练视图的实验,展示在表3中。值得注意的是,InstantSplat在所有评估的数据集和视觉指标中一致优于所有基线。作者的方法不仅将优化时间从33分钟(NoPe-NeRF)减少到仅10.4秒(Ours-S),而且在结构相似性指数(SSIM)上提高了62%,在位姿指标上也有显著提升。

4.3 消融分析

为了验证作者的设计方案,作者进行了消融实验,从使用不可微分的结构从运动(SfM)辅以具有自适应密度控制的高斯溅射,转变到采用多视图立体(MVS)结合自适应表面点下采样和联合优化,以实现高效和稳健的稀疏视图3D建模。实验在教堂场景上进行,使用来自400个密集视图的COLMAP位姿作为真值,除非另有说明。

问题1: 多视图立体预测的准确性如何?

问题2: 焦距平均的效果如何?

问题3: 自适应密集表面初始化在减少冗余的同时是否保持了重建精度?

问题4: 联合优化对于实现准确渲染是否必要?

问题5: 使用稀疏视图图像的InstantSplat是否能够达到之前使用密集视图配置的方法的渲染质量?

作者评估了从MVS点云图派生的相机位姿的准确性,如第3.1节所详述。正如表4的第一行和第四行所示,MVS初始化的场景几何有相当大的提升空间。

从所有图像聚合焦距为优化3D表示提供了稳定的基础,如表4的第二行所示,视图合成质量得到了显著提升。

采用自适应密集表面初始化,使用并行基于网格的最远点采样(FPS),考虑到置信水平,能够有效降低冗余同时保持精度(参见表4的第三行)。作者实验中选择了643个网格。

联合优化,使用粗糙的3D模型和光度误差,可以进一步增强渲染和姿态精度。

使用12个训练图像的InstantSplat评估显示,使用学习感知图像块相似性(LPIPS)的渲染质量非常接近人类感知。然而,使用绝对轨迹误差(ATE)测量的姿态估计精度仍有差异。

5. 结论

作者介绍了InstantSplat,这是一个旨在在几秒钟内从稀疏视图、无姿态的图像重建场景的框架。作者的方法利用多视图立体(MVS)的能力进行粗糙的场景初始化,并提出了一种基于梯度的自监督联合优化机制,用于高斯属性和相机参数的优化。与之前表现最佳的无姿态方法相比,作者已经将所需的视图数量从数百个减少到仅有几个,从而仅使用最少的图像和无姿态视图实现了大规模3D建模。

然而,InstantSplat受限于MVS对全局对齐点云的需求,在处理超过数百个图像的场景时存在限制。通过渐进式对齐来解决这一局限性将是作者未来工作的一部分。

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

② 国内首个自动驾驶学习社区

国内最大最专业,近3000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型、端到端等,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

112

112

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?