点击下方卡片,关注“具身智能之心”公众号

本期具身智能之心继续整理了具身智能实验室汇总,包括国内、北美、欧洲部分高校的实验室,排名不分先后!!如有遗漏欢迎评论区留言。香港、新加坡汇总请见下期推送~

更多具身智能内容,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球,这里有多有你想要的。

1 国内

清华大学智能技术与系统实验室

主页:https://www.cs.tsinghua.edu.cn/szzk/jzgml/znjsyxtsys.htm

导师:刘华平、陈挺、冯元等人

研究成果:

论文:

DGPO: Discovering Multiple Strategies with Diversity-Guided Policy Optimization , https://arxiv.org/abs/2207.05631

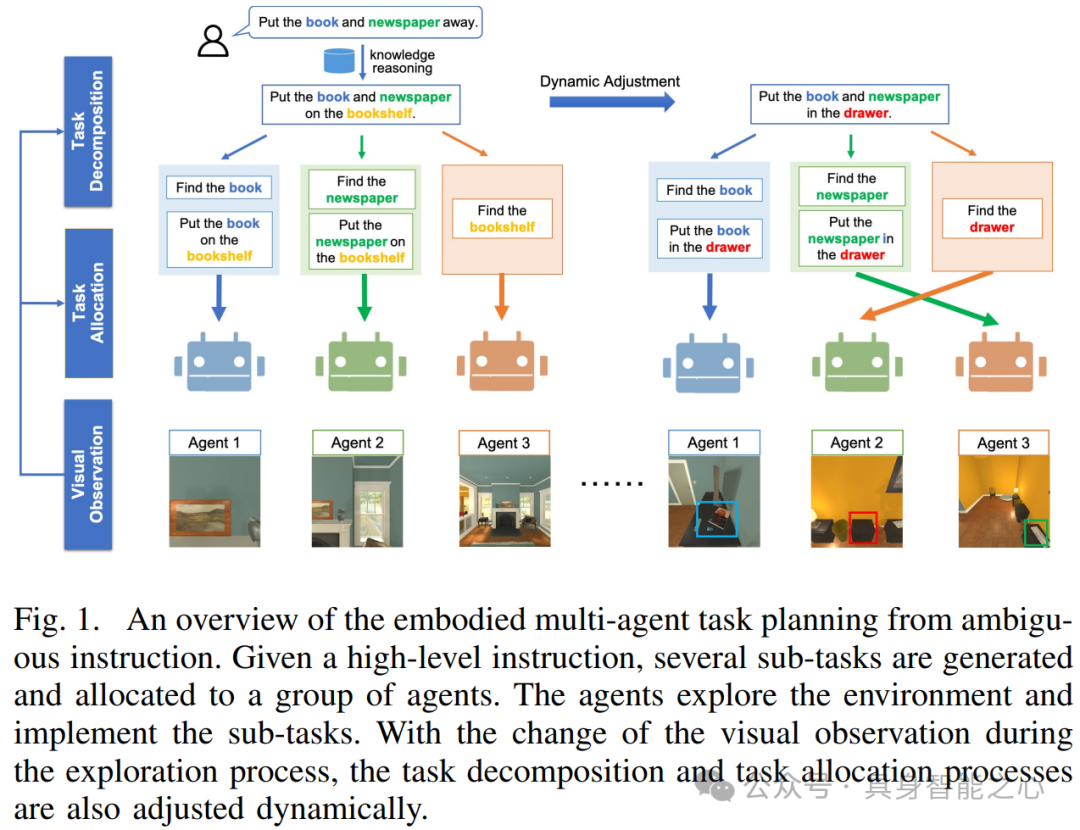

Embodied multi-agent task planning from ambiguous instruction, in: Proc. of Robotics: Science and Systems (RSS), 2022

Continual learning with recursive gradient optimization, in: Prof. of International Conference on Learning Representation (ICLR), 2022

ReThinkLab-上海交通大学严骏驰老师实验室

主页:https://thinklab.sjtu.edu.cn/

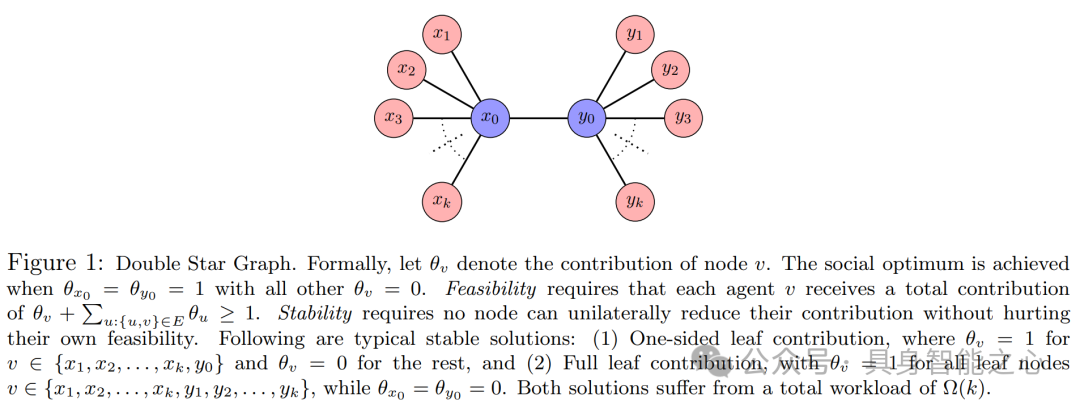

上海交通大学交ReThinkLab的愿景是开发用于解决现实世界问题的前沿技术,从而可以充分探索和应用数据驱动方法与领域知识相结合的方式。特别是近年来的研究集中在组合优化、偏微分方程、量子计算和人工智能科学(AI4Science)领域。

研究方向:

自动驾驶与机器人(环境感知与定位、决策与规划、机器人操作与控制)、图与组合优化的机器学习(组合优化问题求解、算法设计与分析、应用研究)、面向科学、工程和艺术的学习(电子设计自动化、密码学、药物研发、偏微分方程、神经科学、艺术领域)、量子机器学习(量子电路合成与编译优化、量子图表示学习、量子组合优化)、图学习(动态图学习、图神经网络的泛化性和鲁棒性、图表示学习方法)、离散时间空间(时间序列分析、多变量时间序列分析、音频源分离)、连续时间空间(时间点过程建模、顺序推荐、事件序列分析)、视觉(旋转)目标检测(旋转目标检测算法、目标检测的泛化性和鲁棒性、3D目标检测)等。

研究成果:

论文:

Q. Li, X. Jia, S. Wang, Junchi Yan (correspondence). Think2Drive: Efficient Reinforcement Learning by Thinking in Latent World Model for Quasi-Realistic Autonomous Driving (in CARLA-v2). European Conference on Computer Vision (ECCV), 2024. https://arxiv.org/pdf/2402.16720

Z. Zhao, F. Fan, W. Liao, Junchi Yan.

Grounding and Enhancing Grid-based Models for Neural Fields. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2024 Best Paper CandidateY. Li, J. Guo (本科生), R. Wang, H. Zha, Junchi Yan (correspondence)

OptCM: The Optimization Consistency Models for Solving Combinatorial Problems in Few Shots , Neural Information Processing Systems (NeurIPS), 2024

西湖机器人科技、西湖大学机器智能实验室(Machine Intelligence Laboratory, MiLAB)

西湖机器人主页:https://www.westlake.edu.cn/Innovation/StartupsPortfolio/IntelligentManufacturing/WestlakeRobotics/

MiLAB主页:https://milab.westlake.edu.cn/

西湖机器人科技(杭州)有限公司是由王东林博士团队创办的新一代智能机器人科技公司。基于深度学习和机器人学理论基础,研发具有通用行为智能的足式机器人。

公司在西湖大学机器智能实验室(MiLAB)理论研究基础上,高度融合深度强化学习、深度元学习和机器人学,研发下一代具有通用行为智能的足式机器人,可广泛应用于1)教育科研行业、2)电力建筑畜牧等垂直行业、3)商场机场家用等服务行业。

研究成果:

论文:

PiTe: Pixel-Temporal Alignment for Large Video-Language Model, https://arxiv.org/abs/2409.07239

Latent Diffusion Prior Enhanced Deep Unfolding for Snapshot Spectral Compressive Imaging , https://github.com/Zongliang-Wu/LADE-DUN

PathMMU: A Massive Multimodal Expert-Level Benchmark for Understanding and Reasoning in Pathology , https://arxiv.org/pdf/2401.16355

2 北美、欧洲

Stanford AI Lab (SAIL)

主页:https://ai.stanford.edu/

斯坦福人工智能实验室(SAIL)的研究领域涵盖生物医学与健康、计算认知与神经科学、计算教育、计算机视觉、经验机器学习、以人为本和创造性人工智能、自然语言处理和语音、强化学习、机器人技术以及统计或理论机器学习等人工智能的各个领域。

联合教师实验室及团队:(详见 https://ai.stanford.edu/research-groups/)

斯坦福自然语言处理(NLP)组:成员包括 Chris Manning、Dan Jurafsky、Percy Liang 等。

斯坦福视觉与学习实验室(SVL):由李飞飞、Juan Carlos Niebles、Silvio Savarese、Jiajun Wu 组成。

斯坦福统计机器学习(statsml)组:有 Emma Brunskill、John Duchi、Stefano Ermon 等成员。

研究成果:

论文:

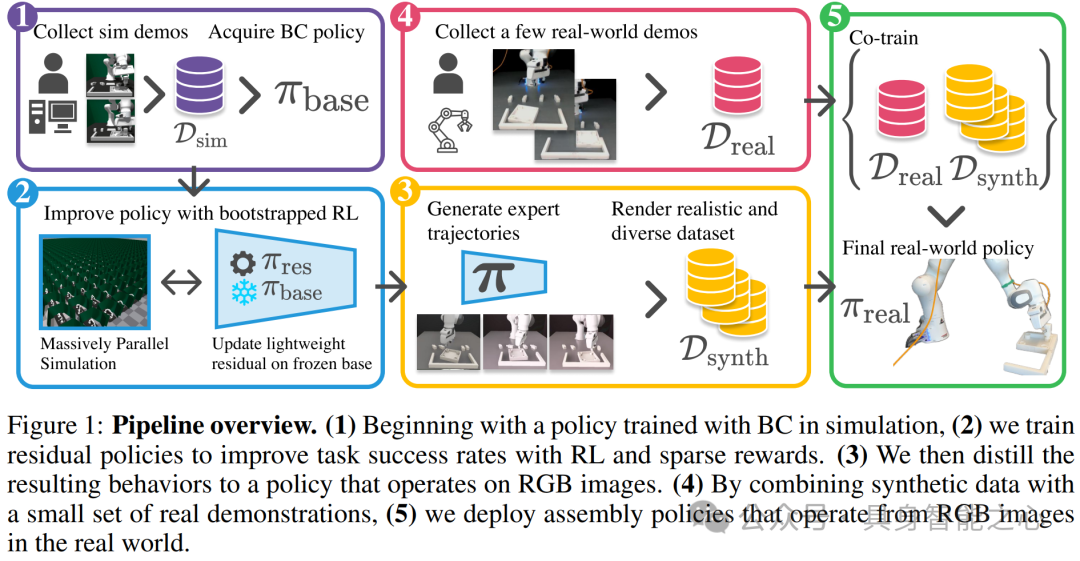

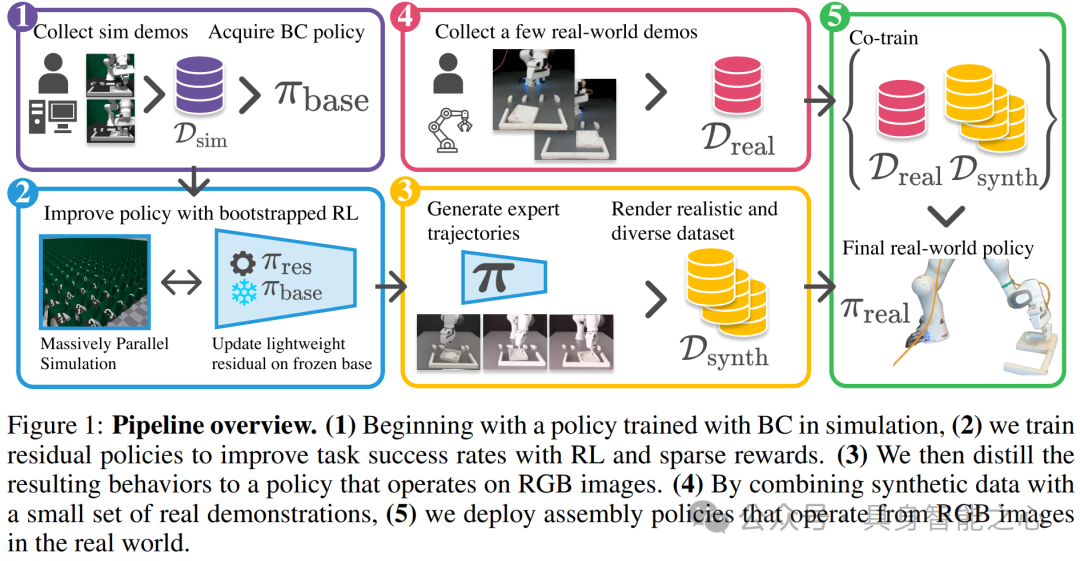

TRANSIC: Sim-to-Real Policy Transfer by Learning from Online Correction, CoRL 2024, Yunfan Jiang, Chen Wang, Ruohan Zhang, Jiajun Wu, Li Fei-Fei, https://arxiv.org/abs/2405.10315

D3Fields: Dynamic 3D Descriptor Fields for Zero-Shot Generalizable Rearrangement, CoRL 2024 (Oral), Yixuan Wang*, Mingtong Zhang*, Zhuoran Li*, Tarik Kelestemur, Katherine Rose Driggs-Campbell, Jiajun Wu, Li Fei-Fei, Yunzhu Li, https://robopil.github.io/d3fields/d3fields.pdf

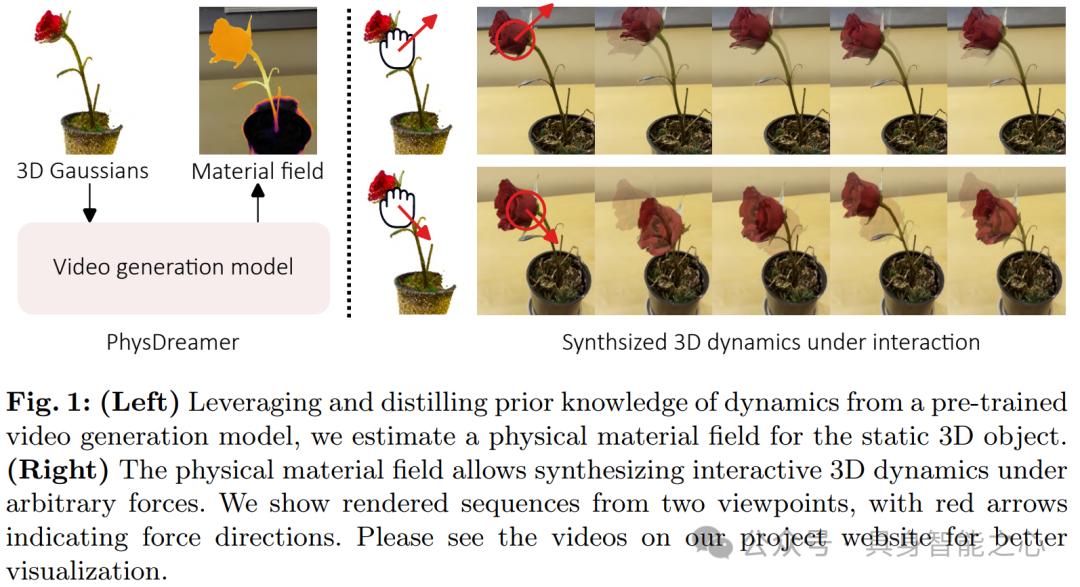

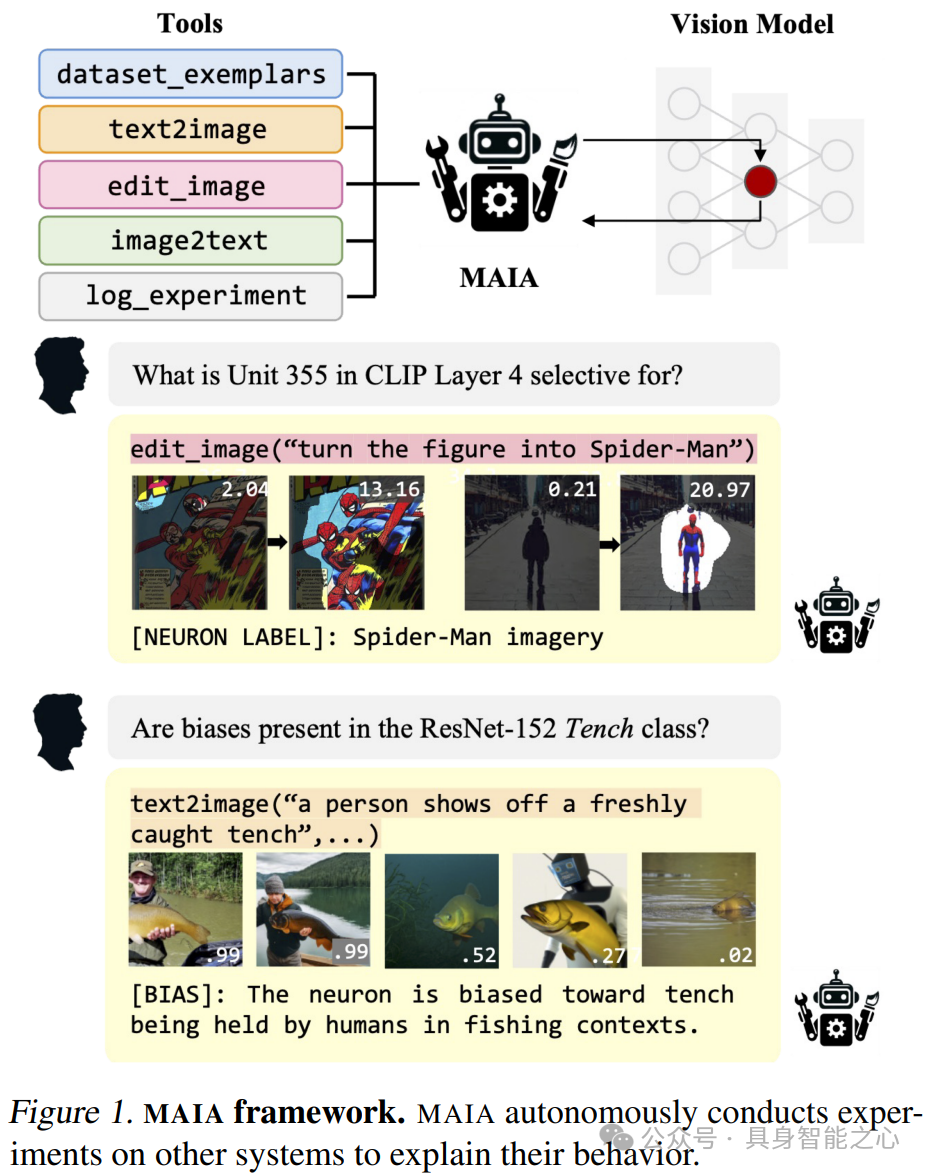

PhysDreamer: Physics-Based Interaction with 3D Objects via Video Generation, ECCV 2024 (Oral), Tianyuan Zhang, Hong-Xing Yu, Rundi Wu, Brandon Y. Feng, Changxi Zheng, Noah Snavely, Jiajun Wu, William T. Freeman, https://arxiv.org/abs/2404.13026

CSAIL Embodied Intelligence Labs - MIT

主页:https://ei.csail.mit.edu/labs.html

简介:实验室的目标是通过对人类智能的研究以及智能机器人的设计和实现,来理解物理世界中智能行为的本质。我们在感知、传感、语言、学习和规划方面拥有专业知识,目标是整合这些学科,以打造具有类人智能的物理实体。实验室下分许多子实验室,包括算法对齐组、协作学习和自主研究实验室(CLEAR实验室)、计算认知科学实验室、计算设计与制造组(CDFG)等多个研究方向的实验室。

导师:Ted Adelson, Pulkit Agrawal, Jacob Andreas, Sara Beery, Andreea Bobu, Wojciech Matusik等人

研究成果:

【图片:CSAIL-1.gif】 图注:CSAIL下CLEAR实验室成果,强化学习从人类反馈中学习 (RLHF),探索从有噪声、不完整或不一致的数据中有效学习人类目标,使得自主系统能够更好地理解和预测人类需求。

图注:CSAIL下CLEAR实验室成果,强化学习从人类反馈中学习 (RLHF),探索从有噪声、不完整或不一致的数据中有效学习人类目标,使得自主系统能够更好地理解和预测人类需求。

论文:

Adaptive Language-Guided Abstraction from Contrastive Explanations, https://arxiv.org/abs/2409.08212

Towards real-time photorealistic 3D holography with deep neural networks, https://www.nature.com/articles/s41586-020-03152-0

Aligning Human and Robot Representations, https://dl.acm.org/doi/abs/10.1145/3610977.3634987

Training Neural Networks from Scratch with Parallel Low-Rank Adapters, https://arxiv.org/abs/2402.16828

Quest for Intelligence (MIT)

主页:https://quest.mit.edu/about/vision-statement

简介:麻省理工学院的智能探索计划旨在理解智能 —— 大脑如何产生智能以及如何在人工系统中复制智能。为了实现这一愿景,必须发展关于自然智能的科学理论,必须创建计算模型,并且这些模型必须与自然智能的能力和神经机制进行比较,并在现实世界的问题上进行测试。智能探索计划的方法不仅需要跨越边界,还需要真正实现跨学科的整合。

导师:Pulkit Agrawal、Cynthia Breazeal、James DiCarlo等人

研究成果:

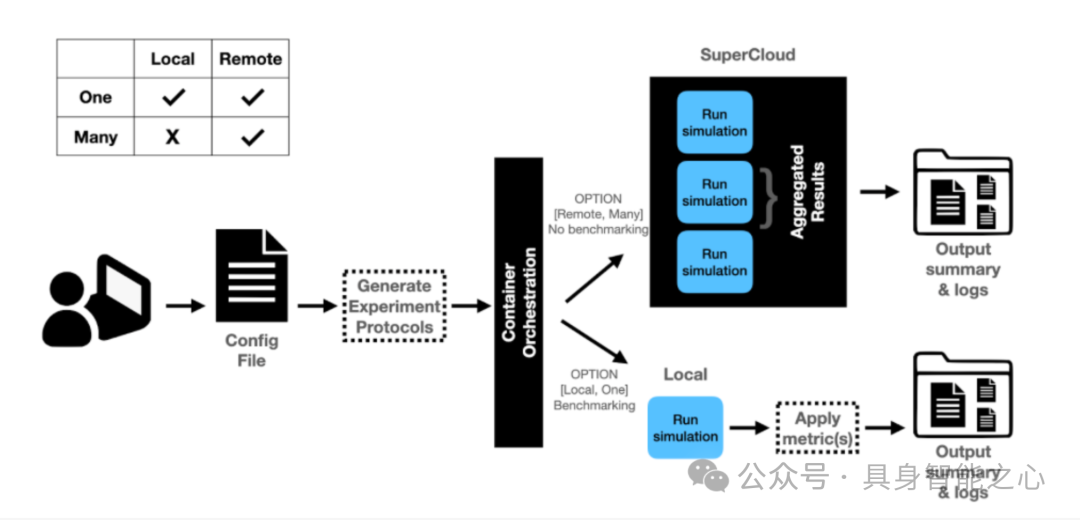

QREI 程序实验创建和基准测试基础设施。显示了两个配置选项:1) 并行远程执行多个实验,但不进行基准测试,以及 2) 本地执行单个实验,其中根据一个或多个基准测试评估结果。

代表性论文:

Towards Practical Multi-object Manipulation using Relational Reinforcement Learning, https://richardrl.github.io/relational-rl/

Adversarially trained neural representations may already be as robust as corresponding biological neural representations, https://proceedings.mlr.press/v162/guo22d/guo22d.pdf

Diagnosis, Feedback, Adaptation: A Human-in-the-Loop Framework for Test-Time Policy Adaptation, https://arxiv.org/pdf/2307.06333

Bio-Inspired Robotics Laboratory (BIRL) -剑桥

主页:https://birlab.org/

简介:生物启发实验室(BIRL)的研究着眼于如何从自然中汲取灵感来改进机器人技术,无论是学习智能,还是寻找改进机器人运动的方法。BIRL由布鲁塞尔自由大学(VUB)领导,成员包括剑桥大学工程系、巴黎市高等工业物理化学学院(ESPCI)、瑞士联邦材料科学与技术实验室(Empa)以及荷兰聚合物制造商 SupraPolix。团队的一项开发成果 ——“无椅之椅”,是一种可穿戴设备,允许用户锁定膝关节并在任何地方 “坐下”,无需椅子。

导师:Iida Fumiya, Egorova Veronica, Hosseini Narges Khadem等人

研究成果:

论文:

Ishida, M., Berio, F., Di Santo, V., Shubin, NH., Iida, F. (2024). Paleo-inspired robotics as an experimental approach to the history of life, Science Robotics, (accepted).

Fan, C., Chu, KF., Wang, X., Kwok, KW., Iida, F. (2024). State transition learning with limited data for safe control of switched nonlinear systems, Neural Networks, (accepted).

Xu, J., Anvo, NZR., Taha-Abdalgadir, H., d’Avigneau, AL., Palin, D., Wei, F., Hadjidemetriou, F., Iida, F., Al-Tabbaa, A., De Silva, L., Brilakis, I. (2024). Highway digital twin-enabled Autonomous Maintenance Plant (AMP): A perspective, Data-Centric Engineering, (accepted).

Almanzor, E., Sugiyama, T., Abdulali, A., Hayashibe, M., Iida, F., (2024). Utilising redundancy in musculoskeletal systems for adaptivestiffness and muscle failure compensation: A model-free inverse statics approach, Bioinspiration & Biomimetics 19: 046015.

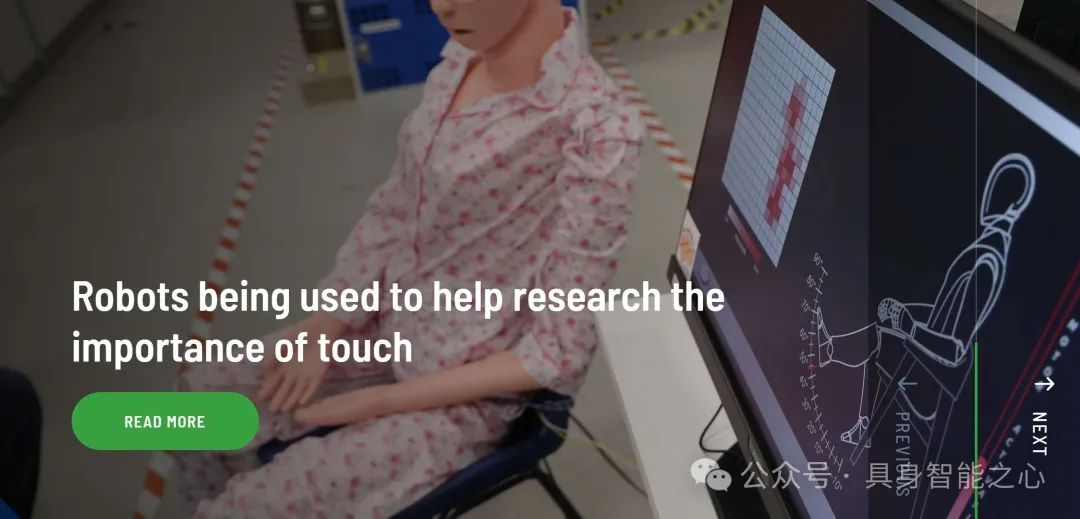

Affective Intelligence and Robotics Laboratory (AFAR)-剑桥

主页:https://cambridge-afar.github.io/#:~:text=I%20am%20a%20first%20year%20PhD%20student%20at%20the%20Computer

简介:AFAR 实验室的研究兴趣在于情感计算和社会信号处理领域,该领域处于包括计算机视觉、信号处理、机器学习、多模态交互和人机交互等多个学科的交叉点。AFAR 实验室的研究方向:(具身化的)人工情感智能、自主的,具有社会情感智能的系统和社交机器人、长期的,自适应的和个性化的交互(虚拟现实 / 人机交互和人机交互)

项目:用于幸福感的自适应机器人情感智能、用于情感计算和机器人技术的持续学习、儿童心理健康的机器人化评估、仿人服务机器人的情感智能、机器人心理健康教练的用户研究、用于幸福感的自适应机器人教练、用于面部动作单元、抑郁和个性分析的深度学习、情感计算的偏差分析和实现公平性、工作年龄。

导师:Hatice Gunes, Sinan Kalkan, Siyang Song等人

论文:

Learning Socially Appropriate Robo-waiter Behaviours through Real-time User Feedback, https://dl.acm.org/doi/10.5555/3523760.3523831

Domain-Incremental Continual Learning for Mitigating Bias in Facial Expression and Action Unit Recognition, https://ieeexplore.ieee.org/document/9792455

Latent Generative Replay for Resource-Efficient Continual Learning of Facial Expressions, https://www.repository.cam.ac.uk/items/ca5b5996-350c-4354-9f5c-941bcc16224b

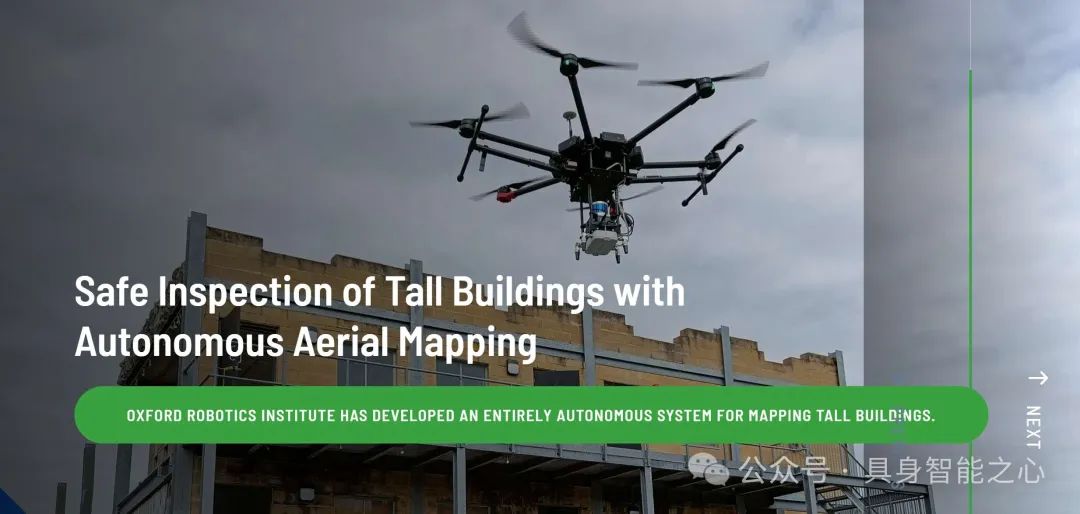

Oxford Robotics Institute

主页:https://ori.ox.ac.uk/

ORI 致力于拓展机器人的能力,为人类带来更多价值。该研究所的研究兴趣极为广泛,涵盖了从飞行到抓取、从检查到奔跑、从触觉到驾驶、从探索到规划等众多领域。在技术研究方面,ORI 涉及机器学习与人工智能、计算机视觉、制造、多光谱传感、感知、系统工程等多个前沿主题。

研究成果:

论文:

Textual explanations for automated commentary driving, https://ieeexplore.ieee.org/document/10186611

Motion planning in dynamic environments using context-aware human trajectory prediction, https://www.sciencedirect.com/science/article/pii/S0921889023000891?via%3Dihub

EDAMS: An Encoder-Decoder Architecture for Multi-grasp Soft Sensing Object Recognition, https://ieeexplore.ieee.org/document/10121962

Harvard Microrobotics Laboratory

主页:https://www.micro.seas.harvard.edu/#:~:text=SOFT%20ROBOTICS.%20The%20lab%20was%20founded%20within%20the%20Harvard%20John

该实验室由罗伯特・伍德教授在哈佛约翰・A・保尔森工程与应用科学学院内创立。它拥有设计、制造和评估具有独特尺寸、形状和材料成分的机器人所需的所有工具。该实验室采用高度实验性的方法来开发机器人,并且我们将这些机器人用作工具,以探索微力学、驱动、流体力学、控制和微电子学中的基本问题。

研究成果:

论文:

Marter, P., Khramova, M., Duvigneau, F., Wood, R.J., Juhre, D. and Orszulik, R., 2024. Bidirectional motion of a planar fabricated piezoelectric motor based on unimorph arms. Sensors and Actuators A: Physical, 377, p.115642. October 2024, https://doi.org/10.1016/j.sna.2024.115642

Burns, J.A., Daniels, J., Becker, K.P., Casagrande, D., Roberts, P., Orenstein, E., Vogt, D.M., Teoh, Z.E., Wood, R., Yin, A.H. and Genot, B., 2024. Transcriptome sequencing of seven deep marine invertebrates. Scientific Data, 11(1), p.679. June 2024, https://doi.org/10.1038/s41597-024-03533-4

Maalouf, A., Jadhav, N., Jatavallabhula, K.M., Chahine, M., Vogt, D.M., Wood, R.J., Torralba, A. and Rus, D., 2024. Follow Anything: Open-set detection, tracking, and following in real-time. IEEE Robotics and Automation Letters, 9(4), pp.3283-3290, April 2024, doi: 10.1109/LRA.2024.3366013.

Rajpurkar Lab

主页:https://www.rajpurkarlab.hms.harvard.edu/#:~:text=Our%20lab%20is%20dedicated%20to%20advancing%20medical%20artificial%20intelligence%20with

Rajpurkar Lab 是一个致力于推动医学人工智能发展的实验室。研究方向包括:

(1)基础模型:开发自适应医疗基础模型的自我监督和预训练技术,减少对大量数据标注的需求。例如开发了能在无明确标签情况下检测胸部 X 光疾病的 AI 模型,还成功构建并利用了包括胸部 X 光、心电图、心肺音、CT 等医学领域的基础模型。

(2)多模态学习开发结合不同数据源(如图像、传感器和语言)的方法,以提高医学决策和泛化能力。从生理数据开发模型以监测急诊科的高危患者,还开发了能通过学习配对医学图像和放射学报告来解释图像的模型,并建立了跨医学图像和传感器数据的模态不可知学习基准。

(3)生成式 AI:构建生成式 AI 模型,使模型能够用自然语言解释医学图像,并实现与临床医生的交互通信。引入数据集以解决自动报告生成的一些重大挑战,还开创了放射学报告生成的辅助方法,研究为临床医生提供 AI 辅助的影响以及可解释性方法的可信度。

论文:

Expert-level detection of pathologies from unannotated chest X-ray images via self-supervised learning, https://www.nature.com/articles/s41551-022-00936-9

MoCo-CXR: MoCo Pretraining Improves Representation and Transferability of Chest X-ray Models, https://arxiv.org/abs/2010.05352

Predicting patient decompensation from continuous physiologic monitoring in the emergency department, https://www.nature.com/articles/s41746-023-00803-0

Robotics and Embodied Artificial Intelligence Lab (REAL)

主页:https://real.stanford.edu/index.html

研究方向:多机器人协作与语言模型、机器人技能学习与获取、机器人操作研究、机器人导航与场景理解

研究成果:

论文:

GET-Zero: Graph Embodiment Transformer for Zero-shot Embodiment Generalization, https://arxiv.org/abs/2407.15002, https://get-zero-paper.github.io/

Dynamics-Guided Diffusion Model for Robot Manipulator Design, https://dgdm-robot.github.io/ , https://arxiv.org/abs/2402.15038

Universal Manipulation Interface: In-The-Wild Robot Teaching Without In-The-Wild Robots, https://umi-gripper.github.io/ , https://arxiv.org/abs/2402.10329

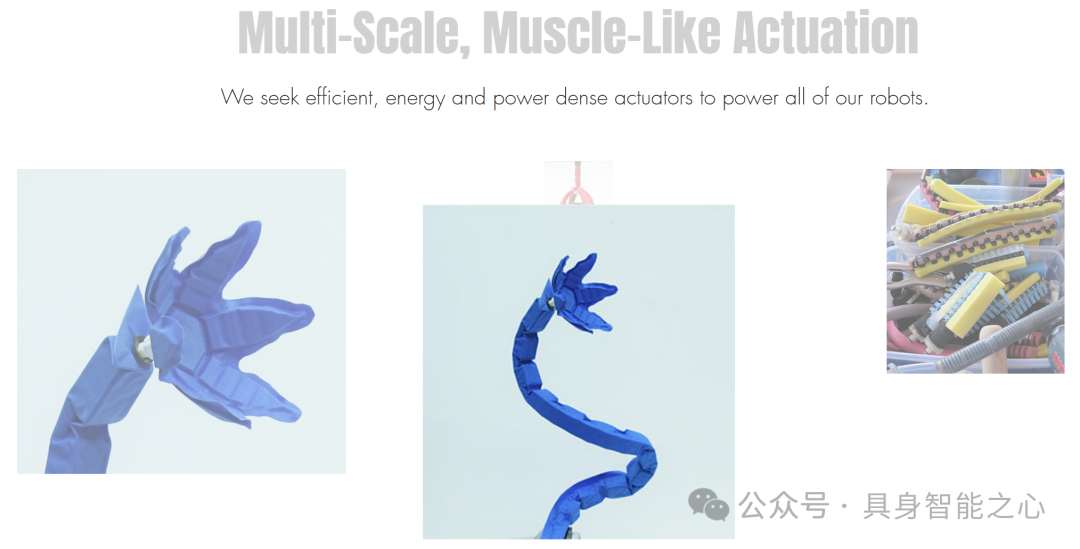

Multi-Scale Embodied Intelligence Lab - Imperial College London

主页:https://www.intelligentrobotics-acrossscales.com/

导师:Dr. Dandan Zhang

Multi - Scale Embodied Intelligence Lab 由 Dandan Zhang 博士领导,专注于多尺度的具身智能研究,将机器学习与机器人技术相结合,主要针对医疗应用领域,目标是开发具有超人类能力的下一代机器人。

研究方向:(1)多模态感知(传感):研究如何让机器人在不同尺度下精确地感知环境,例如针对微尺度手术工具的感知研究。(2)交互学习(决策):通过机器学习等技术,探索机器人如何在复杂环境中进行决策,如结合人工操作指令和基于机器学习的自主控制实现高效的人机共享控制。(3)灵巧操作(执行):研究机器人在不同尺度下的灵巧操作能力,包括开发微手术工具以实现精确的微操作,以及研究在 3D 空间中对微工具的灵巧操作控制策略和视觉技术。

应用领域:包括医疗机器人、家用机器人和辅助机器人等。

研究成果:

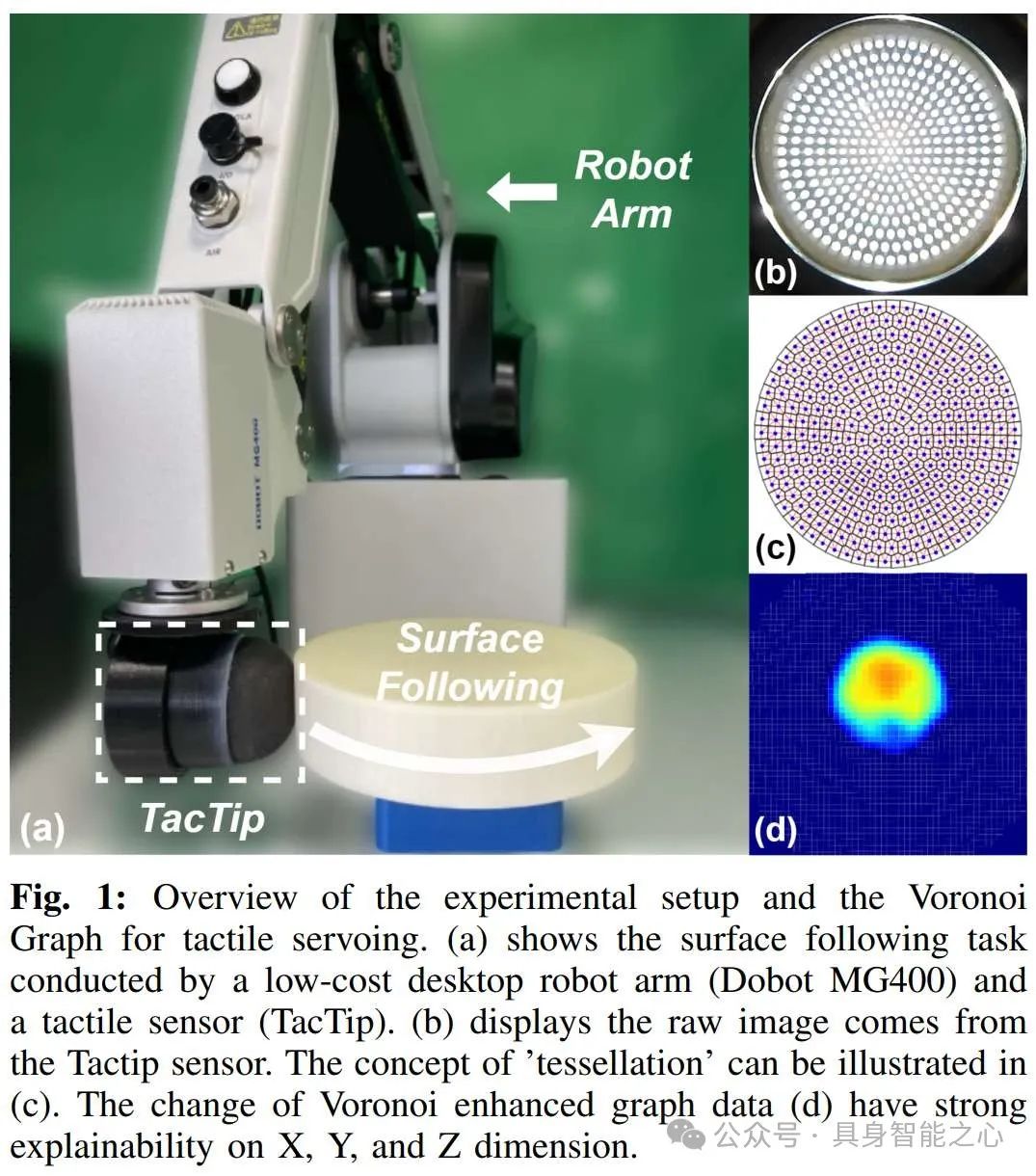

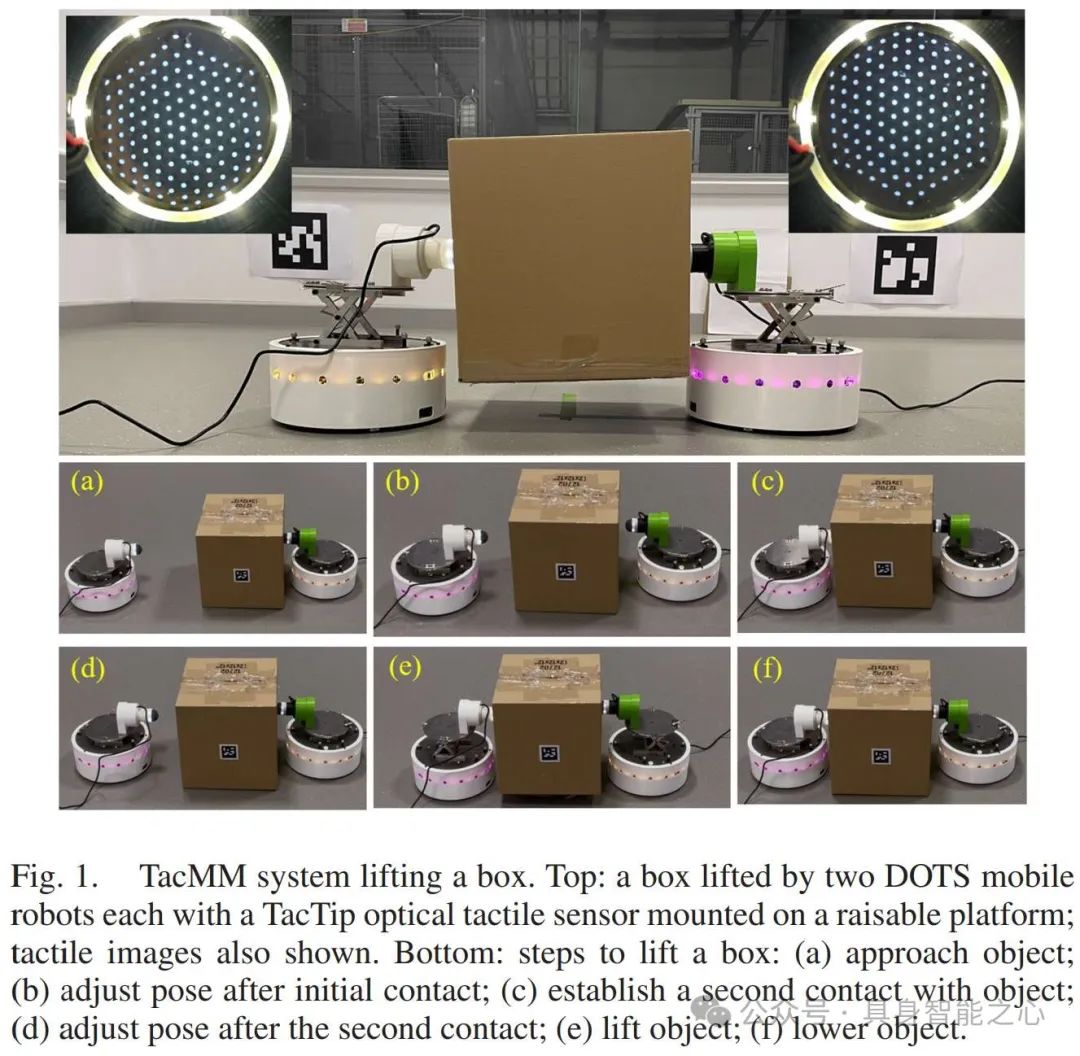

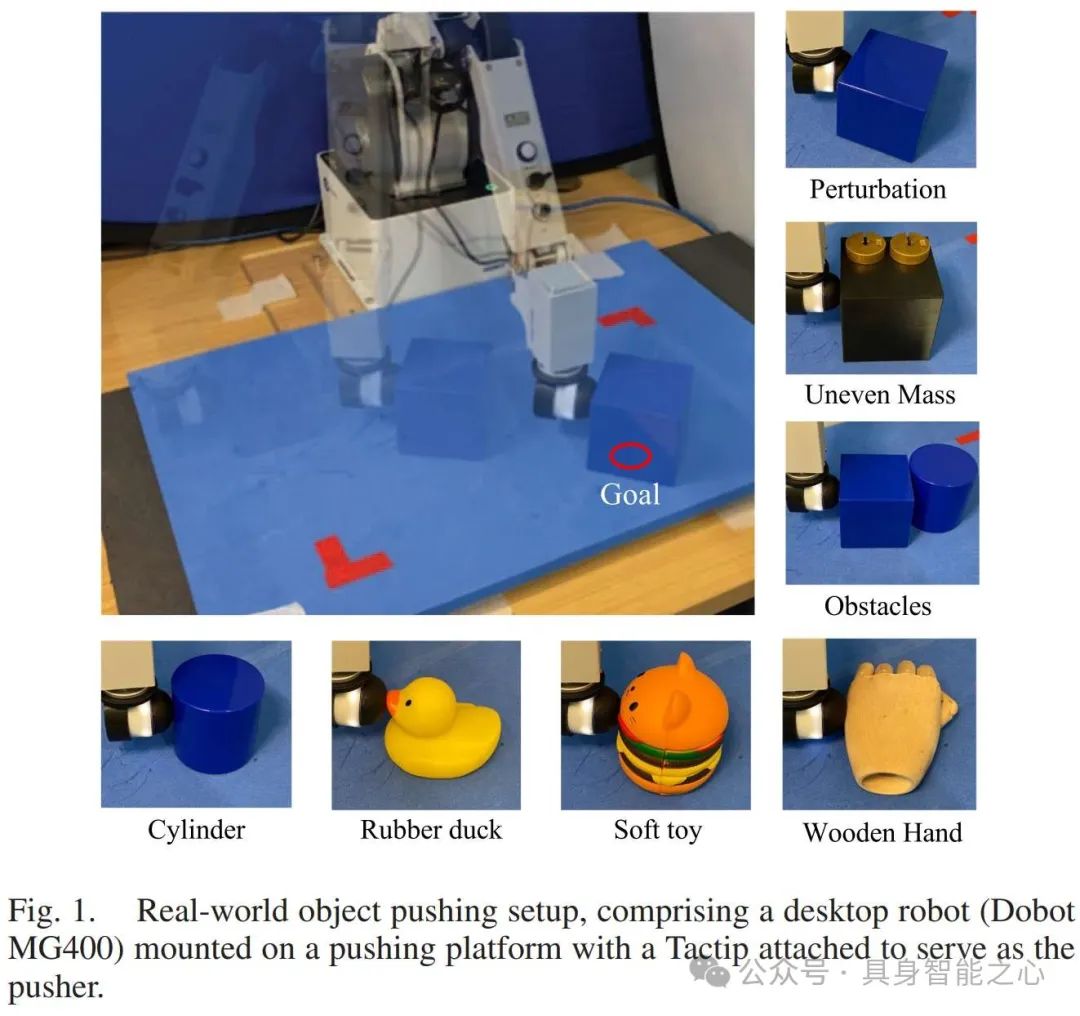

来源:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10155191 , TacMMs: Tactile Mobile Manipulators for Warehouse Automation

来源:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10155191 , TacMMs: Tactile Mobile Manipulators for Warehouse Automation

来源:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10182274 , Sim-to-Real Model-Based and Model-Free Deep Reinforcement Learning for Tactile Pushing

来源:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10182274 , Sim-to-Real Model-Based and Model-Free Deep Reinforcement Learning for Tactile Pushing

论文:

D. Zhang*, J. Zheng, "Towards the New Generation of Smart Homecare with IoHIRT: Internet of Humans and Intelligent Robotic Things", under review.

D. Zhang*, Z. Wu, J. Zheng, Y. Li, Z. Dong, J. Lin, "HuBotVerse: A Mixed Reality-Aided Cloud-Based Framework", under revision.

W. Fan*, H. Li*, W. Si, S. Luo, N. Lepora, D. Zhang,* "ViTacTip: Design and Verification of a Novel Biomimetic Physical Vision-Tactile Fusion Sensor", under review.

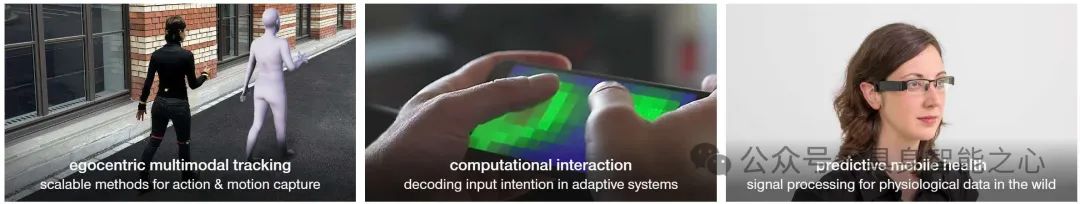

Sensing, Interaction & Perception Lab - SIPLAB - ETH Zürich

主页:https://siplab.org/

SIPLAB 是苏黎世联邦理工学院的一个跨学科研究小组,专注于计算交互、具身感知和移动健康领域的研究,涉及混合现实、机器人技术、人机交互和机器学习等多个学科。

研究方向:计算交互(研究自适应系统中的输入意图解码)、具身感知(包括以自我为中心的多模态跟踪,如用于动作和运动捕捉的可扩展方法,以及在不同条件下的姿态估计等)、移动健康(进行生理数据的信号处理,例如心血管监测(每秒测量血压))

研究成果:

论文:

EgoPoser: Robust Real-Time Egocentric Pose Estimation from Sparse and Intermittent Observations Everywhere. Jiaxi Jiang, Paul Streli, Manuel Meier, and Christian Holz.European Conference on Computer Vision 2024 (ECCV).

Ultra Inertial Poser: Scalable Motion Capture and Tracking from Sparse Inertial Sensors and Ultra-Wideband Ranging. Rayan Armani, Changlin Qian, Jiaxi Jiang, and Christian Holz.Proceedings of ACM SIGGRAPH 2024.

Robust Heart Rate Detection via Multi-Site Photoplethysmography. Manuel Meier and Christian Holz.Proceedings of IEEE EMBC 2024.

Robot Perception and Learning Lab

主页:https://rpl-as-ucl.github.io/

Robot Perception and Learning Lab 是一个专注于机器人研究的实验室,工作重点是为关节式机器人(四足、人形、类动物、移动操作器等)开发前沿算法,使它们能够在不可预测的自然环境中高效导航和操作。通过结合感知、决策和运动控制方面的见解,旨在使机器人能够以更高的自主性和精确性处理现实世界场景的复杂性。

研究方向:

为关节式机器人(四足、人形、类动物、移动操作器等)开发前沿算法。

使机器人能够在不可预测的自然环境中高效导航和操作。

提高机器人在处理现实世界复杂场景时的自主性和精确性。

研究成果:

机器人描述:Spot 是波士顿动力公司的旗舰四足机器人,旨在导航和检查具有挑战性的地形。这个强大的平台支持多种研究应用,尤其侧重于高级路径规划和感知系统。Spot 被设计用于在传统轮式或履带式机器人面临局限的现实环境中提供帮助,具备在不平坦表面上进行检查、数据收集和移动的能力。

机器人描述:ANYmal 平台支持低级控制,使其成为推进运动算法、环境感知和规划技术的理想研究工具。研究人员利用 ANYmal 探索在崎岖和动态表面上机器人运动和导航的新方法,为自主探索、检查和监测等领域做出贡献。

论文:

Active Sensing for Data Quality Improvement in Model Learning. Napolitano, O., Cognetti, M., Pallottino, L., Kanoulas, D., Salaris, P., & Modugno, V. IEEE Control Systems Letters (L-CSS). 2024.

Real-Time Metric-Semantic Mapping for Autonomous Navigation in Outdoor Environments. Jiao, J., Geng, R., Li, Y., Xin, R., Yang, B., Wu, J., Wang, L., Liu, M., Fan, R., & Kanoulas, D. IEEE Transactions on Automation Science and Engineering (T-ASE). 2024.

Reinforcement Learning Grasping with Force Feedback from Modelling of Compliant Fingers. Beddow, L., Wurdemann, H., & Kanoulas, D. IEEE/ASME Transactions on Mechatronics (T-Mech). 2024.

Berkeley Artificial Intelligence Research Lab (BAIR)

主页:https://bair.berkeley.edu/

伯克利人工智能研究实验室(BAIR)成立于 2017 年,汇集了加州大学伯克利分校计算机视觉、机器学习、自然语言处理、规划、控制和机器人等领域的研究人员。该实验室隶属于 CITRIS 人与机器人(CPAR)倡议。

研究成果:

论文:

Ruiqi Zhang, Spencer Frei, and Peter L. Bartlett. Trained transformers learn linear models in-context. Journal of Machine Learning Research, 25(49):1--55, 2024.

Covert Malicious Finetuning: Challenges in Safeguarding LLM Adaptation , By Danny Halawi, Alex Wei, Eric Wallace, Tony Wang, Nika Haghtalab, and Jacob Steinhardt. ICML 2024: Proc. International Conference in Machine Learning, 2024.

Jinkyu Kim, John Canny Interpretable Learning for Self-Driving Cars by Visualizing Causal Attention, International Conference on Computer Vision (ICCV) 2017

“具身智能之心”公众号持续推送具身智能领域热点:

往期 · 推荐

(1)具身多模态基础模型

NVIDIA最新!NVLM:开放级别的多模态大语言模型(视觉语言任务SOTA)

全面梳理视觉语言模型对齐方法:对比学习、自回归、注意力机制、强化学习等

CLIP怎么“魔改”?盘点CLIP系列模型泛化能力提升方面的研究

揭秘CNN与Transformer决策机制:设计原则是关键?

VILA:视觉推理能力如何up up?多模态预训练设计有妙招

(2)3D场景理解、分割与交互

大模型继续发力!SAM2Point联合SAM2,首次实现任意3D场景,任意Prompt的分割

更丝滑更逼真!模型自主发现与模式自动识别新升级助力三维场景构建与形状合成

进一步向开放识别迈进!3D场景理解与视觉语言模型的融合创新可以这样玩

(3)具身机器人与环境交互

港大最新!RoboTwin:结合现实与合成数据的双臂机器人基准

Robust Robot Walker:跨越微小陷阱,行动更加稳健!

波士顿动力最新SOTA!ThinkGrasp:通过GPT-4o完成杂乱环境中的抓取工作

基础模型如何更好应用在具身智能中?美的集团最新研究成果揭秘!

(4)具身仿真×自动驾驶

东京大学最新!CoVLA:用于自动驾驶的综合视觉-语言-动作数据集

ECCV 2024 Oral | DVLO:具有双向结构对齐功能的融合网络,助力视觉/激光雷达里程计新突破

(5)权威赛事结果速递

模型与场景的交互性再升级!感知、行为预测以及运动规划在Waymo2024挑战赛中有哪些亮点

效率和精度齐飞!CVPR2024 AIS workshop亮点大盘点

(6)具身智能工具深度测评

巨好用的工具安利!胜过WPS?MinerU 帮你扫清PDF提取

UCLA出品!用于城市空间的具身人工智能模拟平台:MetaUrban

(7)具身智能时事速递

端到端、多模态、LLM如何与具身智能融合?看完这50家公司就明白了

见证历史?高通准备收购英特尔!

万张A100“堆”出来的勇气:一个更极致的中国技术理想主义故事

即将截止!ECCV'24自动驾驶难例场景多模态理解与视频生成挑战赛

1637

1637

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?