Emory大学的研究团队提出了一种新的方法,通过知识蒸馏技术,将LLMs的强大能力转移到更小、更高效的本地图模型中,以提高TAGs的学习效率。

文本属性图(Text-Attributed Graph, TAG)学习是图神经网络和自然语言处理领域的一个重要交叉点。TAG中的节点通常由文本描述,而图结构则表示节点之间的关系。这类图结构在社交网络、推荐系统、知识图谱等多个领域具有广泛应用。然而,由于文本数据的复杂性以及图数据的异质性,如何有效地在TAG上进行学习一直是一个具有挑战性的问题。传统的图神经网络在处理TAGs时,往往依赖于大量的人工标注标签,这在许多应用中是不可行的。

近年来,大型语言模型(Large Language Models, LLMs)在自然语言处理任务中展现了强大的能力。LLMs能够捕捉文本中的丰富语义信息,并在多种下游任务中实现了显著的性能提升。然而,LLMs通常具有计算成本高、模型规模大等问题,这使得其在实际应用中存在一定的局限性。为了解决这一问题,Emory大学的研究团队提出了一种新的方法,通过知识蒸馏技术,将LLMs的强大能力转移到更小、更高效的本地图模型中,以提高TAGs的学习效率。(https://arxiv.org/pdf/2402.12022)

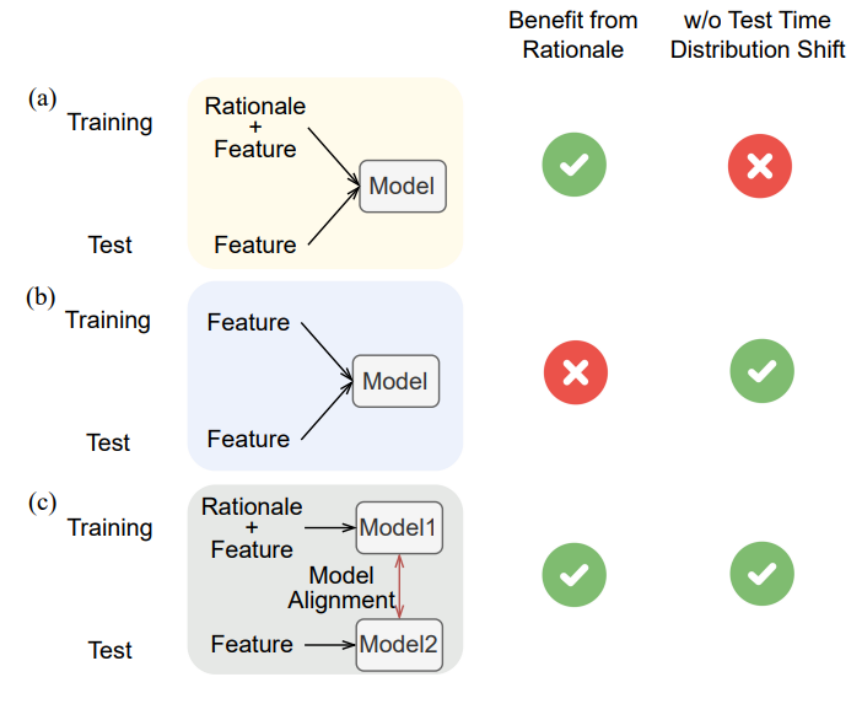

该研究的核心问题在于如何将LLMs的强大表现有效地转移到TAG学习中,同时克服LLMs在应用中的局限性。研究目标包括设计一个能够从LLMs中学习的中介模型,该模型能够捕捉文本中的重要信息,并将其传递给学生模型(student model);并在保证性能的同时,减少LLMs在TAG学习中的计算开销和隐私风险。具体而言,该项研究主要包含以下内容:

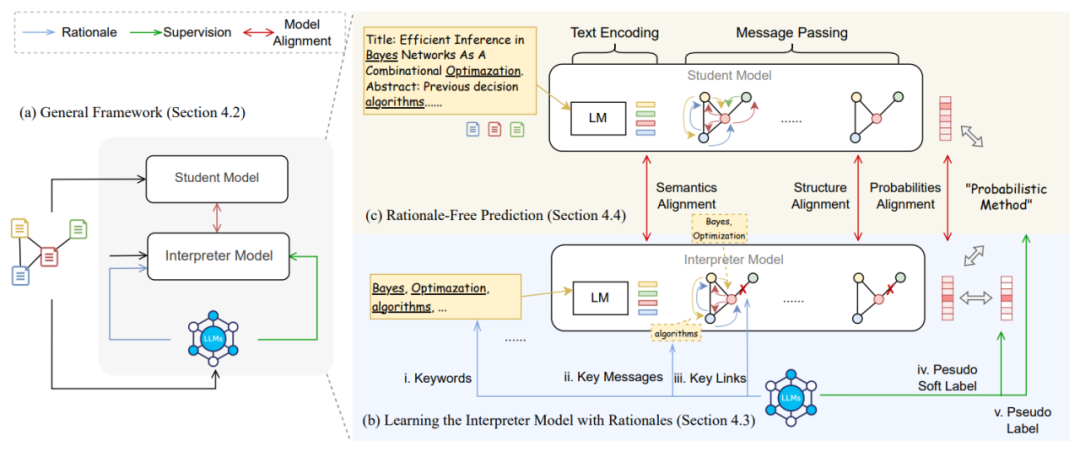

1、提出了一种新的框架,通过让LLMs输出理由来训练解释器模型,然后将这些知识转移到不依赖LLMs的学生模型中。

2、提出了一种将文本理由转换为文本级、结构级和消息级理由的方法,以及使用LLMs生成的伪标签和伪软标签作为训练解释器模型的监督。

3、提出了一种语义和结构感知的TAG模型对齐方法,该方法在对齐TAG模型时保留了文本和图信息,使学生模型能够更好地与教师模型对齐。

一、模型蒸馏框架

蒸馏框架旨在解决TAG学习中传统GNN模型难以充分利用文本信息的问题。通过结合大型语言模型(LLMs)的语义提取能力和GNN的结构学习能力,本文提出了一个两步的蒸馏过程。该方法包括三个主要模块:LLMs、解释器模型(interpreter model)和学生模型(student model)。

1. LLMs:

LLMs具备强大的文本理解和生成能力,能够捕捉到输入文本中的深层语义信息。其主要作用是从文本数据中提取出丰富的语义特征。这些特征不仅包括文本的显性信息(如关键词),还包含隐性的语义结构(如上下文依赖、隐喻等)。

2. 解释器模型:

该模型的设计目的是从LLMs中学到足够的信息,并以适合本地图模型输入的方式进行表达。解释器模型通过知识蒸馏(Knowledge Distillation)的方式进行训练,即通过对比LLMs的输出和目标标签,解释器模型逐渐学会如何从文本中提取重要的特征,并将这些特征映射为适合图神经网络处理的格式。这一过程的关键在于保持信息的有效性和一致性,使得后续的学生模型能够在不依赖于LLMs的情况下执行任务。

3. 学生模型:

学生图模型是最终用于实际任务的轻量级图神经网络。该模型接收解释器模型的输出作为输入,并在TAG学习任务中进行节点分类、链接预测等操作。由于中介模型已经预处理了大量复杂的语义信息,学生模型可以专注于利用图结构中的关系信息,从而大幅减少计算资源的消耗,具有良好的高效性和可扩展性。

二、解释器模型的零样本学习

解释器模型的训练过程核心在于使用零样本学习方法,即在没有先验标签的情况下,通过文本理由(rationales)自动生成伪标签和软标签,用于将文本理由转化为图形模型中的多层次增强特征以训练图神经网络。

主要步骤包括:

1、生成伪标签和伪软标签:

利用LLMs的零样本学习能力,为每个节点生成伪标签和伪软标签,这些标签将用于生成理由并作为训练解释器模型的监督信号。过程中引入软标签(soft labels)机制,通过分析文本的深层含义来给出更加细致的标签,有助于模型更好地理解文本和图结构之间的关联。

2、关键词识别:

通过LLMs识别文本中对分类最有帮助的关键词,以增强文本特征。

3、关键链接和消息识别:

识别对中心节点分类重要的邻居节点(关键链接)和这些邻居节点中的关键信息(关键消息)。模型通过详细的文本理由来学习如何将文本信息转化为图的信息。这些理由不仅包括文本的直接描述,还包括背后的逻辑和推理过程,使模型能够在没有显式理由的情况下进行推断。

三、语义和结构感知的模型对齐方法

通过语义和结构感知的方式,可将大型语言模型(LLMs)的知识传递给图模型,以优化文本属性图(TAG)的学习过程。这个框架包括一个解释器模型和一个学生模型,两者通过特定的模型对齐方法进行知识传递,以实现在没有LLMs的情况下进行有效的预测。

1、语义对齐(semantics alignment)

语义对齐的目的是缩小解释器模型和学生模型在文本嵌入上的差异,主要包含以下步骤:

①提取文本嵌入:从解释器模型和学生模型中提取文本嵌入,这些嵌入包含了节点的文本特征。

②考虑节点度:在对齐过程中,考虑节点在图中的连接度,即其邻居节点的数量。

③计算语义相似性:使用余弦相似度等方法计算原始文本特征和LLM增强后的文本特征之间的相似性。

④最小化嵌入差异:通过优化过程,减少解释器模型和学生模型在文本嵌入上的差异。

2、结构对齐(Structure Alignment)

结构对齐关注于模型对图结构的理解,特别是节点的邻居结构,主要包含以下步骤:

①选择重要邻居:通过模型识别每个节点的关键邻居节点,这些邻居节点对于节点的分类至关重要。

②计算结构相似性:比较原始邻居结构和增强后的邻居结构之间的相似性,以识别结构上的差异。

③最小化结构差异:通过优化过程,减少解释器模型和学生模型在结构嵌入上的差异。

3、总体模型对齐目标

在语义对齐和结构对齐的基础上,本研究进一步考虑模型的预测输出(即逻辑值对齐)。总体对齐目标是结合以下三个方面的损失函数:

①标签预测损失:使用交叉熵损失来计算学生模型的预测标签与真实标签之间的差异。

②逻辑值对齐损失:使用均方误差(MSE)损失来计算解释器模型和学生模型输出的逻辑值之间的差异。

③语义和结构对齐损失:结合语义对齐和结构对齐的损失,以确保学生模型在没有LLMs的情况下也能准确预测。

与传统方法相比,该研究提出的框架通过蒸馏过程,将LLMs的计算负担转移到更轻量级的学生模型中,使得实际应用更加高效,降低计算成本。同时,学生模型不再直接依赖LLMs,避免了在数据传输和处理过程中暴露敏感信息的风险。该方法能够适应多种LLMs和GNN架构,为不同任务提供定制化的解决方案。

四、如何学习大模型?

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

5. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方CSDN官方认证二维码,免费领取【

保证100%免费】

如有侵权,请联系删除

743

743

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?