当今环境,所有人都面临一个问题:信息过载。不知道你是否曾经遇到过以下困扰?

- 在海量数据中搜索时,是否难以迅速找到所需的信息?

- 在面对日益增长的专业知识,是否感到知识管理的需求愈发迫切?

- 对于敏感数据的存储,是否时常害怕一不小心就会泄露关键信息?

- 在日常工作中,是否因为工作效率不高而觉得时间不够用?

如果这些场景让你感同身受,那么你一定在思考:是否存在一种方案,能够一举解决这些棘手的问题?

确实有这么一个方案,它就是基于 FastGPT 搭建本地私有化知识库,一个为你量身定制专属的知识管理解决方案。

下面将带领大家揭示如何结合FastGPT、大语言模型和向量模型,构建属于你自己的本地私有化知识库。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

一、安装部署FastGPT

什么是FastGPT?

FastGPT,是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。

同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!

FastGPT 在线使用地址:https://cloud.fastgpt.in/login

FastGPT 在线GitHub地址:https://github.com/labring/FastGPT

1、推荐配置

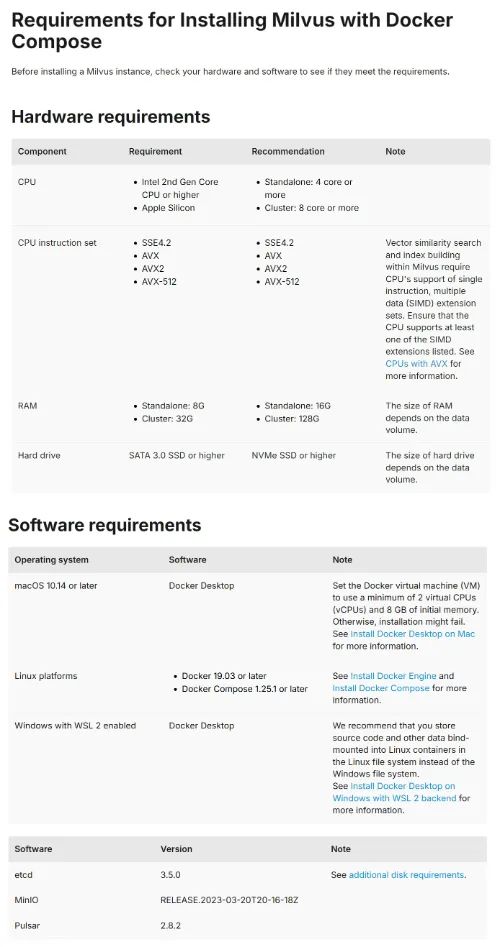

为了满足广大用户的具体需求,FastGPT提供了PgVector、Milvus和zilliz cloud三种版本可供选择。我们可以根据自己的数据规模和性能要求,灵活地在Linux、Windows、Mac等不同的操作系统环境中部署合适的版本。

「PgVector版本」 —— 针对初体验与测试的完美起点

PgVector版本是进行初步体验和测试的理想选择。它简便易用,适合处理中小规模的向量数据,能够迅速掌握并开始工作。

「Milvus版本」 —— 专为千万级向量数据设计的性能强者

当数据处理需求升级至千万级以上,Milvus版本较之其他版本具有卓越的性能优势,是处理大规模向量数据的首选方案。

「zilliz cloud版本」 —— 亿级向量数据的专业云服务解决方案

对于处理亿级及更高量级的海量向量数据,zilliz cloud版本提供了专业的云服务支持,确保您能够获得高效且稳定的数据处理体验。得益于向量库使用了 Cloud,无需占用本地资源,无需太关注配置。

2、环境准备

FastGpt的部署重度依赖于Docker环境。因此,在本地系统或所管理的服务器上安装Docker环境是确保FastGpt顺畅运行的必要条件。

什么是Docker? 这么说吧,FastGpt就像一款需要特定玩具盒子才能玩的电子游戏。这个特定的玩具盒子的名字就叫“Docker”。所以,如果我们想在我们的电脑或服务器上顺利地运行FastGpt,就必须先安装这个玩具盒子,这样FastGpt才能正确地工作。

Windows 系统安装 Docker

在 Windows 系统上,建议将源代码和其他数据绑定到 Linux 容器时,使用 Linux 文件系统而非 Windows 文件系统,以避免兼容性问题。

-

「使用 Docker Desktop」

「推荐使用 WSL 2 后端」:可以通过 Docker 官方文档在 Windows 中安装 Docker Desktop。具体步骤请参考**:****https://docs.docker.com/desktop/wsl/**。

-

「使用命令行版本的 Docker」

「直接在 WSL 2 中安装」:如果不希望使用 Docker Desktop,也可以选择在 WSL 2 中直接安装命令行版本的 Docker。详细安装步骤请参考:https://nickjanetakis.com/blog/install-docker-in-wsl-2-without-docker-desktop。

macOS 系统安装 Docker

对于 macOS 用户,推荐使用 Orbstack 来安装 Docker。

- 「通过 Orbstack 安装」:

- 访问 Orbstack 官网 **(https://orbstack.dev/)**按照指示进行安装。

-

「通过 Homebrew 安装」:

brew install orbstack

- 在终端运行以上命令

Linux 系统安装 Docker

在 Linux 系统上安装 Docker 的步骤如下:

- 「打开终端,运行以下命令来安装 Docker:」

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

systemctl enable --now docker

- 「接着安装

**docker-compose**:」

curl -L https://github.com/docker/compose/releases/download/v2.20.3/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-compose chmod +x /usr/local/bin/docker-compose

- 「验证安装是否成功」:

docker -v docker-compose -v

- 运行以上命令来验证 Docker 和 docker-compose 是否正确安装

3、开始部署

-

下载

**docker-compose.yml**文件

首先,我们需要访问 FastGPT 的 GitHub 仓库。在仓库的根目录中找到**docker-compose.yml**文件。点击文件,然后点击 “Raw”(原始)按钮,文件内容将显示在浏览器中。接下来,右键点击页面,选择 “保存为”,将其保存到您的计算机上。 -

修改

**docker-compose.yml**环境变量

使用文本编辑器(如记事本、Notepad++、VSCode 等)打开下载的**docker-compose.yml**文件,接下来在文件中找到与向量库版本相关的部分。根据您选择的向量库(PgVector、Milvus 或 Zilliz),您需要修改相应的环境变量。注意:如果选择的是 Zilliz 版本,则需要找到包含

**MILVUS_ADDRESS**和**MILVUS_TOKEN**的行,将它们修改为您的 Milvus 服务地址和认证令牌,而另外的两个版本无需修改。 -

启动容器

打开命令行工具(如终端、命令提示符或 PowerShell)。

使用**cd**命令切换到包含**docker-compose.yml**文件的目录。例如:cd path/to/your/docker-compose.yml/directory然后运行以下命令来启动容器:

docker-compose up -d这个命令会在后台启动所有定义在

**docker-compose.yml**文件中的服务。 -

打开 OneAPI 添加模型

在浏览器中输入您的服务器 IP 地址后跟**:3001**,例如**http://192.168.1.100:3001**。

然后使用默认账号**root**和密码**123456**登录 OneAPI。登录后,根据指示添加 AI 模型渠道。 -

访问 FastGPT

在浏览器中输入您的服务器 IP 地址后跟**:3000**,例如**http://192.168.1.100:3000**。

使用默认用户名**root**和在**docker-compose.yml**文件中设置的**DEFAULT_ROOT_PSW**密码登录 FastGPT。 -

至此,FastGPT安装部署大功告成!

二、搭建私有化知识库

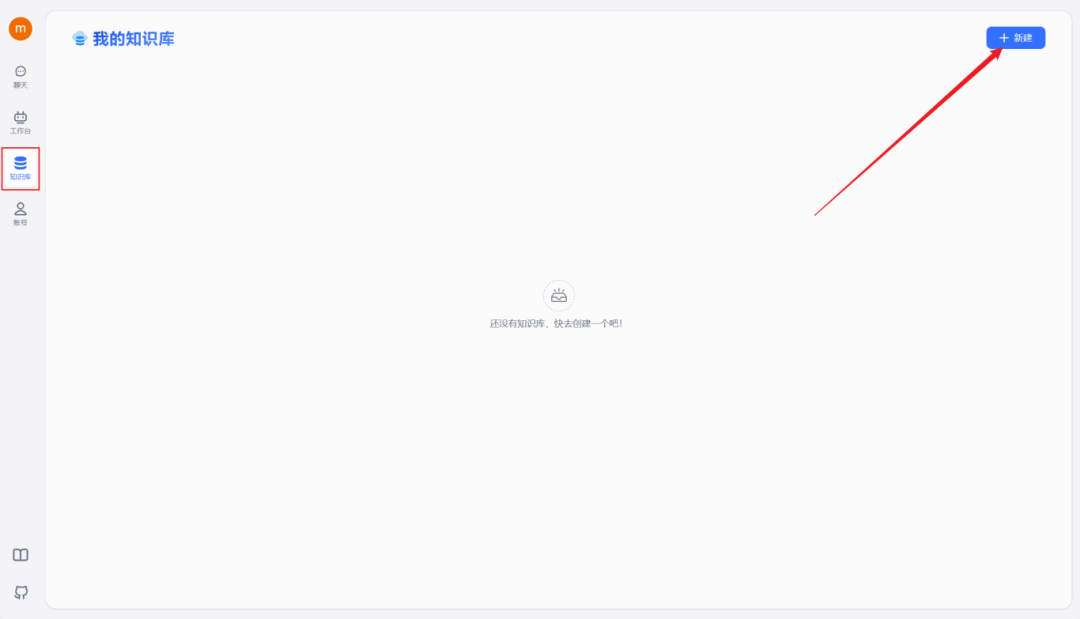

当第一次打开网站时,我们会发现界面一片白花花的啥也没有。这个时候,不要慌,来跟我按照以下步骤来搞定你的第一个个人知识库!

-

在左侧菜单栏选择“知识库”选项。

-

点击页面右上角的“新建”,开始构建您的第一个知识库。

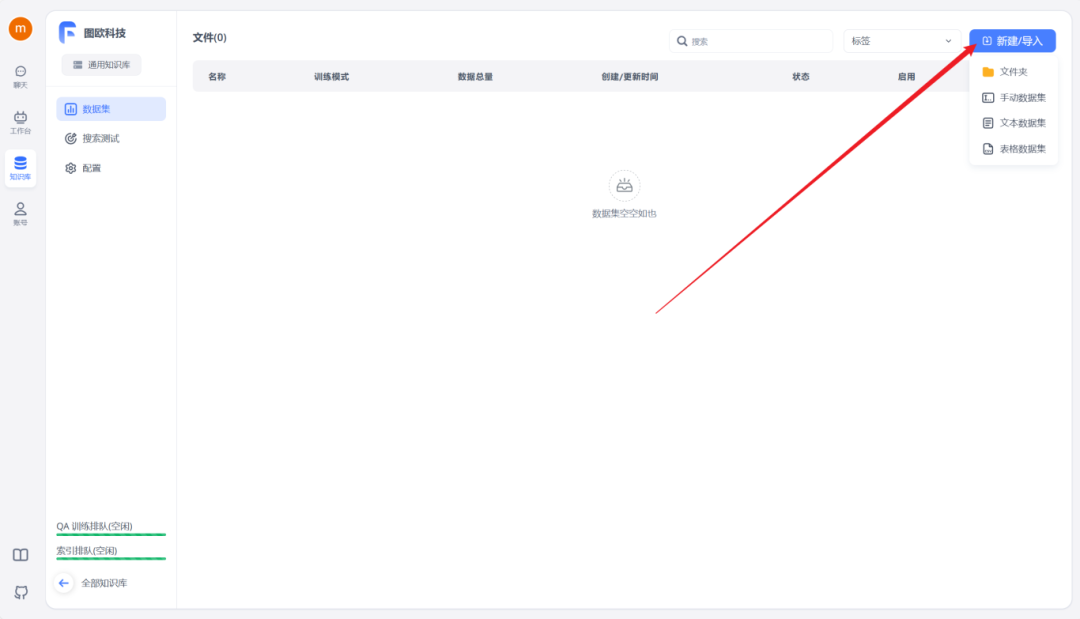

在此过程中,可以根据自身的需求选择合适的知识库类型。紧接着确定我们的知识库名称、索引模型和文件处理模型。

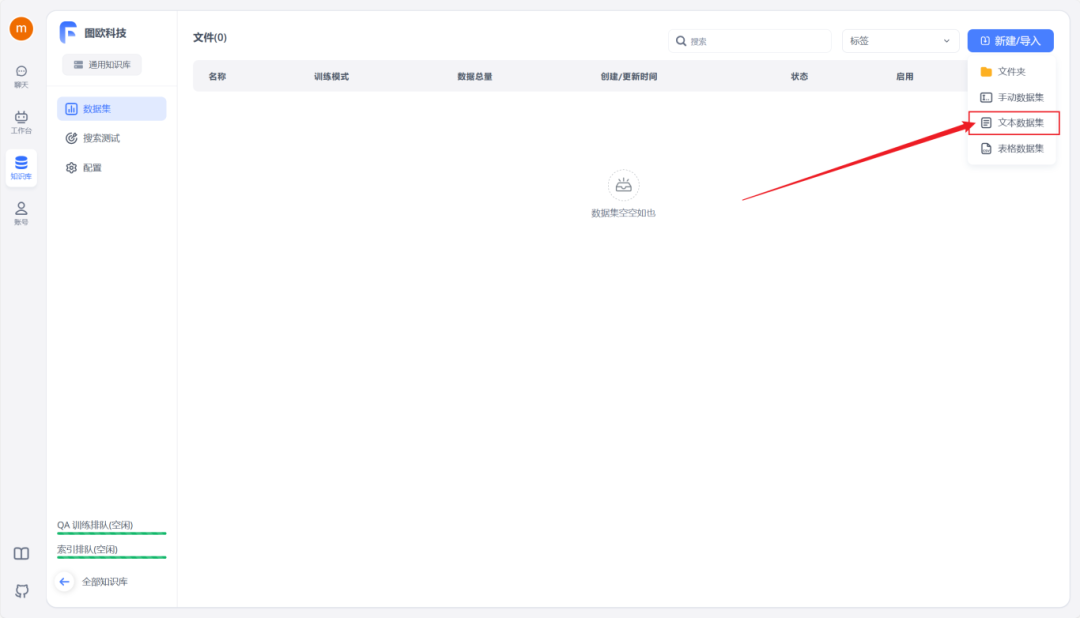

完成创建后,点击右上角的“新建/导入”,根据您的数据集类型选择相应的导入选项。

首先需要准备好知识库数据集,可以为DOCX、TXT或者PDF格式,然后选择文本数据集,选择本地文件导入。这里图欧君以咱们的IMYAI知识库为例子,进入飞书云文档《IMYAI智能助手使用手册》之后点击右上角导出为Word文档,文档权限我已经开放为人人都可以创建副本,导出下载,这个大可放心。

IMYAI知识库地址:https://new.imyai.top

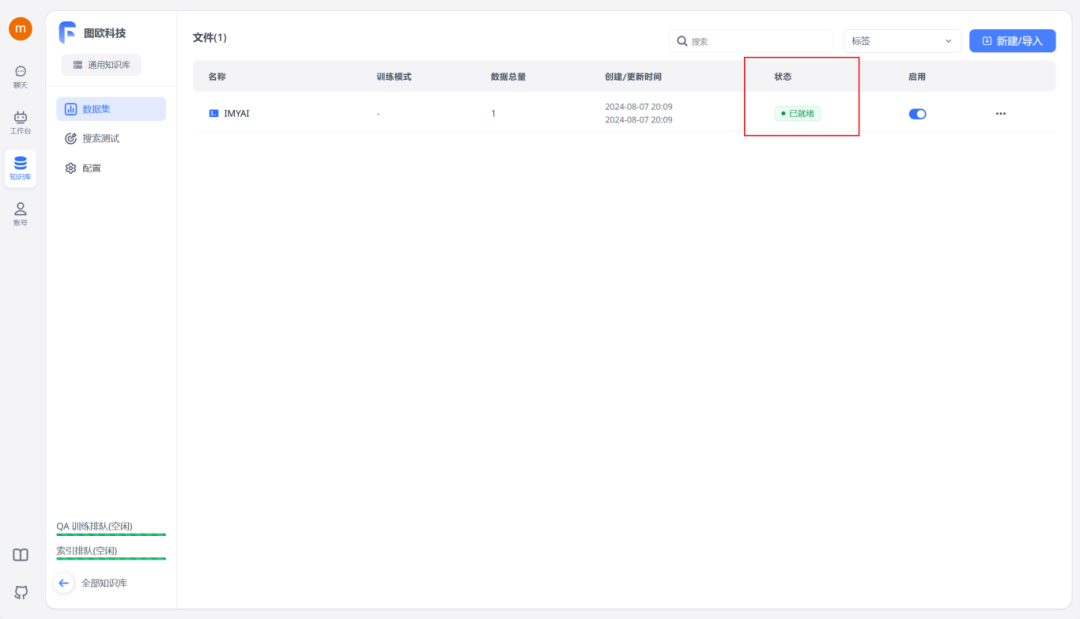

等待数据处理并成功上传后,状态栏将显示“已就绪”,这时知识库搭建就完成了。

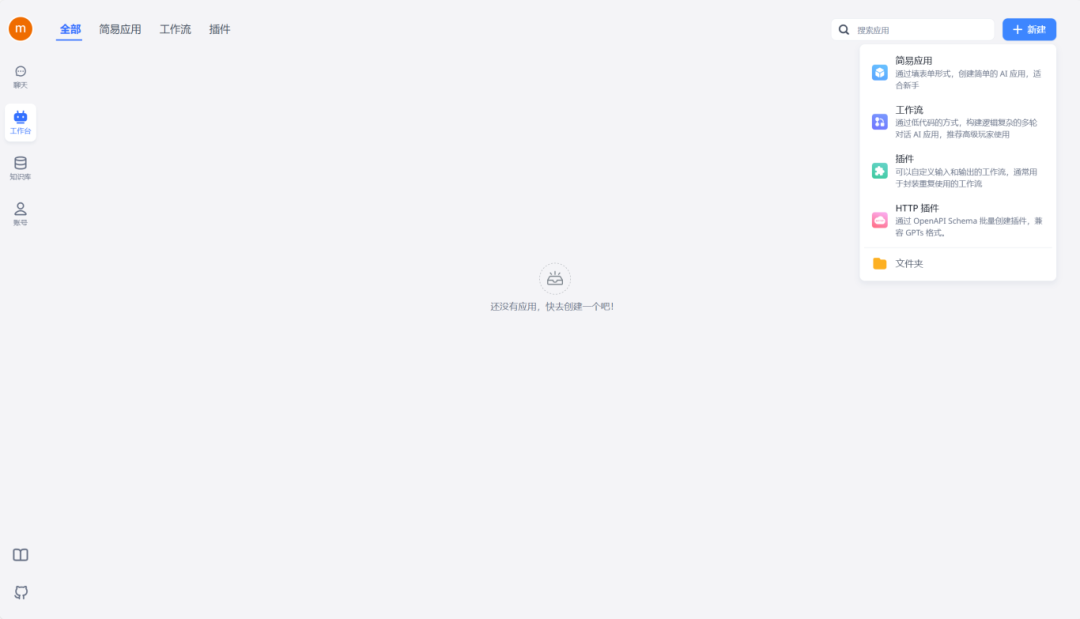

知识库搭建完成之后就可以转到工作台栏进行应用的创建了,一共是提供了四种类型的应用可供我们选择,只需根据自己的需要选择合适的应用即可,图欧君在这里选择了简易应用做个示范。

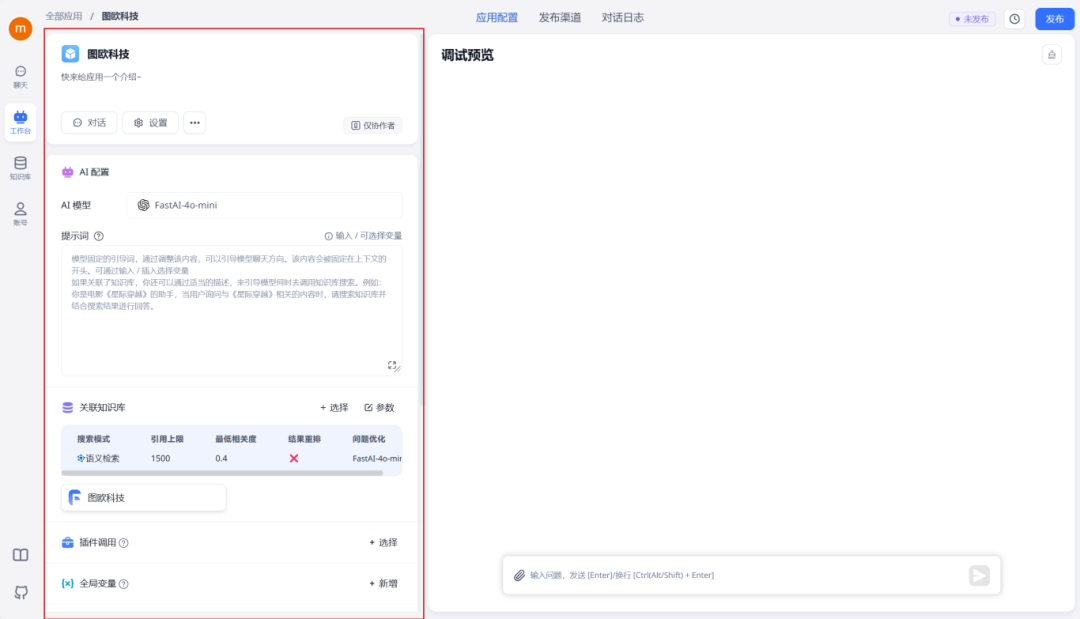

左侧你可以对创建的应用进行一些配置,最后不要忘了把刚刚建立的知识库,关联进来。

完成配置之后,我们可以在右侧调试一下。

如果在使用IMYAI智能助手的过程中遇到其他问题,也可以随时进行提问,它会根据知识库内容进行梳理总结,减少你寻找答案的时间(不过要记得,先导入知识库内容哦~)

通过对比不难看出,FastGPT这波回答的还是不错的,将原本的内容进行梳理整合之后重新输出,能够更加直观地找到解决问题的答案。

确认调试无误后,点击右上角的“发布”。发布成功后,就可以拥有一个基于本地私有知识库增强的LLM(大型语言模型)啦~

至此,一个私有化的个人知识库就搭建完成了。

最后分享

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

5. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?