CodeGeeX4-ALL-9B作为最新一代CodeGeeX4系列模型的开源版本发布后,很多用户对这次更新的CodeGeeX插件支持本地模式非常感兴趣,都希望能够在本地部署CodeGeeX4-ALL-9B,然后通过本地模式接入CodeGeeX插件中来使用代码补全和智能问答的功能。

CodeGeeX4-ALL-9B这次也专门适配了GGUF,今天我们详细介绍只用简单的一招,不用考虑环境和依赖,通过Ollama跑起来本地的CodeGeeX代码大模型。

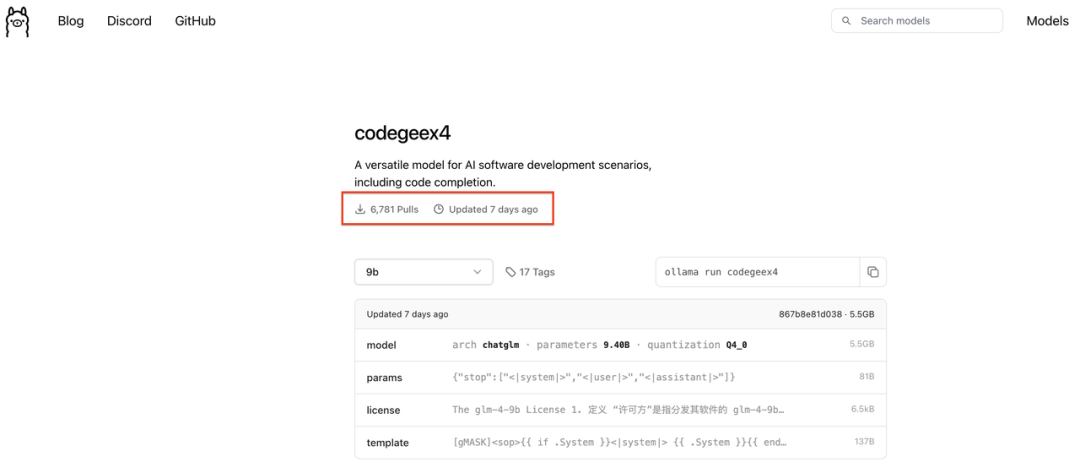

首先我们需要用到的Ollama也是一个开源项目,是在本地快速跑各种开源大模型的最优选择之一。CodeGeeX4-ALL-9B在开源后不到24小时就获得了Ollama的支持,目前通过Ollama下载已经超过了6000次+。

安装使用的过程非常简单,跟着下面的教程,大家也可以一起来体验:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1726

1726

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?