Enhanced Language Representation with Label Knowledge for Span Extraction

目录

01 领域

NER领域,文中给出的任务形式是span extraction,即从plain text中抽取text span。

文中主要研究了如何融入外部信息?(label knowledge)

任务建模形式:QA范式。(问答的形式)

插一个总结

文章的创新是label 的text的融合方法。两个encoder和label的attention融合。

但文中,没有给出是使用一个encoder同时编码text和Q和两个不同encoder编码Q和A的效果对比。

在语义融合中,对比了,average pooling和使用sent—level【CLS】做信息融合的性能和文中使用的sent token level+attention的性能对比。

02 前言

在已有的融入模式中,前人的做法,Q和A采用同一个encoder,一般模型的输入是【CLS】+Q+【SEP】+A。

文中的做法是采用了两个share paramter的encoder,编码Q和A,之后,设置了信息融合步骤,融合两类信息。

03文中模型

模型由语义编码模块、语义融合模块和跨度解码模块三个模块构成。

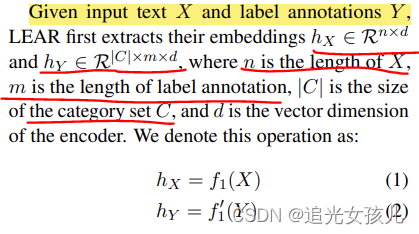

3.1 语义编码模块

将本X 和所有标签类别的注释 Y 作为输入。这两个输入分别由两个编码器网络处理,其主干为 BERT (Devlin et al., 2019)。两个编码器在处理两个输入时共享权重(称为共享编码器)

3.2 语义融合模块

共享编码器生成的文本嵌入和标签嵌入由语义融合模块融合,以得出文本的标签知识增强嵌入。根据注意力机制,得到每个class 下的x的表示。

(1)通过该线性层,映射到相同的特征空间

(2)attention计算,采用dot product计算注意力分值,在通过softmax function得到attention score。

补充:其中的label annotation部分,是由人制定的。

(3)计算每个类别下的text的细粒度特征。

3.2 跨度解码模块

分别计算,每个类别下的span的start和end的index。

train

flat和nest两种。设置了两种损失函数。

flat如下:

nest如下:

loss函数

该文探讨了在命名实体识别(NER)任务中的跨度提取,通过引入外部标签知识来提升语义表示。文章提出使用两个共享参数的编码器分别处理文本和标签,然后通过语义融合模块结合注意力机制融合信息。尽管提出了label的text融合方法,但未比较单个编码器与双编码器的效果。此外,对比了平均池化和基于【CLS】的融合策略。在跨度解码阶段,计算每个类别下的起始和结束索引。训练时采用了flat和nest两种损失函数设置。

该文探讨了在命名实体识别(NER)任务中的跨度提取,通过引入外部标签知识来提升语义表示。文章提出使用两个共享参数的编码器分别处理文本和标签,然后通过语义融合模块结合注意力机制融合信息。尽管提出了label的text融合方法,但未比较单个编码器与双编码器的效果。此外,对比了平均池化和基于【CLS】的融合策略。在跨度解码阶段,计算每个类别下的起始和结束索引。训练时采用了flat和nest两种损失函数设置。

1246

1246

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?