还没开始宣传,就收到了这样的评价,我有点破防了

👋 你好,我是《Yocto项目实战教程》的作者。

这本书正式上市其实才没多久,我还在纠结怎么宣传、怎么介绍,甚至连朋友圈都还没怎么发。

结果,前几天收到一个读者的留言,让我有点破防了。

他是一位做 OpenBMC 的 Linux 开发工程师,悄悄在京东下单买了书。收到后,他主动加我微信,然后说:

“书写得不错,我也是做 linux 开发的(openbmc),以后得多多向您请教 😁

这书太新了,我看日期还是今年的。”

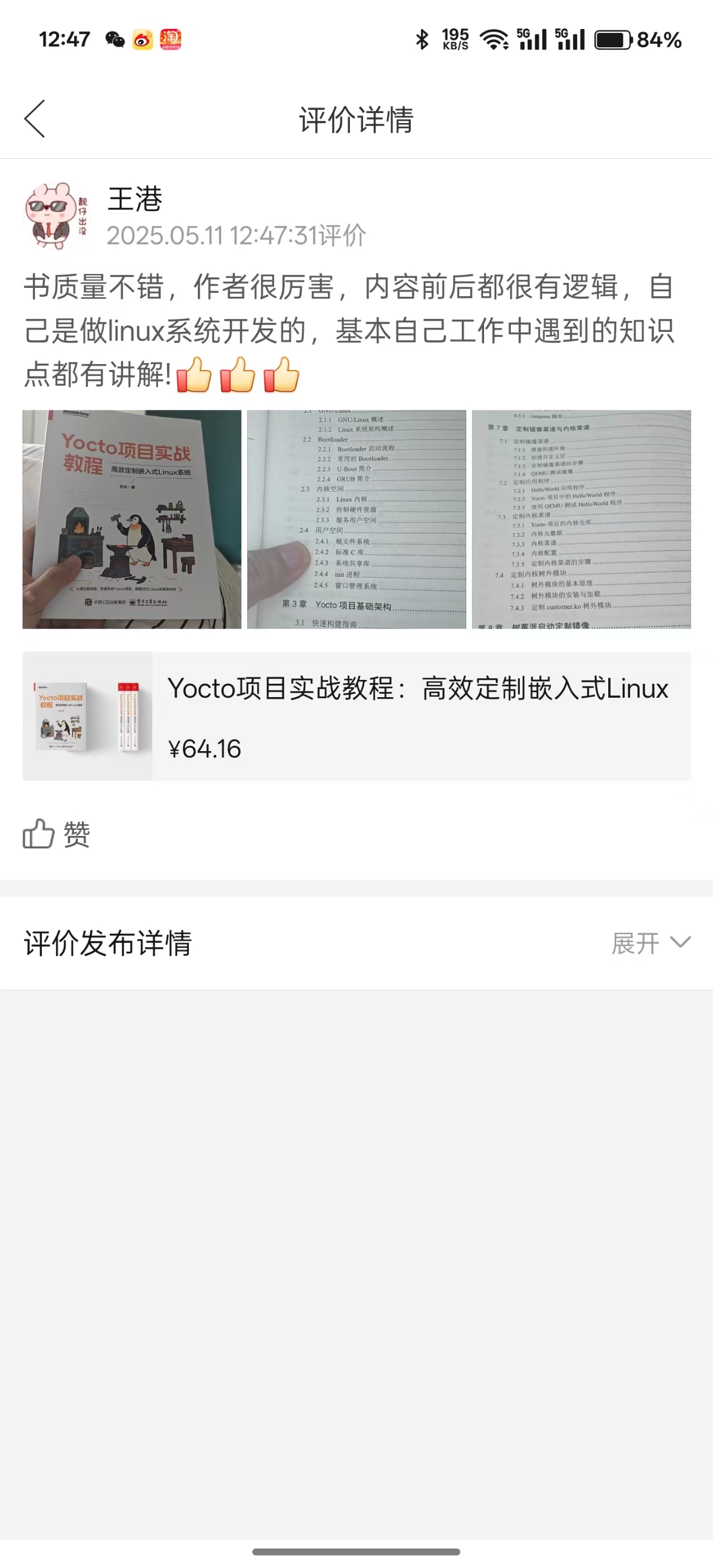

后来我一看,他还专门去京东写了评价、拍了几张照片,并且说:

“作者很厉害,内容前后有逻辑,自己是做linux系统开发的,基本自己工作中遇到的知识点都有讲解!”

“👍👍👍”

坦白说,写这本书的过程一点也不轻松:

- 我是从一行一行代码搭出来的内容,不是“复制配方”,而是每个章节都和实际项目有关;

- 我自己就来自系统开发一线,每一节都在想“写下这段话,能帮读者解决什么问题?”

所以,当我看到这些真实的反馈时,我真的有点感动。

写书最大的回报,是“共鸣”

我知道这本书还有很多可以优化的地方,甚至书还没广泛宣传、还没有太多媒体推荐。

但就是这样,在没有炒作、没有营销的情况下,有人愿意主动给出这样的评价:

这不是“做内容”的人最幸福的时刻吗?

所以,感谢每一个悄悄买书、认真阅读的你

📕 这本《Yocto项目实战教程》,可能不会一夜爆红。

但它会成为越来越多嵌入式工程师,走向系统开发道路上的伙伴。

我会继续创作,把 Yocto、BSP、驱动、系统架构这些原本枯燥的知识,讲得更清楚、写得更实用。

📮 如果你也读了这本书,有任何想法,欢迎随时私信我。

📺 视频讲解、更新笔记、实战补充内容,也都会发布在 B站“嵌入式Jerry”。

📌 这不是一本讲完就忘的书,而是你整个嵌入式职业路上的参考书。

谢谢你的信任。

—— Jerry 敬上

1037

1037

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?