一致且特定的多视图子空间聚类

Abstract 由于利用数据的多个视图的有效性,多视图聚类引起了人们的广泛关注。然而,大多数现有的多视图聚类方法仅旨在探索不同视图的一致性或增强不同视图的多样性。在本文中,我们提出了一种新颖的多视图子空间聚类方法(CSMSC),其中一致性和特异性联合用于子空间表示学习。我们使用共享一致表示和一组特定表示来制定多视图自我表示属性,这更好地适合现实世界的数据集。具体来说,一致性对所有视图之间的共同属性进行建模,而特异性则捕获每个视图中的固有差异。此外,为了优化非凸问题,我们引入凸松弛并开发交替优化算法来恢复相应的数据表示。对四个基准数据集的实验评估表明,所提出的方法比几种最先进的方法取得了更好的性能。

“Introduction” 介绍

子空间聚类对于许多科学问题至关重要,例如表示学习(Liu and Yan 2011)、运动分割(Rao et al. 2010)和图像处理(Ma et al. 2007)。给定/位于子空间并集中的多个类别的数据,将数据集聚类为类别可以简化为将数据分配到各自的子空间,其中每个数据样本由同一子空间中其他样本的线性组合表示。

近年来已经开发了许多子空间聚类方法(Parsons、Haque 和 Liu 2004)。例如,稀疏子空间聚类(Elhamifar 和 Vidal 2013)从数据的子空间中找到稀疏表示。此外,低秩表示(Liu et al. 2013)通过低秩约束探索子空间结构来恢复数据。在获得数据的自表示矩阵后,应用谱聚类(Ng,Jordan和Weiss 2002)来获得最终的聚类结果。此外,创新追求(Rahmani and Atia 2017)提出了另一种子空间发现方法,该方法根据每个子空间对其他子空间的新颖性来识别它。

许多现实世界的问题都有多种观图的表征(Blum 和 Mitchell 1998;Chaudhuri 等人 2009)。例如,图像是通过颜色、纹理、边缘等来描述的。一个文档可以同时用几种不同的语言来描述。因此,仅使用单一视图信息的方法不能很好地满足现实世界的需求。基于各种理论,已经开发了许多方法来从多个视图中提取综合信息(Xu、Tao 和 Xu 2013),包括协同训练(Blum 和 Mitchell 1998;Kumar、Rai 和 Daum ́ e 2011) ;Kumar 和 Daum ́ e 2011)、多核学习(G ̈ onen 和 Alpaydın 2011)和子空间学习(Chaudhuri 等人 2009;Cao 等人 2015;Zhang 等人 2015;Xia 等人 2014)。

然而,大多数现有方法都存在几个主要缺陷。一方面,单视图方法不像多视图方法那样利用那么多信息。另一方面,大多数多视图方法只考虑多视图数据的一致性(Kumar and Daum ́ e 2011;Kumar, Rai, and Daum ́ e 2011;Zhang et al. 2015),或者只探索不同的子空间表示的多样性(曹等人,2015)。虽然我们可以简单地连接所有特征,但这种策略忽略了视图之间的相关性,并可能导致严重的“维数灾难”。此外,现实世界是本质上的,仅仅考虑一致性或多样性是不够的。因此,这些方法没有全面探索不同视图之间的底层数据分布。

针对上述问题,我们提出了一种同时考虑一致性和多样性的子空间学习方法。

考虑到多个视图特征覆盖了相同数据的信息,因此不同视图之间应该存在许多共享的公共信息。具体来说,对于一致项,我们假设存在一个低秩的共同表示来挖掘不同视图之间的共享信息。同时每个视图中都有一些独特的信息可以弥补精确重建的不足。

因此,通过一致且具体的项,我们可以全面地发现多视图数据的相关性,从而更好地拟合现实世界的数据集。我们将此方法称为一致且特定的多视图子空间聚类(CSMSC)。图 1 展示了我们的方法。

图 1:我们的 CSMSC 方法的图示。给定具有 V 个视图 X(1), X(2),…,X(V ) 的数据样本,我们的方法追求视图一致的自表示矩阵 C 和一组特定于视图的自表示矩阵 D( 1), D(2),…,D(V)。由 C 和 {D(v)}v∈[V ] 生成的亲和力矩阵将用作谱聚类方法的输入,以生成最终的聚类结果。

图 1:我们的 CSMSC 方法的图示。给定具有 V 个视图 X(1), X(2),…,X(V ) 的数据样本,我们的方法追求视图一致的自表示矩阵 C 和一组特定于视图的自表示矩阵 D( 1), D(2),…,D(V)。由 C 和 {D(v)}v∈[V ] 生成的亲和力矩阵将用作谱聚类方法的输入,以生成最终的聚类结果。

自表示属性是使用多种类型的特征构建的,自表示矩阵由所有视图共享的一致表示和特定于视图的表示组成。基于一致和特定表示的亲和力矩阵被作为谱聚类的输入(Ng、Jordan 和 Weiss 2002)以生成最终的聚类结果。此外,结果表明,所提出方法的复杂性仅与视图数量和数据维度成线性关系,并且与数据样本数量成立方关系。这项工作的主要贡献是:

• 本文提出了一种新颖的子空间表示学习方法一致且特定的多视图子空间聚类(CSMSC),该方法同时学习用于多视图子空间聚类的视图一致表示和一组特定于视图的表示。 %% 有没有可能有多组张量?

• 我们引入了非凸优化问题,并提出了凸松弛交替优化算法来恢复相应的子空间表示,提供了一些进一步实用的平滑收敛。

• 对基准数据集的大量实验表明,我们的模型优于多种基线方法和最先进的方法。

“Related Work” 相关工作

在本节中,我们回顾相关的子空间聚类方法,这些方法从数据中寻找子空间结构,并对学习到的自表示矩阵进行聚类。

单视图子空间聚类方法的许多进步受到了启发,并且各种方法从特征空间提取信息的方式有所不同。

对于重建项,Frobenius 范数对噪声进行建模(Cand` es and Plan 2010),l0 范数描述随机损坏(Cand` es et al. 2011),l2 范数处理样本特定的损坏和异常值(Liu、Lin 和 Yu 2010) )。鲁棒形状交互(Wei and Lin 2011)假设理想情况下数据是干净的。

对于自我表示项,核范数追求低秩恢复(Liu et al. 2013),l0范数在最广泛的数据假设下获得稀疏表示(Yang et al. 2016)。

对于多视图重建误差项,多视图完整空间学习(Xu,Tao,and Xu 2015)采用柯西估计量作为误差测量,以增强异常值的鲁棒性。

对于单视图方法,稀疏子空间聚类(Elhamifar and Vidal 2013)从数据子空间中找到稀疏表示,而低秩表示(Liu et al. 2013)通过低秩表示探索子空间结构以恢复数据。此外,多子空间表示(Luo et al. 2011)同时发现子空间的数量、每个子空间的维度以及每个子空间中的样本。此外,最小二乘回归(Lu et al. 2012)发现了具有连通性的数据的底层子空间分割。

此外,基于各种理论,人们设计了许多多视图聚类方法来挖掘视图之间的内在信息。例如,共同正则化多视图谱聚类(Kumar、Rai 和 Daum ́ e 2011)在不同视图上进行聚类,并通过假设各个视图通常承认相同的基础数据聚类来进行共同正则化约束。协同训练 SPC(Kumar 和 Daum e 2011)假设底层聚类会将数据样本协同训练到同一集群,而不管视图如何。低秩张量约束多视图子空间聚类(Zhang et al. 2015)捕获多视图数据的高阶相关性。多样性引起的多视图子空间聚类(Cao et al. 2015)使用多样性术语探索多视图特征之间的互补信息。 Min-Disagreement (De Sa 2005) 使用基于谱聚类算法的二分图最小化不同观点的分歧。多视图潜在表示(Zhang et al. 2017)基于每个视图都源自一个潜在潜在表示的假设。深度非负矩阵矩阵分解(Zhao、Ding 和 Fu 2017)构建深层结构以寻求具有更一致知识的共同特征表示以促进聚类。

“The Proposed Approach” 提议的方法

在本节中,我们提出了一种新颖的多视图学习算法,该算法有效地处理子空间聚类,并能够在自我表示时分离一致性和特异性属性。

“Subspace Clustering” 子空间聚类

给定从多个子空间抽取的数据 X ∈ Rd×N,其中 N 是样本数,d 表示数据的维度。自表示是指每个数据样本由同一子空间中其他样本的线性组合来表示。自表示性质可以表示为

其中 Z ∈ RN×N 是学习到的自表示矩阵,E ∈ Rd×N 是误差项。

基于自表示的子空间聚类的目标函数通常具有以下形式

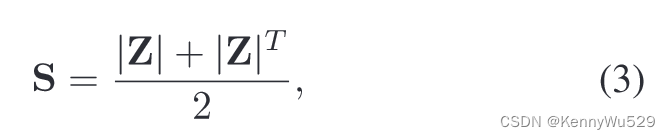

其中Ω(·)和Φ(·)表示某些正则化策略,而λ>0是平衡这两个正则化器的参数。得到自表示矩阵 Z 后,亲和力矩阵 S ∈ RN×N 通常构造为

其中 |·| 是绝对运算符。因此,最终的聚类结果是由基于亲和力矩阵的谱聚类算法(Ng, Jordan, and Weiss 2002)生成的。

“Formulation” 公式

令 X(v) ∈ Rdv×N 表示第 v 个视图对应的特征矩阵,dv 表示第 v 个视图中数据的维度,v ∈ [V ],其中 [V ] 代表 {1, 2 , ..., V }。定义 Z(v) ∈ RN×N 每个视图中学习的子空间表示,E(v) ∈ Rdv×N 自我表示的误差项。如果我们只考虑所有视图的一致性项,多视图自表示公式可以写为 %% 基础公式起手

除了方程(4)中包含的一致性项之外,我们认为方程(4)中的 E(v)不应简单地视为残差,它确实包含了各个观点的内在差异。此外,虽然在等式 (4)中考虑了所有视图中保持不变的共同表示,没有考虑每个视图中独特的部分,仅仅利用这一小部分进行数据建模显然是不够或准确的。

我们认为

其中C,D(v) ∈ RN×N分别是在不同视图下的数据学习到的一致且特定的自我表示矩阵。我们将 X(v) = X(v)Z(v) + E(v) 中的普通多视图表示矩阵 Z(v) 分解为共享表示的总和,该共享表示对不同视图上保持不变的部分以及对应于第 v 个视图的唯一部分的视图特定表示进行编码。1

1 节一致性和特异性消融研究通过数值验证,仅考虑或不考虑一致性项会丢失许多重要信息,效果不佳。

由于这些限制,我们施加一些正则化来惩罚一致矩阵和特定于视图的矩阵。对于一致项,我们选择核范数来保证低秩属性,以挖掘不同视图之间更多的共享信息。此外,核范数也阻止了平凡的解决方案。此外,我们对特定项应用l2范数以确保连通性,因此表示矩阵通常是稠密的,这减轻了连通性问题(Lu et al. 2012)。最后,我们可以追求所有观点上最兼容的结构。因此,正则项的形式为

其中 ‖·‖* 表示核范数, ‖·‖2 为 l2 范数, λC ,λD ∈ (0, 1] 为权衡参数。

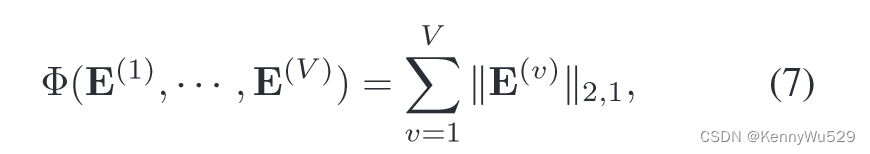

此外,现实世界的数据集通常包含许多噪声信息,因此我们引入误差项来处理噪声数据。与(Liu et al. 2013;Zhang et al. 2015)类似,我们将误差项表示为

其中 ‖·‖2,1 表示 l2,1 范数,它促使 E(V ) 的列为零。

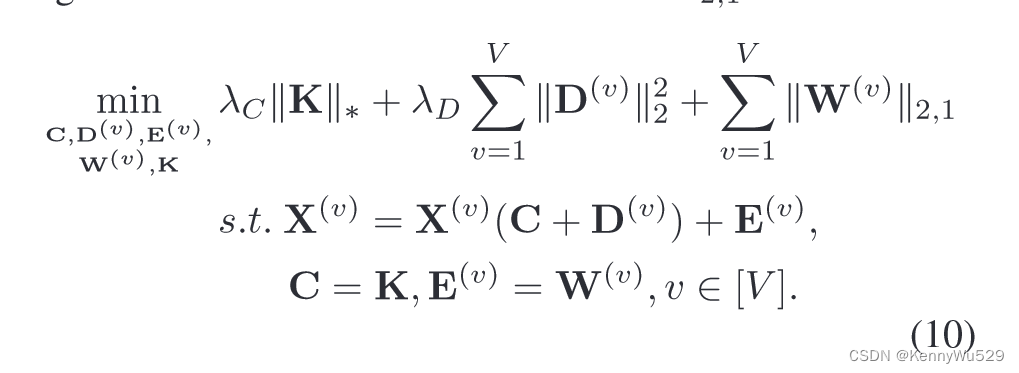

因此,将上面讨论的所有条件组合在一起就可以得到所提出方法的目标函数:

因此,通过多视图特征求解方程 (8),可以提取一致的、一系列特定的表示,使数据表示更加自然。

因此,通过多视图特征求解方程 (8),可以提取一致的、一系列特定的表示,使数据表示更加自然。

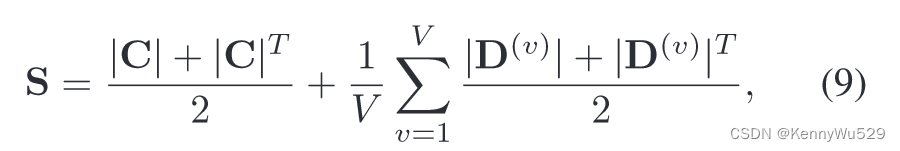

利用学习到的表示,我们构建了关于一致性和特异性的亲和力矩阵

然后将谱聚类算法应用于亲和力矩阵以追求最终的聚类结果。

“Optimization” 优化

我们的目标函数方程(8)同时从多个视图中学习一致且具体的表示。然而,直接找到问题(8)的最优解是极其困难的。因此,我们利用凸松弛并开发交替优化算法来共同恢复相应的数据表示。首先,我们引入变量 K, W(v) ∈ RN×N 作为核范数中的 C 和 l2,1 范数中的 E(v) 的代理:

这个问题可以通过增广拉格朗日乘子 (ALM) (Lin, Chen, and Ma 2010) 方法来解决,该方法最小化以下形式的增广拉格朗日函数:

其中<·,·>是两个矩阵的标准欧几里得内积,‖·‖F表示福贝尼乌斯范数,{Y1(v) , Y3(v) }v∈[V], Y2是拉格朗日乘数,μ> 0 是惩罚参数。

为了解决这个问题,我们将上述无约束问题分为六个子问题,并通过固定其他变量来优化它们。

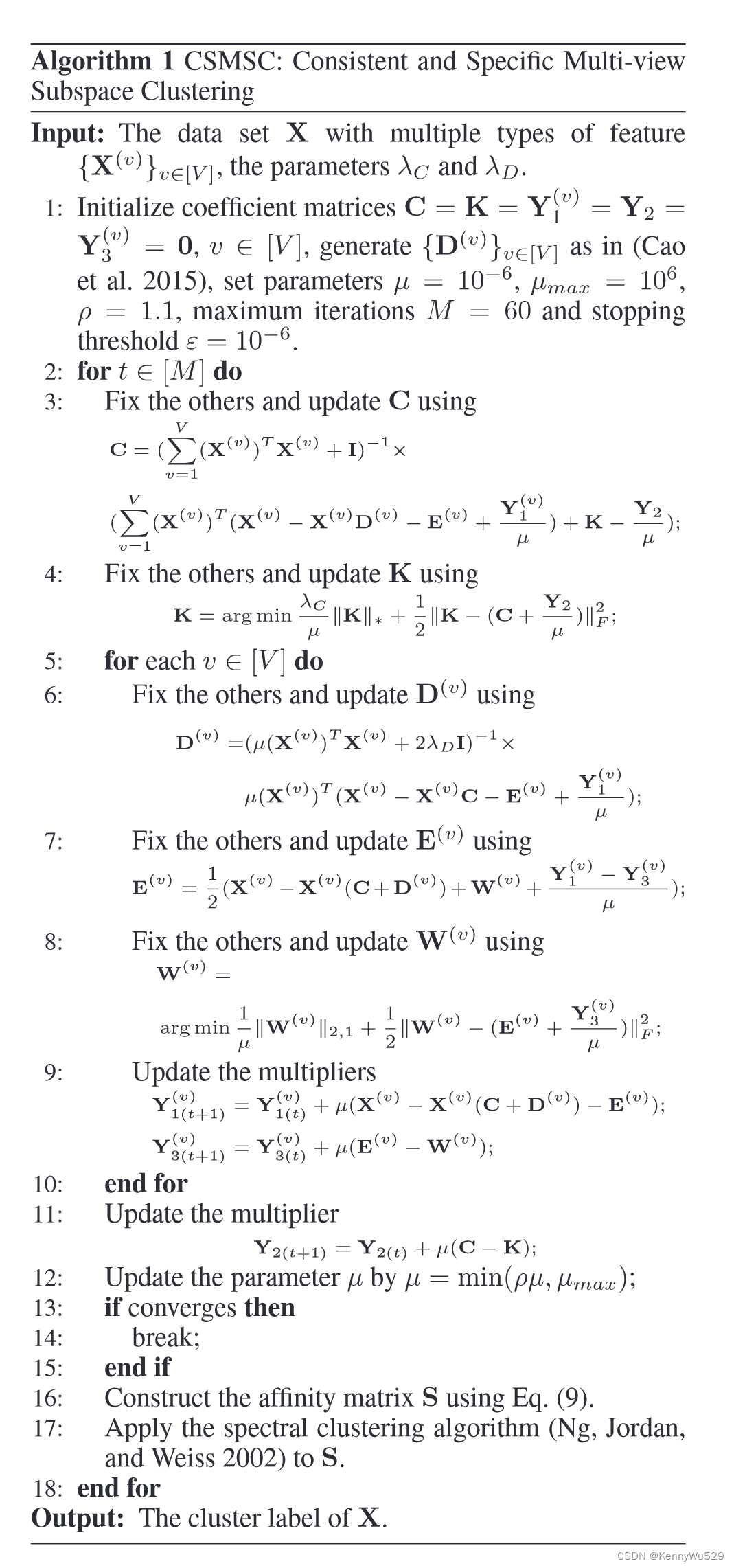

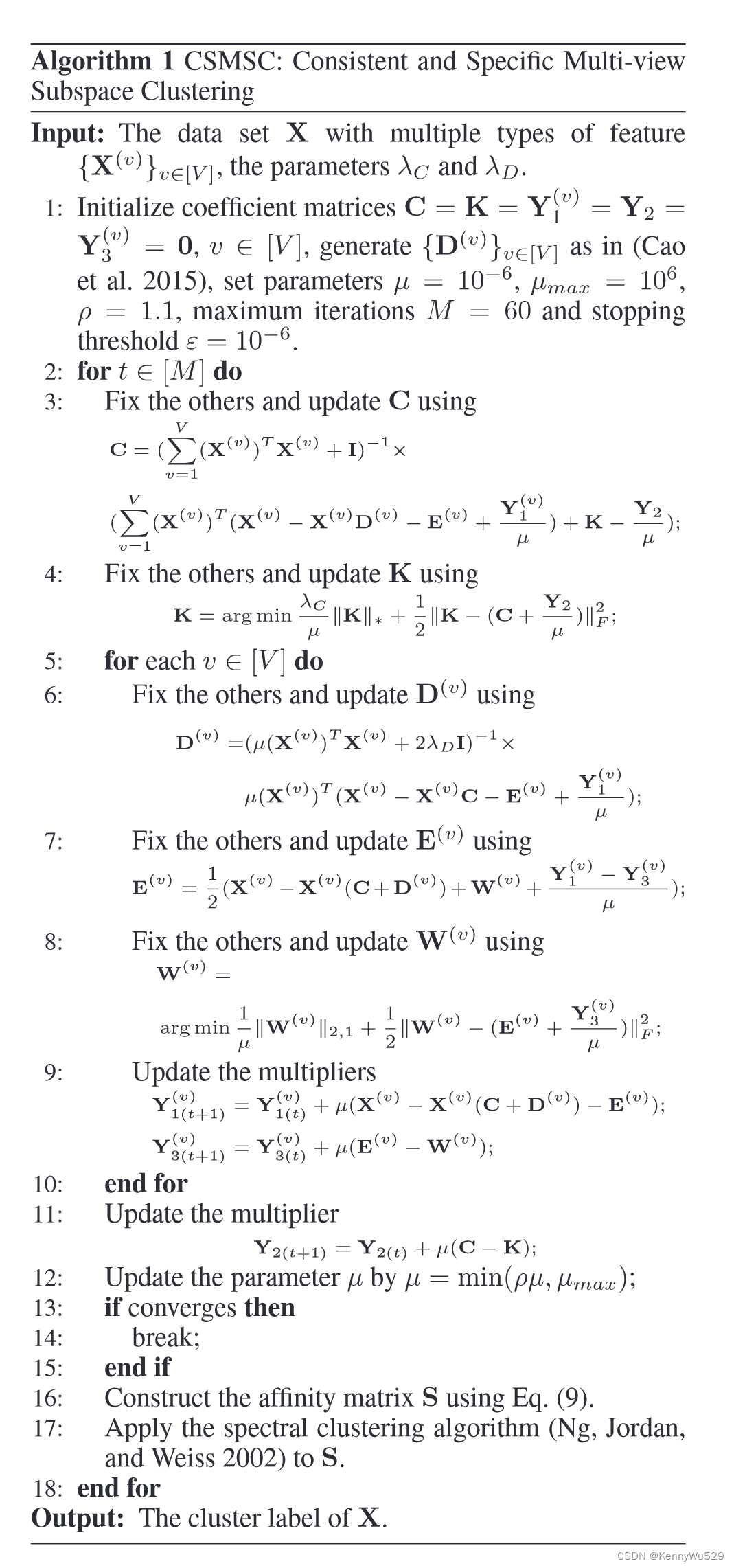

算法 1 中描述的过程解决了问题 (8)。

算法1 CSMSC:Consistent and Specific Multi-View Subspace Clustering

输入:具有多种类型特征{X(v)}v∈[V]的数据集X,参数λC和λD

1.初始化系数矩阵C=K=Y1(v) = Y2 = Y3(v) =0,v∈[V],如(Cao等人.2015)中所示生成{D(v)}v∈[V],设置参数μ = 10-6,μmax = 106,ρ = 1.1,最大迭代次数 M = 60 和停止阈值 ε = 10-6

2.for t∈[M] do

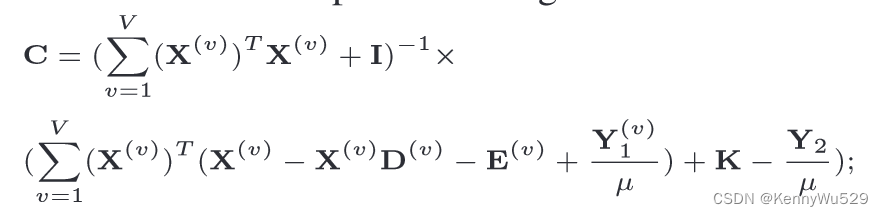

3.固定其他并使用

更新C

4.固定其他并使用

更新K

5.for 每个v∈[V] do

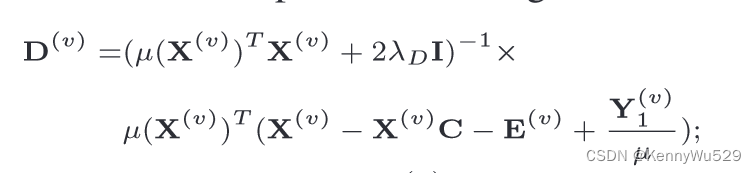

6.固定其他并使用

更新D(v)

7.固定其他并使用

更新E(v)

8.固定其他并使用

更新W(v)

9.更新乘数

10.end for

11.更新乘数

12.通过μ = min(ρμ,μmax)更新参数μ

13.if 收敛则

14.break

15.end if

16.使用方程(9)构建亲和矩阵S

17.对S使用谱聚类算法(Ng,Jordan,and Weiss 2002)

18.end for

输出:X的聚类标签

请注意,由于奇异值收缩算子(Cai、Cand` es 和 Shen 2010),步骤 4 具有封闭式解,并且步骤 8 可以通过(Liu 等人,2013)中的引理 4.1 有效求解。优化的详细过程可以在补充材料中找到。

“Analysis” 分析

“Convergence analysis.” 收敛性分析。

当目标函数平滑时,精确 ALM 方法的收敛性在(Bertsekas 2014)中得到了很好的研究。最多两个待定矩阵的不精确 ALM 方法的收敛性也已被证明(Lin,Chen 和 Ma 2010)。不幸的是,确保具有三个或更多待定矩阵的不精确 ALM 方法的收敛仍然很困难。由于我们的方法有 3V +2 待定矩阵和目标函数 Eq.式(11)并不平滑,因此收敛性很难在理论上证明。由于每次迭代中产生的间隙是单调递减的,如性能评估部分所示,该方法的有效性可以在一定程度上通过拉格朗日函数的凸性来保证(Eckstein and Bertsekas 1992)。因此,可以预期所提出的方法具有良好的收敛特性。值得一提的是,为了保证收敛,μ应该以算法1中的步骤12为上限。这是源自传统的交替方向法理论(Lin,Chen,and Ma 2010)。

“Complexity analysis.” 复杂性分析。

我们的算法由3V +2个子问题组成,子问题的复杂度分析如下。

由矩阵求逆和核范数导出的更新C、D(v)和K的复杂度是O(N3),其中N是数据样本的数量。更新 E(v) 和 W(v) 的复杂度为 O(dN ),其中 d 是所有视图的数据最大维度。总体而言,每次迭代的复杂度为 O((V +2)N3 + 2VdN),其中 V 是视图数。考虑到迭代次数,算法1的复杂度为

其中 M 是迭代次数。

“Experimental Results” 实验结果

在本节中,我们在三个广泛使用的人脸数据集(具有三个视图)和一个众所周知的文档数据集(具有两个视图)上广泛评估所提出方法的聚类特性。 CSMSC 的性能在六个评估指标方面与六种最先进的子空间聚类方法和两种基线方法进行了比较。

我们的评估采用了四个基准数据集。

Yale 是一个广泛使用的人脸数据集,包含 165 张灰度图像,15 个个体,每个类别 11 张图像。数据的变化包括中心光、戴眼镜、快乐、左光、不戴眼镜、正常、右光、悲伤、困倦、惊讶和眨眼。

Notting-Hill 视频人脸数据集(Zhang et al. 2009)源自电影 Notting-Hill。收集了 5 个主要演员的面孔,包括 76 首曲目的 4,660 个面孔。我们对每个演员随机抽取 110 张图像。

ORL 人脸数据集包含 40 个不同主题的 400 张图像。对于每个类别,图像是在不同的时间、灯光、面部表情(睁眼/闭眼、微笑与否)和面部细节(戴眼镜/不戴眼镜)拍摄的。

BBCSport(Xia 等,2014)包含来自 BBC Sport 网站的 2004-2005 年五个主题领域体育新闻文章的 544 份文档。

跟随(Zhang et al. 2015),对于人脸数据集,我们将图像大小调整为 48 × 48 并提取三种类型的特征:View1 强度(4,096 维)、View2 LBP(Ojala、Pietikainen 和 Maenpaa 2002)(3,304 维)和 View3 Gabor(Lades 等人,1993)(6,750 维)。标准 LBP 特征是从 72 × 80 松散裁剪的图像中提取的,直方图大小为 59,超过 910 个像素块。 Gabor 特征是在四个方向 θ = {0°, 45°, 90°, 135°} 处以一个尺度 λ = 4 提取的,并以 25 × 30 像素的分辨率进行松散的面部裁剪。 BBCSport 数据集只有两个视图,分别为 View1:3,183 维和 View2:3,203 维。除强度外的所有描述符都按比例缩放以具有单位范数。

“Compared Methods and Evaluation Metrics” 比较方法和评估指标

为了评估 CSMSC 的性能,我们将我们的方法与单视图方法 LRR (Liu et al. 2013) 和一系列最先进的多视图方法进行比较。 LRRbest (Liu et al. 2013) 是一种单视图算法。它寻求数据的最低等级表示,以将样本描述为具有最多信息量视图的线性组合。 LRRcon (Liu et al. 2013) 首先连接来自不同视图的数据,然后输入到传统的子空间聚类方法 LRR 中。 Co-Reg SPC(Kumar、Rai 和 Daum ́ e 2011)是一种成对多视图谱聚类方法,它共同规范聚类假设,以对跨视图的一致表示进行聚类。 RMSC(Xia 等人,2014)代表鲁棒多视图谱聚类方法。它恢复共享的低秩转移概率矩阵并使用马尔可夫链进行聚类。 LT-MSC(Zhang et al. 2015)表示低秩张量约束多视图子空间聚类。它捕获多视图数据中的高阶底层相关性。 DiMSC(Cao et al. 2015)代表了多样性引起的多视图子空间聚类,它通过强制多样性来探索不同视图之间的互补信息。

我们还与两个基线进行比较,这两个基线是所提出的 CSMSC 方法的特殊情况。 CMSC 表示一致的多视图子空间聚类,它使用一致部分作为自表示矩阵 Z,并且视图特定项 D(v) 被删除,如等式(4) 所示。 SMSC 代表特定多视图子空间聚类,它在每个视图上运行 LRR,如方程(1)所示,然后将这些自表示矩阵 Z(v) 加在一起作为矩阵 Z。两个基线的亲和力矩阵按照式 (3)构造。

“Experimental Setup” 实验装置

在我们的实验中,我们在 (0,1] 范围内调整参数 λC 和 λD 并报告最佳性能结果。我们运行每个实验 30 次并报告平均分数和标准差。对于所有比较的方法,我们有将参数调整到最佳。

“Performance Evaluation” 表现评估

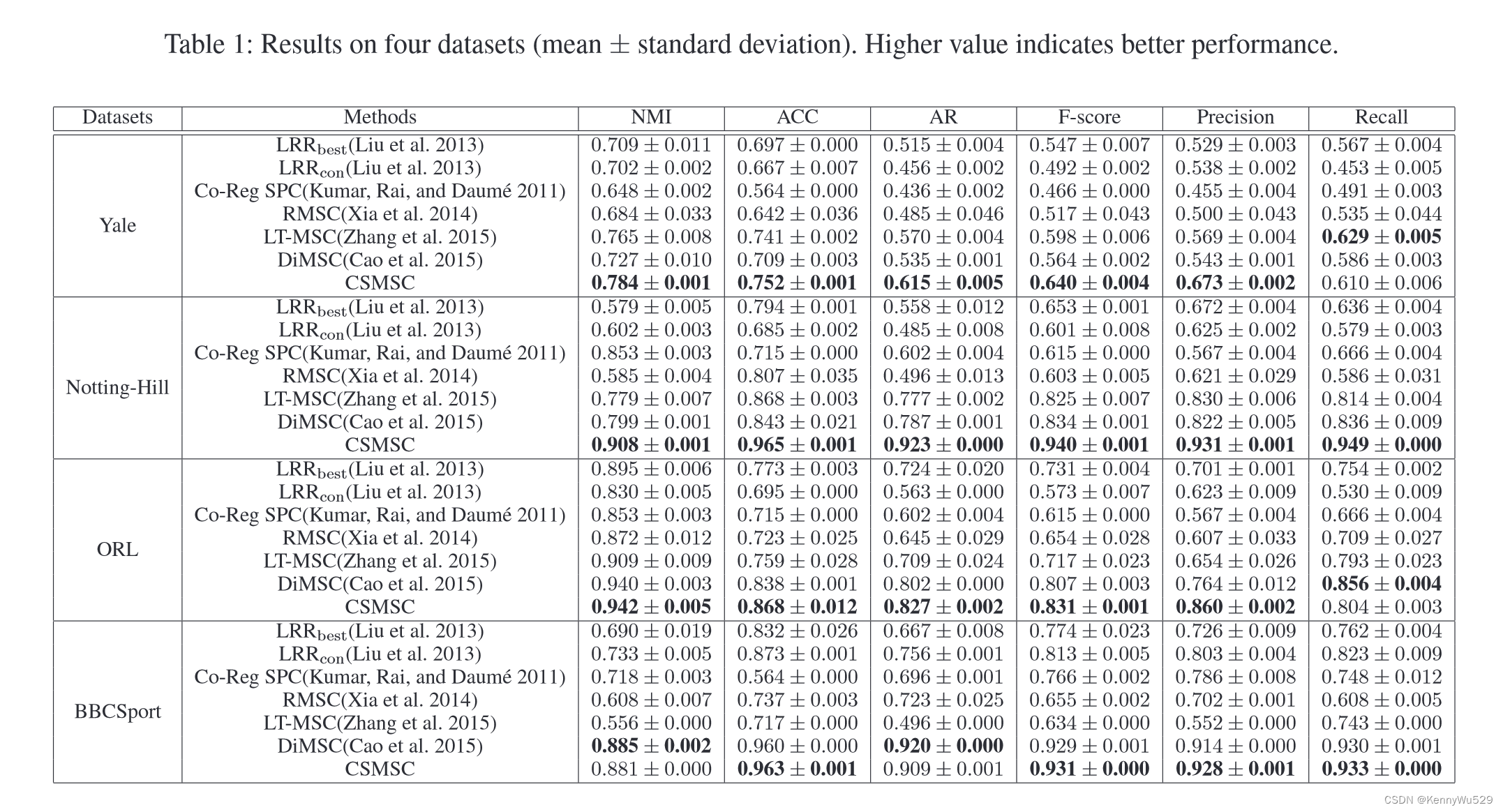

四个数据集的实验结果如表1所示。

如图所示,多视图方法大多优于单视图方法,这证明了提取多视图信息进行聚类的必要性。我们提出的方法在 Yale、Notting-Hill 和 ORL 数据集上显着优于其他方法,并且在 BBCSport 数据集上显示出非常有竞争力的性能。在 NottingHill 上,我们的方法在 NMI、ACC、AR、F-score、Precision 和 Recall 方面分别比第二好的方法获得了约 10.9%、12.2%、13.6%、10.6%、10.9% 和 11.3% 的大幅改进。另一个吸引人的地方是我们的方法比 LRRcon 的基线表现要好得多,LRRcon 简单地将所有特征连接在一起,然后对新特征执行 LRR。这证明了所提出的多视图子空间聚类技术的有效性。请注意,LRRcon 在 Yale 和 ORL 数据集上的表现甚至比 LRRbest 还要差,这从数值上证明了简单地组合所有特征并不是一个好的选择。我们进一步在补充材料中的四个数据集上展示了 LRRcon 和 CSMSC 生成的可视化亲和力矩阵。

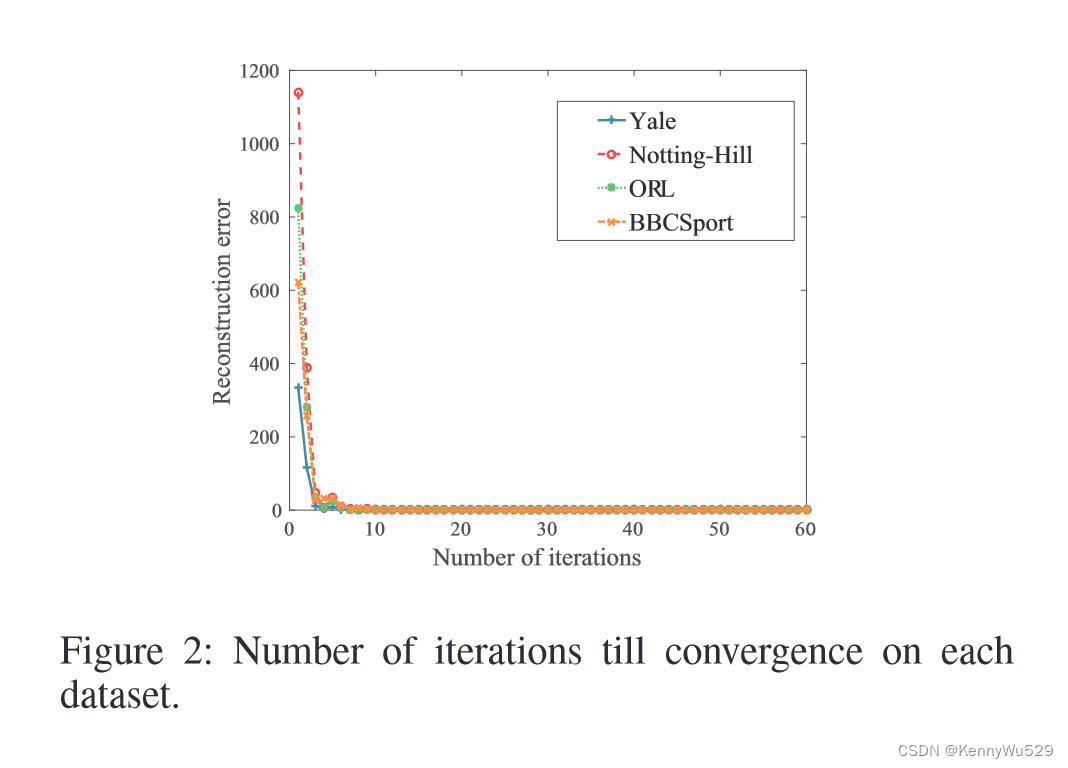

此外,我们研究了我们方法的停止标准。图 2 绘制了所有四个数据集上的重建误差(纵轴)与迭代次数(横轴)的关系。

图2:在每个数据集上的迭代直到收敛的次数

如图所示,误差在开始时迅速下降,然后保持稳定。在大多数数据集上,CSMSC 仅在少量迭代内收敛2。这一结果进一步实证证实了我们在章节Analysis 中的收敛性分析。

2在我们的实验中,我们发现 20 次迭代通常适用于确保良好的结果。

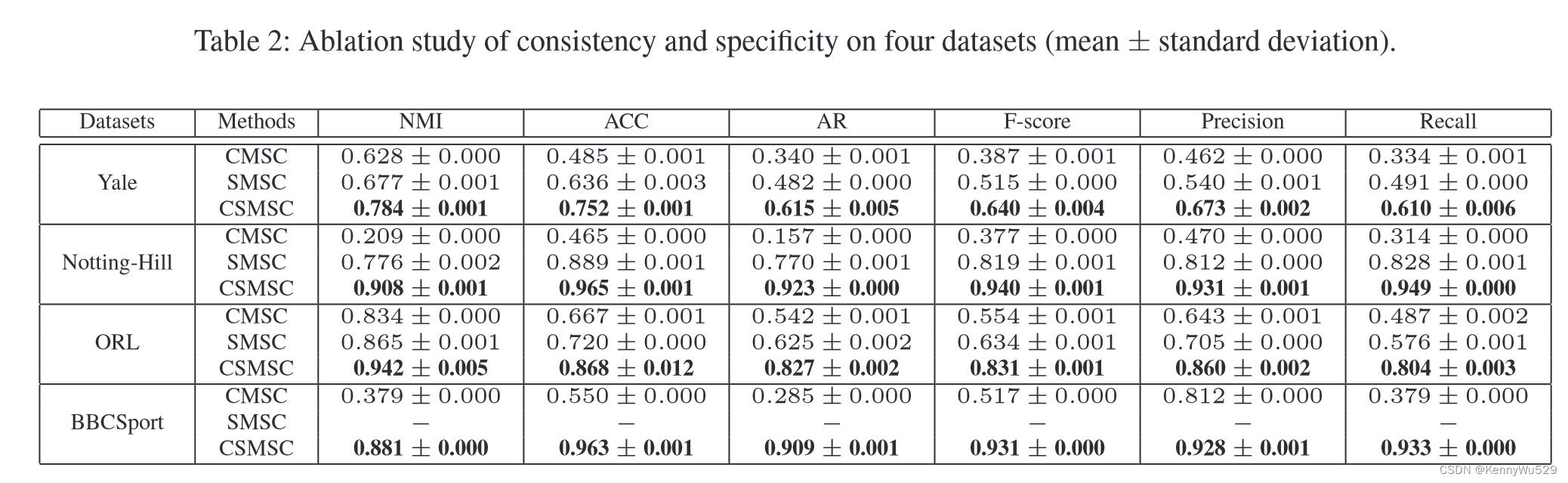

“Ablation Study on Consistency and Specificity” 一致性和特异性的消融研究

通过与仅考虑一致性的 CMSC 和不考虑一致性部分的 SMSC 进行比较,我们进一步分析了所提出的 CSMSC 的改进。四个数据集的实验结果如表2所示。

请注意,BBCSport数据集的特征太稀疏,无法运行SVD,因此我们无法在BBCSport上执行LRR。据观察,我们的 CSMSC 在四个数据集上明显优于 CMSC,因此从数字上表明,考虑每个视图的特定于视图的项是有优点的。此外,我们提出的方法比 SMSC 表现更好,因此声明将一致表示与所有视图的表示分离可以提高性能。这两个基线没有详尽地发现不同视图的底层子空间结构,并且通常会导致较差的聚类性能。总之,所提出的方法有效地结合了与多视图数据相关的一致性和特异性,因此优于仅考虑任一一项的基线。

“Single View versus Multiple Views” 单视图与多视图

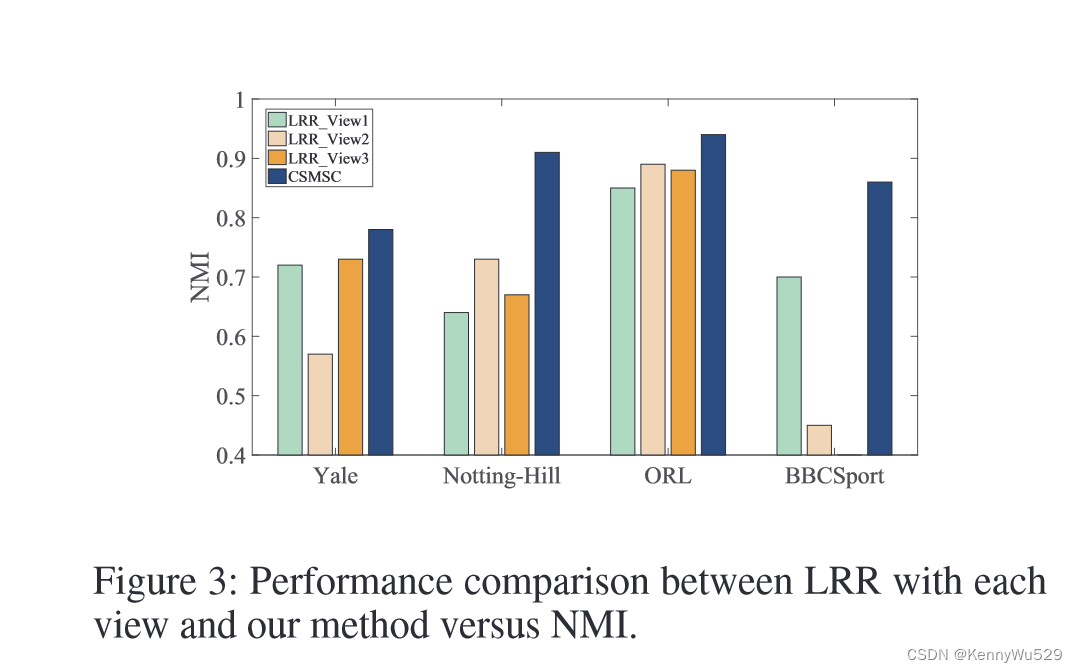

在本节中,我们将多视图方法 CSMSC 与相应的单视图方法 LRR 进行比较。图 3 显示了不同配置的详细结果。

图三:表现比较在每个视图上的LRR和我们的方法比较 NMI

请注意,BBCSport 数据集只有两个条形图用于两个不同的视图。从图 3 中,我们得到以下观察结果。首先,正如我们之前提到的,多视图通常比单视图更稳健并且性能更好,因为考虑了更多的信息视角。事实上,CSMSC确实有效地将来自不同观点的信息与一致且特定的约束结合起来,展示了我们提出的方法的优势。其次,一种视图在某些数据集中表现出色,但在其他数据集中可能无法获胜。例如,View2 在 Notting-Hill 和 ORL 上表现最好,但在 Yale 上表现最差。 View3 是 Yale 上的最佳视图,但在 Notting-Hill 和 ORL 上表现较差。因此,为所有数据集固定特定视图是不可靠的,并且很难选择最佳视图,因为最佳视图因数据集而异。总之,多视图方法比单视图方法具有明显的优势。

为了进一步研究所提出方法的改进,我们分别对每个单视图进行LRR,对多视图进行CSMSC。 LRR和CSMSC中的参数设置为0.05。根据表3,多视图的聚类性能通常优于每个单视图的聚类性能,这从经验上证明多视图的聚类比单视图的聚类更稳健。此外,当视图数量增加时,性能通常会提高。请注意,与表1中的LRRbest相比,表3中的View1、View2和View3要差得多,这说明LRR对该参数极其敏感。

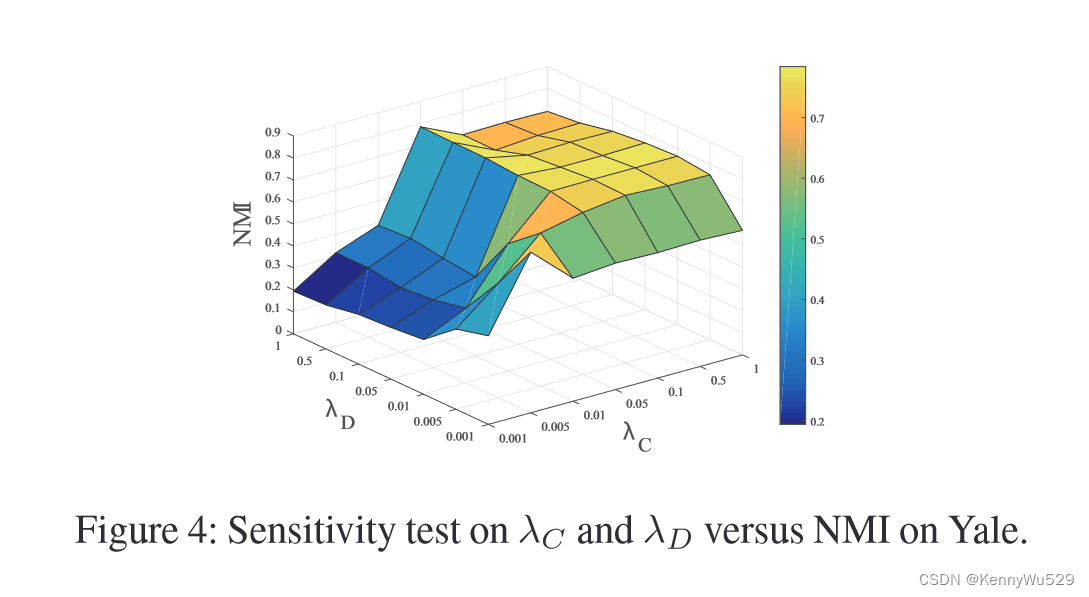

“Parameter Sensitivity” 参数灵敏度

在本节中,我们对参数 λC 和 λD 从 0.001 到 1 进行敏感性测试。图 4 显示了不同参数值对耶鲁数据集 NMI 的影响。

图4:λC和λD对耶鲁数据集 NMI 的敏感度测试

可以看出,当λC或λD接近于零时,性能急剧下降,这与一致性和特异性的消融研究部分一致。此外,当 λC 和 λD 变大时,我们的方法表现得更加稳定。

“Conclusion” 结论

在本文中,我们介绍了一种新的多视图设置下子空间聚类的子空间表示学习方法。所提出的方法称为一致且特定的多视图子空间聚类,使用一致的表示和一组特定的表示来制定自我表示属性,这更好地适合现实世界的数据集。我们引入非凸优化问题并开发凸松弛优化算法来恢复相应的数据表示,这提供了一些进一步实用的平滑收敛。我们的方法的性能在四个数据集上进行了定量评估,这表明我们的方法优于多视图子空间聚类的基线方法和最先进的方法。

总结

key point:作者主要提出了对多视图间一致性的自表示矩阵Z分解为C+D,其中C表示多视图一致性部分,D表示每个视图特定的部分,从而实现对多视图一致性和特异性的联合。

其他推导过程见上文,个人觉得与其他方法差别不大,很好看懂。

具体计算如下图,图中有看不懂的地方见上文:

补充:关于本文还可以去看一下补充材料和跑代码,也是本人下一步要干的事。

833

833

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?