一、初识

MNIST数据集是从NIST的Special Database 3(SD-3)和Special Database 1(SD-1)构建而来。Yann LeCun等人从SD-1和SD-3中各取一半数据作为MNIST训练集和测试集,其中训练集来自250位不同的标注员,且训练集和测试集的标注员完全不同。

MNIST数据集的发布,吸引了大量科学家训练模型。1998年,LeCun分别用单层线性分类器、多层感知器(Multilayer Perceptron, MLP)和多层卷积神经网络LeNet进行实验,使得测试集的误差不断下降(从12%下降到0.7%)。在研究过程中,LeCun提出了卷积神经网络(Convolutional Neural Network,CNN),大幅度地提高了手写字符的识别能力,也因此成为了深度学习领域的奠基人之一。

如今在深度学习领域,卷积神经网络占据了至关重要的地位,从最早LeCun提出的简单LeNet,到如今ImageNet大赛上的优胜模型VGGNet、GoogLeNet、ResNet等,人们在图像分类领域,利用卷积神经网络得到了一系列惊人的结果。

MNIST数据集在深度学习领域的地位就相当与Hello World在编程界的地位一样。

- 任务输入:一系列手写数字图片,其中每张图片都是28x28的像素矩阵。

- 任务输出:经过了大小归一化和居中处理,输出对应的0~9的数字标签。

二、学习路线

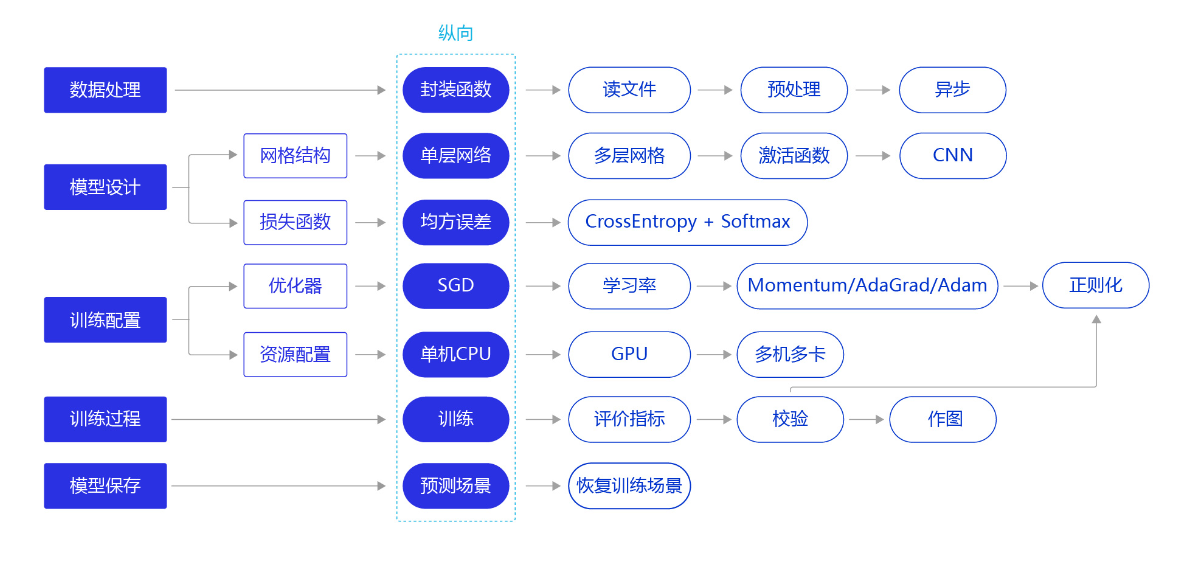

paddlepaddle采用的“横纵式”教学法,本教程中,对于每一个案例,会以先纵后横的方式来学习,即先学习一个最简单的完整流程,再逐个环节优化,以达到最优训练效果。如下图所示:

例如,我们先实现一个完整的流程,第一遍可能用的网络结构是最简单的单层网络,最终效果也不是很好,但是可以成功运行得出结果。第二遍就可以优化网络结构了。

手写数字识别模型

1.1 数据处理

桨提供了多个封装好的数据集API,涵盖计算机视觉、自然语言处理、推荐系统等多个领域,帮助读者快速完成深度学习任务。如在手写数字识别任务中,通过paddle.vision.datasets.MNIST可以直接获取处理好的MNIST训练集、测试集,飞桨API支持如下常见的学术数据集:

| mnist | cifar | Conll05 |

| imdb | imikolov | movielens |

| sentiment | uci_housing | wmt14 |

| wmt16 |

通过paddle.vision.datasets.MNIST API设置数据读取器,代码如下所示。

# 设置数据读取器,API自动读取MNIST数据训练集

train_dataset = paddle.vision.datasets.MNIST(mode='train')

2.1 模型设计

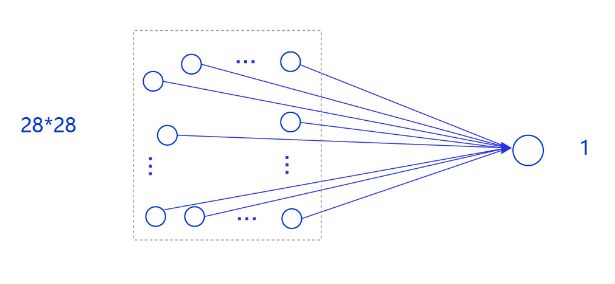

在手写数字识别中,我们使用单层网络。模型的输入为784维(28×28)数据,输出为1维数据。

说明:

事实上,采用只有一层的简单网络(对输入求加权和)时并没有处理位置关系信息,因此可以猜测出此模型的预测效果可能有限。在后续优化环节介绍的卷积神经网络则更好的考虑了这种位置关系信息,模型的预测效果也会有显著提升。

下面以类的方式组建手写数字识别的网络,实现方法如下所示。

# 定义mnist数据识别网络结构,同房价预测网络

class MNIST(paddle.nn.Layer):

def __init__(self):

super(MNIST, self).__init__()

# 定义一层全连接层,输出维度是1

self.fc = paddle.nn.Linear(in_features=784, out_features=1)

# 定义网络结构的前向计算过程

def forward(self, inputs):

outputs = self.fc(inputs)

return outputs

3.1 训练配置

训练配置需要先生成模型实例(设为“训练”状态),再设置优化算法和学习率(使用随机梯度下降SGD,学习率设置为0.001),实现方法如下所示。

# 声明网络结构

model = MNIST()

def train(model):

# 启动训练模式

model.train()

# 加载训练集 batch_size 设为 16

train_loader = paddle.io.DataLoader(paddle.vision.datasets.MNIST(mode='train'),

batch_size=16,

shuffle=True)

# 定义优化器,使用随机梯度下降SGD优化器,学习率设置为0.001

opt = paddle.optimizer.SGD(learning_rate=0.001, parameters=model.parameters())

4.1 训练过程

训练过程采用二层循环嵌套方式,训练完成后需要保存模型参数,以便后续使用。

- 内层循环:负责整个数据集的一次遍历,遍历数据集采用分批次(batch)方式。

- 外层循环:定义遍历数据集的次数,本次训练中外层循环10次,通过参数EPOCH_NUM设置。

# 图像归一化函数,将数据范围为[0, 255]的图像归一化到[0, 1]

def norm_img(img):

# 验证传入数据格式是否正确,img的shape为[batch_size, 28, 28]

assert len(img.shape) == 3

batch_size, img_h, img_w = img.shape[0], img.shape[1], img.shape[2]

# 归一化图像数据

img = img / 255

# 将图像形式reshape为[batch_size, 784]

img = paddle.reshape(img, [batch_size, img_h*img_w])

return img

import paddle

# 确保从paddle.vision.datasets.MNIST中加载的图像数据是np.ndarray类型

paddle.vision.set_image_backend('cv2')

# 声明网络结构

model = MNIST()

def train(model):

# 启动训练模式

model.train()

# 加载训练集 batch_size 设为 16

train_loader = paddle.io.DataLoader(paddle.vision.datasets.MNIST(mode='train'),

batch_size=16,

shuffle=True)

# 定义优化器,使用随机梯度下降SGD优化器,学习率设置为0.001

opt = paddle.optimizer.SGD(learning_rate=0.001, parameters=model.parameters())

EPOCH_NUM = 10

for epoch in range(EPOCH_NUM):

for batch_id, data in enumerate(train_loader()):

images = norm_img(data[0]).astype('float32')

labels = data[1].astype('float32')

#前向计算的过程

predicts = model(images)

# 计算损失

# import paddle.nn.functional as F

loss = F.square_error_cost(predicts, labels)

avg_loss = paddle.mean(loss)

#每训练了1000批次的数据,打印下当前Loss的情况

if batch_id % 1000 == 0:

print("epoch_id: {}, batch_id: {}, loss is: {}".format(epoch, batch_id, avg_loss.numpy()))

#后向传播,更新参数的过程

avg_loss.backward()

opt.step()

opt.clear_grad()

train(model)

paddle.save(model.state_dict(), './mnist.pdparams') #模型保存地址

从训练过程中损失所发生的变化可以发现,虽然损失整体上在降低,但到训练的最后一轮,损失函数值依然较高。可以猜测手写数字识别完全复用房价预测的代码,训练效果并不好。接下来我们通过模型测试,获取模型训练的真实效果。

4.1.1 模型测试

模型测试的主要目的是验证训练好的模型是否能正确识别出数字,包括如下四步:

- 声明实例

- 加载模型:加载训练过程中保存的模型参数,

- 灌入数据:将测试样本传入模型,模型的状态设置为校验状态(eval),显式告诉框架我们接下来只会使用前向计算的流程,不会计算梯度和梯度反向传播。

- 获取预测结果,取整后作为预测标签输出。

在模型测试之前,需要先读取样例图片,并进行归一化处理。

# 读取一张本地的样例图片,转变成模型输入的格式

def load_image(img_path):

# 从img_path中读取图像,并转为灰度图

im = Image.open(img_path).convert('L')

# print(np.array(im))

im = im.resize((28, 28), Image.ANTIALIAS)

im = np.array(im).reshape(1, -1).astype(np.float32)

# 图像归一化,保持和数据集的数据范围一致

im = 1 - im / 255

return im

# 定义预测过程

model = MNIST()

# 加载模型参数

params_file_path = 'mnist.pdparams'

param_dict = paddle.load(params_file_path)

model.load_dict(param_dict)

# 灌入数据

model.eval() #校验状态

img_path = './work/example_6.jpg'

tensor_img = load_image(img_path)

result = model(paddle.to_tensor(tensor_img))

print('result',result)

# 预测输出取整,即为预测的数字,打印结果

print("本次预测的数字是", result.numpy().astype('int32'))

完整代码地址如下:

https://aistudio.baidu.com/aistudio/projectdetail/3202547

三、作业 2-1:

- 使用飞桨API paddle.vision.datasets.MNIST的mode函数获得测试集数据,计算当前模型的准确率。

- 怎样进一步提高模型的准确率?可以在接下来内容开始前,写出你想到的优化思路。

作业答案参见:

https://aistudio.baidu.com/aistudio/projectdetail/3202547

700

700

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?