目录

4.GradientExplainer和treeexplainer对比

1.为什么要对模型进行解释

深度学习模型是一个黑盒模型,对于这个训练好的黑盒模型想要知道各种输入特征是如何影响模型的最终结果,为了达到这个目标就要对模型进行解释。

2.可解释模型——SHAP

2.1 SHAP是什么:

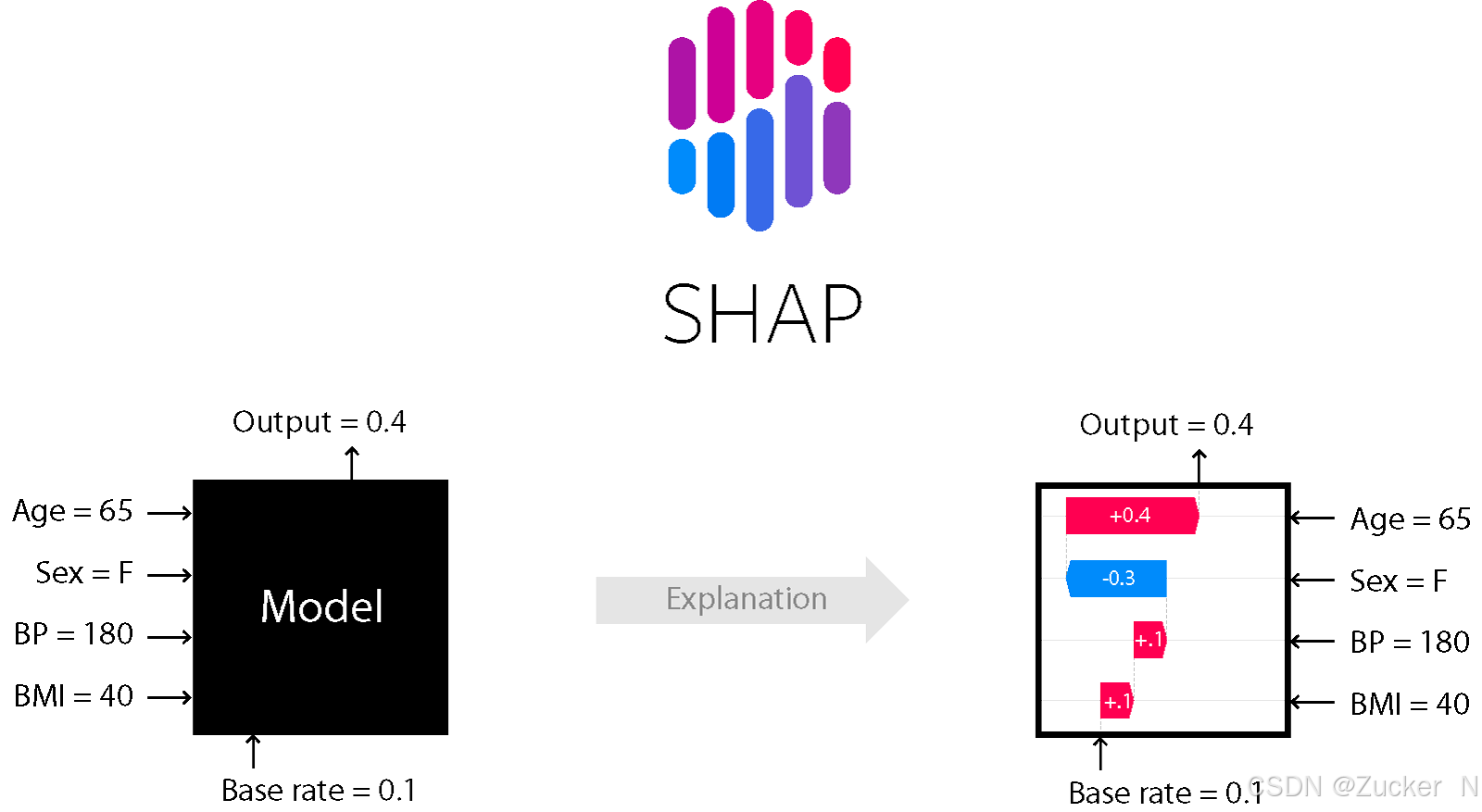

SHAP(SHapley Additive Explanations)是一种解释任何机器学习模型输出的博弈论方法。它将最优信用分配与使用博弈论及其相关扩展的经典Shapley值的局部解释联系起来。

SHAP 属于模型事后解释的方法,它的核心思想是计算特征对模型输出的边际贡献,再从全局和局部两个层面对“黑盒模型”进行解释。

2.2 为什么要用shap:

SHAP构建一个加性的解释模型,所有的特征都视为“贡献者”。对于每个预测样本,模型都产生一个预测值,SHAP value就是该样本中每个特征所分配到的数值。

基本思想:计算一个特征加入到模型时的边际贡献,然后考虑到该特征在所有的特征序列的情况下不同的边际贡献,取均值,即某该特征的SHAPbaseline value。

(边际贡献:当增加的投入超过某一水平之后,新增的每一个单位投入换来的产出量会下降。)

3.SHAP模型中的GradientExplainer

3.1介绍

如何对二维图像数据进行解释?二维图像数据往往会有更多的信息,更复杂的特征,要想对一个处理二维图像信息的模型进行解释,这里要用到GradientExplainer。

GradientExplainer 是 SHAP 中用于深度学习模型(如神经网络)的一个解释工具,它的核心思想是使用 梯度反向传播 来估算每个输入特征对模型预测结果的贡献。

3.2举例

这里用图像分类模型进行举例,一个图像分类模型在训练的时候往往呈现多对一的形式,

用来训练的这些图片,模型主要关注的是图片中的那一部分呢?

比如模型识别出来这个是猫,在识别的时候是关注猫的颜色还是猫的尾巴,这里就要想办法对模型进行解释,就用到了“GradientExplainer”

3.3原理解释

通过计算模型输出对每个输入特征的 梯度,进而估算每个特征对预测结果的贡献。梯度反映了特征对模型输出变化的影响,梯度越大,特征的贡献越大。

4.GradientExplainer和treeexplainer对比

4.1适用性

GradientExplainer解释器主要基于 梯度 来计算 SHAP 值,因此特别适合处理连续输入和非树形结构的数据(如图像、文本等)。

TreeExplainer适用于树形模型,尤其是 决策树、随机森林、梯度提升树(如 XGBoost、LightGBM、CatBoost 等)。

4.2计算效率

GradientExplainer的计算效率不如 TreeExplainer,因为需要计算梯度,并且神经网络通常具有复杂的层和大量的参数,因此 GradientExplainer 计算 SHAP 值时可能需要更多的计算资源和时间。

5.总结

关于深度学习模型的研究,往往都是一个黑箱模型,为了进一步对模型进行解释,可以引入shap模型,对于二维图像数据的解释,GradientExplainer是个不错的选择。

本文介绍了GradientExplainer的解释原理,希望对你有所帮助。

3178

3178

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?