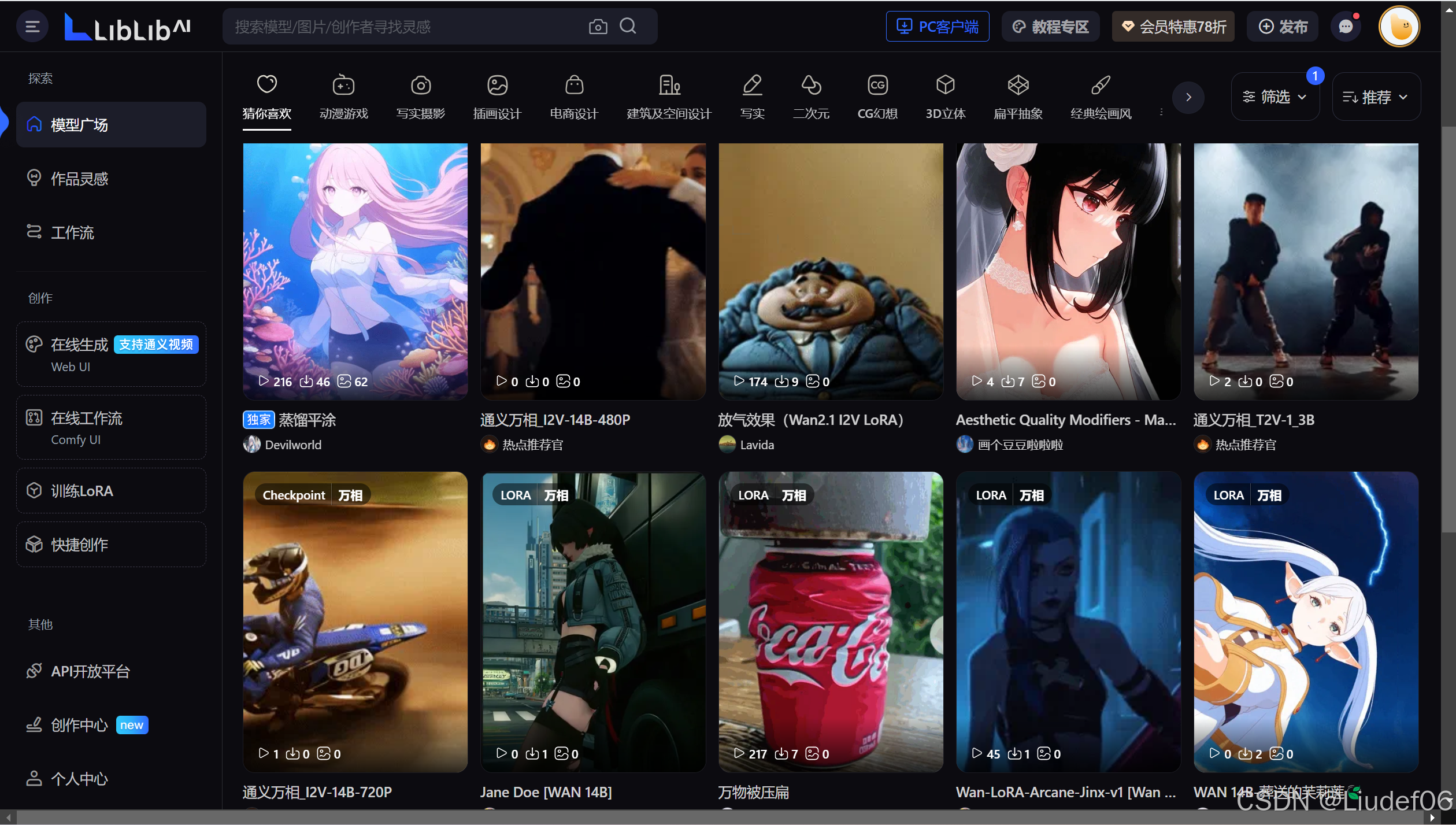

通义万相2.1:多模态AI图像生成模型的全面升级与行业革新

一、引言:AI图像生成技术的时代背景

在人工智能技术飞速发展的今天,多模态大模型正在重塑内容创作领域。作为阿里巴巴旗下阿里云推出的新一代AI图像生成平台,通义万相(Tongyi Wanxiang)自2023年首次发布以来,凭借其强大的生成能力和广泛的适用性,迅速成为行业焦点。2024年,通义万相2.1版本的推出,标志着该平台在生成质量、可控性和应用场景上的全面突破,为设计、电商、教育等多个领域带来颠覆性创新。

二、通义万相2.1的核心技术升级

-

多模态融合架构的突破

- 超大规模参数体系:模型参数量突破千亿级,通过混合专家(MoE)架构实现动态任务分配,相比前代模型推理效率提升40%。

- 多模态理解能力:整合文本、图像、语音、视频跨模态数据训练,支持"文本+草图+风格参考图"三重条件输入。

- 物理引擎级渲染技术:新增光线追踪模拟模块,可生成符合真实物理规律的材质反射与阴影效果。

-

生成质量与可控性飞跃

- 超分辨率生成:最高支持8K分辨率输出,噪点控制精度达到百万像素级。

- 细粒度风格控制:内置300+艺术风格模板,支持梵高笔触强度、水墨晕染程度等参数微调。

- 空间一致性增强:通过场景拓扑感知网络(STAN)确保复杂场景中物体透视关系的准确性。

-

行业级效率优化

- 分布式生成引擎:单次任务可并行生成100张候选图像,响应速度缩短至1.2秒/批次。

- API标准化接口:提供RESTful API和Python SDK,支持与企业现有工作流无缝对接。

- 版权合规体系:集成数字水印技术和内容过滤模型,确保生成内容的可追溯性与合法性。

三、功能特性深度解析

-

智能创作套件

- 概念设计辅助:支持从关键词脑暴到分镜脚本的完整创作流程。

- 动态风格迁移:实现"毕加索风格动画角色设计"等跨维度风格应用。

- 3D资产生成:可将2D图像自动转换为带UV贴图的OBJ格式3D模型。

-

企业级解决方案

- 电商场景:一键生成商品场景图、模特试穿图和广告海报。

- 工业设计:支持CAD草图渲染、产品材质模拟和装配示意图生成。

- 影视游戏:提供角色立绘、场景概念图和分帧动画批量生成。

-

个性化创作工具

- 人脸定制引擎:通过3张照片即可构建个性化数字形象。

- 实时协作平台:支持多用户在线标注修改,版本管理追溯至每个笔触。

- 艺术风格训练:允许用户上传10-20张样本图微调专属风格模型。

四、行业应用场景实践

-

新零售革命

- 虚拟试衣间:某服装品牌借助通义万相2.1的材质模拟功能,将新品开发周期缩短60%。

- 智能橱窗设计:某商场实现基于实时客流分析的动态海报生成系统。

-

教育创新

- 历史场景重建:高校利用建筑生成模块还原圆明园数字沙盘。

- 生物教学:通过DNA序列生成蛋白质3D结构可视化模型。

-

文化遗产保护

- 壁画修复:敦煌研究院使用破损区域智能补全功能完成第285窟修复。

- 文物数字化:三星堆青铜器实现"考古现场→3D模型→文创周边"全链路生成。

五、技术优势与行业影响

-

核心竞争优势

- 中文语境理解:在古诗词意象转化、传统纹样生成方面准确率超国际竞品30%。

- 本土化数据优势:训练集包含超500万张中国元素图像数据。

- 云边端协同:支持从阿里云超算集群到移动端的全场景部署。

-

行业生态构建

- 已与200+企业建立合作,涵盖建筑、影视、游戏等10余个垂直领域。

- 开发者社区累计共享超1.2万个定制化风格模型。

- 教育领域培养认证AI视觉设计师超5000人。

-

社会价值创造

- 帮助中小微企业降低视觉设计成本达75%。

- 推动非遗传承人数字作品产出效率提升20倍。

- 年度减少实物样衣、样机制作产生的碳排放约1.2万吨。

六、未来展望与技术路线图

通义万相团队计划在2025年前实现三大突破:

- 动态生成维度扩展:支持视频、3D动画和VR场景的端到端生成。

- 跨模态创作增强:实现"文字→图像→音乐→剧本"的连贯创作链条。

- 认知智能融合:结合大语言模型构建具备艺术鉴赏能力的AI创作助手。

七、结语:重新定义视觉生产力

通义万相2.1不仅是一个技术产品,更是打开创意宇宙的钥匙。通过降低专业设计门槛、释放人类创造力、重构视觉内容生产流程,它正在推动从"工具辅助"到"智能共创"的范式转变。在保证技术伦理和版权规范的前提下,这场由多模态AI引发的视觉革命,将催生出前所未有的商业价值和文化可能。

附录:访问阿里云官网获取API接入文档,或体验在线Demo创建您的首幅AI艺术作品。

1051

1051

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?