维度灾难是机器学习中的另一个重要问题,这个概念是贝尔曼(Bellman)在 1961 年首先提出的,它描述了以下事实:许多算法在低维空间表现很好,但输入为高维时,算法往往失效。

在机器学习领域,这有更多的意义,随着样本维度的增加,正确泛化的难度会以指数级增加,这是因为样本数量固定时,覆盖的输入空间比例指数级减少。比如对于 100 维的布尔空间(样本取值只有 0 和 1),即使包含 1 万亿(10 的 12 次方)样本的数据集,也只能覆盖输入空间 (2 的 100 次方,约为 10 的 30 次方) 的 10 的负 18 次方左右。这就体现出机器学习「归纳」的必要性,也是它的难点所在。

严格的讲,机器学习算法(显式或隐式)所依赖的基于相似度的推理在高维空间中会失效。比如:一个采用汉明距离为相似度度量的最近邻分类器,假设样例的分类类别是 x1∧x2。如果没有其它特征,这是一个很容易的问题。如果增加 98 个不相关的特征 x3,…,x100 时,来自这些特征的噪音会淹没 x1 和 x2 产生的信号,导致所找到的最近邻样本相当于做出随机预测。

更糟糕的是,即使所有的 100 个特征都是相关的,最近邻方法依然会有问题。这是因为在高维空间所有的样例都变得很相似,比如:假设所有样本分布在规则的网格上,现在考虑一个测试样本 x,如果网格是 d 维的,会有个 2d 个最近邻样例与 x 的距离相等。因此,随着维数的增加,x 会拥有越来越多的最近邻样本,导致最终最近邻的选择等价于随机的,从而使得类别的选择也变成随机的。

在三维世界的直觉在高维空间通常失效。在高维空间,多元高斯分布的大部分质量并不分布在均值附近,而是在逐渐远离均值的一层「壳」上,类似一个橘子的大部分质量不在瓤上,而是在皮上。如果数量一定的样本均匀分布在一个(维数不断增加的)高维的超立方体中,那么超出某个维数后,大部分样本与超立方体的某一面的距离要小于与它们最近邻样本的距离。如果在超立方体中内接一个超球面,那么几乎所有的质量都会分布在超球面之外。这对机器学习是一个坏消息,因为机器学习常常用一种类型的形状来近似另一种类型的形状。

在二维或三维空间构建分类器很简单,因为仅通过肉眼就可以发现不同类别样本的分界线,甚至可以说,如果人们拥有在高维空间中的观察能力,那么机器学习就没有存在的必要了。正是因为很难理解在高维空间中发生什么,所以很难设计出一个好的分类器。也许人们会天真地认为:收集更多的特征永远不会有什么坏处,因为最坏的情况也不过是这些新增的特征没有提供关于类别的新信息而已。但实际上,这样做的好处可能要远小于维度灾难带来的问题。

在机器学习领域,这有更多的意义,随着样本维度的增加,正确泛化的难度会以指数级增加,这是因为样本数量固定时,覆盖的输入空间比例指数级减少。比如对于 100 维的布尔空间(样本取值只有 0 和 1),即使包含 1 万亿(10 的 12 次方)样本的数据集,也只能覆盖输入空间 (2 的 100 次方,约为 10 的 30 次方) 的 10 的负 18 次方左右。这就体现出机器学习「归纳」的必要性,也是它的难点所在。

严格的讲,机器学习算法(显式或隐式)所依赖的基于相似度的推理在高维空间中会失效。比如:一个采用汉明距离为相似度度量的最近邻分类器,假设样例的分类类别是 x1∧x2。如果没有其它特征,这是一个很容易的问题。如果增加 98 个不相关的特征 x3,…,x100 时,来自这些特征的噪音会淹没 x1 和 x2 产生的信号,导致所找到的最近邻样本相当于做出随机预测。

更糟糕的是,即使所有的 100 个特征都是相关的,最近邻方法依然会有问题。这是因为在高维空间所有的样例都变得很相似,比如:假设所有样本分布在规则的网格上,现在考虑一个测试样本 x,如果网格是 d 维的,会有个 2d 个最近邻样例与 x 的距离相等。因此,随着维数的增加,x 会拥有越来越多的最近邻样本,导致最终最近邻的选择等价于随机的,从而使得类别的选择也变成随机的。

在三维世界的直觉在高维空间通常失效。在高维空间,多元高斯分布的大部分质量并不分布在均值附近,而是在逐渐远离均值的一层「壳」上,类似一个橘子的大部分质量不在瓤上,而是在皮上。如果数量一定的样本均匀分布在一个(维数不断增加的)高维的超立方体中,那么超出某个维数后,大部分样本与超立方体的某一面的距离要小于与它们最近邻样本的距离。如果在超立方体中内接一个超球面,那么几乎所有的质量都会分布在超球面之外。这对机器学习是一个坏消息,因为机器学习常常用一种类型的形状来近似另一种类型的形状。

在二维或三维空间构建分类器很简单,因为仅通过肉眼就可以发现不同类别样本的分界线,甚至可以说,如果人们拥有在高维空间中的观察能力,那么机器学习就没有存在的必要了。正是因为很难理解在高维空间中发生什么,所以很难设计出一个好的分类器。也许人们会天真地认为:收集更多的特征永远不会有什么坏处,因为最坏的情况也不过是这些新增的特征没有提供关于类别的新信息而已。但实际上,这样做的好处可能要远小于维度灾难带来的问题。

幸运的是,有一个现象可以在一定程度上抵消维度灾难,那就是所谓的「非均匀性的祈福」(blessing ofnonuniformity)。大多数情况下,样本在空间中并非均匀分布,而是集中在一个低维流形上或其附近。比如:在识别手写数字时,即使数字图片的每个像素都单独作为一个特征,近邻方法依然表现良好,这是因为数字图片的空间要远小于整个可能的空间。学习器可以隐式地充分利用这个有效的低维空间,也可以显式地进行降维。

再进行数据降维时PCA(基于svd)的方法是比较常用的,但是在deeplearning 的那本书中作者介绍了

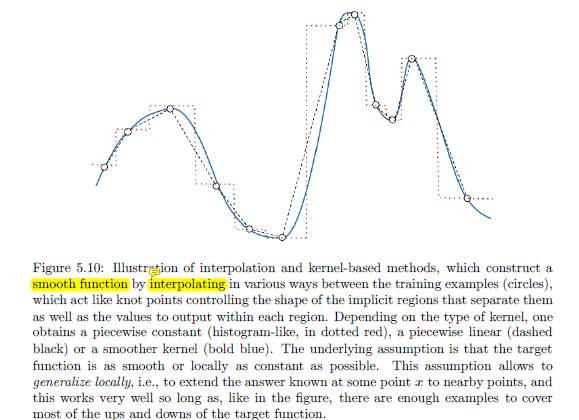

局部不变性与平滑正则化的方式来进行约束,使得数据的维度局部不变性的条件下,先是一种建立在局部的范围的分类,然后将各个范围的东西通过平滑曲线及插入之法来进行连接,使用最近邻或是k-means的方法在局部区域进行选择,其次是使用决策树的方式来局部分解判定。

在最后作者有提到关于流形学习算法来进行降维的提取。流形学习正是利用了局部不变性的这一特质来进行分割的,根据概率密度将主要的分离出来。

790

790

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?