Dif-Fusion: 通过扩散模型实现红外与可见光图像融合中的高色彩保真度

摘要——色彩在人类视觉感知中起着重要作用,反映了物体的光谱。然而,现有的红外与可见光图像融合方法很少探讨如何直接处理多光谱/通道数据,并实现高色彩保真度。本文通过提出一种新的基于扩散模型的方法,名为Dif-Fusion,来解决上述问题,生成多通道输入数据的分布,从而增强多源信息聚合的能力和色彩的保真度。具体来说,本文方法不同于现有的图像融合方法将多通道图像转化为单通道数据,而是在潜在空间中通过去噪网络和正向、反向扩散过程来创建多通道数据分布。接着,我们使用去噪网络提取包含可见光和红外信息的多通道扩散特征。最后,将多通道扩散特征输入到多通道融合模块中,直接生成三通道融合图像。为了保留纹理和强度信息,我们提出了多通道梯度损失和强度损失。除了现有的纹理和强度保真度评估指标外,我们还引入了Delta E作为新的评估指标,用于量化色彩保真度。大量实验表明,我们的方法在色彩保真度方面比其他现有的图像融合方法更为有效。源代码可以在 https://github.com/GeoVectorMatrix/Dif-Fusion 获得。

关键词——图像融合、色彩保真度、多模态信息、扩散模型、潜在表示、深度生成模型。

I. 引言

由于光学成像硬件设备的理论和技术限制,通过单一传感器或单一拍摄设置获得的图像只能获取部分图像信息[1][2]。因此,不同传感器或不同拍摄设置的图像融合有助于丰富图像信息。在各种图像融合任务中,红外与可见光图像融合是最广泛使用的任务之一[3][4]。红外传感器可以捕捉物体的热辐射,但它容易受到噪声的影响,且难以捕捉纹理信息。相反,可见光图像通常包含丰富的结构和纹理信息,但容易受到光照和遮挡的影响。两者之间的互补性使得生成包含热物体和纹理细节的融合图像成为可能。在这种背景下,红外与可见光图像融合作为一种技术,通过将红外与可见光图像对的信息结合,创建融合图像。这种方法利用两种光谱的优势,改善最终图像的整体质量和可解释性。融合图像的一个常见且广泛使用的应用是加快和提高视觉解释的准确性,例如多模态遥感图像的分析。两模态图像常在监控应用中同时拍摄,因此提供重要互补信息的融合图像也很重要。近年来,图像融合还在其他领域引起了关注,如语义分割[5]、人类再识别[6]、物体检测与追踪[7]等多个领域。

为了实现红外与可见光图像的有效融合,过去几十年中提出了许多图像融合技术[3],包括传统方法[8]和基于深度学习的方法[9]。传统的红外与可见光图像融合算法通常可以分为以下几类,包括基于稀疏表示的方法[10][11]、基于多尺度变换的方法[12][13]、基于子空间的方法[14]、基于显著性检测的方法[15]和混合方法[16]。虽然上述算法在大多数情况下能够满足特定场景的需求,但仍然存在一些问题:1)现有的传统方法通常使用相同的方式来表达图像特征,且很少考虑红外与可见光图像的独特特性;2)活动度测量和融合规则需要手动设置,这无法满足复杂场景的需求[17]。

近年来,随着深度学习技术的快速发展[18][19],研究人员探索了基于深度神经网络的融合算法。通常,当前主流的深度融合方法可以分为三类:基于自编码器(AE)的方法[20]、基于卷积神经网络(CNN)的方法[4][21]和基于生成对抗网络(GAN)的方法[9][22]。作为一种图像生成任务,现有的红外与可见光图像融合方法在生成模型的深入探索上存在不足。现有的基于生成模型的方法主要依赖于GAN,包括FusionGAN[9]和GANMcC[22]。然而,由于这些方法对生成器施加的额外约束,导致无法建立红外与可见光图像的分布。

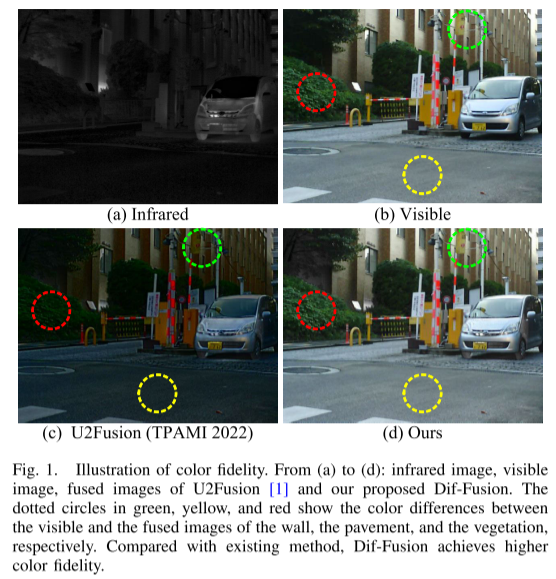

尽管现有的基于深度学习的融合方法可以实现相对令人满意的性能,但仍然存在一些需要考虑的问题。首先,现有方法主要关注于保留红外图像中的热目标和可见光图像中的背景纹理结构,而较少考虑如何保留可见光图像中的色彩信息[4]。然而,色彩反映了物体的光谱,这在数字图像中至关重要。人类视觉系统对色彩(光谱)非常敏感,关于色彩在理解视觉场景中的重要性已有许多研究[23][24]。大量的理论和实证研究表明,色彩对人类的认知、情感和行为具有重要影响[25][26][27]。如图1(c)所示,当前的方法(U2Fusion [1])未能有效利用多光谱信息,并且在保留可见光图像中的色彩信息方面表现较差,这会对人类的感知产生负面影响。除了梯度保真度和强度保真度外,我们认为在图像融合任务中保持可见光图像的色彩同样是必要的,这有助于保留对人类感知至关重要的信息[28]。

另一方面,如何从输入数据中提取多通道的互补信息尚未得到充分研究。现有的方法通常将存储在三通道(即RGB通道)的可见光图像从RGB空间转换到YCbCr空间,并使用Y通道进行融合[1][29]。在生成单通道融合图像后,需要通过后处理将其转换为三通道图像[30][31]。由于输入数据中并未呈现所有通道,因此很难构建多通道分布并提取多通道的互补信息,从而导致色彩失真。

为了应对上述挑战,提出了一种基于扩散模型的新型红外与可见光图像融合方法,称为Dif-Fusion。首先,我们直接输入由三通道可见光图像和一通道红外图像组成的多通道数据,并通过扩散过程在潜在空间中构建多通道分布。扩散过程是一个马尔可夫过程,分为前向过程和反向过程[32]。在前向过程中,逐步向多通道输入数据中添加高斯噪声;而在反向过程中,通过多个时间步消除前向过程中添加的噪声。多通道分布通过在反向过程中训练去噪网络来估计前向过程中添加的噪声,从而构建。其次,我们从去噪网络中提取多通道扩散特征,其中包括红外和可见光特征。第三,将多通道扩散特征输入多通道融合模块,直接生成三通道融合图像。此外,我们提出了多通道梯度损失LMCG和多通道强度损失LMCI,以保留三通道融合图像的纹理和梯度信息。

现有的方法大多集中于融合可见光图像中的纹理/梯度和红外图像中的强度,而没有关注色彩信息的保留以及多通道互补信息的提取。所提出的方法基于扩散模型建立多通道输入数据的分布,并提取多通道互补信息,以实现高色彩保真度。如图1(d)所示,我们的融合图像具有高色彩保真度,更适合人类视觉感知。在融合结果评估方面,除了现有的量化强度和梯度保真度的指标外,我们还引入了一个用于量化色彩保真度的指标。通过所提出的Dif-Fusion,红外与可见光图像可以直接输入模型,而无需进行色彩空间转换。总结起来,本文的主要贡献有三点:

- 我们提出了一种基于扩散模型的红外与可见光图像融合框架,可以直接生成具有色彩的融合图像,并同时实现色彩、梯度和强度的保真度。

- 我们将多通道分布的构建形式化为一个扩散过程,这是迄今为止首次将扩散模型应用于红外与可见光图像融合。

- 为了衡量融合图像的色彩保真度,我们引入了一种新的评估指标来量化色彩保真度。大量实验表明,所提出的方法优于现有的最先进方法。

本文的其余部分组织结构如下:第二部分简要介绍了图像融合和扩散模型的相关工作;第三部分详细描述了所提出的方法;第四部分展示并讨论了实验设置和结果;第五部分总结了本文的结论。

2.相关工作

A.红外和可见光图像融合

在本节中,我们将介绍与本文提出的方法高度相关的背景资料和相关工作,包括传统的红外和可见光图像融合方法、基于深度学习的融合方法和扩散模型。

在过去的几十年里,研究人员提出了许多红外与可见光图像融合技术,包括传统方法和基于深度学习的方法[2],[17]。传统的红外与可见光图像融合算法通常可以分为五类,即稀疏表示、多尺度变换、子空间表示、显著性检测和混合方法[3]。

稀疏表示理论的主要思想是,图像信号可以表示为过完备字典中最少可能原子或变换基的线性组合[18]。过完备性意味着字典中的原子数大于信号的维度[10],[11]。在图像融合中,稀疏表示通常通过从一组训练图像中学习一个完整字典,从而捕捉固有的基于数据的图像表示。过完备字典包含丰富的基原子,使得源图像的表示更加有意义和稳定[12]。多尺度变换可以将原始图像分解为不同尺度的子图像[3]。多尺度变换类似于人类视觉过程,这可以使融合图像具有良好的视觉效果[12],[33],[34],[35]。

基于子空间表示的方法旨在将高维特征投影到低维子空间[3]。投影到低维子空间有助于捕捉原始输入图像的固有结构[36]。此外,在低维子空间中的数据处理相比于高维空间中的处理,可以节省时间和内存。常见的基于子空间表示的方法包括主成分分析(PCA)[37],[38],独立成分分析(ICA)[39],[40]和非负矩阵分解(NMF)[14],[41]。

显著性检测模型模拟人类行为,捕捉图像或场景中最显著的区域/物体[15]。它在计算机视觉和模式识别任务中具有许多重要应用[42]。近年来,基于显著

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

120

120

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?