深度学习(BOT方向) 学习笔记(2) Sequence2Sequence 学习2

PS:这一个系列比较语无伦次,后期会有一个refined版的,这个系列相当于草稿

1 前言

这个系列的笔记拖了很久了,一直没时间仔细详细写,一来是因为自己能力不足,学习进度也很慢,二是真的很懒,也没有什么outline,所以一直拖着没写,现在终于挤出第二篇来了。

话说之前的第一篇,我很匆忙的写了写Sequence2Sequence RNN-Encoder-Decoder的框架,写的不是很认真,这篇博客则主要想仔细写写这个框架。最主要的目的是帮助自己理解,其次是做个留底和分享。

2 再看 RNN Encoder-Decoder框架

这里复习下Sequence2Sequence任务到底是什么,所谓的Sequence2Sequence任务主要是泛指一些Sequence到Sequence的映射问题,Sequence在这里可以理解为一个字符串序列,当我们在给定一个字符串序列后,希望得到与之对应的另一个字符串序列(如 翻译后的、如语义上对应的)时,这个任务就可以称为Sequence2Sequence了。

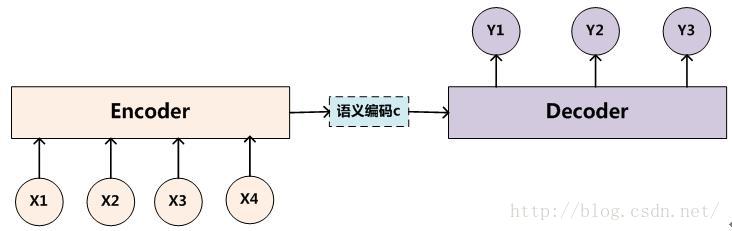

在现在的深度学习领域当中,通常的做法是将输入的源Sequence编码到一个中间的context当中,这个context是一个特定长度的编码(可以理解为一个向量),然后再通过这个context还原成一个输出的目标Sequence。

如果用人的思维来看,就是我们先看到源Sequence,将其读一遍,然后在我们大脑当中就记住了这个源Sequence,并且存在大脑的某一个位置上,形成我们自己的记忆(对应Context),然后我们再经过思考,将这个大脑里的东西转变成输出,然后写下来。

那么我们大脑读入的过程叫做Encoder,即将输入的东西变成我们自己的记忆,放在大脑当中,而这个记忆可以叫做Context,然后我们再根据这个Context,转化成答案写下来,这个写的过程叫做Decoder。其实就是编码-存储-解码的过程。

而对应的,大脑怎么读入(Encoder怎么工作)有一个特定的方式,怎么记忆(Context)有一种特定的形式,怎么转变成答案(Decoder怎么工作)又有一种特定的工作方式。

好了,现在我们大体了解了一个工作的流程Encoder-Decoder后,我们来介绍一个深度学习当中,最经典的Encoder-Decoder实现方式,即用RNN来实现。

在RNN Encoder-Decoder的工作当中,我们用一个RNN去模拟大脑的读入动作,用一个特定长度的特征向量去模拟我们的记忆,然后再用另外一个RNN去模拟大脑思考得到答案的动作,将三者组织起来利用就成了一个可以实现Seque

本文介绍了Sequence2Sequence任务的概念,通过RNN Encoder-Decoder框架来理解这一序列到序列的映射问题。文章详细阐述了RNN及LSTM的工作原理,解释了它们如何在处理长期依赖问题时发挥作用。重点讨论了LSTM的“门”机制,如忘记门和输入门,以及如何在Encoder-Decoder模型中使用RNN(LSTM)处理可变长序列数据。

本文介绍了Sequence2Sequence任务的概念,通过RNN Encoder-Decoder框架来理解这一序列到序列的映射问题。文章详细阐述了RNN及LSTM的工作原理,解释了它们如何在处理长期依赖问题时发挥作用。重点讨论了LSTM的“门”机制,如忘记门和输入门,以及如何在Encoder-Decoder模型中使用RNN(LSTM)处理可变长序列数据。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1221

1221

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?