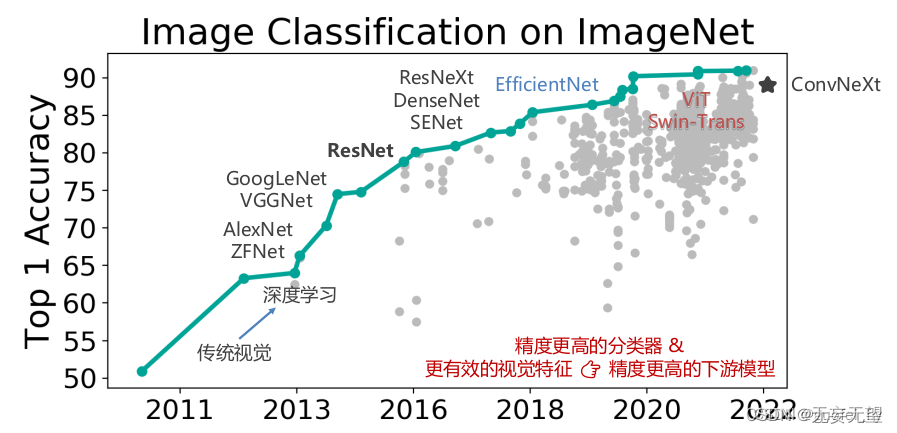

1.图像分类的发展历程

图像分类的发展历程可以追溯到计算机视觉领域的早期。最早的图像分类方法是基于手工设计的特征提取算法,例如SIFT和HOG等。这些方法通过提取图像的局部特征,然后使用传统的机器学习算法(如SVM和KNN)进行分类。然而,这些方法对于复杂的图像场景和大规模数据集来说,效果有限。

随着深度学习的兴起,卷积神经网络(CNN)在图像分类任务上取得了巨大的成功。CNN通过多层卷积和池化操作,自动学习图像的特征表示,并且能够从大规模数据中进行端到端的训练。著名的CNN模型,如LeNet、AlexNet、VGGNet、GoogLeNet和ResNet等,不断推动图像分类的性能和效果的提升。

除了CNN之外,近年来还出现了一些基于注意力机制的图像分类方法。这些方法通过学习图像中的关键区域,提高对重要信息的关注程度,从而提升分类性能。

此外,迁移学习也在图像分类中得到了广泛应用。迁移学习利用已经训练好的模型,在新的任务上进行微调,从而加速训练过程并提升模型的泛化能力。

1.1背景与意义

图像信息的丰富性:图像作为人类感知世界的重要方式之一,包含丰富的视觉信息。通过研究图像分类,可以帮助计算机理解和解释图像中的对象、场景和特征,从而实现更智能和高效的图像处理和分析。

应用广泛性:图像分类在许多领域中都有广泛的应用。例如,在医学领域,图像分类可以用于疾病诊断和治疗方案选择;在安防领域,图像分类可以用于图像监控和异常检测;在自动驾驶领域,图像分类可以用于识别交通标志和行人等。图像分类的研究和应用可以提高各个领域的效率和安全性。

数据驱动决策:在大数据时代,图像数据以惊人的速度增长,对这些海量的图像数据进行分类和分析,可以帮助人们从中挖掘出有价值的信息。通过图像分类,可以为决策提供更全面和准确的数据支持,从而推动各个领域的发展和进步。

1.2应用

视觉搜索:图像分类可以用于视觉搜索引擎,通过输入图像来搜索相似或相关的图像。这在电子商务、社交媒体等领域有广泛的应用,方便人们寻找感兴趣的内容和商品。

图像检索:图像分类可以用于图像库的管理和索引,通过给图像打上标签或分类,方便用户对大规模图像进行检索和管理。这在图书馆、博物馆等场景中具有重要意义。

计算机辅助诊断:医学影像如X射线、CT、MRI等包含了丰富的信息,图像分类可以帮助医生自动识别和定位疾病病灶,提高疾病的早期诊断和治疗效果。

2.图像分类的概念

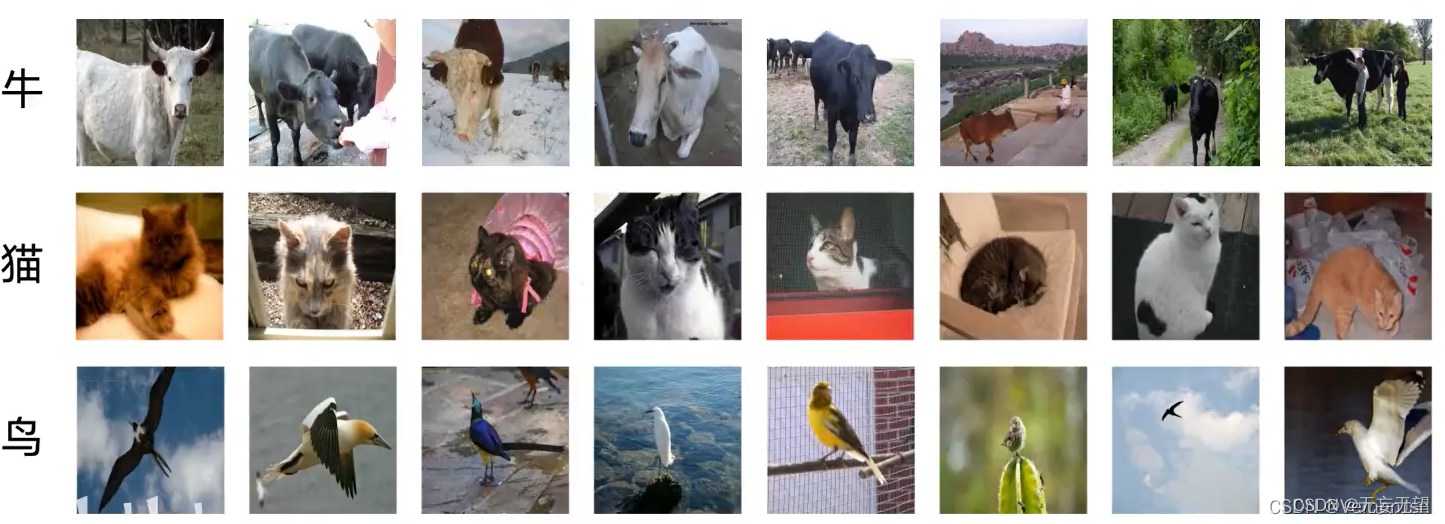

图像分类是计算机视觉领域中的一个基本任务,它的目标是从给定的图像中识别出所属的类别。它涉及到从图像中提取特征,然后使用分类算法将这些特征映射到预定义的类别。

1.1什么是图像分类

图像分类问题指的是,对于一张输入图像,从已有的标签集合中找出一个标签,并分配给这张图像。以下图为例:我们的图像分类模型会读取这张图片,然后输出这张图片对应每个标签的概率。对于计算机来说,图像是由一个一个的像素信息组成的。在这个例子中,这张猫的图片大小像素是248*400,因为图片是彩色的,所以还包含了RGB三个颜色通道。所以我们的输入是240*800*3=297600,每个数字代表着某一通道的亮度值。范围在0-255之间,0代表白色,255代表黑色。而我们要做的就是让计算机理解这些数字信息,然后做出分类。

1.2 图像分类的难度

图像分类的难度在于以下几个方面:

视角变化(Viewpoint variation):同一个物体,摄像机可以从多个角度来展现。

大小变化(Scale variation):物体可视的大小通常是会变化的(不仅是在图片中,在真实世界中大小也是变化的)。

形变(Deformation):很多东西的形状并非一成不变,会有很大变化。

遮挡(Occlusion):目标物体可能被挡住。有时候只有物体的一小部分(可以小到几个像素)是可见的。

光照条件(Illumination conditions):在像素层面上,光照的影响非常大。

背景干扰(Background clutter):物体可能混入背景之中,使之难以被辨认。

类内差异(Intra-class variation):一类物体的个体之间的外形差异很大,比如椅子。这一类物体有许多不同的对象,每个都有自己的外形。

以上的所有情况,同一个类别的像素信息都会有巨大的差异(计算机是通过像素信息去看图像的)。面对以上所有变化及其组合,好的图像分类模型能够在维持分类结论稳定的同时,保持对类间差异足够敏感。

3.使用CNN进行图像分类

1.收集图像以及对应的标签,形成数据集

2.使用机器学习训练一个分类器

3.在新的图像.上测试这个分类器

4.图像分类的经典模型

4.1 AlexNet

AlexNet是一种深度神经网络结构,相对于原始的LeNet来说更深,LeNet为5层,而AlexNet为8层。AlexNet在神经网络发展过程中起到了重要的作用,让研究人员意识到网络深度对性能的巨大影响。它的出现打破了以前学者们对于学习特征的认知,首次证明了学习到的特征可以超越手工设计的特征。

网络架构

该网络的特点是:

AlexNet包含8层变换,有5层卷积和2层全连接隐藏层,以及1个全连接输出层

AlexNet第一层中的卷积核形状是11×1111×11。第二层中的卷积核形状减小到5×55×5,之后全采用3×33×3。所有的池化层窗口大小为3×33×3、步幅为2的最大池化。

AlexNet将sigmoid激活函数改成了ReLU激活函数,使计算更简单,网络更容易训练

AlexNet通过dropOut来控制全连接层的模型复杂度。

AlexNet引入了大量的图像增强,如翻转、裁剪和颜色变化,从而进一步扩大数据集来缓解过拟合。

在tf.keras中实现AlexNet模型:

# 构建AlexNet模型

net = tf.keras.models.Sequential([

# 卷积层:96个卷积核,卷积核为11*11,步幅为4,激活函数relu

tf.keras.layers.Conv2D(filters=96,kernel_size=11,strides=4,activation='relu'),

# 池化:窗口大小为3*3、步幅为2

tf.keras.layers.MaxPool2D(pool_size=3, strides=2),

# 卷积层:256个卷积核,卷积核为5*5,步幅为1,padding为same,激活函数relu

tf.keras.layers.Conv2D(filters=256,kernel_size=5,padding='same',activation='relu'),

# 池化:窗口大小为3*3、步幅为2

tf.keras.layers.MaxPool2D(pool_size=3, strides=2),

# 卷积层:384个卷积核,卷积核为3*3,步幅为1,padding为same,激活函数relu

tf.keras.layers.Conv2D(filters=384,kernel_size=3,padding='same',activation='relu'),

# 卷积层:384个卷积核,卷积核为3*3,步幅为1,padding为same,激活函数relu

tf.keras.layers.Conv2D(filters=384,kernel_size=3,padding='same',activation='relu'),

# 卷积层:256个卷积核,卷积核为3*3,步幅为1,padding为same,激活函数relu

tf.keras.layers.Conv2D(filters=256,kernel_size=3,padding='same',activation='relu'),

# 池化:窗口大小为3*3、步幅为2

tf.keras.layers.MaxPool2D(pool_size=3, strides=2),

# 伸展为1维向量

tf.keras.layers.Flatten(),

# 全连接层:4096个神经元,激活函数relu

tf.keras.layers.Dense(4096,activation='relu'),

# 随机失活

tf.keras.layers.Dropout(0.5),

# 全链接层:4096个神经元,激活函数relu

tf.keras.layers.Dense(4096,activation='relu'),

# 随机失活

tf.keras.layers.Dropout(0.5),

# 输出层:10个神经元,激活函数softmax

tf.keras.layers.Dense(10,activation='softmax')

])

我们构造一个高和宽均为227的单通道数据样本来看一下模型的架构:

# 构造输入X,并将其送入到net网络中

X = tf.random.uniform((1,227,227,1)

y = net(X)

# 通过net.summay()查看网络的形状

net.summay()

网络架构如下:

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

conv2d (Conv2D) (1, 55, 55, 96) 11712

_________________________________________________________________

max_pooling2d (MaxPooling2D) (1, 27, 27, 96) 0

_________________________________________________________________

conv2d_1 (Conv2D) (1, 27, 27, 256) 614656

_________________________________________________________________

max_pooling2d_1 (MaxPooling2 (1, 13, 13, 256) 0

_________________________________________________________________

conv2d_2 (Conv2D) (1, 13, 13, 384) 885120

_________________________________________________________________

conv2d_3 (Conv2D) (1, 13, 13, 384) 1327488

_________________________________________________________________

conv2d_4 (Conv2D) (1, 13, 13, 256) 884992

_________________________________________________________________

max_pooling2d_2 (MaxPooling2 (1, 6, 6, 256) 0

_________________________________________________________________

flatten (Flatten) (1, 9216) 0

_________________________________________________________________

dense (Dense) (1, 4096) 37752832

_________________________________________________________________

dropout (Dropout) (1, 4096) 0

_________________________________________________________________

dense_1 (Dense) (1, 4096) 16781312

_________________________________________________________________

dropout_1 (Dropout) (1, 4096) 0

_________________________________________________________________

dense_2 (Dense) (1, 10) 40970

=================================================================

Total params: 58,299,082

Trainable params: 58,299,082

Non-trainable params: 0

_________________________________________________________________

手写数字势识别

AlexNet使用ImageNet数据集进行训练,但因为ImageNet数据集较大训练时间较长,我们仍用前面的MNIST数据集来演示AlexNet。读取数据的时将图像高和宽扩大到AlexNet使用的图像高和宽227。这个通过tf.image.resize_with_pad来实现。

数据读取

import numpy as np

# 获取手写数字数据集

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

# 训练集数据维度的调整:N H W C

train_images = np.reshape(train_images,(train_images.shape[0],train_images.shape[1],train_images.shape[2],1))

# 测试集数据维度的调整:N H W C

test_images = np.reshape(test_images,(test_images.shape[0],test_images.shape[1],test_images.shape[2],1))

由于使用全部数据训练时间较长,我们定义两个方法获取部分数据,并将图像调整为227*227大小,进行模型训练:

# 定义两个方法随机抽取部分样本演示

# 获取训练集数据

def get_train(size):

# 随机生成要抽样的样本的索引

index = np.random.randint(0, np.shape(train_images)[0], size)

# 将这些数据resize成227*227大小

resized_images = tf.image.resize_with_pad(train_images[index],227,227,)

# 返回抽取的

return resized_images.numpy(), train_labels[index]

# 获取测试集数据

def get_test(size):

# 随机生成要抽样的样本的索引

index = np.random.randint(0, np.shape(test_images)[0], size)

# 将这些数据resize成227*227大小

resized_images = tf.image.resize_with_pad(test_images[index],227,227,)

# 返回抽样的测试样本

return resized_images.numpy(), test_labels[index]

调用上述两个方法,获取参与模型训练和测试的数据集:

# 获取训练样本和测试样本

train_images,train_labels = get_train(256)

test_images,test_labels = get_test(128)

为了让大家更好的理解,我们将数据展示出来:

# 数据展示:将数据集的前九个数据集进行展示

for i in range(9):

plt.subplot(3,3,i+1)

# 以灰度图显示,不进行插值

plt.imshow(train_images[i].astype(np.int8).squeeze(), cmap='gray', interpolation='none')

# 设置图片的标题:对应的类别

plt.title("数字{}".format(train_labels[i]))

结果为:

我们就使用上述创建的模型进行训练和评估。

模型编译

# 指定优化器,损失函数和评价指标

optimizer = tf.keras.optimizers.SGD(learning_rate=0.01, momentum=0.0, nesterov=False)

net.compile(optimizer=optimizer,

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

模型训练

# 模型训练:指定训练数据,batchsize,epoch,验证集

net.fit(train_images,train_labels,batch_size=128,epochs=3,verbose=1,validation_split=0.1)

训练输出

Epoch 1/3

2/2 [==============================] - 3s 2s/step - loss: 2.3003 - accuracy: 0.0913 - val_loss: 2.3026 - val_accuracy: 0.0000e+00

Epoch 2/3

2/2 [==============================] - 3s 2s/step - loss: 2.3069 - accuracy: 0.0957 - val_loss: 2.3026 - val_accuracy: 0.0000e+00

Epoch 3/3

2/2 [==============================] - 4s 2s/step - loss: 2.3117 - accuracy: 0.0826 - val_loss: 2.3026 - val_accuracy: 0.0000e+00

模型评估

# 指定测试数据

net.evaluate(test_images,test_labels,verbose=1)

输出为:

4/4 [==============================] - 1s 168ms/step - loss: 2.3026 - accuracy: 0.0781

[2.3025851249694824, 0.078125]

如果我们使用整个数据集训练网络,并进行评估的结果:

[0.4866700246334076, 0.8395]

4.2 VGG

VGG是一种卷积神经网络,其网络结构由小卷积核、小池化核和ReLU激活函数组成。根据卷积核的大小和卷积层数的不同,VGG有6种不同的配置,分别为A、A-LRN、B、C、D和E。其中,D和E两种配置最为常用,分别称为VGG16和VGG19。VGG16是最佳的模型之一,它由一系列的3x3卷积和2x2池化层构成,结构简洁优美。通过增加网络的深度,可以有效地提升VGG的性能。此外,VGG的卷积层可以代替全连接层,从而适应各种尺寸的图片

网络架构

VGG可以看成是加深版的AlexNet,整个网络由卷积层和全连接层叠加而成,和AlexNet不同的是,VGG中使用的都是小尺寸的卷积核(3×3),其网络架构如下图所示:

VGGNet使用的全部都是3x3的小卷积核和2x2的池化核,通过不断加深网络来提升性能。VGG可以通过重复使用简单的基础块来构建深度模型。

在tf.keras中实现VGG模型,首先来实现VGG块,它的组成规律是:连续使用多个相同的填充为1、卷积核大小为3×33×3的卷积层后接上一个步幅为2、窗口形状为2×22×2的最大池化层。卷积层保持输入的高和宽不变,而池化层则对其减半。我们使用vgg_block函数来实现这个基础的VGG块,它可以指定卷积层的数量num_convs和每层的卷积核个数num_filters:

# 定义VGG网络中的卷积块:卷积层的个数,卷积层中卷积核的个数

def vgg_block(num_convs, num_filters):

# 构建序列模型

blk = tf.keras.models.Sequential()

# 遍历所有的卷积层

for _ in range(num_convs):

# 每个卷积层:num_filter个卷积核,卷积核大小为3*3,padding是same,激活函数是relu

blk.add(tf.keras.layers.Conv2D(num_filters,kernel_size=3,

padding='same',activation='relu'))

# 卷积块最后是一个最大池化,窗口大小为2*2,步长为2

blk.add(tf.keras.layers.MaxPool2D(pool_size=2, strides=2))

return blk

VGG16网络有5个卷积块,前2块使用两个卷积层,而后3块使用三个卷积层。第一块的输出通道是64,之后每次对输出通道数翻倍,直到变为512。

# 定义5个卷积块,指明每个卷积块中的卷积层个数及相应的卷积核个数

conv_arch = ((2, 64), (2, 128), (3, 256), (3, 512), (3, 512))

因为这个网络使用了13个卷积层和3个全连接层,所以经常被称为VGG-16,通过制定conv_arch得到模型架构后构建VGG16:

# 定义VGG网络

def vgg(conv_arch):

# 构建序列模型

net = tf.keras.models.Sequential()

# 根据conv_arch生成卷积部分

for (num_convs, num_filters) in conv_arch:

net.add(vgg_block(num_convs, num_filters))

# 卷积块序列后添加全连接层

net.add(tf.keras.models.Sequential([

# 将特征图展成一维向量

tf.keras.layers.Flatten(),

# 全连接层:4096个神经元,激活函数是relu

tf.keras.layers.Dense(4096, activation='relu'),

# 随机失活

tf.keras.layers.Dropout(0.5),

# 全连接层:4096个神经元,激活函数是relu

tf.keras.layers.Dense(4096, activation='relu'),

# 随机失活

tf.keras.layers.Dropout(0.5),

# 全连接层:10个神经元,激活函数是softmax

tf.keras.layers.Dense(10, activation='softmax')]))

return net

# 网络实例化

net = vgg(conv_arch)

4.3 GoogLeNet

GoogLeNet是一种深度卷积神经网络模型,它在ImageNet图像分类挑战中取得了很好的结果。与AlexNet和VGG等其他模型不同,GoogLeNet采用了Inception模块,通过并行使用多个不同大小的卷积核和池化层来提取特征。这种设计使得网络具有更高的表达能力和更少的参数量。

与其他模型相比,GoogLeNet在性能和效率方面有很大的优势。通过引入辅助分类器,GoogLeNet能够在训练过程中增加额外的监督信号,以提高梯度传播和防止梯度消失问题。此外,GoogLeNet还使用了1x1卷积层来减少网络的计算复杂度,并使用了平均池化层来减少过拟合

网络结构

网络中的亮点:

1.引入了Inception(开端)结构(融合不同尺度的特征信息)

2.使用1*1的卷积核进行降维以及映射处理

3.添加两个辅助分类器帮助训练(AlexNet和VGG都只有一个输出层,GoogLeNet有三个,其中两个辅助分类层)

4.丢弃全连接层,使用平均池化层(大大减少了模型的参数)

a)是未加入1x1卷积的inception模块,(b)是加入了1x1 卷积的inception模块。

我们以3x3卷积线路为例,假设输入的特征图大小为(28x28x192),输出特征图的通道数是128:

(a)图中该线路的参数量为:3x3x192x128 = 221184

(b)图中加入1x1卷积后通道为96,再送入3x3卷积中的参数量为:(1x1x192x96)+(3x3x96x128)=129024.

对比可知,加入1x1卷积后参数量减少了。

在tf.keras中实现Inception模块,各个卷积层卷积核的个数通过输入参数来控制,如下所示:

# 定义Inception模块

class Inception(tf.keras.layers.Layer):

# 输入参数为各个卷积的卷积核个数

def __init__(self, c1, c2, c3, c4):

super().__init__()

# 线路1:1 x 1卷积层,激活函数是RELU,padding是same

self.p1_1 = tf.keras.layers.Conv2D(

c1, kernel_size=1, activation='relu', padding='same')

# 线路2,1 x 1卷积层后接3 x 3卷积层,激活函数是RELU,padding是same

self.p2_1 = tf.keras.layers.Conv2D(

c2[0], kernel_size=1, padding='same', activation='relu')

self.p2_2 = tf.keras.layers.Conv2D(c2[1], kernel_size=3, padding='same',

activation='relu')

# 线路3,1 x 1卷积层后接5 x 5卷积层,激活函数是RELU,padding是same

self.p3_1 = tf.keras.layers.Conv2D(

c3[0], kernel_size=1, padding='same', activation='relu')

self.p3_2 = tf.keras.layers.Conv2D(c3[1], kernel_size=5, padding='same',

activation='relu')

# 线路4,3 x 3最大池化层后接1 x 1卷积层,激活函数是RELU,padding是same

self.p4_1 = tf.keras.layers.MaxPool2D(

pool_size=3, padding='same', strides=1)

self.p4_2 = tf.keras.layers.Conv2D(

c4, kernel_size=1, padding='same', activation='relu')

# 完成前向传播过程

def call(self, x):

# 线路1

p1 = self.p1_1(x)

# 线路2

p2 = self.p2_2(self.p2_1(x))

# 线路3

p3 = self.p3_2(self.p3_1(x))

# 线路4

p4 = self.p4_2(self.p4_1(x))

# 在通道维上concat输出

outputs = tf.concat([p1, p2, p3, p4], axis=-1)

return outputs

1*1卷积核是怎样起到降维的作用呢?

googLeNet的网络设计

B1模块

第一模块使用一个64通道的7×7卷积层。

# 定义模型的输入

inputs = tf.keras.Input(shape=(224,224,3),name = "input")

# b1 模块

# 卷积层7*7的卷积核,步长为2,pad是same,激活函数RELU

x = tf.keras.layers.Conv2D(64, kernel_size=7, strides=2, padding='same', activation='relu')(inputs)

# 最大池化:窗口大小为3*3,步长为2,pad是same

x = tf.keras.layers.MaxPool2D(pool_size=3, strides=2, padding='same')(x)

# b2 模块

B2模块

第二模块使用2个卷积层:首先是64通道的1×1卷积层,然后是将通道增大3倍的3×3卷积层。

# b2 模块

# 卷积层1*1的卷积核,步长为1,pad是same,激活函数RELU

x = tf.keras.layers.Conv2D(64, kernel_size=1, padding='same', activation='relu')(x)

# 卷积层3*3的卷积核,步长为1,pad是same,激活函数RELU

x = tf.keras.layers.Conv2D(192, kernel_size=3, padding='same', activation='relu')(x)

# 最大池化:窗口大小为3*3,步长为2,pad是same

x = tf.keras.layers.MaxPool2D(pool_size=3, strides=2, padding='same')(x)

B3模块

第三模块串联2个完整的Inception块。第一个Inception块的输出通道数为64+128+32+32=256。第二个Inception块输出通道数增至128+192+96+64=480。

# b3 模块

# Inception

x = Inception(64, (96, 128), (16, 32), 32)(x)

# Inception

x = Inception(128, (128, 192), (32, 96), 64)(x)

# 最大池化:窗口大小为3*3,步长为2,pad是same

x = tf.keras.layers.MaxPool2D(pool_size=3, strides=2, padding='same')(x)

B4模块

第四模块更加复杂。它串联了5个Inception块,其输出通道数分别是192+208+48+64=512、160+224+64+64=512、128+256+64+64=512、112+288+64+64=528和256+320+128+128=832。并且增加了辅助分类器,根据实验发现网络的中间层具有很强的识别能力,为了利用中间层抽象的特征,在某些中间层中添加含有多层的分类器,如下图所示:

实现如下图所示

def aux_classifier(x, filter_size):

#x:输入数据,filter_size:卷积层卷积核个数,全连接层神经元个数

# 池化层

x = tf.keras.layers.AveragePooling2D(

pool_size=5, strides=3, padding='same')(x)

# 1x1 卷积层

x = tf.keras.layers.Conv2D(filters=filter_size[0], kernel_size=1, strides=1,

padding='valid', activation='relu')(x)

# 展平

x = tf.keras.layers.Flatten()(x)

# 全连接层1

x = tf.keras.layers.Dense(units=filter_size[1], activation='relu')(x)

# softmax输出层

x = tf.keras.layers.Dense(units=10, activation='softmax')(x)

return x

b4模块的实现:

# b4 模块

# Inception

x = Inception(192, (96, 208), (16, 48), 64)(x)

# 辅助输出1

aux_output_1 = aux_classifier(x, [128, 1024])

# Inception

x = Inception(160, (112, 224), (24, 64), 64)(x)

# Inception

x = Inception(128, (128, 256), (24, 64), 64)(x)

# Inception

x = Inception(112, (144, 288), (32, 64), 64)(x)

# 辅助输出2

aux_output_2 = aux_classifier(x, [128, 1024])

# Inception

x = Inception(256, (160, 320), (32, 128), 128)(x)

# 最大池化

x = tf.keras.layers.MaxPool2D(pool_size=3, strides=2, padding='same')(x)

B5模块

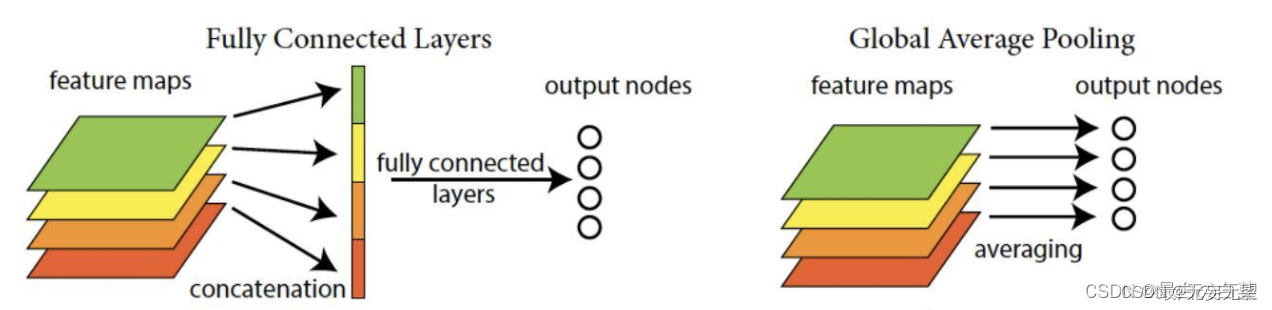

第五模块有输出通道数为256+320+128+128=832和384+384+128+128=1024的两个Inception块。后面紧跟输出层,该模块使用全局平均池化层(GAP)来将每个通道的高和宽变成1。最后输出变成二维数组后接输出个数为标签类别数的全连接层。

全局平均池化层(GAP)

用来替代全连接层前的Flatten,将特征图每一通道中所有像素值相加后求平均,得到就是GAP的结果,在将其送入后续网络中进行计算

实现过程是:

# b5 模块

# Inception

x = Inception(256, (160, 320), (32, 128), 128)(x)

# Inception

x = Inception(384, (192, 384), (48, 128), 128)(x)

# GAP

x = tf.keras.layers.GlobalAvgPool2D()(x)

# 输出层

main_outputs = tf.keras.layers.Dense(10,activation='softmax')(x)

# 使用Model来创建模型,指明输入和输出

构建GoogLeNet模型并通过summary来看下模型的结构:

# 使用Model来创建模型,指明输入和输出

model = tf.keras.Model(inputs=inputs, outputs=[main_outputs,aux_output_1,aux_output_2])

model.summary()

4.3 ResNet

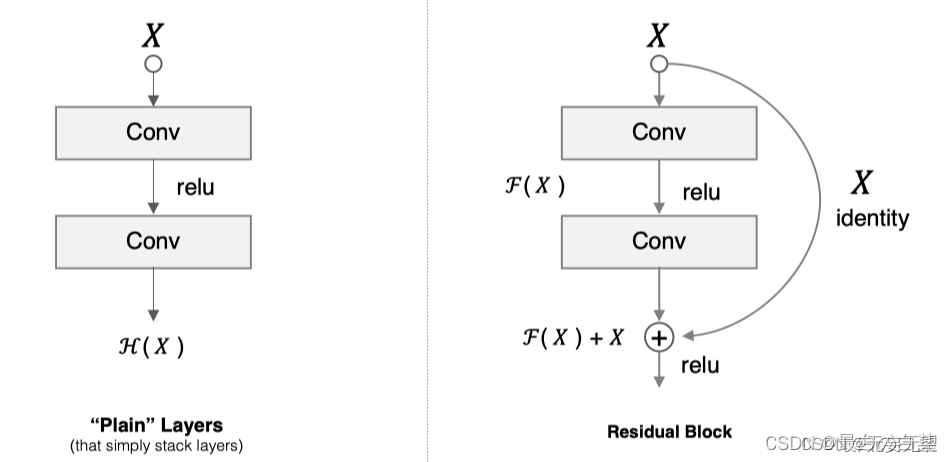

网络越深,获取的信息就越多,特征也越丰富。但是在实践中,随着网络的加深,优化效果反而越差,测试数据和训练数据的准确率反而降低了。针对这一问题,何恺明等人提出了残差网络(ResNet)在2015年的ImageNet图像识别挑战赛夺魁,并深刻影响了后来的深度神经网络的设计。

残差块

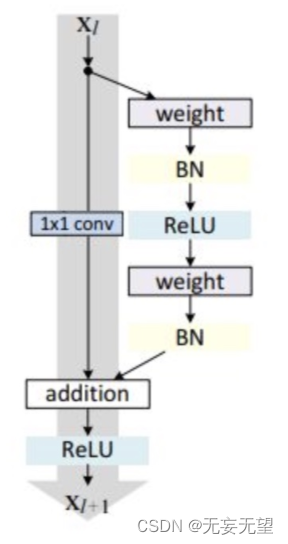

假设 F(x) 代表某个只包含有两层的映射函数, x 是输入, F(x)是输出。假设他们具有相同的维度。在训练的过程中我们希望能够通过修改网络中的 w和b去拟合一个理想的 H(x)(从输入到输出的一个理想的映射函数)。也就是我们的目标是修改F(x) 中的 w和b逼近 H(x) 。如果我们改变思路,用F(x) 来逼近 H(x)-x ,那么我们最终得到的输出就变为 F(x)+x(这里的加指的是对应位置上的元素相加,也就是element-wise addition),这里将直接从输入连接到输出的结构也称为shortcut,那整个结构就是残差块,ResNet的基础模块。

ResNet沿用了VGG全3×33×3卷积层的设计。残差块里首先有2个有相同输出通道数的3×33×3卷积层。每个卷积层后接BN层和ReLU激活函数,然后将输入直接加在最后的ReLU激活函数前,这种结构用于层数较少的神经网络中,比如ResNet34。若输入通道数比较多,就需要引入1×11×1卷积层来调整输入的通道数,这种结构也叫作瓶颈模块,通常用于网络层数较多的结构中。如下图所示:

上图左中的残差块的实现如下,可以设定输出通道数,是否使用1*1的卷积及卷积层的步幅。

# 导入相关的工具包

import tensorflow as tf

from tensorflow.keras import layers, activations

# 定义ResNet的残差块

class Residual(tf.keras.Model):

# 指明残差块的通道数,是否使用1*1卷积,步长

def __init__(self, num_channels, use_1x1conv=False, strides=1):

super(Residual, self).__init__()

# 卷积层:指明卷积核个数,padding,卷积核大小,步长

self.conv1 = layers.Conv2D(num_channels,

padding='same',

kernel_size=3,

strides=strides)

# 卷积层:指明卷积核个数,padding,卷积核大小,步长

self.conv2 = layers.Conv2D(num_channels, kernel_size=3, padding='same')

if use_1x1conv:

self.conv3 = layers.Conv2D(num_channels,

kernel_size=1,

strides=strides)

else:

self.conv3 = None

# 指明BN层

self.bn1 = layers.BatchNormalization()

self.bn2 = layers.BatchNormalization()

# 定义前向传播过程

def call(self, X):

# 卷积,BN,激活

Y = activations.relu(self.bn1(self.conv1(X)))

# 卷积,BN

Y = self.bn2(self.conv2(Y))

# 对输入数据进行1*1卷积保证通道数相同

if self.conv3:

X = self.conv3(X)

# 返回与输入相加后激活的结果

return activations.relu(Y + X)

1*1卷积用来调整通道数。

ResNet模型的构成如下图所示:

ResNet网络中按照残差块的通道数分为不同的模块。第一个模块前使用了步幅为2的最大池化层,所以无须减小高和宽。之后的每个模块在第一个残差块里将上一个模块的通道数翻倍,并将高和宽减半。

下面我们来实现这些模块。注意,这里对第一个模块做了特别处理。

# ResNet网络中模块的构成

class ResnetBlock(tf.keras.layers.Layer):

# 网络层的定义:输出通道数(卷积核个数),模块中包含的残差块个数,是否为第一个模块

def __init__(self,num_channels, num_residuals, first_block=False):

super(ResnetBlock, self).__init__()

# 模块中的网络层

self.listLayers=[]

# 遍历模块中所有的层

for i in range(num_residuals):

# 若为第一个残差块并且不是第一个模块,则使用1*1卷积,步长为2(目的是减小特征图,并增大通道数)

if i == 0 and not first_block:

self.listLayers.append(Residual(num_channels, use_1x1conv=True, strides=2))

# 否则不使用1*1卷积,步长为1

else:

self.listLayers.append(Residual(num_channels))

# 定义前向传播过程

def call(self, X):

# 所有层依次向前传播即可

for layer in self.listLayers.layers:

X = layer(X)

return X

ResNet的前两层跟之前介绍的GoogLeNet中的一样:在输出通道数为64、步幅为2的7×77×7卷积层后接步幅为2的3×33×3的最大池化层。不同之处在于ResNet每个卷积层后增加了BN层,接着是所有残差模块,最后,与GoogLeNet一样,加入全局平均池化层(GAP)后接上全连接层输出。

# 构建ResNet网络

class ResNet(tf.keras.Model):

# 初始化:指定每个模块中的残差快的个数

def __init__(self,num_blocks):

super(ResNet, self).__init__()

# 输入层:7*7卷积,步长为2

self.conv=layers.Conv2D(64, kernel_size=7, strides=2, padding='same')

# BN层

self.bn=layers.BatchNormalization()

# 激活层

self.relu=layers.Activation('relu')

# 最大池化层

self.mp=layers.MaxPool2D(pool_size=3, strides=2, padding='same')

# 第一个block,通道数为64

self.resnet_block1=ResnetBlock(64,num_blocks[0], first_block=True)

# 第二个block,通道数为128

self.resnet_block2=ResnetBlock(128,num_blocks[1])

# 第三个block,通道数为256

self.resnet_block3=ResnetBlock(256,num_blocks[2])

# 第四个block,通道数为512

self.resnet_block4=ResnetBlock(512,num_blocks[3])

# 全局平均池化

self.gap=layers.GlobalAvgPool2D()

# 全连接层:分类

self.fc=layers.Dense(units=10,activation=tf.keras.activations.softmax)

# 前向传播过程

def call(self, x):

# 卷积

x=self.conv(x)

# BN

x=self.bn(x)

# 激活

x=self.relu(x)

# 最大池化

x=self.mp(x)

# 残差模块

x=self.resnet_block1(x)

x=self.resnet_block2(x)

x=self.resnet_block3(x)

x=self.resnet_block4(x)

# 全局平均池化

x=self.gap(x)

# 全链接层

x=self.fc(x)

return x

# 模型实例化:指定每个block中的残差块个数

mynet=ResNet([2,2,2,2])

这里每个模块里有4个卷积层(不计算 1×1卷积层),加上最开始的卷积层和最后的全连接层,共计18层。这个模型被称为ResNet-18。通过配置不同的通道数和模块里的残差块数可以得到不同的ResNet模型,例如更深的含152层的ResNet-152。虽然ResNet的主体架构跟GoogLeNet的类似,但ResNet结构更简单,修改也更方便。这些因素都导致了ResNet迅速被广泛使用。 在训练ResNet之前,我们来观察一下输入形状在ResNe的架构:

X = tf.random.uniform(shape=(1, 224, 224 , 1))

y = mynet(X)

mynet.summary()

Model: "res_net"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

conv2d_2 (Conv2D) multiple 3200

_________________________________________________________________

batch_normalization_2 (Batch multiple 256

_________________________________________________________________

activation (Activation) multiple 0

_________________________________________________________________

max_pooling2d (MaxPooling2D) multiple 0

_________________________________________________________________

resnet_block (ResnetBlock) multiple 148736

_________________________________________________________________

resnet_block_1 (ResnetBlock) multiple 526976

_________________________________________________________________

resnet_block_2 (ResnetBlock) multiple 2102528

_________________________________________________________________

resnet_block_3 (ResnetBlock) multiple 8399360

_________________________________________________________________

global_average_pooling2d (Gl multiple 0

_________________________________________________________________

dense (Dense) multiple 5130

=================================================================

Total params: 11,186,186

Trainable params: 11,178,378

Non-trainable params: 7,808

_________________________________________________________________

参考:

代码:mmpretrian

5743

5743

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?