今天,开始写一个新的系列《大模型RAG实战》。上个月我在2篇文章中,介绍了如何使用LlamaIndex框架,通过少量代码,实现本地可部署和运行的大模型RAG问答系统。我们要开发一个生产级的系统,还需要对LlamaIndex的各个组件和技术进行深度的理解、运用和调优。本系列将会聚焦在如何让系统实用上,包括:知识库的管理,检索和查询效果的提升,使用本地化部署的模型等主题。我将会讲解相关的组件和技术,辅以代码示例。最终这些文章中的代码将形成一套实用系统。

过去一年,大模型的发展突飞猛进。月之暗面的Kimi爆火,Llama3开源发布,大模型各项能力提升之大有目共睹。

对于大模型检索增强生成(RAG)系统来说,我们越来越认识到,其核心不在于模型的能力,而是在于如何更好地构建和使用知识库,提升检索的效能。

1

知识库的三类数据

无论是企业还是个人,我们构建知识库,自然希望高质量的数据越多越好。这些数据主要分为三类。

-

文件:电脑上为数众多的文件资料,包括方案、文稿、产品资料等,通常为PDF、DOCX、PPT等格式

-

网页:收集的网页信息,比如我们在微信上打开和阅读的公众号文章。如果觉得这些文章有用,会收藏起来

-

数据库:保存在各种数据库中的文本信息,比如企业内部的信息系统,会记录用户提出的问题与相应的解决方案

对于个人用户,建立个人知识库,主要是电脑上的文件资料和收藏的网页信息。而对于企业来说,接入和利用已有信息系统的数据库中的文本数据,也非常关键。

LlamaIndex是一个专门针对构建RAG系统开发的开源数据框架,对于以上三类数据的处理,都提供了很好的支持。

2

数据处理的四个步骤

无论是哪一类数据,LlamaIndex处理数据的过程,都分为四步:

1)加载数据(Load)

LlamaIndex提供了众多数据接入组件(Data Connector),可以加载文件、网页、数据库,并提取其中的文本,形成文档(Document)。未来还将能提取图片、音频等非结构化数据。

最常用的是SimpleDirectoryReader,用来读取文件系统指定目录中的PDF、DOCX、JPG等文件。

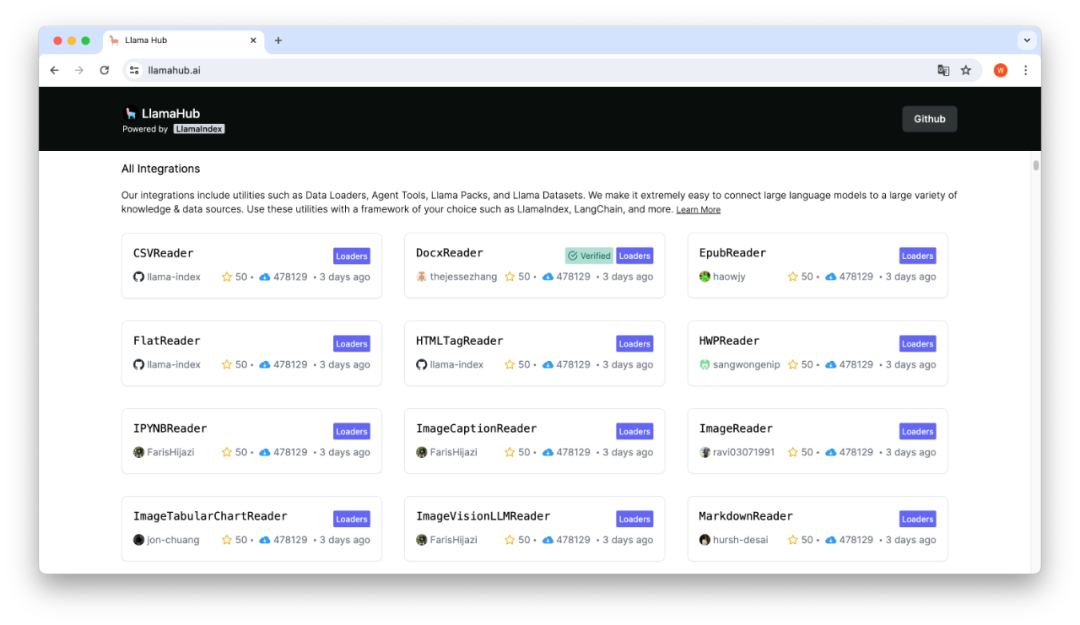

我们在LlamaHub上,可以找到数百个数据接入组件,用来加载各种来源与格式的数据,比如电子书epub格式文件的接入组件。

2) 转换数据(Transform)

类似传统的ETL,转换数据是对文本数据的清洗和加工。通常,输入是文档(Document),输出是节点(Node)。

数据处理的过程,主要是将文本分割为文本块(Chunk),并通过嵌入模型,对文本块进行嵌入(Embedding)。同时,可提取元数据(Metadata),例如原文件的文件名和路径。

这里有两个重要的参数,chunk_size和chunk_overlap,分别是文本块分割的大小,和相互之间重叠的大小。我们需要调整这些参数,从而达到最好的检索效果。

3)建立索引(Index)

索引是一种数据结构,以便于通过大语言模型(LLM)来查询生成的节点。

最常使用的是向量存储索引(Vector Store Index),这种方式把每个节点(Node)的文本,逐一创建向量嵌入(vector embeddings),可以理解是文本语义的一种数字编码。

不同于传统的关键词匹配,通过向量检索,比如余弦相似度,我们可以找到语义相近的文本,尽管在文字上有可能截然不同。

4)存储数据(Store)

默认情况下,以上操作生成的数据都保存在内存中。要避免每次重来,我们需要将这些数据进行持久化处理。

LlamaIndex 提供了内置的persisit()方法,将索引数据持久化保存在磁盘文件中。更常见的做法是通过索引存储器(Index Store),将索引保存在向量数据库中,如Chroma、LanceDB等。

知识库的管理,不仅要保存索引数据,也要保存所有文档(Document)及其提取的节点(Node)。

LLamaIndex提供了文档存储器(Document Store),把这些文本数据保存在MongoDB、Redis等NoSQL数据库中,这样我们可以对每一个节点进行增删改查。

3

代码实现示例

下面结合代码,介绍构建知识库的过程。

我们将使用LlamaIndex来加载和转换文档和网页数据,建立向量索引,并把索引保存在Chroma,把文档和节点保存在MongoDB。

示例1:加载本地文件

对于在本地文件系统中的文件,LlamaIndex提供了非常简便的方法来读取:SimpleDirectoryReader。

我们只需要将已有的文件,放在指定的目录下,比如./data,通过这个方法就可以全部加载该目录下的所有文件,包括子目录中的文件。

from llama_index.core import SimpleDirectoryReader``documents = SimpleDirectoryReader(input_dir="./data", recursive=True).load_data()` `print(f"Loaded {len(documents)} Files")

如果,我们在知识库中上传了新的文件,还可以指定加载这个文件,而非读取整个目录。

SimpleDirectoryReader(input_files=["path/to/file1", "path/to/file2"])

文件加载后,LlamaIndex会逐一提取其中的文本信息,形成文档(Document)。通常一个文件对应一个文档。

****示例2:加载网页信息

LlamaIndex读取和加载网页信息也很简单。这里,我们用到另一个工具SimpleWebPageReader。

给出一组网页的URL,我们使用这个工具可以提取网页中的文字信息,并分别加载到文档(Document)中。

pages = ["https://mp.weixin.qq.com/s/LQNWNp7nI_hI1iFpuZ9Dfw",` `"https://mp.weixin.qq.com/s/m8eI2czdXT1knX-Q20T6OQ",` `"https://mp.weixin.qq.com/s/prnDzOQ8HjUmonNp0jhRfw",` `"https://mp.weixin.qq.com/s/YB44--865vYkmUJhEv73dQ",` `"https://mp.weixin.qq.com/s/SzON91-fZgkQvzdzkXJoCA",` `"https://mp.weixin.qq.com/s/zVlKUxJ_C6GjTh0ePS-f8w",` `"https://mp.weixin.qq.com/s/gXlX_8mKnQSmI0R1me40Ag",` `"https://mp.weixin.qq.com/s/z9eV8Q8TJ4c-IhvJ1Ag34w"]`` ``documents = SimpleWebPageReader(html_to_text=True).load_data(` `pages``)``print(f"Loaded {len(documents)} Web Pages")

代码中我给出的网页,是我写的《大卫说流程》系列文章。你可以改为任何你想读取的网页。未来,你可以针对这些网页内容来向大模型提问。

使用这个工具,我们需要安装llama-index-readers-web和html2text组件。为了行文简洁,未来不再说明。你可以在运行代码时根据提示,安装所需的Python库和组件。

****示例3:分割数据成块

接下来,我们通过文本分割器(Text Splitter)将加载的文档(Document)分割为多个节点(Node)。

LlamaIndex使用的默认文本分割器是SentenceSplitter。我们可以设定文本块的大小是256,重叠的大小是50。文本块越小,那么节点的数量就越多。

from llama_index.core.node_parser import SentenceSplitter``nodes = SentenceSplitter(chunk_size=256, chunk_overlap=50).get_nodes_from_documents(documents)``print(f"Load {len(nodes)} Nodes")

之前我介绍过文本分割器Spacy,对中文支持更好。我们可以通过Langchain引入和使用。

from llama_index.core.node_parser import LangchainNodeParser``from langchain.text_splitter import SpacyTextSplitter``spacy_text_splitter = LangchainNodeParser(SpacyTextSplitter(` `pipeline="zh_core_web_sm",`` chunk_size = 256,` `chunk_overlap = 50``))

****示例4:数据转换管道与知识库去重

上一步给出的数据转换方法,其实并不实用。问题在于没有对文档进行管理。我们重复运行时,将会重复加载,导致知识库内重复的内容越来越多。

为了解决这个问题,我们可以使用LlamaIndex提供的数据采集管道(Ingestion Pipeline)的功能,默认的策略为更新插入(upserts),实现对文档进行去重处理。

from llama_index.core.ingestion import IngestionPipeline``pipeline = IngestionPipeline(` `transformations=[` `spacy_text_splitter,` `embed_model,` `],` `docstore=MongoDocumentStore.from_uri(uri=MONGO_URI),` `vector_store=chroma_vector_store,``)``nodes = pipeline.run(documents=documents)``print(f"Ingested {len(nodes)} Nodes")

****示例5:索引与存储的配置

在上面的数据采集管道的代码示例中,我们配置了用来生成向量索引的嵌入模型(embed_model),以及采用Chroma作为向量库,MongoDB作为文档库,对数据进行持久化存储。

嵌入模型的配置如下。这里我们通过之前介绍过的HugginFace的命令行工具,将BAAI的bge-small-zh-v1.5嵌入模型下载到本地,放在“localmodels”目录下。

from llama_index.embeddings.huggingface import HuggingFaceEmbedding``embed_model = HuggingFaceEmbedding(model_name="./localmodels/bge-small-zh-v1.5")

然后配置向量库,Chroma将把数据存储在我们指定的“storage”目录下。

import chromadb``from llama_index.vector_stores.chroma import ChromaVectorStore``db = chromadb.PersistentClient(path="./storage")``chroma_collection = db.get_or_create_collection("think")``chroma_vector_store = ChromaVectorStore(chroma_collection=chroma_collection)

我们可以使用Redis或MongoDB来存储处理后的文档、节点及相关信息,包括文档库(docstore)和索引信息库(index_store)。

作为示例,我们选用在本机上安装的MongoDB。

from llama_index.core import StorageContext``from llama_index.storage.docstore.mongodb import MongoDocumentStore``from llama_index.storage.index_store.mongodb import MongoIndexStore`` ``MONGO_URI = "mongodb://localhost:27017"`` ``storage_context = StorageContext.from_defaults(` `docstore=MongoDocumentStore.from_uri(uri=MONGO_URI),` `index_store=MongoIndexStore.from_uri(uri=MONGO_URI),` `vector_store=chroma_vector_store,``)

****示例6:构建知识库

现在,我们可以将此前的数据采集管道生成的文档和节点,载入到文档知识库中(docstore)。

storage_context.docstore.add_documents(nodes)``print(f"Load {len(storage_context.docstore.docs)} documents into docstore")

这步完成后,我们在MongoDB中,可以找到一个名为“db_docstore”的数据库,里面有三张表,分别是:

-

docstore/data

-

docstore/metadata

-

docstore/ref_doc_info

我们可以通过MongoDB,来查询相关的文档和节点,元数据以及节点之间的关系信息。

未来,当你有更多的文件和网页需要放入知识库中,只需要遵循以上的步骤加载和处理。

****示例7:实现RAG问答

完成知识库的构建之后,我们可以设定使用本地的LLM,比如通过Ollama下载使用Gemma 2B模型。

然后,加载索引,生成查询引擎(Query Engine),你就可以针对知识库中的内容进行提问了。

from llama_index.llms.ollama import Ollama``llm_ollama = Ollama(model="gemma:2b", request_timeout=600.0)``Settings.llm = llm_ollama`` ``from llama_index.core import VectorStoreIndex``index = VectorStoreIndex.from_vector_store(` `vector_store=chroma_vector_store,` `)`` ``query_engine = index.as_query_engine()``response = query_engine.query("流程有哪三个特征?")

以上,主要介绍了使用LlamaIndex构建知识库的过程。

未来,我们可以结合Streamlit、Flask等前端框架,进一步开发成一个完善的知识库管理系统,以便对知识内容进行持续的增加与更新,并支持灵活的配置文本分割的各项参数和选择嵌入模型。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

2024最新版CSDN大礼包:《AGI大模型学习资源包》免费分享

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

2895

2895

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?