欢迎大家点赞、收藏、关注、评论啦 ,由于篇幅有限,只展示了部分核心代码。

一项目简介

一、项目背景与意义

手写数字识别是计算机视觉和机器学习领域的一个经典问题。MNIST数据集包含了大量手写数字的图片和对应的标签,是初学者和研究者们常用的数据集之一。通过使用卷积神经网络(CNN)对MNIST数据集进行训练和测试,我们可以构建一个能够自动识别和分类手写数字的系统。这不仅能够帮助我们理解卷积神经网络的工作原理,还能为更复杂的图像识别任务提供基础。

二、项目目标

构建一个基于TensorFlow的卷积神经网络模型。

使用MNIST数据集对模型进行训练和测试。

评估模型的性能,包括准确率、损失等指标。

对模型进行优化,以提高手写数字识别的准确率。

三、技术实现

数据预处理:

加载MNIST数据集,并将其划分为训练集、验证集和测试集。

对图像数据进行归一化处理,使其像素值范围在0到1之间。

如果需要,可以对图像进行增强,如旋转、平移等操作,以增加模型的泛化能力。

构建CNN模型:

定义一个包含多个卷积层、池化层和全连接层的CNN模型。

选择合适的激活函数(如ReLU)、损失函数(如交叉熵损失)和优化器(如Adam)。

设置模型的超参数,如学习率、批次大小、训练轮数等。

训练模型:

使用训练集对模型进行训练,通过反向传播算法更新模型的权重和偏置。

在训练过程中,使用验证集对模型进行验证,以评估模型的性能并防止过拟合。

记录训练过程中的损失值和准确率等指标,以便后续分析和优化。

测试模型:

使用测试集对训练好的模型进行测试,评估模型在手写数字识别任务上的性能。

计算并输出模型的准确率、混淆矩阵等指标。

模型优化:

根据测试结果对模型进行优化,如调整网络结构、改变超参数、使用正则化技术等。

重复训练和测试过程,直到模型性能达到要求。

四、项目特点与优势

经典数据集:MNIST数据集是手写数字识别领域的经典数据集,具有广泛的应用和参考价值。

深度学习技术:使用卷积神经网络作为模型基础,能够自动学习图像中的特征表示,提高识别准确率。

可视化工具:TensorFlow提供了丰富的可视化工具,如TensorBoard,可以帮助我们更好地理解模型的训练过程和性能表现。

可扩展性:基于本项目的CNN模型可以很容易地扩展到其他类似的图像识别任务中,如人脸识别、物体检测等。

二、功能

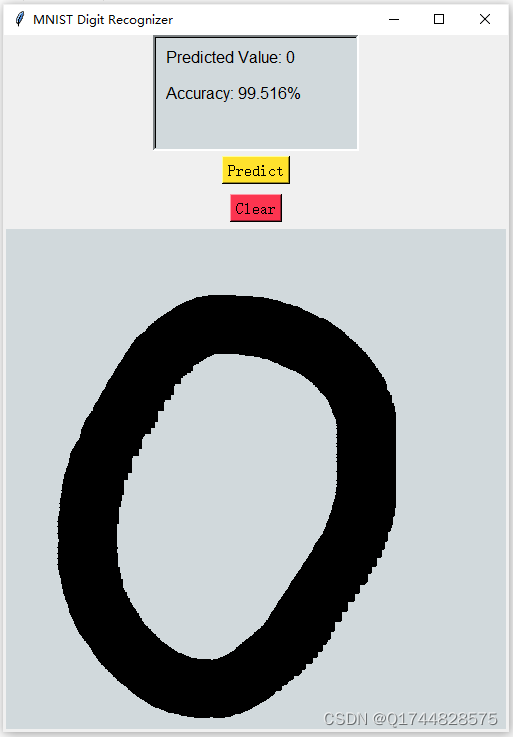

基于Tensorflow CNN网络MNIST数据集手写数字识别

三、系统

四. 总结

手写数字识别技术在许多领域都有广泛的应用前景,如银行支票处理、邮政编码识别、自动驾驶中的交通标志识别等。通过本项目的实践,我们可以掌握基于TensorFlow的CNN模型构建和训练方法,为后续更复杂的图像识别任务打下坚实的基础。

826

826

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?