摘要

多变量时间序列的预测是一个重要问题,在交通管理、蜂窝网络配置和量化金融等领域有广泛应用。当存在一个图形来描述时间序列之间的关系时,这个问题的一个特殊情况就出现了。在本文中,我们提出了一种新颖的学习架构,其性能与或优于现有最佳算法相媲美,而无需了解图形的知识。我们提出架构的关键元素是可学习的全连接硬图形门控机制,它使得在交通预测应用中可以使用最先进且高度计算效率的全连接时间序列预测架构。两个公共交通网络数据集的实验结果说明了我们方法的价值,剖析研究证实了该架构的每个元素的重要性。我们的代码可在以下链接找到:https://github.com/boreshkinai/fc-gaga。

1 引言

许多多变量时间序列(TS)预测问题自然地适用于图形模型的制定。特别是在那些通过简单因果关系相互影响的实体中,过去被观察到的实体和需要预测未来的实体。例如,在商店引入百事可乐产品很可能会降低未来可口可乐的销售额;高速公路上某一点的车流拥堵可能会减缓前面高速公路段的交通流量。如果没有图形建模,模型将对这些细微差别视而不见,使得实体间的相互作用变成了一堆混杂的因素,这极大地增加了模型的解释和预测难度。 通过拥有一个可学习的实体属性模型(例如实体嵌入)、一个实体间关系模型(例如图形边缘权重)以及将它们与TS模型连接的机制(例如门控机制),我们可以学习这些通常未知的实体间相互作用,以提高预测精度。

适用于图形TS建模的问题包括预测相关产品的需求(Singh等,2019),电力需求(Rolnick等,2019),道路交通(Shi等,2020)或乘客需求(Bai等,2019)。最近的研究表明,那些明确考虑到跨多个TS的基础关系的模型优于那些将每个TS单独预测的模型。虽然图形建模的引入已经被证明可以提高准确性,但当前的模型仍然存在几个严重的限制。首先,这些模型的复杂性和因此运行时显著较高。其次,一些模型依赖于领域专家提供的变量间关系的定义(例如,根据观察到的变量之间的地理关系启发式地定义邻接矩阵)。最后,现有的模型倾向于依赖马尔可夫假设,以便使得对跨变量间相互作用的建模成为可能。

为了解决这些限制,我们提出了一种新颖的架构,称为FC-GAGA,它基于一个完全连接的TS模型N-BEATS(Oreshkin等,2020)和本文提出的硬图形门控机制的组合。为了生成单个TS(图形模型中的节点)的预测,它使用可学习的图形权重来衡量所有其他节点的历史观测值,通过ReLU对它们进行门控,然后堆叠所有节点的门控观测值,通过全连接残差块进行处理(见图1)。

这种架构的优点有三个:

- 首先,该架构不依赖于对底层图的知识,而是专注于学习所有所需的非线性预测关系。

- 其次,该架构的基本层可堆叠,我们允许每一层学习自己的图形结构。这赋予了模型学习非马尔可夫信息扩散过程的能力,这个过程可以被有效地学习,我们在实验证明了这一点。

- 最后,FC-GAGA是一个非常高效的内存和计算效率架构,我们通过性能分析进行了证明。剖析研究表明,当使用高效的全连接残差时间序列预测模块时,仅仅使用标准的图形注意力是不够的——我们提出的新颖图形门控实现的稀疏性对于实现良好的预测性能至关重要。

重点内容:

- 问题描述:多变量时间序列(TS)预测在交通管理、电力需求、道路交通和乘客需求等领域具有重要应用。当实体通过简单的因果关系相互影响时,问题通常可被建模成图形模型。然而,传统模型无法准确捕捉这些实体间的复杂关系。

- 图形建模的重要性:引入图形模型可以解决实体间相互作用的问题。例如,引入新产品可能影响其他产品的销售,交通拥堵可能影响前面的交通流量。图形模型帮助了解这些细微关系,提高了预测的准确性。

- 现有问题和限制:现有的图形TS预测模型存在复杂性高、运行时间长、依赖专家定义的关系、以及依赖马尔可夫假设等问题。

- 提出的解决方案:提出了一种新的架构,命名为FC-GAGA,结合了N-BEATS模型和本文提出的硬图形门控机制。该架构不依赖于底层图的知识,允许每一层学习自己的图形结构,并且具有非常高效的内存和计算性能。

1.1 问题陈述

假设一个图G = (V,E)被定义为顶点的有序集合,V = 1, . . . ,N,和边的集合,E

⊂

\subset

⊂ V

×

\times

×V。我们关注的是定义在这个图上的多变量时间序列(TS)预测问题。假设图中的每个顶点 v 生成一个观测序列,yv = [yv,1 . . . , yv,T] ∈ RT,受一个未知的随机过程控制。假定E中编码的图的连接性捕捉了顶点之间的未知关系。例如,图的边E可能反映了道路网络中道路的连接性,而yv可能是交通速度的观察序列。任务是基于截至时间T内由图中所有顶点生成的观察,预测每个顶点v的未来数值向量 yv∈ RH = [yT+1,yT+2, . . . , yT+H]。在顶点v处,长度为w ≤ T的模型输入,以最后一个观察值yv,T结束,表示为xv ∈ Rw = [yv,T−w+1, . . . ,yv,T]。我们用y表示在顶点 v 处 yv 的点预测。

指标:

我们通过平均绝对误差(MAE)、平均绝对百分比误差(MAPE)和均方根误差(RMSE)来衡量准确性:

MAE

=

1

N

∑

v

=

1

N

∣

y

v

,

T

+

H

−

y

^

v

,

T

+

H

∣

\text{MAE} = \frac{1}{N} \sum_{v=1}^{N} |y_{v,T+H} - \hat{y}_{v,T+H}|

MAE=N1∑v=1N∣yv,T+H−y^v,T+H∣,

MAPE

=

1

N

∑

v

=

1

N

∣

y

v

,

T

+

H

−

y

^

v

,

T

+

H

y

v

,

T

+

H

∣

\text{MAPE} = \frac{1}{N} \sum_{v=1}^{N} \left| \frac{y_{v,T+H} - \hat{y}_{v,T+H}}{y_{v,T+H}} \right|

MAPE=N1∑v=1N

yv,T+Hyv,T+H−y^v,T+H

,

RMSE

=

1

N

∑

v

=

1

N

(

y

v

,

T

+

H

−

y

^

v

,

T

+

H

)

2

\text{RMSE} = \sqrt{\frac{1}{N} \sum_{v=1}^{N} (y_{v,T+H} - \hat{y}_{v,T+H})^2}

RMSE=N1∑v=1N(yv,T+H−y^v,T+H)2

1.2 贡献概述

我们提出了一种新的原理,将完全连接的最先进的单变量TS预测模型NBEATS(Oreshkin et al. 2020)与可学习的时间门和可学习的硬图门机制相结合。我们的经验表明,该模型可以有效地从数据中学习图形参数,并实现令人印象深刻的预测性能。我们表明,所提出的模型提供了计算优势,并减少了至少三个因素的训练时间相对于具有类似精度的模型。

2 FC-GAGA

提议架构的块状图如图1所示。我们通过维度为d的嵌入向量来表示节点i,即ei = [ei,1, . . . ei,d]。所有这些向量的集合形成了节点嵌入矩阵E ∈ RN×d。以下我们描述单个层的操作,为了清晰起见,省略了层索引。

图1:FC-GAGA块图。每个层包括一个图门控机制,一个时间门控机制和一个全连接时间序列模型。

图的边权

节点链接的强度被编码在从节点嵌入导出的权重矩阵W ∈ RN×N中:

W

=

exp

(

ε

E

E

T

)

(1)

W = \exp(\varepsilon EE^T)\tag{1}

W=exp(εEET)(1)

这里,ε是被设置为允许在架构的其他部分中使用的E的缩放与实现W中的必要动态范围所需的缩放解耦的参数。我们期望边权重Wi,j的幅度将反映给定FC-GAGA层处的节点对(i,j)之间的相互影响的强度。

时间门控块

时间门控块对时间协变量特征(例如,一天中的时间、一周中的天等)进行建模。其可以与节点观测一起可用。我们建议使用乘法门模型来对时间相关特征进行建模,该乘法门模型将FCGAGA层的输入/输出除以/乘以经由图1所示的全连接网络从时间特征导出的时间效应。此外,输入时间特征向量与节点嵌入连接,以考虑每个节点可能具有不同的季节性模式的事实。这相当于从块的输入中移除特定于节点的乘法季节性,并在块的输出处再次应用它。我们允许输入和输出时间效应通过单独的线性投影层解耦,因为通常输入和输出的时间是不同的。

图门控块

FC-GAGA层的输入是一个矩阵X ∈ RN×w,其中包含图中所有节点的长度w的历史。我们用

x

~

\tilde{x}

x~表示时间维度上输入值的最大值,

x

i

~

\tilde{x_i}

xi~= maxj Xi,j。选通操作产生矩阵G ∈ RN×Nw。门控矩阵的第i行对应于节点i,并且它包含在过去w步期间由图累积的所有信息:

G

i

,

j

+

k

=

RELU

[

(

W

i

,

j

×

X

j

,

k

−

ε

x

i

)

ε

x

i

]

(2)

G_{i,j+k} = \text{RELU}\left[\frac{(W_{i,j} \times X_{j,k} - \varepsilon x_i)}{\varepsilon x_i}\right] \tag{2}

Gi,j+k=RELU[εxi(Wi,j×Xj,k−εxi)](2)

图形门控(Graph Gate)通过两种机制相关联了节点i、j收集的信息。首先,节点 i i i 和节点 j j j 中的测量值通过RELU内部的减法和水平操作相互关联。此外,RELU操作通过关闭无关的 i i i , j j j对而不影响通过 W i , j W_{i,j} Wi,j实现的比例调整,起到了屏蔽的作用。W~i, j~的大小影响着打开硬门的概率。我们的经验研究表明, W i , j W_{i,j} Wi,j的大小与节点之间的空间接近度相关(见图3和图4)。我们发现,如果没有硬门控制,图权重计算就不够有效。我们认为这是因为对于每个目标节点,在给定层次上只有很少的节点是相关的,所以完全连接架构的输入应该是稀疏的。硬门控制鼓励稀疏性。软门控提供的输入不是稀疏的,它会因为来自图中许多节点的太多低幅度输入而使完全连接网络不堪重负。此外,根据本节末尾所提供的复杂性分析,我们的图形门控设计具有较小的复杂性,为 O ( N 2 ) O(N^2) O(N2),与文献中基于图扩散步骤中的矩阵乘法的方法(如DCRNN和Graph WaveNet)相比,后者的复杂度为 O ( N 3 ) O(N^3) O(N3)。

全连接时序块

我们提出了一个完全连接的残差结构,L个隐藏层,R个残差块和权重在节点之间共享。它对节点 i i i的输入 Z i Z_i Zi取决于节点嵌入和它自己的历史: Z = [ E , X / x ~ , G ] T Z = [E,X/\tilde{x},G]^T Z=[E,X/x~,G]T, Z ∈ R N ( w + 1 ) + d × N Z ∈ R^{N(w+1)+d×N} Z∈RN(w+1)+d×N。使用残差块和层上标,并将具有权重 A r , ρ A^{r,\rho} Ar,ρ和偏置 b r , ρ b^{r,\rho} br,ρ的全连接层表示为 F C r , ρ ≡ R E L U ( A r , ρ H r , ρ − 1 + b r , ρ ) FC_{r,\rho}\equiv RELU(A^{r,\rho} H^{r,\rho-1}+b^{r,\rho}) FCr,ρ≡RELU(Ar,ρHr,ρ−1+br,ρ),全连接残差TS建模架构的操作描述如下:

Z

r

=

RELU

[

Z

r

−

1

−

Z

^

r

−

1

,

H

r

,

1

=

F

C

r

,

1

(

Z

r

)

,

.

.

.

,

H

r

,

L

=

F

C

r

,

L

(

H

r

,

L

−

1

)

,

Z

^

r

=

B

r

H

r

,

L

,

Y

^

r

=

(

H

r

,

L

)

T

F

r

(3)

Z^r = \text{RELU}[Z^{r-1} - \hat{Z}^{r-1},\\ H^{r,1} = FC_{r,1}(Z^r), . . . , H^{r,L} = FC_{r,L}(H^{r,L-1} ),\\ \hat{Z}^r= B^r H^{r,L}, \hat{Y}^r= (H^{r,L})^TF^r \tag{3}

Zr=RELU[Zr−1−Z^r−1,Hr,1=FCr,1(Zr),...,Hr,L=FCr,L(Hr,L−1),Z^r=BrHr,L,Y^r=(Hr,L)TFr(3)

我们假设

Z

^

0

≡

0

\hat{Z}^0 \equiv 0

Z^0≡0,

Z

0

≡

Z

Z^0\equiv Z

Z0≡Z;投影矩阵的维度为

B

r

∈

R

N

(

w

+

1

)

+

d

×

d

h

B^r \in \mathbb{R}^{N(w+1)+d \times dh}

Br∈RN(w+1)+d×dh,

F

r

∈

R

d

h

×

H

F^r \in \mathbb{R}^{dh \times H}

Fr∈Rdh×H;最终的预测是所有残差块的预测之和,

Y

^

=

∑

r

Y

^

r

\hat{Y} = \sum_r\hat{Y}^r

Y^=∑rY^r。

FC-GAGA层堆叠

基于以下三个原则。首先,下一层接受前几层预测的总和作为输入。其次,每个FC-GAGA层都有自己的一组节点嵌入,因此也有自己的图门。因此,每一层被提供了根据前一层已经完成的处理来门控跨节点的信息流的自由度。例如,在第一FC-GAGA层中,对于节点id 5,关注节点id [10,200,500]的历史可能是最佳的。然而,由于第一FC-GAGA层更新所有节点的状态,节点5可能不再需要节点[10,200,500]或其邻居提供的信息;而是可能希望关注节点id [3和15],因为它们现在提供更重要的信息。这显然是一种比基于节点邻近度的马尔可夫模型更灵活的信息扩散模型,这种模型在交通预测文献中很常见(Li et al. 2018)。最后,最终的模型输出等于层预测的平均值。

复杂度分析

在下面的分析中,我们跳过批量维度,计算当输入历史长度为w,节点嵌入宽度为d,隐藏层宽度为dh时,为图中所有节点N创建长度为H的单个预测所涉及的复杂度。分析详情见附录B。图门块具有复杂度O(N2(w+d)),如从等式(1)显而易见的。(2).时间门机制使用其相关联的时间特征为每个节点产生季节性因子,该时间门机制与节点的数量、隐藏维度、输入历史长度线性缩放:O(N(d+w)dh)。最后,具有L个FC层和R个残差块的全连接TS模型接受平坦化的输入N×Nw,其复杂度为O(R(2N2wdh +(L−2)Nd2 h))。在大多数实际配置中,模型的总复杂度将由O(N2Rwdh)主导。

3 实证结果

数据集

数据集FC-GAGA在两个交通数据集METR-LA和PEMS-BAY(Chen et al. 2001; Li et al. 2018)上进行评估,这些数据集包括从环路检测器收集的交通速度读数,并以5分钟为间隔进行聚合。METRLA包含在洛杉矶县4个月内收集的207个传感器的34,272个时间步长。PEMS-BAY包含在湾区收集的325个传感器的52,116个时间步长。数据集分为70%训练,10%验证和20%测试,如(Li et al. 2018)中所定义。

基线

我们将FC-GAGA与不需要预先指定的图的时间模型以及可能依赖于预先指定的图或具有可学习的图的时空模型进行比较。由Li等人提供的以下单变量时间模型。2018年):ARIMA(Makridakis和Hibon 1997),使用卡尔曼滤波器实现;SVR(Wu,Ho和Lee 2004),线性支持向量回归模型;FNN,前馈神经网络;以及FC-LSTM(Sutskever,Vinyals和Le 2014),序列到序列模型,在编码器和解码器中使用完全连接的LSTM。时空模型包括DCRNN(Li et al.2018)(扩散卷积递归神经网络,序列到序列体系结构中的图卷积网络);STGCN(Yu,Yin,and朱2018)(时空图卷积网络,将图卷积与门控时间卷积合并);Graph WaveNet(Wu等.2019年),融合了图卷积和扩张因果卷积;GMAN(郑等人);2020)(图多注意网络,一种具有多个时空注意块的编解码器模型,以及编码器和解码器之间的变换关注层);STGRAT(Park等人2019年)(用于交通预测的时空图注意网络,使用变压器的位置编码方法的编码器-解码器模型(Vaswani等人)。2017)捕获长序列的特征和节点注意力以捕获空间相关性)。在这些方法中,只有Graph WaveNET可以在没有预先指定的图的情况下生成预测。对于DCRNN,我们在代码中报告了错误修复后的结果,比本文报告的结果要好。对于STGCN、Graph WaveNet、GMAN和STGRAT,我们使用原始论文的设置和报告结果。

FC-GAGA架构详细信息和培训设置

(1)中的标量ε被设置为10。嵌入维度d设置为64,所有全连接层的隐藏层宽度dh设置为128。全连接TS模型中的层数L等于3,块的数量R等于2。我们使用1 e-5的权重衰减来正则化全连接层。该模型使用Adam优化器进行训练,默认tensorflow设置,初始学习率为0.001,持续60个epochs。学习率从时期43开始每6个时期被退火2倍。一个历元由800个大小为4的批次组成,模型采用12个点的历史记录,并一次性预测12个点(60分钟)。每个训练批次使用从训练集中均匀随机选择的4个时间点和在每个时间点收集的所有节点的历史来组装。METR-LA有207个传感器节点,PEMS-BAY有325个,分别由207 · 4 = 828和325 · 4 = 1300个时间序列组成。用于训练网络的目标函数是MAE,在所有节点上平均,并在H = 12的范围内进行所有预测:

定量结果

我们的主要实证结果见表1。FC-GAGA甚至可以与依赖于METR-LA和PEMS-BAY数据集(DCRNN,STGCN,GraphWaveNet和GMAN)上的额外外部图形定义的基于图形的模型进行比较。大多数情况下,FCGAGA在相同条件下训练和评估时优于Graph WaveNet模型,即两个模型都只依赖于从数据中学习的图(Graph WaveNet只使用从数据中学习的自适应邻接矩阵)。它显著优于单变量模型(ARIMA,SVR,FNN和FC-LSTM)。请注意,STGRAT严重依赖于Transformer架构的主要成分,如位置编码和注意力机制。因此,将FC-GAGA与它进行比较,可以很好地了解我们的方法在准确性方面与基于transformer的方法的区别。

表1:使用标准协议(Wu等,2019)计算的错误指标(平均值为预测时间范围的最后一个时间步,输入窗口长度为12)。数字越低越好。 ‡Graph Wavenet使用作者提供的官方代码训练,仅使用自适应矩阵,没有使用地理邻接矩阵的支持。 ‡ FC-GAGA(4层)是提出的模型,有4层。在第四层,图门控机制的权重被设置为单位矩阵,表示更依赖于纯粹的时间序列组件。

定性结果

最终的FC-GAGA预测由各个层预测的平均值组成。图2显示了不同层对最终15分钟预报的贡献(按平均因子1/3缩放后)。我们可以看到,第一层的作用主要是提供基线预测,同时考虑一些季节性影响。第2层对预测的贡献清楚地捕捉了每日的季节性。第2层,特别是第3层,根据最新的数据,对第1层产生的原始基线提供迭代校正项。这对于层3尤其明显,其输出在大多数时间是不活动的,当需要显著校正时变为活动的,因为观察到的信号在短时间段内经历显著的随机变化。

图2:METR-LA数据集中节点37的FC-GAGA提前15分钟的预测结果。蓝色、绿色和橙色线分别表示架构的第1、2和3层产生的部分预测。蓝色和红色:左轴;橙色和绿色:右轴。附录A中还有其他结果。

接下来,我们在图3中示出了图门中的权重Wi,j的地理分布,其在等式2中指定。(2)对于层1-3,如针对METR-LA数据集所学习的。每一层都可以自由地学习自己在图节点之间的关系;学习到的关系在各层之间有很大的不同,这表明来自不同空间区域的信息聚合。

图3:层1、2和3中权重最高的20个节点的地图。黑色星星表示预测节点。

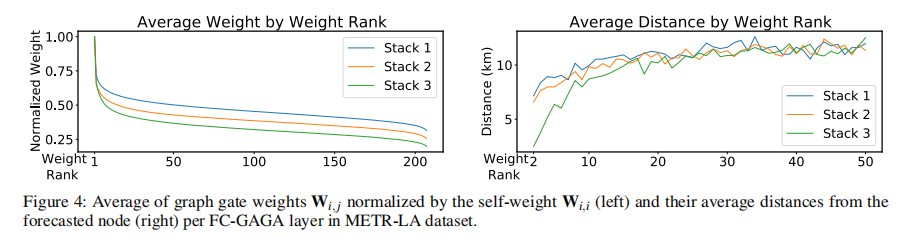

在图4(左)中,我们观察到门控在第一层中不太严格地实施(平均Wi,j值在第一层中更高),并且值的地理分布更分散(参见图3,左)。我们将其解释为表明在第1层中,FC-GAGA收集了各种节点和地理位置的信息,以构建稳定的基线预测。当我们从第2层移动到第3层时,我们可以看到具有最高图形权重的节点更紧密地集中在为其生成预测的目标节点周围(参见图3,中间和右侧以及图4,右侧)。图4(左)指示更多Wi,j在层2和层3中逐渐具有较小的值,这意味着等式中的更严格的门控。(2).我们对此的解释是,为了提供对基线预测的迭代更新,FC-GAGA专注于更接近目标节点的节点,并限制信息流,使得校正项由具有最相关信息的节点定义。

图4:在METR-LA数据集中,每个FC-GAGA层的图门控权重Wi, j的平均值,通过自我权重Wi,i进行标准化(左侧),以及它们距离预测节点的平均距离(右侧)。

消融研究

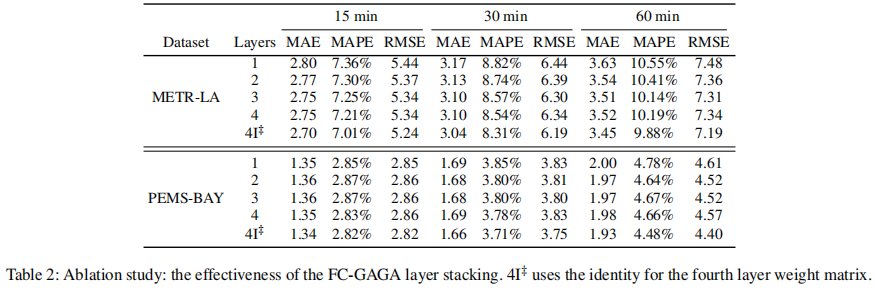

我们的烧蚀研究验证了FC-GAGA层堆叠机制、图形门控机制和时间门控的有效性。表2展示了FC-GAGA的性能作为层数的函数。增加层的数量会导致METR-LA数据集的显著改进,而在PEMS-BAY上,层的数量不会显著影响性能。众所周知,METR-LA是一个比PEMS-BAY更难的问题,因为它的TS更不稳定。这意味着增加FC-GAGA层的数量来解决更难的问题可能会带来额外的精度优势,而从计算效率的角度来看,仅使用一个FC-GAGA层来解决更容易的问题可能是有益的(运行时间与层数近似线性地缩放)。表中的最后一行(4 I)示出了当第四层被设置为标识时的性能,使得该层专注于仅使用每个节点的历史来形成预测。这种方法带来了显著的改进;强制一个层学习单变量关系可能是有益的。

表2:消融研究:FC-GAGA层堆叠的有效性。4I‡在第四层的权重矩阵中使用了单位矩阵。

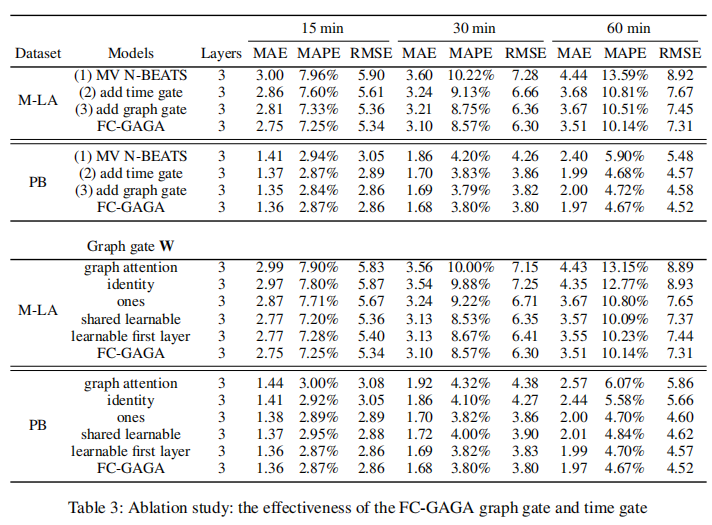

表格3的顶部部分显示了使用3层FC-GAGA网络进行图形门控和时间门控机制剔除实验的结果。时间门控和图形门控各自相较于简单的多变量N-BEATS模型都带来了改进,而且当它们结合使用时,进一步提升了性能。表格的底部部分探讨了不同的图形门控方法。"图形注意力"是一个标准的图形注意力方法,不执行硬门控。

表3:消融研究:FC-GAGA图门控机制和时间门控机制的有效性。

我们可以看到,我们提出的门控提供的稀疏性是至关重要的;图形注意力甚至被单变量的FC-GAGA模型(“identity”)超越。单变量的FC-GAGA在表格1中所有单变量方法中表现得最好。当W被设置为全1(“ones”)时,FC-GAGA可以学习不同节点之间的关系,但它不能强调具有影响力的节点。我们考察了三种可学习的选项:“共享学习”,即所有层共享一个可学习的W;“可学习第一层”,即与第一层相关的W是可学习的,而对于其他层则设置为全1矩阵;以及完全可学习的FC-GAGA方法。允许架构为每层学习一个不同的权重矩阵导致了最佳的预测性能,而额外的计算开销非常小。

性能分析结果

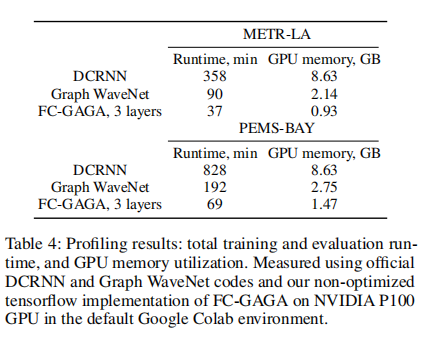

为了验证FC-GAGA的计算效率,我们在默认的Google Colab环境中使用了一块P100 GPU进行了性能分析实验。我们分析了DCRNN(Li等,2018)和Graph Wavenet(Wu等,2019)的原始代码。我们对基于TensorFlow 2.0的FC-GAGA实现进行了性能分析,该实现依赖于标准的Keras层定义,没有进行内存或速度的优化尝试。表格4清晰地显示了FC-GAGA更具计算效率,因为它的内存和计算时间大约是Graph Wavenet的一半,比DCRNN快大约10倍,并且内存效率大约是DCRNN的5-10倍。我们还可以看到,它在METR-LA(207个节点)和PEMS-BAY(325个节点)数据集之间的扩展性良好,这可能是处理具有数千个节点的大规模问题时的重要特性。

表4:性能分析结果:总训练和评估运行时间,以及GPU内存利用率。使用官方的DCRNN和Graph WaveNet代码,以及我们在NVIDIA P100 GPU上在默认的Google Colab环境中使用的非优化的tensorflow实现的FC-GAGA进行测量。

4 相关工作

多变量时间序列(TS)的预测或预测已经在几十年来受到了密集的研究。在历史上,神经网络方法在与最先进的统计预测模型竞争方面曾经遇到困难。然而,最近出现了一些神经网络架构,这些架构在训练时使用许多时间序列,但然后根据单个变量的历史数据(和协变量)进行预测,已经超越了统计方法(Salinas等,2019;Oreshkin等,2020;Smyl,2020)。与我们的工作不同,这些架构不是同时利用所有时间序列的历史信息来为多个时间序列形成预测。其他方法使用多个输入时间序列来预测单个目标TS(Bao,Yue和Rao,2017;Qin等,2017;Lai等,2018;Guo和Lin,2018;Chang等,2018)。对于这些架构,一些创新方法已被证明是有效的,包括使用注意机制来确定关注哪些输入变量和时间滞后(Qin等,2017;Guo和Lin,2018;Munkhdalai等,2019;Liu,Lu和Cai,2020)。在这方面,变压器架构在(Li等,2019)中被修改用于处理TS预测,而DeepGLO(Sen,Yu和Dhillon,2019)是一个混合模型,结合了规范化的矩阵因子分解以推导因子,并结合了用于局部预测的时间卷积网络。

基于图的模型

在某些情境下,我们提供了一个被认为能够捕捉变量间关系的图。神经网络架构通常结合了可以专注于空间关系的图卷积网络(GCNs),以及GRUs、LSTMs、TCNs或RNNs(Zhao等,2019;Li等,2018;Huang等,2019;Yu,Yin和Zhu,2018;Chen等,2019)。少数方法直接将基于图的学习应用于时空图(Yu等,2019;Song等,2020)。使用注意机制(Guo等,2019;Bai等,2019;Park等,2019;Zheng等,2020;Shi等,2020)可以提高性能。更先进的架构也提供了改进的途径。ST-UNet(Yu,Yin和Zhu,2019)采用时空池化/反池化,使得架构能够学习多尺度的表示。Graph WaveNet(Wu等,2019)采用扩张因果卷积,从更大的感知范围中提取时间关系。Xu等人(Xu等,2020)引入了时空变压器网络。这些图通常来自于与预测任务不完全对应的考虑。例如,用于交通预测的图可能基于地理接近性。从数据中学习一个适当的图是有益的。在(Yu等,2019;Diao等,2019)中,算法将图作为预处理步骤学习。更好的方法是将图学习与预测相结合;在(Wu等,2019;Zhang等,2020)中的架构中,加入了学习自适应邻接矩阵的机制,随后在GCNs中使用。虽然GraphWaveNet可以通过图注意力方法学习邻接矩阵,但是当与全连接的时间序列预测模块结合时,这不是一个合适的方法,如表格3所示。我们提出的图门控机制具有重要的稀疏效应,可以防止过拟合。全连接架构非常有吸引力,因为它具有非常好的泛化性能,并且在计算和内存方面要求较少。

5 结论

我们提出并经验性地验证了一种新颖的神经网络架构,用于时空预测,我们称之为FC-GAGA(Fully Connected Gated Graph Architecture,全连接门控图架构)。FC-GAGA将一个全连接的时间序列模型与时间和图门控机制相结合,这两者都具有通用性和高效性。我们在实证上证明,所提出的模型可以高效地从数据中学习,以在架构中的多个变量之间捕捉非马尔可夫关系,从而实现出色的泛化性能。我们进一步分析了FC-GAGA的训练和推断运行时,并且证明了它在利用GPU内存和计算方面比具有相似准确性的现有模型更加高效。我们的结果为发展基于图的信息处理的全连接架构提供了强有力的积极证据,激发了该领域的发展。

328

328

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?