Abstract & Introduction & Related Work

- 研究任务

持续学习 - 已有方法和相关工作

- 面临挑战

- 现有的工作主要是建立在一个包含少数原始数据的小的内存缓冲区上,这不能完全描述旧的数据分布

- 现有的工作往往需要训练额外的参数或者蒸馏旧的特征

- 创新思路

- 在这项工作中,我们提出了带有数据压缩的内存重放,以减少旧训练样本的存储成本,从而增加它们可以存储在内存缓冲区的数量

- 我们提出了一种基于决定性点过程(DPPs)的新方法,以有效地确定当前到达的训练样本的适当压缩质量,这样一来,使用一个具有适当选择质量的天真数据压缩算法,可以在有限的存储空间中保存更多的压缩数据,从而在很大程度上提高最近的强大baseline

- 实验结论

大量的实验表明,使用一个简单的数据压缩算法,并适当选择质量,可以在有限的存储空间内保存更多的压缩数据,从而在很大程度上改善内存重放的情况

与DNN中的 "人工 "记忆重放不同,生物记忆的一个重要特征是以高度压缩的形式对旧的经验进行编码并重放以克服灾难性的遗忘

Data compression

数据压缩旨在提高文件的存储效率,包括无损压缩和有损压缩。无损压缩需要从压缩后的数据中完美地重建原始数据,这限制了它的压缩率(Shannon, 1948)。相比之下,有损压缩可以通过降低原始数据来实现更高的压缩率,所以它在现实应用中被广泛使用。有代表性的手工制作方法包括JPEG(或JPG)(Wallace,1992),它是最常用的有损压缩算法(Mentzer等人,2020),WebP(Lian & Shilei,2012)和JPEG2000(Rabbani,2002)。另一方面,神经压缩方法通常依靠优化香农速率-失真权衡,通过RNNs(Toderici等人,2015;2017)、自动编码器(Agustsson等人,2017)和GANs(Mentzer等人,2020)来实现

METHOD

MEMORY REPLAY WITH DATA COMPRESSION

如果压缩率过高,会影响训练效果,直观地说,这导致了质量和数量之间的权衡:如果存储空间有限,降低数据压缩的质量q将增加可存储在内存缓冲区的压缩数据的数量 N q m b N_q^{mb} Nqmb,反之亦然

在这里,我们通过用JPEG(Wallace, 1992)压缩图像来评估所提出的想法,JPEG是一种简单但常用的有损压缩算法。JPEG可以保存质量在[1, 100]范围内的图像,其中降低质量会导致更小的文件大小。使用相当于每类20张原始图像的内存缓冲器(Hou等人,2019年),我们用有代表性的内存重放方法,如LUCIR(Hou等人,2019年)和PODNet(Douillard等人,2020年)对JPEG质量进行网格搜索。如图2所示,具有适当质量的压缩数据的记忆重放可以大大超过原始数据的表现。然而,无论质量过大还是过小,都会影响性能。特别是,实现最佳性能的质量因内存重放方法的不同而不同。 记忆重放的方法不同,但对于不同数量的增量阶段的分割是一致的

QUALITY-QUANTITY TRADE-OFF

q越小(压缩率越高)数据集越大,也就是说选择合适的q来进行记忆重现

用LUCIR学习5阶段ImageNet-sub后,原始子集(浅色点)和其压缩子集(深色点)的t-SNE可视化特征。从左到右,数量从37,85增加到200,而JPEG的质量从90,50减少到10。我们绘制了最新任务中的五个类别,并以不同的颜色标注。交叉的区域是分布外的

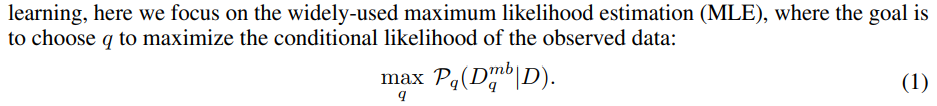

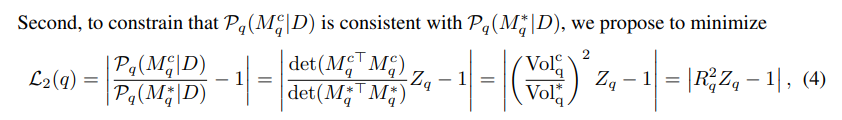

选择合适的q来优化以下极大似然

D

q

m

b

D_q^{mb}

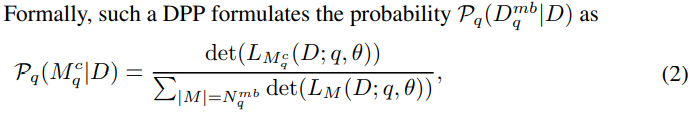

Dqmb 的构建基本上可以看做为一个采样问题,我们应用确定性点过程(DPPs)来制定条件可能性,DPPs不仅仅是一个优美的概率采样模型,它可以通过行列式来描述每个可能的子集的概率,还也可以通过子集中所有元素所跨越的容量来提供概率的几何解释

由于极高的复杂度,很难去直接优化

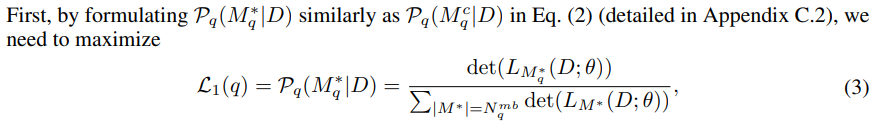

改为优化

M

q

∗

M_q^*

Mq∗

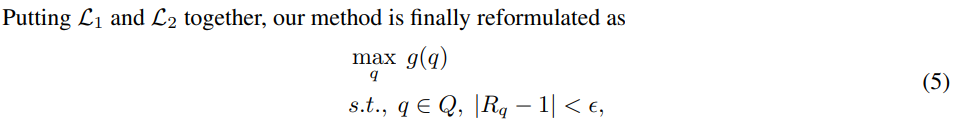

VALIDATE OUR METHOD WITH GRID SEARCH RESULTS

现在我们用网格搜索结果来验证我们的方法所确定的质量,其中LUCIR和PODNet在JPEG质量为50和75的ImageNet-sub上取得了最好的性能

因为它们是满足

∣

R

q

−

1

∣

<

ϵ

|R_q - 1| < \epsilon

∣Rq−1∣<ϵ 的最小质量。 因此,我们的方法确定的质量与网格搜索结果一致,但计算成本却节省了100多倍。有趣的是,对于每个质量

q

q

q,

∣

R

−

q

−

1

∣

<

ϵ

|R-q - 1| <\epsilon

∣R−q−1∣<ϵ 在每个增量阶段和所有增量阶段的平均值中是否一致。我们在附录D.4中进一步探讨

R

q

R_q

Rq 可能更加动态的情况

EXPERIMENT

CONCLUSION

在这项工作中,我们提出,使用具有适当选择的压缩质量的数据压缩,可以在有限的存储空间中保存更多的压缩数据,从而在很大程度上提高内存重放的效率。为了有效地确定压缩质量,我们提供了一种基于决定性点过程(DPPs)的新方法,以避免重复训练,并在物体检测的类增量学习和半监督持续学习中验证了我们的方法。我们的工作不仅提供了一个重要的但未被充分探索的基线,而且还为持续学习开辟了一条有希望的新途径。进一步的工作可以为增量数据开发自适应压缩算法以提高压缩率,或者提出新的正则化方法来约束数据压缩引起的分布变化。同时,基于DPPs的理论分析可以作为一个通用框架来整合记忆重放中的可优化变量,例如选择原型的策略。此外,我们的工作还提出了如何在有限的存储空间中保存一批训练数据,以最好地描述其分布,这将促使在数据压缩和数据选择领域的更广泛的应用

Remark

用数据压缩的方法获得了一些提升,但是真的搞的一堆复杂公式我看都看不懂,就是证明了压缩数据来存储更多张图片用来回忆可以获得更好的性能,还不错,要是能简单点的话会是我很喜欢的paper

1113

1113

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?