目录

一、相关工作

用于图像应用的基于CNNs的灵活内核

CNN倾向于通过增加网络深度或宽度来提高性能,但这会增加训练成本;而轻量级CNN使用更小的卷积来减少计算成本,但会降低性能。为了解决这一问题,有人提出了动态卷积技术。该方法通过一种注意机制来动态融合并行卷积核,而不是通过某个核来提取显著特征。即一种注意机制可以根据不同的输入动态调整每个核的权重,增强得到的特征的表达能力。

另外,有人还提出了变形卷积技术。Chen等人[39]利用不同注意机制的相互依赖关系定义了可变形机制,提高了图像分割中单一泛化卷积的能力。Yu等人[40]提出了一种可变形的注意力来增强目标模板和搜索图像之间的上下文信息和相互依赖性,用于目标跟踪。受此启发,在CNN中使用可变形卷积来提高预测去噪图像的清晰度。

二、方法

2.1、网络体系结构

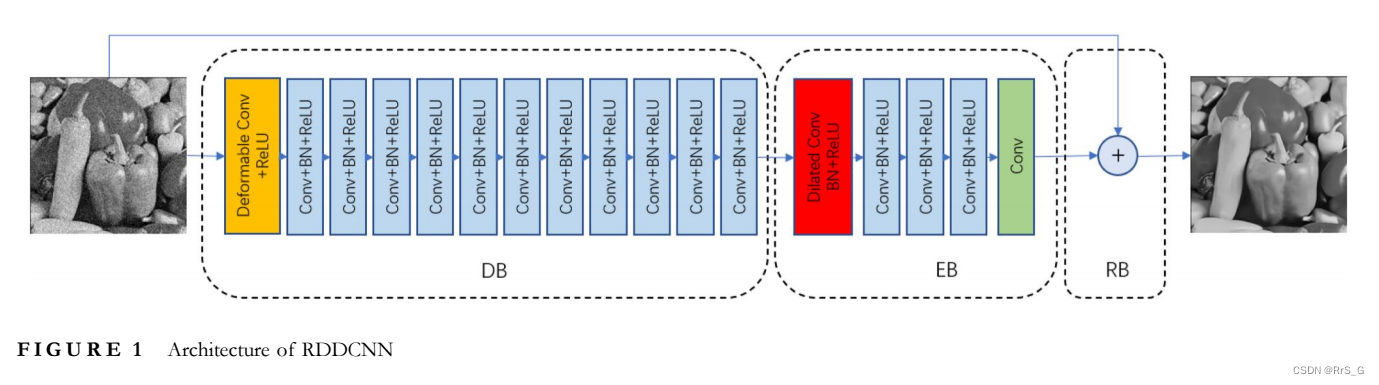

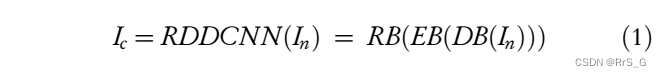

本文提出了一种鲁棒变形去噪CNN(RDDCNN),它由一个DB、一个增强块(EB)和一个RB组成,如图1所示:

由于卷积运算可能会改变已损坏图像中噪声的原始分布,这可能会增加图像去噪的训练难度。因此提出了12层DB,通过可变形和叠加的卷积结构,根据周围像素的关系提取出更有代表性的噪声特征。为了以更低的成本挖掘更多的结构信息,5层EB可以通过扩展卷积促进上下文交互,从而提取出更鲁棒的噪声信息,从而增强RDDCNN的学习能力。为了解决长期依赖问题,RB被用来增强浅层对深层的记忆能力,并构建一个潜在的干净图像。下式(1)可以直观地表达这一过程:

其中表示噪声图像,

表示干净图像。

2.2、损失函数

损失如下:

式中的I分别是噪声图像和相对应的干净图像。

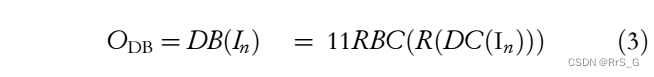

2.3、可变形块(DB)

简而言之,这个模块可以用下式来表示:

其中DC和R分别表示可变形卷积和ReLU,C和B分别表示卷积层和BN。

这个模块中除了可变形卷积都很常规,下面介绍它的详细信息。

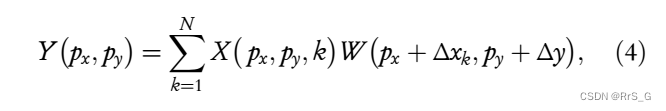

一个标准的卷积运算可以表示为式(4):

其中表示一个给定的核w的中心点的位置。它的大小设置为3 x 3。X表示得到的特征图。N为X中得到的特征的像素总数,

表示

在水平方向上的偏移,

表示

在垂直方向上的偏移。

。

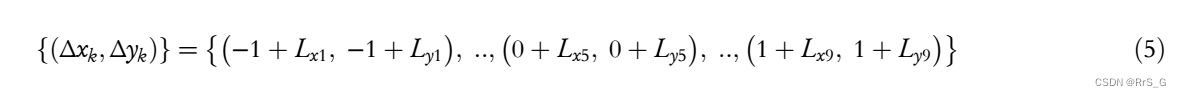

但对于一个3 × 3核的可变形卷积,如下图所示:

式中为第k点的学习偏移量。通过对上述公式的分析,可以看出变形卷积在获取更多上下文信息方面具有良好的性能。

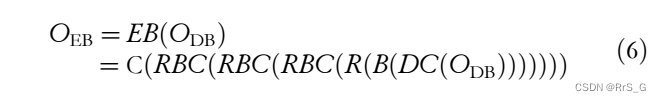

2.4、增强的块(EB)

这个过程可以用下式表示:

式中DC为扩张卷积,C和B分别表示卷积层和BN。

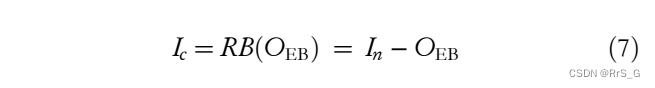

2.5、残差块(RB)

过程如下式所述:

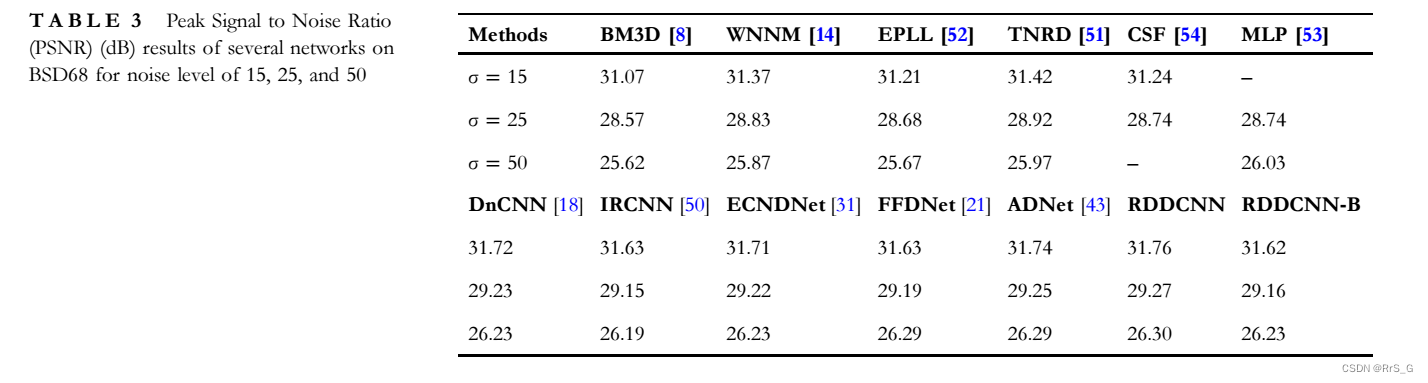

三、实验

5578

5578

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?