论文地址:VGG

一、精读论文

论文题目

Very Deep Convolutional Networks for Large-Scale Image Recognition

论文作者

Karen Simonyan∗ & Andrew Zisserman

刊物名称

ICLR2015

出版日期

2015.10

摘要

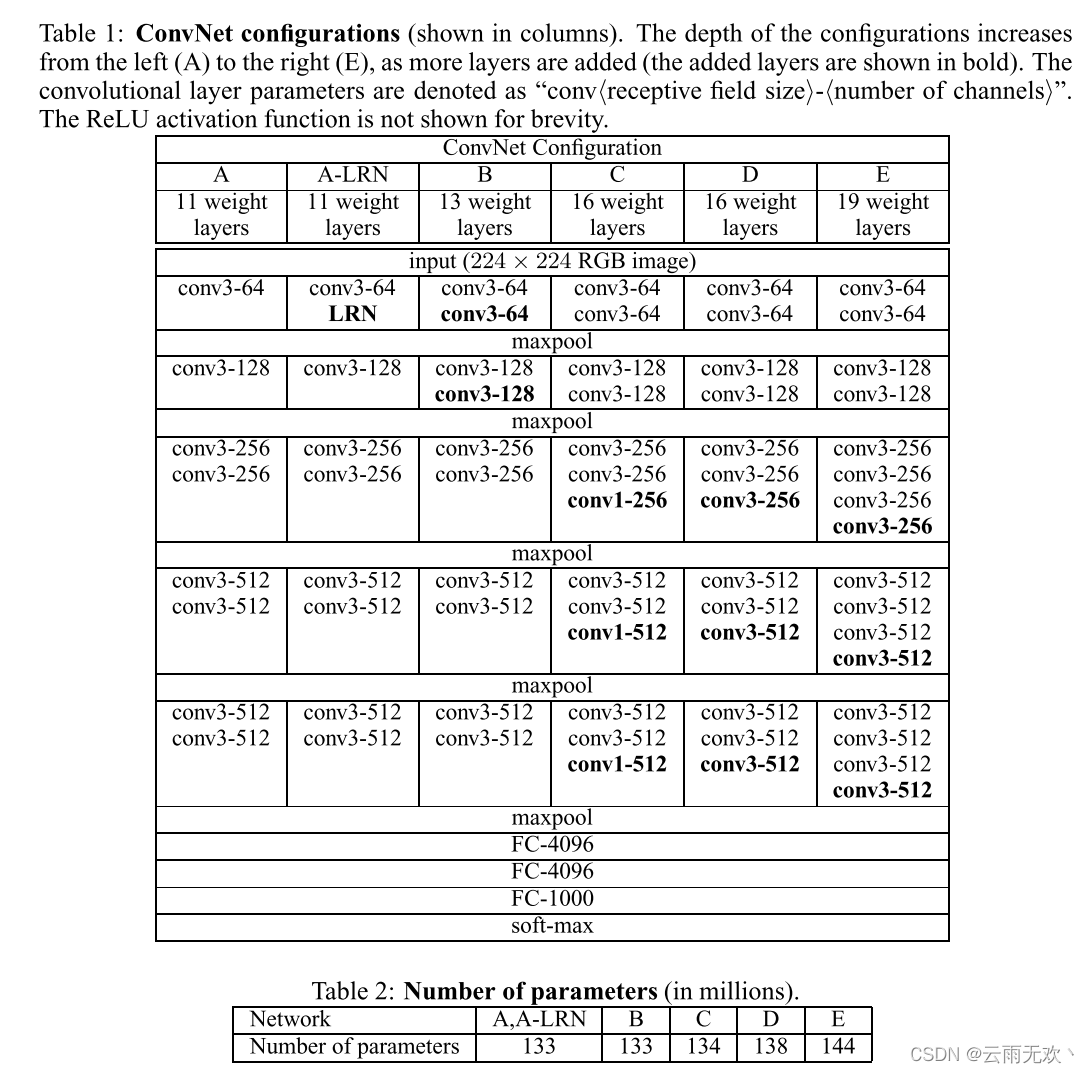

在本工作中,我们研究了卷积网络深度对其在大规模图像识别设置的准确性的影响。我们的主要贡献是对使用非常小的(3×3)卷积滤波器的体系结构的深度增加网络进行了彻底的评估,这表明,通过将深度提升到16-19个权重层,可以实现对现有技术配置的显著改进。这些发现是我们ImageNet Challenge 2014提交的基础,我们的团队在本地化和分类方面分别获得了第一名和第二名。我们还表明,我们的表示可以很好地推广到其他数据集,在这些数据集上,它们获得了最先进的结果。我们公开了两个表现最好的卷积神经网络模型,以促进在计算机视觉中使用深度视觉表示的进一步研究。

关键词

计算机视觉、vgg

总结

结论:VGG在AlexNet的基础上取精华弃糟粕,具体表现在使用AlexNet的一些初始化配置,而增加了网络深度,且将卷积核都替换为了1×1及3×3的小卷积核以减少参数计算量。但是总得来说该网络还是比较臃肿。

Tip1→去掉LRN层,因为没什么大的作用,还增加了参数计算量。

Tip2→卷积块叠加在一起,即加深网络深度。2卷+池化+2卷+池化+3卷+池化+3卷+池化+3卷+池化+3FC,从左向右尺寸越来越小,通道数越来越大。

Tip3→使用小卷积核:增加了非线性性、减少参数量且感受野大小相同。大部分使用3×3卷积核,有些卷积层使用1×1。两个3×3=一个5×5,三个3×3=一个7×7。

Tip4→保留了AlexNet中的ReLU和dropout。

Tip5→测试时将全连接层转换为卷积层,这样就可以输入任意大小的图像了,也就是说测试时用全卷积网络。同时也用到全局平均池化。

Tip6→训练时的尺度变化:性能较固定尺度训练性能要更好。

二、研读总结(分三段总结,500字左右)

1、 针对问题与解决方法

VGG通过增加卷积神经网络的深度来提高模型在图像分类的性能。

具体来讲,VGG通过在模型中增加更多的卷积层来增加模型的深度,需要注意的是VGG卷积层中所使用的都是较小的filter(3*3)。

通过多层较小filter的卷积层去替代一层较大filter的卷积层,可以在保证感受野(receptive field)不变的前提下,减少参数数量,引入更多的非线性因素,提高模型的深度,从而提升模型的分类性能。

2、 数据实验与结论分析

最后的实验结果证明的VGG是非常成功的一种思路。

3、 科研启发与积累工作

复现了VGG

641

641

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?