论文地址:A Gentle Introduction to Graph Neural Networks (distill.pub)

李沐论文精读:零基础多图详解图神经网络(GNN/GCN)【论文精读】_哔哩哔哩_bilibili

目录

2.2. Graphs and where to find them

2.3. What types of problems have graph structured data?

2.4. The challenges of using graphs in machine learning

1. 主要思想

1.1. 图

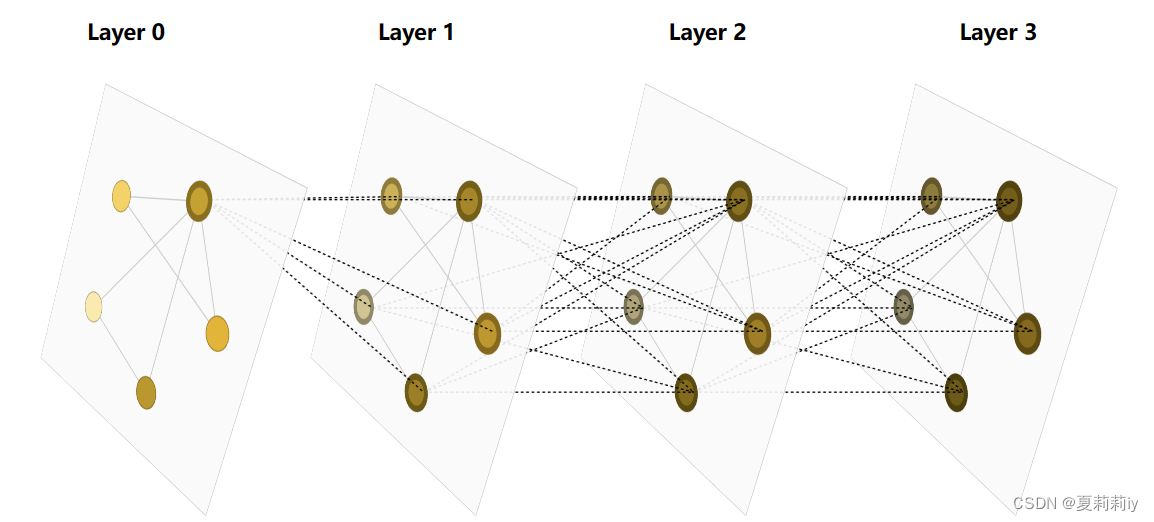

(1)图神经网络的每后一层每个节点都源自于前面所有层的节点,如下图layer 0 实际上是最新层

(2)每个顶点,边缘,全局都有它分别的特征向量中心性

⭐特征向量中心性是对图的邻接矩阵求特征值和特征向量,取最大特征值对应的特征向量,就是节点的特征向量中心性

⭐如果一个节点的度大+它邻接节点的度大,那么大的度中心性会更大一些

(来源:【图神经网络】GNN从入门到精通_哔哩哔哩_bilibili)

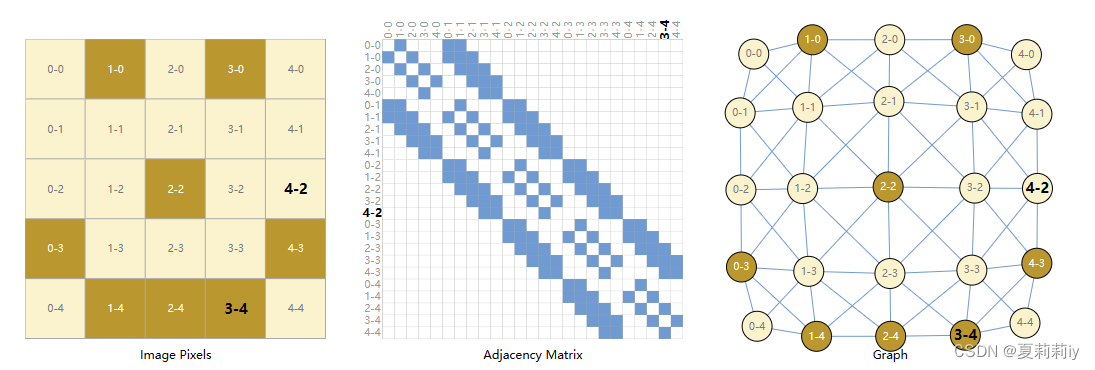

(3)图神经网络将每个像素点表示为一个顶点,每个顶点与其相邻的八个顶点有无向边存在,并可以画出邻接矩阵。邻接矩阵通常为很大的稀疏矩阵

(4)将文本表示成图,文本为序列,将每一个词表示成一个顶点

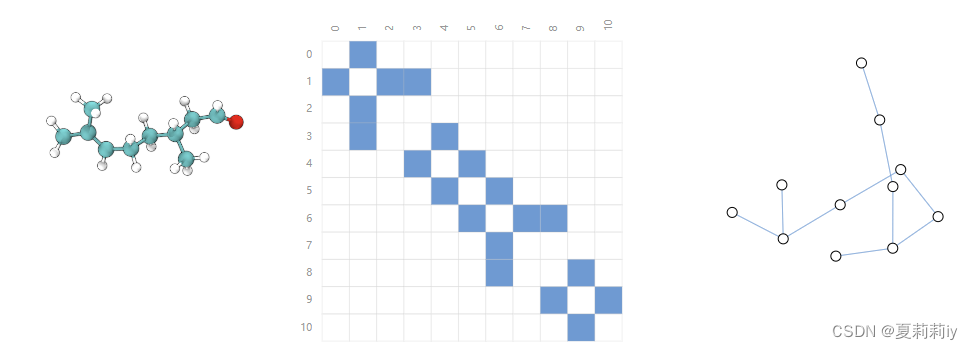

(5)分子也可以表示成图

(6)社交网络图

(7)引用图(有向边)

1.2. 图解决的问题

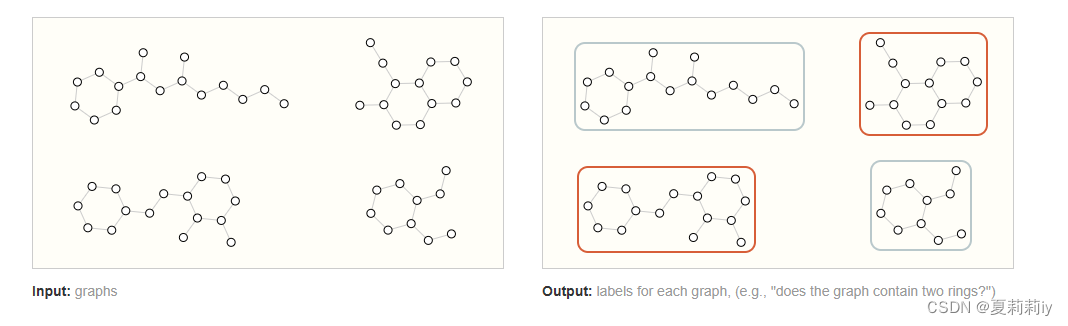

(1)识别整个图

(2)识别顶点属性(可用作分类)

(3)识别边属性

1.3. 图的表示方法

以下均为个人理解,这个图也是我自己点出来的

(1)顶点:实际上这张图已经将每个顶点的序号排好,因此不能再排。但是可以单击将顶点变成0或1,我个人揣测是无效顶点和有效顶点(但是真的很奇怪啊都无效了为什么还能连线呢,意思是线没有节点作为两头吗)

(2)边:边不加的时候啥都没,不像这个图里顶点必须存在。加进去之后出现1或2为一条边的值(这难道是有向边和无向边的区分吗?但是如果是有向边根本不知道谁指谁啊)

(3)邻接列表:添加边后出现对应邻接列表,[x,y]意为x与y相邻(但似乎没有表示有向属性因为我点不出来[y,x])

(4)全局:可以有0和1的值

1.4. 图神经网络操作

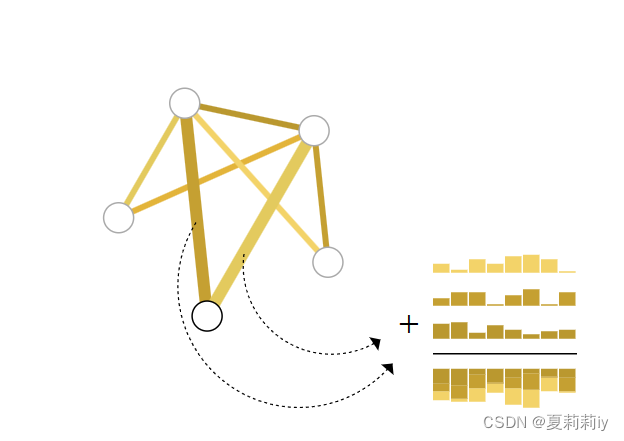

(1)会对U,V,E都进行一个更新的操作,但是图的结构保持不变,即连接信息不变

(2)如果要进行分类,则对图后做一个顶点的k类全连接层。不管有多少顶点,只有一个全连接层,所有的顶点共享一个全连接层里的参数(此时有顶点向量)

(3)如顶点没有向量,要对其做预测,是将顶点所有边的向量和全局向量加起来成为顶点向量.此时称为pooling。同时必须假设顶点和边的维度是一样的,若不一样则需要做投影

(4)同时,若只有顶点向量没有边的向量,就将顶点汇聚到边上

(5)若无全局向量,要对图做预测,可以把全部顶点向量加起来

(6)它的每一层是三个MLP,即U,V,E

1.5. 信息传递

(1)将顶点的向量和顶点所有邻接点的向量全部加在遗器再进入MLP,这些向量的权重都是一样的,没有分权重

(2)先边后顶点和先顶点到边会产生不一样的预估结果

(3)交替更新

(4)全局有效传递:每次传递一个将其他两个也加起来传递

(5)AUC越高越好

2. 逐段原文精读

2.1. Introduction

(1)Graph can be uesed in neural networks

(2)Graphs represent connection. Thus, they build neural networks through graph and call it GNN

(3)Four parts are in this paper:

①Which data are more akin to graph or can be presented by graph

②How graph be different from other data type

③Build a modern GNN

④Provide a GNN playground

(4)Show graphs

2.2. Graphs and where to find them

(1)Images as graphs: each pixel represents a node and they can build an adjacency matrix. Moreover, every node stores 3-dimensional vector representing the RGB value of the pixel

(2)Text as graphs: each character, word, or token is a node and connect with next one

(3)Graph-valued data in the wild

①Molecules as graphs

②Social networks as graphs

③Citation networks as graphs

④Other examples

2.3. What types of problems have graph structured data?

(1)Graph-level task: to predict whole characters of graph

(2)Node-level task: predict each node

(3)Edge-level task: predict the value of each edge

2.4. The challenges of using graphs in machine learning

(1)Quite sparse this adjacency matrices is, which causes inefficient

2.5. Graph Neural Networks

(1)"A GNN is an optimizable transformation on all attributes of the graph (nodes, edges, global-context) that preserves graph symmetries (permutation invariances)."

(2)The simplest GNN: This GNN uses a separate multilayer perceptron (MLP) (or another differentiable model) on each component of a graph

(3)GNN Predictions by Pooling Information

(4)Passing messages between parts of the graph

(5)Learning edge representations

(6)Adding global representations

2.6. GNN playground

以下因为知识点多,以及过于概述,因此不再归纳总结(原文就已经很简短了!)

997

997

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?