Untrained Neural Network Priors for Inverse Imaging Problems: A Survey

综述:使用无训练网络先验解决逆(反)成像问题的方法 TPAMI'2022

从标题中可以看到这篇文章的研究对象,一个是 Untrained Neural Network Priors 无训练网络先验,另一个是 Inverse Imaging Problem 逆(反)成像问题,论文是使用无训练网络先验解决逆(反)成像问题方法的综述

作者来自巴基斯坦信息科技大学 Information Technology University (ITU), Lahore, Pakistan

澳大利亚西澳大学 University of Western Australia (UWA)

卡塔尔大学 Qatar University, Doha, Qatar

论文链接

1. Inverse Imaging Problem

1.1 什么是逆(反)成像问题

一句话概括:逆/反成像问题指从有噪声的观测中还原出真实信号的问题

以下使用逆问题的说法

推荐这个视频,几分钟就讲清楚了综述论文中第一部分的内容

*以下黑色背景的图片均出自该视频

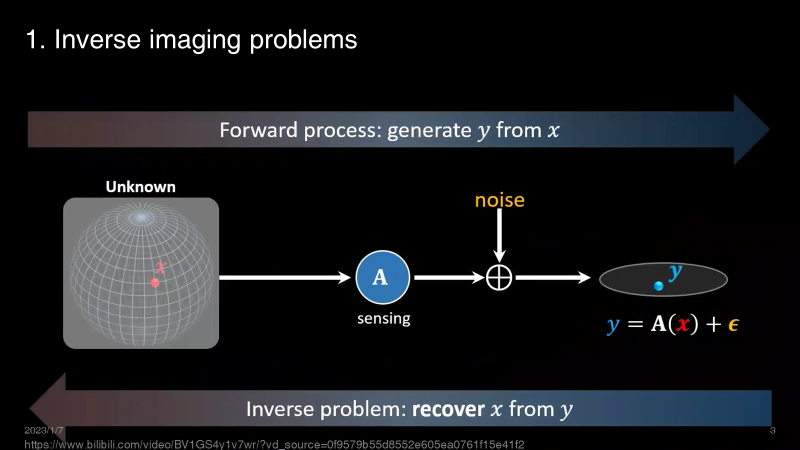

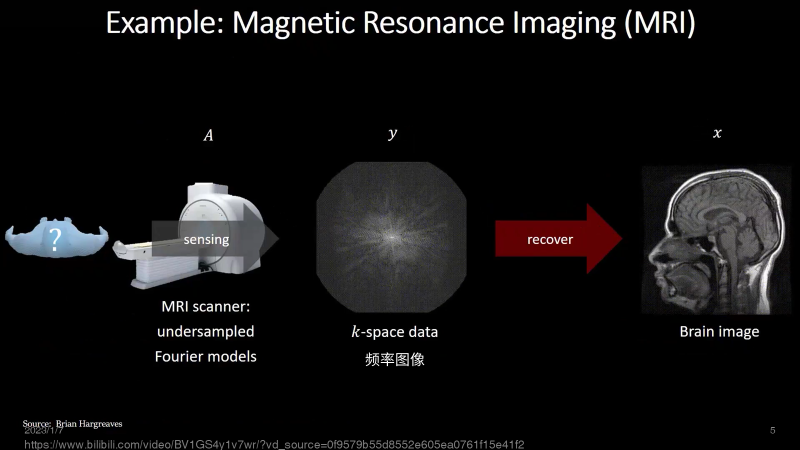

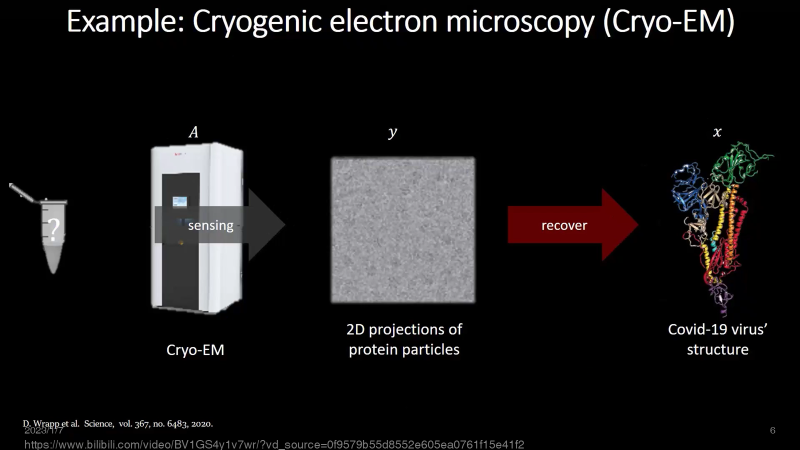

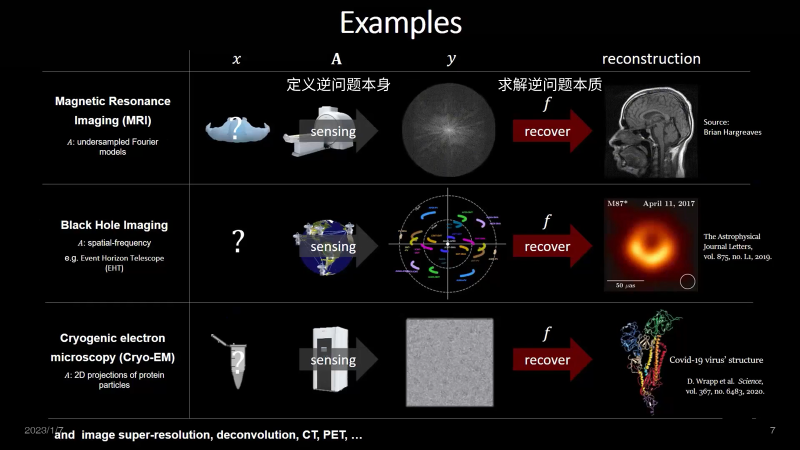

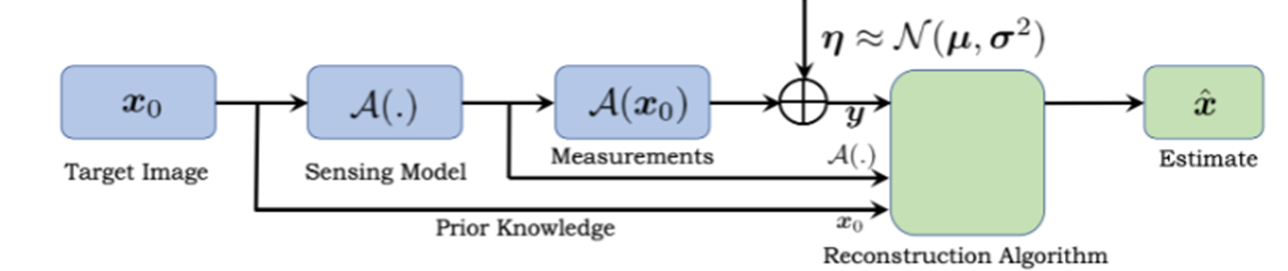

x是感兴趣的未知图像,A是测量算子,用A对x进行观测,得到观测值y

一般来说,在观测过程中会伴随噪声 noise 影响,因此观测值 y 中往往有特定类型的噪声 ϵ

通常,把 x 通过观测 A 得到 y 的过程称为前向过程,把已知观测结果 y 反过来求解感兴趣未知图像 x 的过程称为逆成像过程

1.2 例子

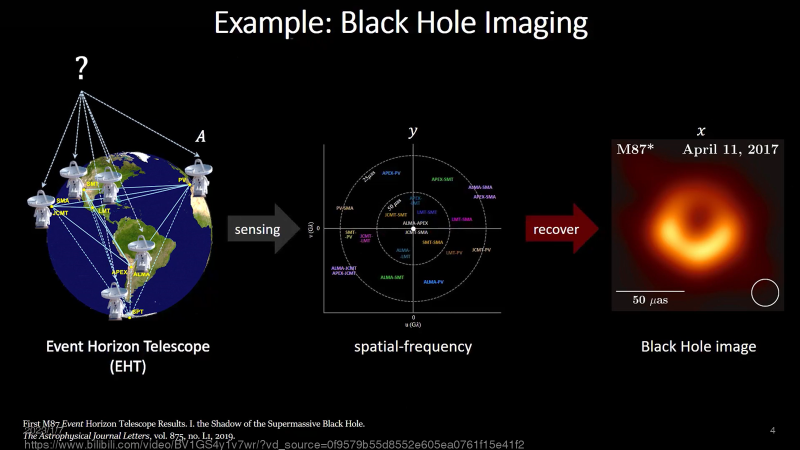

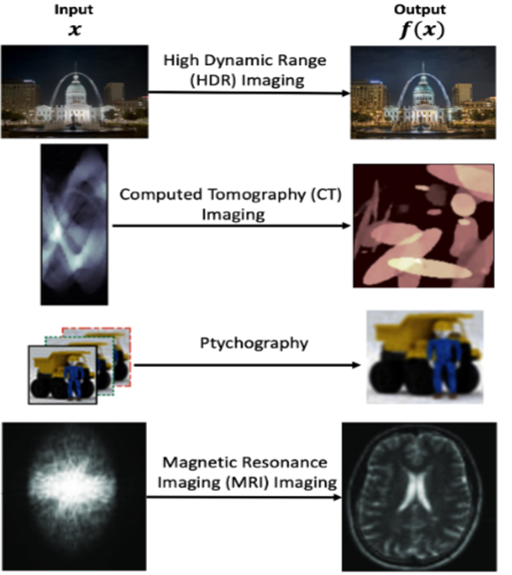

黑洞成像是逆成像问题,我们用射电望远镜观测黑洞直接得到的是 spatial-frequency 图像,现在需要利用观测值 spatial-frequency 图像恢复出黑洞图像

MRI成像也是逆成像问题,用MRI仪器观测得到的是频率图像,需要将其恢复到医生可以看懂的图像

电镜成像也是也是逆成像问题,需要将观测到的2D投影恢复到蛋白质的3D结构

从上面三个例子中,可以看到观测 A 定义逆问题本身,恢复过程 f (y到 x~ 的映射) 是求解逆问题的本质

1.3 逆成像问题的范式

prior knowledge 分成两部分: the target image x0 and sensing model A(.)

比如去噪问题中,prior 分为图像先验与噪声先验

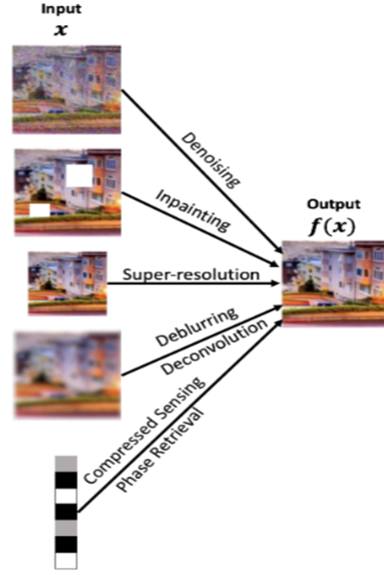

1.4 自然图像中的逆成像问题

1.5 其他图像的逆成像问题

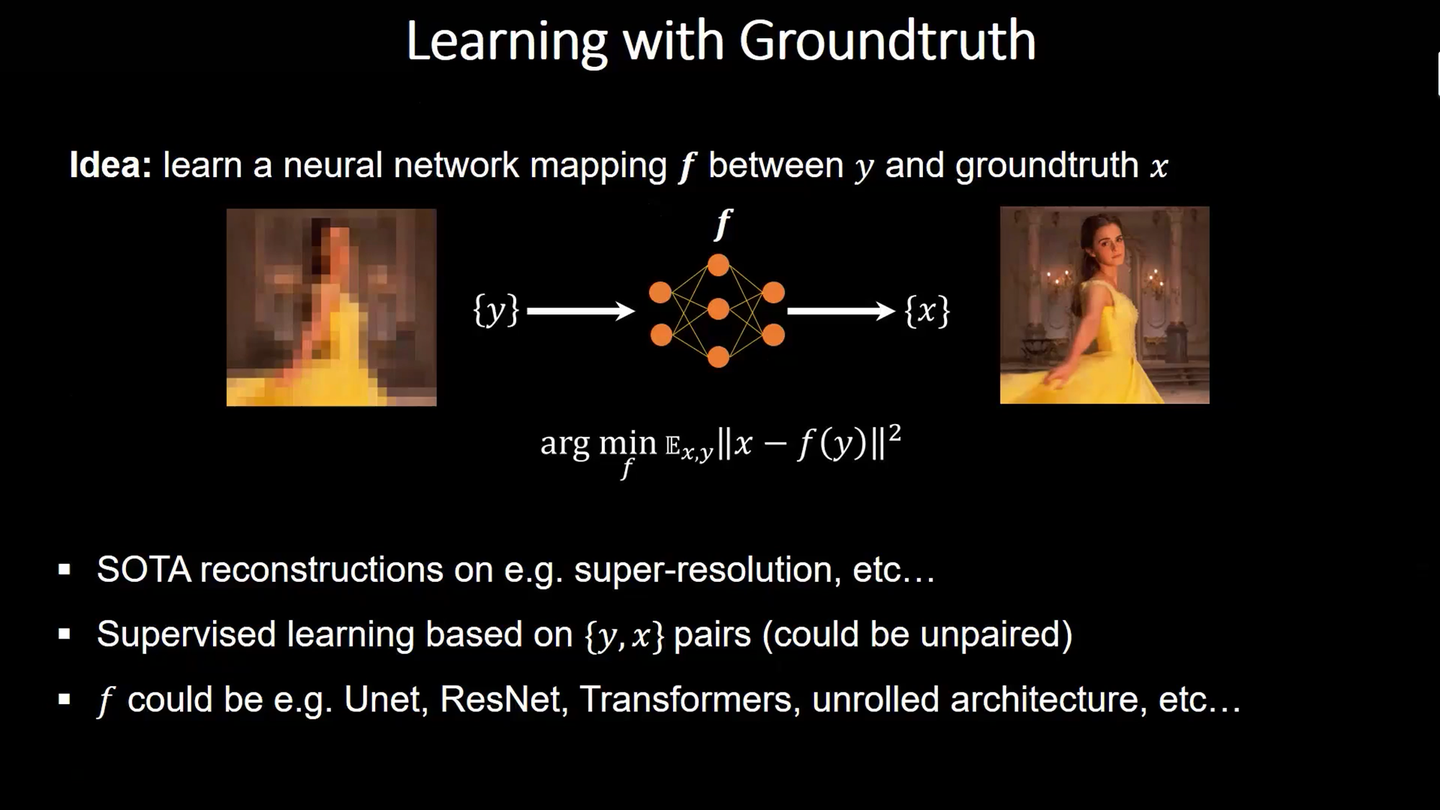

1.6 监督学习

那怎么解决逆成像问题捏?

手工特征、稀疏表示等方法就略过了,从深度学习方法开始

在有ground-truth的时候可以构成<y, x>对进行监督训练

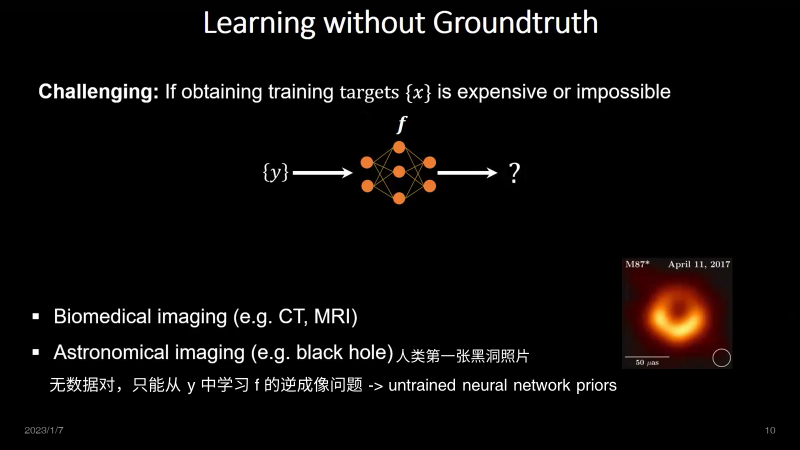

1.7 无监督/自监督学习

但是像黑洞成像、MRI成像等只有y没有x的任务,无法使用监督学习,只能使用无监督/自监督

untrained neural network priors 无训练网络先验就是这样一种从 y 中学习 f 的解决逆成像问题的无监督/自监督方法

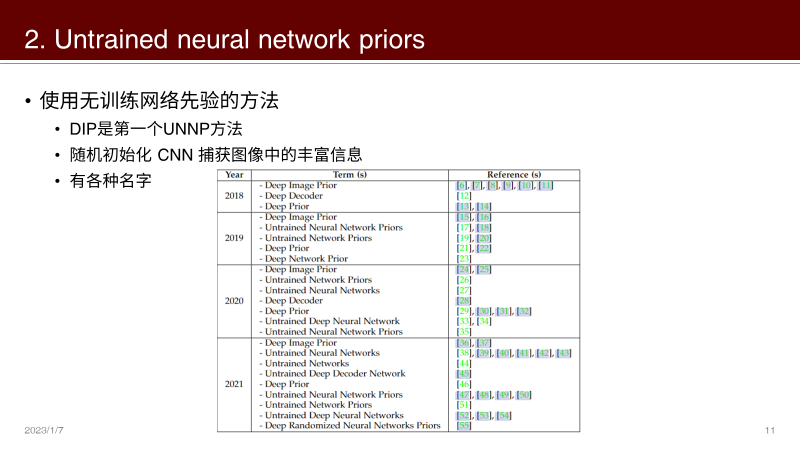

2. Untrained Neural Network Priors

2.1 无训练网络先验

Deep Image Prior 论文可以看这里:

【自监督去噪系列一】Deep Image Prior (CVPR'2018)32 赞同 · 0 评论文章编辑

接下来将按照方向介绍 DIP 系列论文

2.2 理论解释

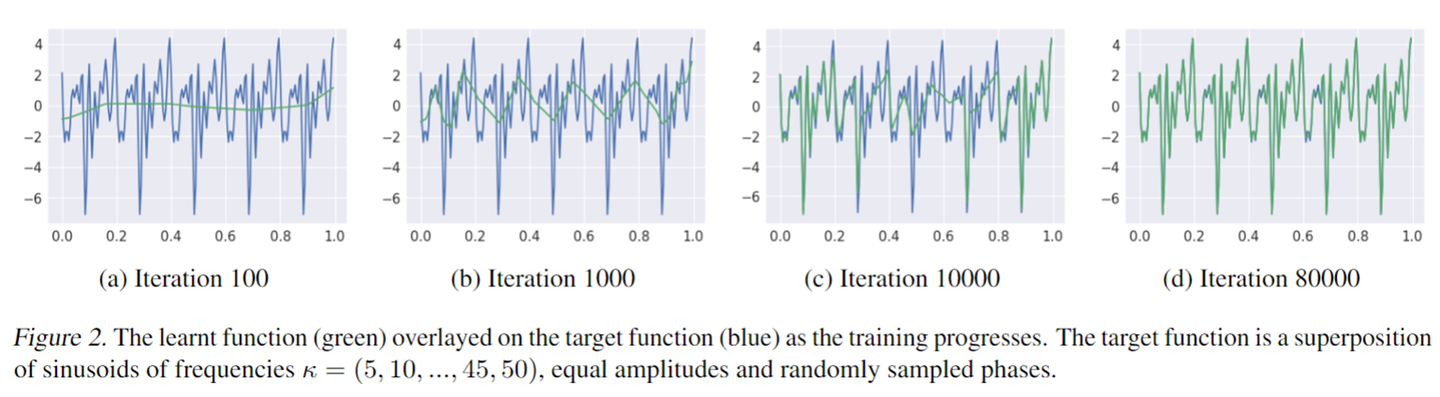

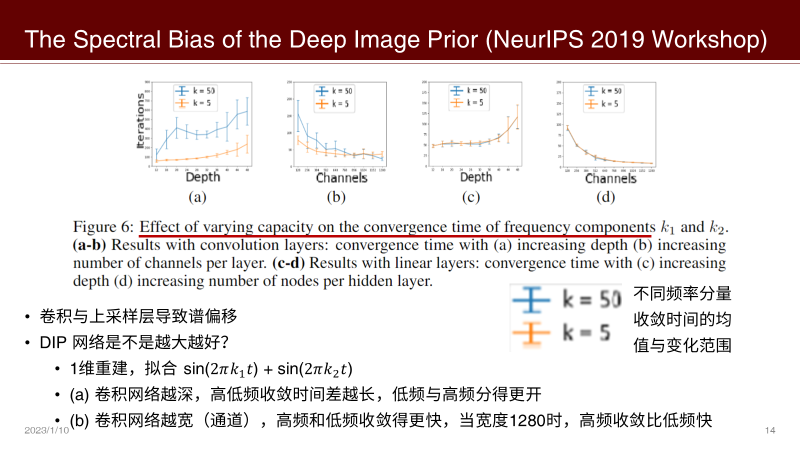

[NeurIPS Workshop'2019] The Spectral Bias of the Deep Image Prior

- 第一次用谱偏移来解释DIP

谱偏移/频率原则是指神经网络拟合低频信息比高频信息快,即神经网络倾向于coarse-to-fine地拟合

从反向传播的角度也可以解释,coarse的部分梯度大,所以优先拟合低频的coarse内容。

如图,绿色是神经网络的预测,蓝色是 Groundtruth

谱偏移/频率原则出自两篇文章

一篇是2018图灵奖得主 Yoshua Bengio 的 On Spectral Bias of Deep Neural Networks (ICML'2018)

另一篇是上海交通大学许志钦老师的 Frequency principle: Fourier analysis sheds light on deep neural networks. (Communications in Computational Physics'2020)

回到该文章

该文章的其他结论包括:

- 卷积与上采样层是谱偏移的结构基础

- 问题:DIP 网络是不是越大越好?

- 回答:

- 一维重建时,卷积网络越深,高低频收敛时间差越长,低频与高频分得更开

- 一维重建时,卷积网络越宽(通道),高频和低频收敛得更快,当宽度1280时,高频收敛比低频快

[IJCV'2021] On measuring and controlling the spectral bias of the deep image prior

本文作者中的 Subhransu Maji 同样也是 The Spectral Bias of the Deep Image Prior (NeurIPS Workshop'2019) 的作者

主要结论

- 无训练网络先验方法 UNNP 可以解决逆图像问题的原因是网络学习低频比高频快,即谱偏移

- 高频分量分为结构高频分量与噪声高频分量,当网络开始学习噪声高频分量时,性能开始下降

- 上采样层提高 PSNR,但是影响低频收敛速度,原因是过度平滑导致引入了 bias(高频内容高阻抗)

因此,为了防止网络退化,平衡性能与效率,网络优化方向:

- 高频噪声的学习会导致DIP的退化,因此引入 Lipschitz-controlled 卷积层,不退化的网络也就不需要停止条件

- 插值、最近邻等上采样层over-smooth(高频内容高阻抗),给网络引入 bias,因此引入 Gaussian-controlled 上采样层

- 提出一个简单的自动停止迭代方法,即模糊度与锐度之比的导数小于预设阈值时停止迭代

[ICLR'2019] Deep Decoder: Concise Image Representations from Untrained Non-convolutional Networks

- 从稀疏分解与稀疏表示的角度看,含噪信号包括干净信号与噪声

- 由于干净信号是有一定的结构的,故干净图像信号被认为是稀疏成分

- 噪声是随机的,不相关,因此没有结构特性

- under-parameterization 方法将冗余的原始数据压缩表达为稀疏的仅保留有效信号的数据

- 将一般卷积起到的提取空间和通道特征的作用解耦,用 1×1 卷积替代 3×3 卷积来专门解决通道独立性,空间等变性与空间不变性直接通过应用上采样层解决

[ICLR'2020] Denoising and Regularization via Exploiting the Structural Bias of Convolutional Generators

- 提出 convolutional generator (无参数量限制的 Deep Decoder) 能够解决逆问题的主要原因在于有固定核的卷积,bilinear upsampling 可以看作固定核的卷积

- 利用 NTK 理论计算得到网络去噪效果的上界,并且通过上界公式中的迭代次数项证明了过参数化网络通过 early stopping 可以去噪

- 利用 NTK 理论证明了一个两层 convolutional generator 优先学习雅可比矩阵奇异值大的部分,而雅可比矩阵大奇异值对应的是低频分量,所以这里可以定量计算得到谱偏移。此外作者在更多层的 convolutional generator 上有同样的实验观测与结论

[ICML'2020] Compressive sensing with un-trained neural networks: Gradient descent finds a smooth approximation

[TNNLS'2020] Manifold Modeling in Embedded Space: A Perspective for Interpreting Deep Image Prior

[ICASSP'2021] A Plug-and-Play Deep Image Prior

2.3 正则化解决过拟合

2.3.1 网络结构与参数正则化

[ICLR'2019] Deep Decoder: Concise Image Representations from Untrained Non-convolutional Networks

- 是参数量比输出维度之积小的 under-parameterization 方法

- 好处是参数少,无法表征大量噪声

- 图像压缩与解决逆问题

[CVPR'2019] A Bayesian Perspective on the Deep Image Prior

- DIP 可以近似认为是 Stationary Gaussian Processes

- 使用 SGLD 取代 SGD

- 在每一次迭代开始前加入高斯噪声、网络输出的结果做指数平均可以提高去噪性能 (DIP中有这两处代码)

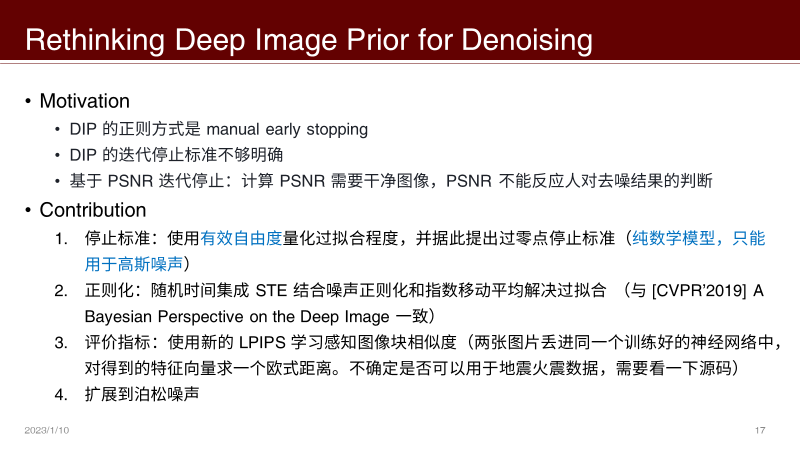

[ICCV'2021] Rethinking Deep Image Prior for Denoising

[IJCV'2021] On measuring and controlling the spectral bias of the deep image prior

分别对卷积层与上采样层正则化,Lipschizs-controlled conv,Gaussian-controlled upsampling

详情:

2.3.2 利用先验进行正则

[ICASSP'2018] Image Restoration using Total Variation Regularized Deep Image Prior

把 TV 全变分先验作为正则项

[NeurIPS'2019] PatchDIP Exploiting Patch Redundancy in Deep Image Prior for Denoising

[ICCV'2019] DeepRED: Deep Image Prior Powered by RED

RED先验作为正则项

2.3.3 Noise modeling

[NeuraIPS'2020] Robust recovery via implicit bias of discrepant learning rates for double over-parameterization

[ICCV'2021] Rethinking Deep Image Prior for Denoising

针对 Gaussian Noise and Possion Noise 建模,前面汇报过了

[NeuraIPS'2021] Rank overspecified robust matrix recovery: Subgradient method and exact recovery

2.3.4 Early stopping

[IJCV'2021] On measuring and controlling the spectral bias of the deep image prior

提出将 blurriness/sharpness 作为迭代停止标准,注意该停止标准适用于该论文提出的正则化之后的网络结构

[BMVA'2021] Self-validation: Early stopping for single-instance deep generative priors

monitoring the DIP reconstruction by training a coupled autoencoder

[arXiv'2021] Early Stopping for Deep Image Prior (ICLR'2023 rej,BMVA'2021的后续工作)

t-99 次迭代到 t 次迭代,一共100次迭代的结果求方差

如果后面1000个这样的方差都大于 t 次迭代时的方差,那么 t 时刻的预测结果作为网络的输出

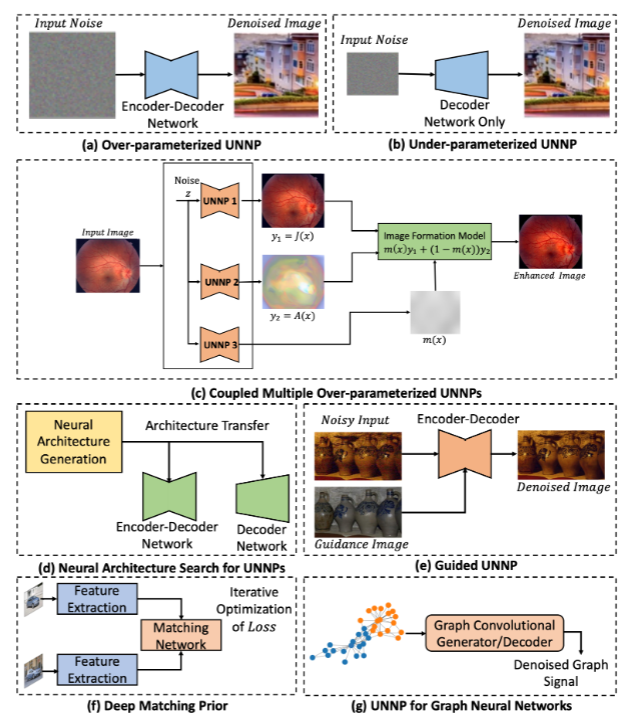

2.4 设计网络结构

a Over-parameterized UNNP

- Deep Image Prior

b Under-parameterized UNNP

[ICLR'2019] Deep Decoder: Concise Image Representations from Untrained Non-convolutional Networks

- 是参数量比输出维度之积小的 under-parameterization 方法

- 好处是参数少,无法表征大量噪声

- 图像压缩与解决逆问题

c 耦合的多DIP

[CVPR'2019] Double-DIP: Unsupervised Image Decomposition via Coupled Deep-Image-Priors

d 网络结构搜索 NAS

[ECCV'2020] NAS-DIP: Learning Deep Image Prior with Neural Architecture Search

- 探索了skip connection、上采样的更多可能

[ccf-c Computers & Graphics] Neural Architecture Search for Deep Image Prior

e Guided UNNP

[ECCV'2020] Guided Deep Decoder: Unsupervised Image Pair Fusion

f 图像匹配 UNNP

[ICCV'2021] Deep Matching Prior: Test-Time Optimization for Dense Correspondence

g 图神经网络 GNN UNNP

[Transactions on Signal Processing'2022] Untrained Graph Neural Networks for Denoising

2.5 隐式模型

[arXiv'2022] PIP: Positional-encoding image prior

[arXiv'2022] TITAN: Bringing The Deep Image Prior to Implicit Representations

2.6 下游任务

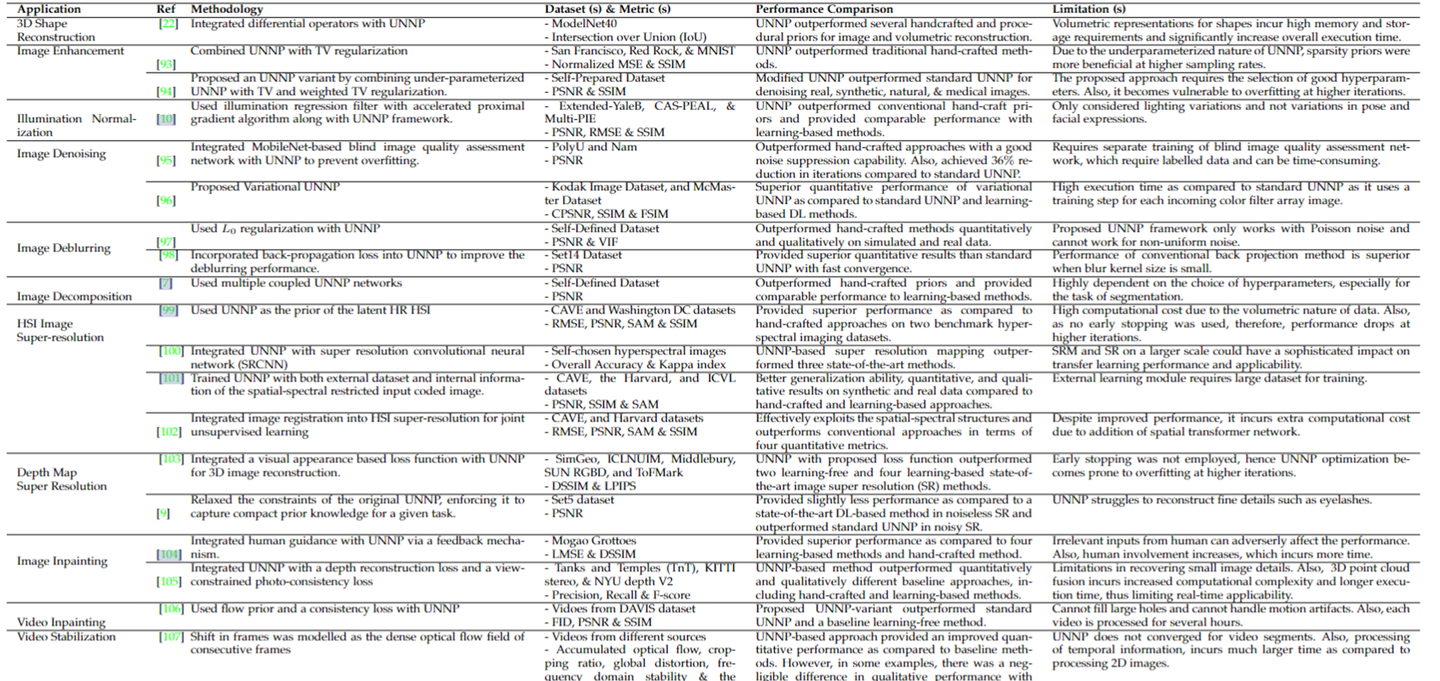

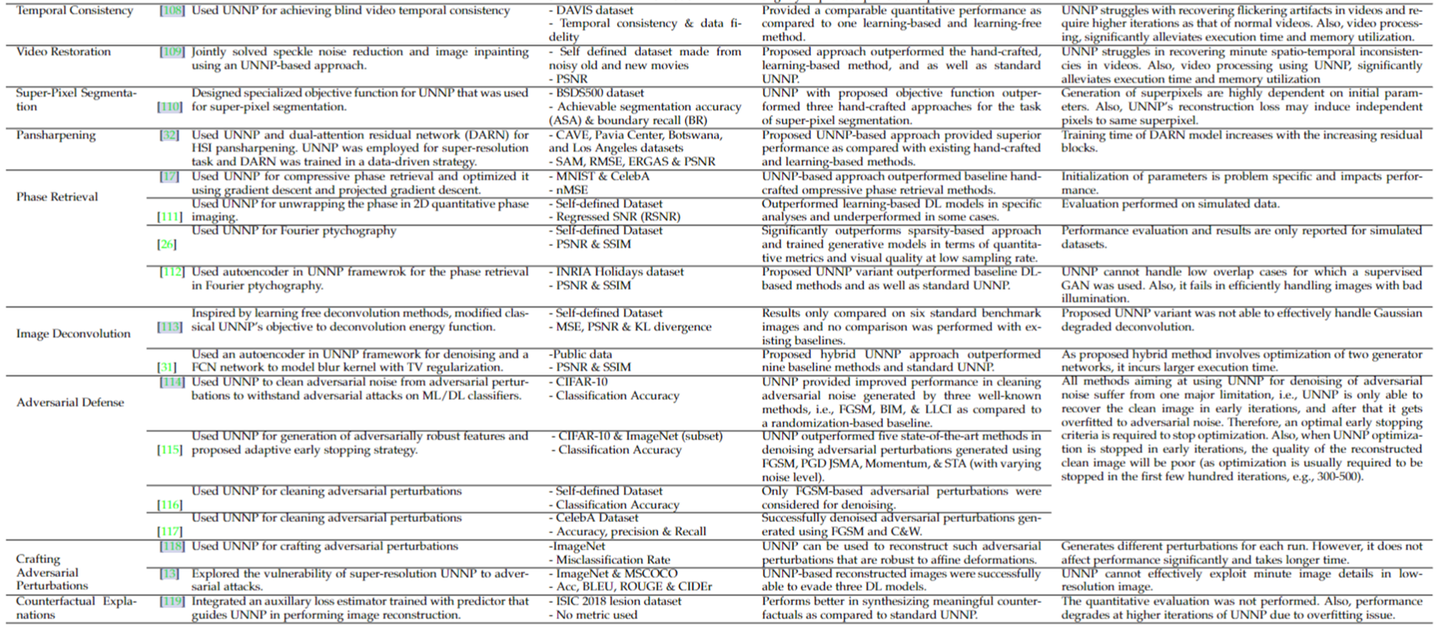

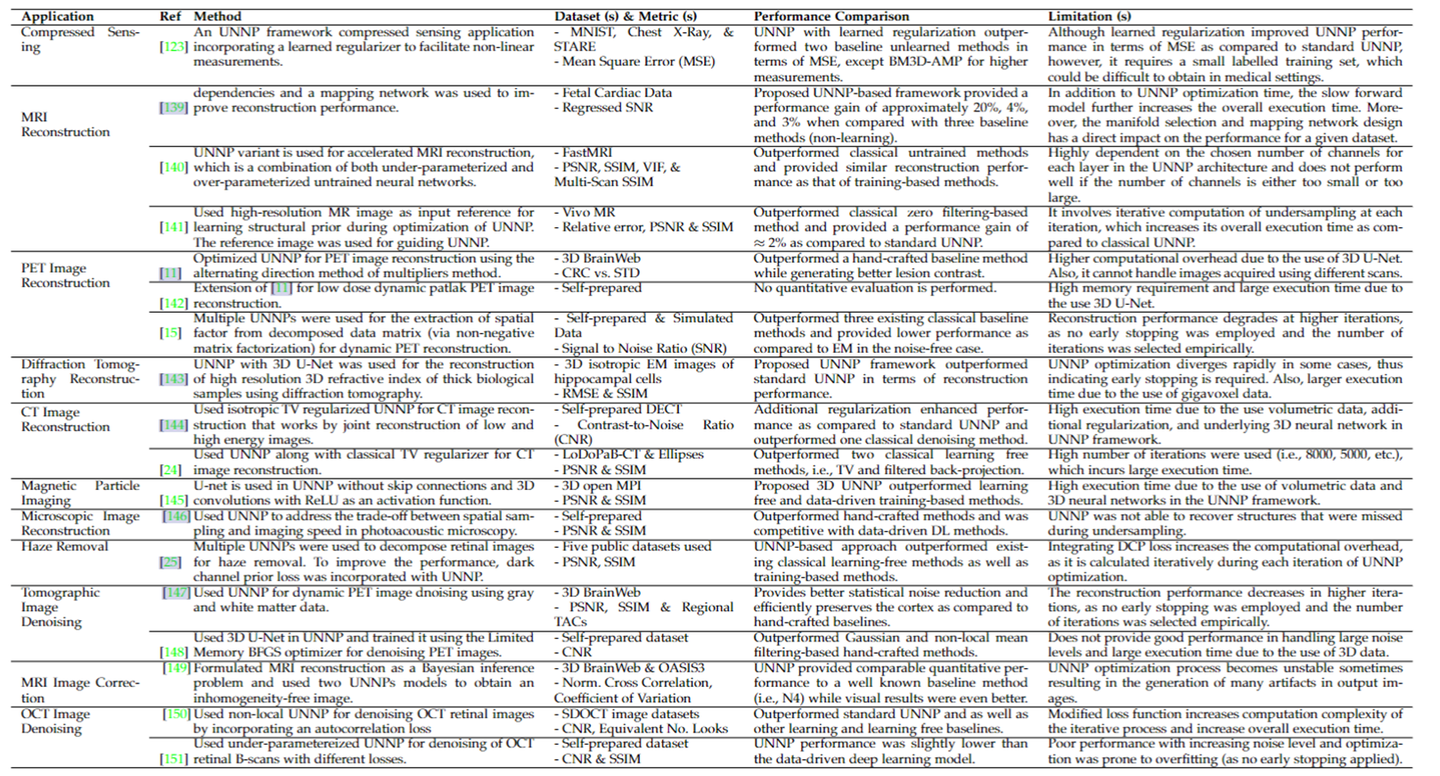

详情见论文的TABLE 3和4,感兴趣的朋友可以自行阅读

Table 3 包括

3D shape Reconstruction, Image Enhancement, Illumination Normalization, Image Denoising, Image Deblurring, Image Decomposition, HSI image super-resolution, Depth Map Super Resolution, Image Inpainting, Video Inpainting, Video Stabilization, Temporal Consistency, Video Restoration, Super-pixel Segmentation, Temporal Consistency, Video Restoration, Super-pixel Segmentation, Pansharpening, Phase Retrieval, Image Deconvolution, Adversarial Defense, Crafting Adversarial Perturbations, Counterfactual Explanations

Table 4 是医学影像专题

3. 总结评价

这篇综述后面还给了一些继续改进的方向,基本上就是 How to 理论解释、How to 正则化、How to 设计网络结构、How to do 下游任务,感兴趣可以看一下

这篇综述没有讲清楚每篇论文的方法与结论,所以只能当目录来看,还是需要自己去读一下提到的论文原文

1543

1543

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?