最近,一些开创性的工作更倾向于应用更复杂的模块来提高分割性能。然而,由于有限的计算资源,它对于实际的临床环境并不友好。为了解决这一挑战,提出了一个轻量级的模型,以实现有竞争力的性能,皮肤病变分割的参数和计算复杂度的最低成本。简而言之,提出了四个模块:

(1)扩展门控注意块(DGA)采用扩张卷积和门控注意机制提取全局和局部特征信息,帮助我们的模型更加关注目标区域。同时,深度可分离卷积进一步减少了参数的数量和计算复杂度。

(2)反向外部注意块(IEA),基于外部注意力对整体数据集进行表征,该机制可以增强样本之间的信息关联,获得整体数据集的特征。

(3)通道注意桥模块(CAB)由1D卷积和全连接层组成,以执行多阶段特征的全局和局部融合,从而生成通道轴上的注意力图;

(4)空间注意桥模块(SAB),其通过共享的2D卷积对多级特征进行操作以在空间轴处生成注意力图。

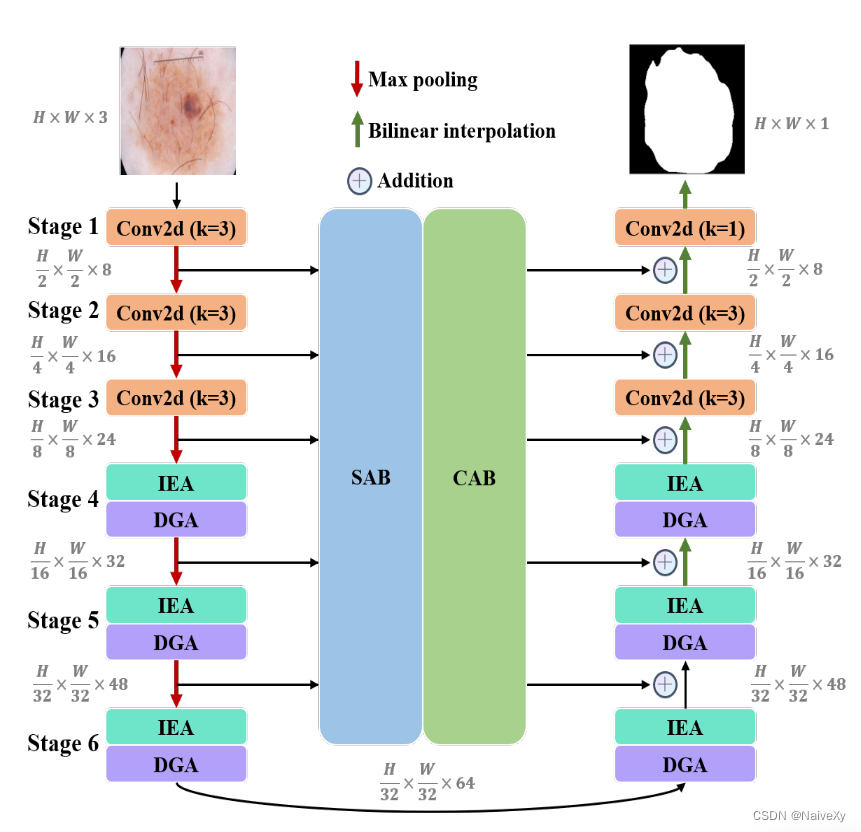

我们联合四个模块与我们的U形架构,并获得一个轻量级的医学图像分割模型称为MALUNet。与UNet相比,我们的模型将mIoU和DSC指标分别提高了2.39%和1.49%,在上述模块的帮助下,我们可以大幅减少模型中的通道数量,并以最少的参数数量和最低的复杂度保持有竞争力的分割效果,参数数量和计算复杂度分别减少了44倍和166倍。此外,我们对两个皮肤病变分割数据集(ISIC 2017和ISIC 2018)进行了比较实验。实验结果表明,我们的模型达到了国家的最先进的平衡参数的数量,计算复杂度和分割性能。

1.扩展门控注意块(DGA)

医学图像分割属于密集预测任务,全局和局部信息的同时获取是提高分割性能的关键。全局信息有助于模型了解病变的整体结构及其与背景的关系,使其更准确地定位病变区域。此外,局部信息有助于获得病变区域的边缘和角落的细节,使得预测更加完整。因此,本文提出了DGA。如图,本模块由两个子单元组成:分离扩张Conv单元(SDC)和门控注意单元(GA)。SDC沿着信道维度将特征图拆分为四个部分,并通过具有不同扩张速率的深度可分离卷积获得全局(扩张速率为5和7的卷积)和局部(扩张速率为1和2的卷积)特征信息。然后,在通道维度中执行级联操作以恢复特征图的大小,随后进行卷积操作以与全局和局部信息交互。其次,对于遗传算法,通过深度可分离卷积生成与输入特征形状相同的注意图,以抑制SDC传输的特征信息的不重要区域,使模型更加关注生命信息。最后,应用剩余连接操作以获得输出。

2.反向外部注意块(IEA)

EAMLP 提出了一种新的注意机制,称为外部注意(EA),它使用两个存储单元(两个共享参数的Conv1D操作)来表征整个数据集的特征信息。此外,受MobileNetV2 (计算机视觉中的通用轻量级骨干)中的反向残差模块的启发,我们提出了用于轻量级医学图像分割模型的反向外部注意力块(IEA),如图所示,给定一个输入X ∈ RC×H×W,经过1 × 1卷积和整形操作,大小变为X ∈ RC×HW。我们使用存储单元1将特征映射扩展到四倍,得到Att ∈ R4C×HW,然后使用存储单元2恢复维数,随后进行整形操作恢复到原始特征映射大小。最后,输出特征图可以通过1 × 1卷积得到,并与残差信息相加。值得注意的是,在IEA中,我们不再像EA那样将两个内存单元之间的通道数固定为64,而是应用了四倍的扩展。其优点在于存储单元将输入映射到更高维的空间,这使得存储单元更全面地描述数据集的整体特征信息。

3.通道注意桥模块(CAB)

多阶段、多尺度信息的获取是分割不同尺度目标的关键,多阶段、多尺度信息的融合是提高分割性能的关键。因此,我们提出了一个桥梁注意模块的通道级,称为CAB。它被用来生成通道注意力地图,通过连接不同阶段的特征,在通道轴,以更好地整合信息。如图以五阶段模型(s = 5)为例,对CAB进行可视化。注意,CAB将多阶段和多尺度信息融合细分为局部信息融合(1D卷积操作)和全局信息融合(用于每个阶段的不同全连接层),以提供信息更丰富的注意力特征图。

4.空间注意桥模块(SAB)

CBAM认为,通道和空间注意力在抑制无关信息方面起着至关重要的作用。因此,受CBAM的启发,我们引入了另一个桥梁注意力模块SAB,如图所示,五阶段SAB被可视化为示例。该模块在空间轴上融合多阶段和多尺度信息,生成每个阶段的注意图。首先,对于每个阶段的特征映射,我们采用平均池化和最大池化操作的通道维度,并将它们连接以获得具有两个通道的特征映射,而高度和宽度保持不变。然后,利用共享的扩张卷积运算(扩张率为3,核大小为7),然后是S形函数以生成每个阶段的空间注意力图。最后,将生成的空间注意力图与原始图逐元素相乘,并添加残差信息。

在结合我们的注意力模块和U形架构之后,我们的模型被称为MALUNet,在MALUNet中,应用了六级U形架构,并且每个级中的通道数量是{8,16,24,32,48,64}。基于UNet,我们增加了一个阶段,并且在阶段1-3中,普通卷积操作从两个减少到一个。在阶段4-6中,我们使用串联布置的IEA和DGA。前者描述数据集的整体特征和样本之间的关系,后者获取样本中的全局和局部特征信息。它们相辅相成,充分利用了不同关注机制的优势。此外,SAB-一阶被用于顺序排列两个桥梁注意模块。两个桥接注意模块可以融合阶段1-5的多阶段和多尺度特征,以生成空间和通道维度的注意图。然后,我们将桥注意模块得到的特征与解码部分的特征相加,以减少编码器和解码器之间的特征语义差异,同时减轻采样过程造成的信息损失。

EXPERIMENTS

为解决有限计算资源下医学图像分割难题,提出轻量级模型MALUNet。该模型包含扩展门控注意块、反向外部注意块、通道注意桥模块和空间注意桥模块。与UNet相比,它提高了mIoU和DSC指标,大幅减少参数数量和计算复杂度,在两个数据集实验中达先进水平。

为解决有限计算资源下医学图像分割难题,提出轻量级模型MALUNet。该模型包含扩展门控注意块、反向外部注意块、通道注意桥模块和空间注意桥模块。与UNet相比,它提高了mIoU和DSC指标,大幅减少参数数量和计算复杂度,在两个数据集实验中达先进水平。

9499

9499

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?