Open Images V5 概述

Open Images是一个由~9M图像组成的数据集,使用图像级标签( image-level labels)、对象边界框(object bounding boxes)、对象分割掩码(object segmentation masks)和视觉关系(visual relationships)进行注释。它总共包含16M个边界框,用于190万(1.9M)张图像上的600个对象类,使其成为现有最大的带有对象位置注释(object location annotations)的数据集。这些方框主要由专业注释人员手工绘制,以确保准确性(accuracy )和一致性(consistency)。图像非常多样化,通常包含多个对象的复杂场景(平均每张图像8.3个对象)。Open Images还提供了可视化的关系注释,指示特定关系中的对象对(例如,“弹吉他的女人”、“桌子上的啤酒”)。共有三胞胎329对,其中三胞胎391,073例(In total it has 329 relationship triplets with 391,073 samples.)。在V5中,我们为350个类中的280万个对象实例添加了分割掩码。分割掩模标记对象的轮廓,它将对象的空间范围描述得更加详细。最后,使用 36.5M 图像级标签(image-level labels)对数据集进行注释,这些标签跨越19,969个类。

我们相信,拥有一个统一的对图像分类、对象检测、视觉关系检测、实例分割的标注的单一数据集,将能够共同研究这些任务,并促进真正的场景理解。

Open Images 扩展(Extended)

Open Images Extended是一组集合(a collection of sets),它用附加的图像和/或注释来补充核心Open Images数据集。您可以在扩展部分()阅读更多相关信息。这个页面的其余部分描述了核心开放图像数据集,没有扩展。

Publications

本文对Open Images V4进行了深入的描述:从数据的收集和注释,到数据的详细统计和基于数据的模型的评估。如果您在工作中使用Open Images数据集(也是V5),请引用本文。

下一篇文章将描述用于在Open Images中注释实例分割(annotate instance segmentations)的技术。如果您使用分割(segmentations),请引用这篇文章。

请同时考虑引用该数据集的一般引用:

Krasin I., Duerig T., Alldrin N., Ferrari V., Abu-El-Haija S., Kuznetsova A., Rom H., Uijlings J., Popov S., Kamali S., Malloci M., Pont-Tuset J., Veit A., Belongie S., Gomes V., Gupta A., Sun C., Chechik G., Cai D., Feng Z., Narayanan D., Murphy K.

OpenImages: A public dataset for large-scale multi-label and multi-class image classification, 2017.

Available from https://storage.googleapis.com/openimages/web/index.html.

[BibTeX]

Data organization

数据集分为训练集(9011,219张图像)、验证集(41,620张图像)和测试集(125,436张图像)。这些图像使用图像级标签、对象包围框、对象分割掩码和如下所述的视觉关系进行注释。

Image-level labels

表1显示了数据集所有分割中的图像级标签(the image-level labels)的概述。所有的图像都有机器生成的图像级标签,这些标签是由类似于谷歌云视觉API的计算机视觉模型自动生成的;此外,在V5数据集发布版中,为了提高标签质量,还对视觉模型进行了升级。这些自动生成的标签有很大的假阳性率(false positive rate)。

此外,验证和测试集以及部分训练集都具有经过人验证的图像级标签。大多数验证都是通过谷歌的内部注释器完成的。一小部分是通过众包完成的:众包应用,g.co/imagelabeler。这个验证过程实际上消除了假阳性(但不是假阴性:图像中可能缺少一些标签)。得到的标签基本上是正确的,我们建议使用这些训练计算机视觉模型。多个计算机视觉模型用于生成示例(不仅仅是用于机器生成标签的模型),这就是词汇表显著扩展的原因(表1中的#classes列)。

总的来说,有19,949个不同的类具有图像级标签。注意,这个数字略高于表1中人工验证标签的数量。原因是有少量的标签的机器生成的组没有出现在human-verified集。可训练的类是那些至少100积极human-verifications V5训练集。基于这个定义,8658类被认为是可训练的和机器生成的标签覆盖8386个。

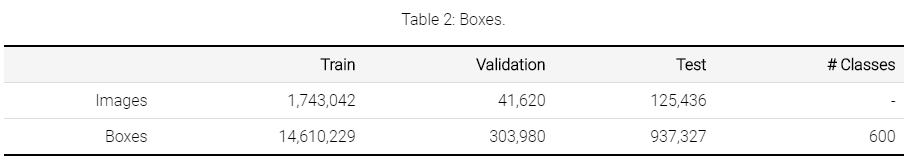

Bounding boxes

表2显示了数据集中所有分割中的包围框注释的概述,这些分割跨越600个对象类。这些提供了比ILSVRC和COCO检测挑战更广泛的范围,包括新的对象,如“fedora”和“snowman”。

对于培训集,我们在174万张图像中为可用的经过人类验证的正面图像级标签标注了框。我们专注于最具体的标签。例如,如果一个图像有标签{car,礼车,螺丝刀(limousine, screwdriver)},我们为礼车和螺丝刀(limousine and screwdriver)标注了盒子。对于图像中的每个标签,我们对图像中该对象类的每个实例都进行了详尽的注释(但关于组用例,请参阅下面)。我们提供146m的包围盒。平均每个图像有8.4个装箱对象。90%的框是由专业注释人员在谷歌上使用高效的极限点击界面[1]手工绘制的。我们使用[2]中方法的增强版本半自动地生成了剩下的10%。这些盒子已经被人类验证为IoU>0.7,在物体上有一个完美的盒子,在实践中它们是准确的(平均IoU ~0.77,见[3]第4.2节)。我们仅为95335张图片绘制了人体部分和“哺乳动物”类的边界框,因为实例数量非常多(在95335张图片中有1327596张)。我们在一组对象周围画了一个框(例如,一个花坛或一群人),如果它们有5个以上的实例,这些实例彼此严重遮挡,并且发生了肢体接触(我们用属性“group of”标记这些框)。

对于验证和测试集,我们为所有对象实例、所有可用的正面图像级标签(同样,除了“groups-of”之外)提供了详尽的框注释。所有的框都是手工绘制的。我们故意尝试在语义层次结构中最特定的层次上注释框。在验证和测试集中,平均每个图像有7.4个框。对于Open Images V5,我们改进了标注密度,现在的标注密度已经接近训练集中的标注密度,这保证了对目标检测模型的评估更加精确。

在所有分割(train、val、test)中,注释器还为每个框标记了一组属性,例如,指示该对象是否被遮挡(请参阅下载部分的完整描述)。

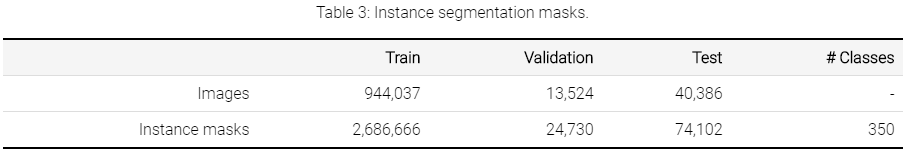

Object segmentations

表3显示了数据集所有分割中的对象分割注释的概述。这些注释涵盖了600个装箱类中的350个类的子集。它们提供了比Cityscapes或COCO更广泛的类别,并涵盖了比ADE20k更多的图像和实例。这些分割用边界框分布在图像的子集上(表2)。

对于训练集,我们从可用的边界框开始,注释了270万个实例掩码。遮罩覆盖350个类,覆盖944k图像。平均每个图像有2.8个分割实例。训练集上的分割掩模是由最先进的交互式分割过程[4]生成的,在这个过程中,专业的人工注释器迭代地纠正分割神经网络的输出。这比单独手工绘图更有效,同时提供精确的掩模(mIoU 84%[4])。

我们根据以下标准选择了350个类来使用分段掩码进行注释:“远足装备”的定义相当模糊);(2)能否定义清晰的标注策略(例如,哪些像素属于一个鼻子?)(3)我们是否期望当前的分割神经网络能够充分捕捉类的形状(例如,水母包含的薄结构是最先进的模型难以实现的)。

我们特别努力确保不同对象之间的注释一致(例如,所有的cat mask都包含它们的尾巴;由骆驼或人携带的袋子,包括在口罩内)。

我们在训练分割上标注了这350个类的所有装箱实例,满足以下条件:(1)对象大小大于40x80或80x40像素;(2)注释器可以自信地确定对象边界(例如跳过模糊或非常暗的实例);(3)边界框包含单个实对象(即没有任何IsGroupOf、isdescription、IsInside属性)。在350个类中,有几个类具有不成比例的大量实例。为了更好地传播注释,我们将四个类别限定为:“衣服”到441k个实例,“人”到149k,“女人”到117k,“男人”到114k。我们总共注释了769k个“人”+“男人”+“女人”+“男孩”+“女孩”+“人体”实例的分割掩码。所有其他类都不使用大写字母进行注释,只使用上面的两个条件。

对于验证和测试分割,我们创建了覆盖54k个图像的99k个掩码。这些都是注释与纯手工自由绘画工具,并与一个强烈的关注质量。它们近乎完美(自我一致性90% mIoU[4]),甚至可以捕捉复杂物体边界的精细细节(例如,人造物体上的尖尖花朵和薄结构)。对于验证和测试分割,我们将这些注释限制为每个类(每个分割)最多600个实例,并应用了与训练分割相同的实例选择标准(最小尺寸、明确的边界、单个实际对象)。在所有实例中,我们的训练和验证+测试注释提供的对象边界比大多数现有数据集[4]提供的多边形注释更精确。

请注意,没有蒙版的实例仍然被它们对应的边界框所覆盖,因此可以在分割模型的训练和评估期间进行适当的处理。

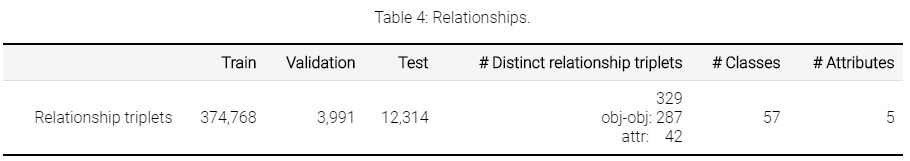

Visual relationships

表4显示了数据集的火车分割中的可视化关系注释的概述。

对于训练集,我们注释了所有已经包含带有对象之间可视关系的边界框注释的图像,对于某些对象,我们注释了可视属性(编码为“is”关系)。

在我们的表示法中,一对由关系连接的对象构成一个三元组(例如,“啤酒表”)。可视属性实际上也是三联体,其中使用关系连接到属性的对象是(例如。“桌子是木制的”、“手提包是皮制的”或“凳子是木制的”)。我们最初根据现有的边界框注释选择了467个可能的三胞胎。其中的329个在训练中至少有一个实例,它们形成了最终的视觉关系/属性三元组。总共,我们在训练分割中注释了375K个三胞胎实例,涉及57个不同的对象类和5个属性。这些包括人与对象的关系(例如,“弹吉他的女人”、“拿麦克风的男人”、“物与物的关系”等。“啤酒在桌上”,“狗在车里”)。

注释是详尽的,这意味着对于每个可能包含关系三元组的图像(即包含该三元组中涉及的对象),我们提供注释,详细列出该图像中的所有正三元组实例。例如,对于一个图像中的“正在弹吉他的女人”,我们列出了在这个图像中的关系“正在弹吉他”中的所有对(“女人”、“吉他”)。所有其他对(女人,吉他)的形象都是负面的例子,为“发挥”的关系。

对于Open Images V5,我们在验证和测试spits上添加了关系注释,以与训练分割相同的方式生成。这些包含相同的329个关系三元组,其中3,991个实例在验证分割上,12,314个实例在测试分割上。总的来说,对于57个带有391k关系注释的对象类,进行了所有的分割。

Class definitions

类由MIDs(机器生成的id)标识,可以在Freebase或谷歌知识图API中找到。每个类的简短描述可以在class description .csv中找到。

Statistics and data analysis

Hierarchy for the 600 boxable classes

在这里可以将boxable类的集合作为层次结构查看,或者下载为JSON文件:

Label distributions(标签分布)

下图显示了注释在数据集中的分布情况。注意,标签分布严重倾斜(注意:y轴是对数刻度)。类按阳性样本的数量排序。绿色表示阳性样本,红色表示阴性样本。

Licenses(许可)

注释由谷歌LLC在CC by 4.0许可下授权。这些图像被列出为具有CC BY 2.0许可。

注意:虽然我们试图识别在知识共享署名许可下授权的图像,但我们不对每幅图像的授权状态做出任何表示或保证,您应该亲自验证每幅图像的授权。

References(参考文献)

-

"Extreme clicking for efficient object annotation", Papadopolous et al., ICCV 2017.

-

"We don't need no bounding-boxes: Training object class detectors using only human verification", Papadopolous et al., CVPR 2016.

-

"The Open Images Dataset V4: Unified image classification, object detection, and visual relationship detection at scale", Kuznetsova et al., arXiv:1811.00982 2018.

-

"Large-scale interactive object segmentation with human annotators", Benenson et al., CVPR 2019.

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?