SOM(Self-Organizing Map,自组织映射)网络也是一种竞争学习型的无监督神经网络。

它能将高维数据映射到低维空间(通常为二维),同时保持输入数据在高维空间的拓扑结构,即将高维数据中相似的样本点映射到网络输出层中的邻近神经元。

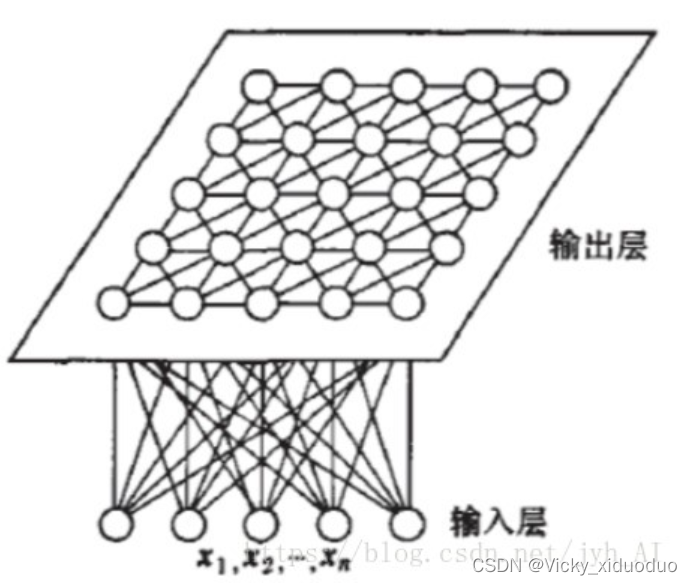

SOM网络结构为:

输入层神经元的数量是由输入向量的维度决定的,一个神经元对应一个特征。

输出层中的一个节点代表一个需要聚成的类。

SOM网络结构的区别主要在竞争层:可以有1维、2维(最常见)。竞争层也可以有更高的维度,不过处于可视化的目的,高维竞争层用的比较少。输出层中的节点与输入层的节点是全连接的。

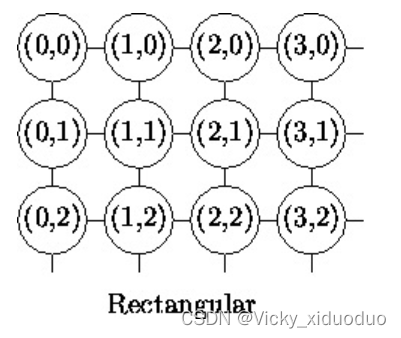

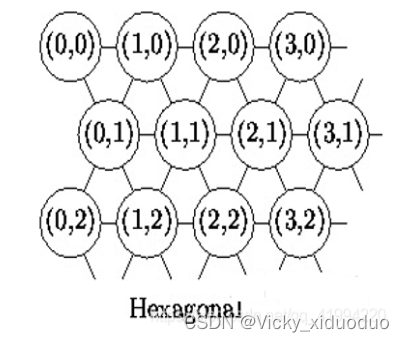

其中二维平面有2种平面结构,即

竞争层SOM神经元的数量决定了最终模型的粒度与规模,这对最终模型的准确性与泛化能力影响很大。

根据查找的资料,有人得出一条经验公式:竞争层最少节点数量=,N是训练样本的个数。如果是正方形输出,边长等于竞争层节点数再开一次根号,并向上取整即可。

SOM网络中的输出层神经元以矩阵方式排列在二维空间中,每个神经元都拥有一个权向量,网络在接收输入向量后,将会确定输出层获胜神经元,它决定了该输入向量在低维空间中的位置。

SOM的训练过程:在接收到一个训练样本后,每个输出层神经元会计算该样本与自身携带的权向量之间的距离,距离最近的神经元成为竞争获胜者,称为最佳匹配单元。然后最佳匹配单元及其邻近神经元的权向量将被调整,以使这些权向量与当前输入样本的距离缩小。这个过程不断迭代,直至收敛。

SOM的主要目标是将任意维度的输入信号模式转换为一维或二维离散映射,并以拓扑有序的方式自适应地执行这种变换。

SOM网采用的算法称为Kohonen算法,在“胜者通吃”(Winner-Talk-All,WTA)学习规则上加以改进的,主要区别是调整权向量与侧抑制的方式不同:

WTA:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

579

579

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?