因为太多的博客并没有深入理解,本文是自己学习后加入自己深入理解的总结记录,方便自己以后查看。

nn.BatchNorm2d()的计算原理详解

学习前言

一起来学习nn.BatchNorm2d()的原理,如果有用的话,请记得点赞+关注哦。

参考链接:

BatchNorm2d这是什么层

BatchNorm2d详解

一、标准化层

torch.nn.BatchNorm2d(num_features, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

1.num_features:输入数据的shape一般为[batch_size, channel, height, width],即为其中特征的数量;

2.eps:分母中添加的一个值,目的是为了计算的稳定性,默认为:1e-5,避免分母为0;

3.momentum:一个用于运行过程中均值和方差的一个估计参数(我的理解是一个稳定系数,类似于SGD中的momentum的系数);

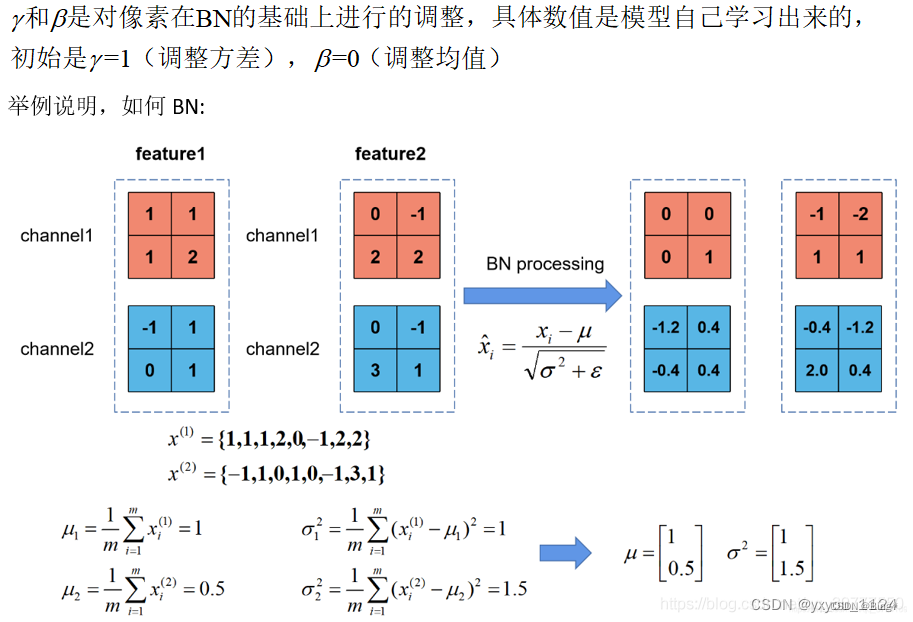

4.affine:当设为true时,会给定可以学习的系数矩阵gamma和beta5、track_running_stats:BatchNorm2d中存储的的均值和方差是否需要更新,若为True,表示需要更新;反之不需要更新。更新公式参考momentum参数介绍

二、作用

1、BatchNorm2d是深度学习中的一种层,用于进行批归一化(Batch Normalization)操作。

注解:批归一化是一种常用的技术,旨在解决深度神经网络训练中的梯度消失和梯度爆炸问题,并提高网络的收敛速度和稳定性。批归一化通过对每个小批量样本的特征进行规范化,使得特征的均值接近0,方差接近1。这样可以使得输入数据分布更加稳定,有助于缓解梯度问题,提高网络的泛化能力

2、 BatchNorm2d的引入对于提高模型的训练速度和性能非常重要。它不仅可以加速收敛过程,还可以提高模型的泛化能力和对输入数据的鲁棒性。因此,BatchNorm2d已成为卷积神经网络中的一种常用层

三、批归一化计算原理

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?