论文地址:https://link.springer.com/article/10.1007/s44267-023-00019-6

摘要

伪装场景理解是一个热门的计算机视觉课题,旨在感知展示伪装的物体,当前技术和应用的繁荣需要最新的研究调查,这可以帮助研究人员更好的了解全球CSU领域,包括当前的成就和剩余的挑战。本文提出了四个贡献:

(1)首次全面介绍了面向CSU的深度学习技术的调查,包括分类法、任务特定的挑战和正在进行的发展

(2)为了对最新技术进行权威量化,我们提供了最大和最新的隐蔽物体分割基准

(3) 为了评估深度CSU在实际场景中的普适性,我们收集了最大的隐蔽缺陷分割数据集CDS2K,其中包含来自多样化工业场景的困难案例,并在此基础上构建了一个全面的基准

(4)我们讨论了CSU的开放问题和潜在的研究方向。

关键词:隐蔽场景理解 分割 检测 调查 入门 分类 深度学习 机器学习

1.引言

隐蔽场景理解(CSU)旨在识别呈现不同伪装形式的物体,如图1所示。由于其本质特点,与传统的目标检测相比,CSU显然是一个具有挑战性的问题。它具有许多现实世界的应用,包括搜救工作、稀有物种发现、医疗保健(例如,结直肠息肉的自动诊断和肺部病变)、农业(例如,害虫识别和水果成熟度评估)以及内容创作(例如,娱乐艺术)。在过去的十年中,学术界和工业界广泛研究了CSU,并使用传统的计算机视觉和模式识别技术处理了各种带有伪装物体的图像,包括手工设计的模式(例如,运动线索和光流)、启发式先验(例如,颜色、纹理和强度)以及技术的组合。

近年来,得益于基准数据集的出现(如COD10K和NC4K)以及深度学习的快速发展,这个领域取得了重要的进展。2020年,Fan等人发布了第一个面向感知任务的大规模公开数据集COD10K,旨在处理隐蔽性问题。这也激发了其他相关学科的研究。例如,Mei等人提出了一种分散注意力的框架,用于伪装物体的分割,该框架可以扩展到自然场景中透明材料的识别。2023年,Ji等人开发了一种有效的模型,通过从物体级梯度中学习纹理,并通过各种下游应用程序验证了其泛化能力,例如医学息肉分割和道路裂缝检测。

尽管多个研究团队已经开始研究与隐蔽物体相关的任务,但我们认为加强这些研究之间的互动将会有益。因此,我们主要回顾了目前在计算机视觉中的状态和最新的基于深度学习的进展。同时,我们贡献了一个名为CDS2K的大规模隐蔽缺陷分割数据集。该数据集包含来自不同工业场景的困难案例,为计算机视觉提供了一个有效的基准。

过往的调查和范围 据我们所知,仅有少数几篇综述论文在CSU社区中发表,其中[29,30]主要回顾了非深度学习技术。有一些基准测试[31,32]的范围较窄,例如图像级分割,仅评估了少数深度学习方法。在本文中,我们提出了深度学习CSU技术的全面调查,从而扩大了范围。我们还提供了更广泛的基准测试,进行了更全面的比较和应用导向的评估。

贡献

我们的贡献总结如下:

(1)我们代表了首次彻底研究针对CSU的深度学习技术的努力。这包括对其分类和特定障碍的概述,以及通过对现有数据集和技术的审查来评估其在深度学习时代的进展。

(2)为了对当前最先进技术进行定量评估,我们创建了一个新的隐蔽目标分割(COS)基准,这是CSU领域的一个关键和非常成功的领域。这是目前最新和最全面的基准。

(3)为了评估深度学习在实际场景中应用于CSU的可行性,我们对CDS2K数据集进行了重组,这是用于隐蔽缺陷分割的最大数据集,包括来自各种工业环境的具有挑战性的案例。我们利用这个更新的数据集创建了一个全面的评估基准。

(4) 我们的讨论深入探讨了目前CSU社区面临的障碍、可利用的前景和未来的研究领域。

2.背景

2.1 任务分类和形式化定义

2.1.1 图像级CSU

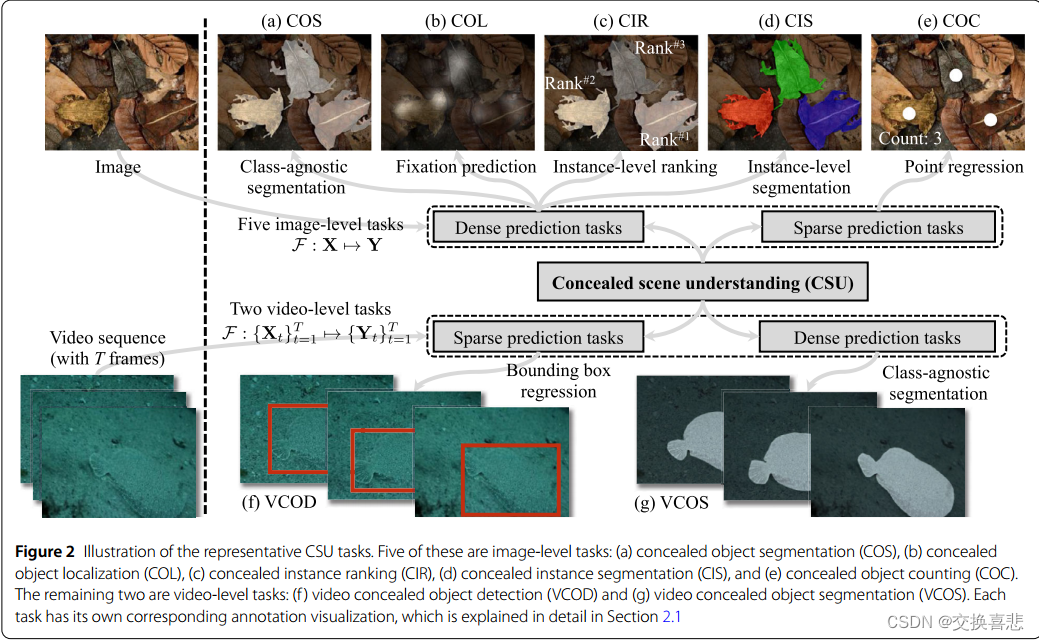

在本节中,介绍了五个常用的图像级CSU任务,这些任务可以被形式化成为一个映射函数F:X→Y,将输入空间X转换为目标空间Y

• 伪装目标分割(Concealed Object Segmentation,COS)是一项类别不可知的密集预测任务,用于分割具有未知类别的隐蔽区域或物体。如图2(a)所示,模型FCOS:X→Y由二进制掩码Y监督,以预测图像X的每个像素x的概率p∈[0,1],这是模型确定x是否属于隐蔽区域的置信水平。

•伪装目标定位(Concealed Object Localization,COL)旨在确定隐藏物体最显著的区域,与人类感知心理学相一致[33]。 该任务是学习一个密集映射函数FCOL:X → Y。输出Y是由眼动追踪设备捕获的非二进制注视图,如图2(b)所示。实质上,对于像素x的概率预测p ∈ [0, 1]表示了该像素上的注视度。

•伪装实例排序(Concealed Instance Ranking,COR)根据实例的可检测性对隐蔽场景中的不同实例进行排名。这种排名是基于伪装程度来进行的。CIR任务的目标是学习一个密集映射 FCIR: X → Y,将输入空间 X 和伪装排名空间 Y 进行映射,其中 Y 表示每个实例的每个像素的注释,带有相应的排名级别。例如,在图2©中,有三只具有不同伪装级别的蟾蜍,它们的排名标签来自[24]。为了完成这个任务,可以在实例分割模型(如Mask R-CNN [34])中用排名标签替换每个实例的类别ID。

•伪装实例分割(Concealed Instance Segmentation,CIS)是一种旨在基于语义特征在隐蔽场景中识别实例的技术。与一般实例分割[37, 38]不同,其中每个实例被分配一个类别标签,CIS识别隐蔽对象的属性以更有效地区分不同实体。为实现这一目标,CIS采用一个映射函数FCIS:X→Y,其中Y是一个标量集合,包括用于解析每个像素的各种实体。该概念如图2(d)所示。

•伪装目标计数(Concealed Object Counting,COC)是CSU中的一个新兴课题,旨在估计隐藏在周围环境中的实例数量。如图2(e)所示,COC估计每个实例的中心坐标并生成它们的计数。其公式可以定义为FCOC: X → Y,其中X是输入图像,Y表示指示场景中隐藏实例的输出密度图。

总体而言,基于语义,图像级CSU任务可以分为两组:对象级(COS和COL)和实例级(CIR、COC和CIS)。

对象级任务专注于感知对象,而实例级任务旨在识别语义以区分不同的实体。此外,基于其输出形式,COC被视为一种稀疏预测任务,而其他任务属于密集预测任务。在表1中回顾的文献中,COS得到了广泛研究,而对其他三个任务的研究逐渐增加。

2.1.2 视频级CSU

给定一个包含T个隐藏帧的视频剪辑{Xt}T t=1,视频级联合解析可以被表示为一个映射函数F:{Xt} T t=1 ↑→ {Yt} T t=1,用于解析密集的时空对应关系,其中Yt是帧Xt的标签。

•视频隐蔽物体检测(VCOD)[40] 类似于视频物体检测[41]。该任务旨在通过学习一个空间-时间映射函数 FVCOD : {Xt} T t=1 → {Yt} T t=1 来识别和定位视频中的隐蔽物体,该函数预测每帧 Xt 中物体的位置 Yt。位置标签 Yt 以边界框的形式提供(见图2(f)),边界框由四个数字(x,y,w,h)组成,表示目标的位置。这里,(x,y)表示其左上角坐标,w 和 h 分别表示其宽度和高度。

•视频隐蔽物体分割(VCOS)[42] 源于伪装物体发现任务[40]。其目标是在视频中分割出隐蔽的物体。这个任务通常利用时空线索来驱动模型学习输入帧Xt与相应分割掩码标签Yt之间的映射FVCOS: {Xt}T t=1 ↑→ {Yt} T t=1。图2(g)展示了一个分割掩码的示例。

总体而言,与图像级别的CSU相比,视频级别的CSU发展较慢,因为收集和注释视频数据需要大量的人力和时间。然而,随着在MoCA-Mask [42]上建立了第一个大规模的VCOS基准,这个领域取得了根本性的进展,同时还有很大的探索空间。

2.1.3 任务之间的关系

在图像级CSU任务中,CIR任务需要最高水平的理解,因为它不仅涉及到四个子任务,例如分割像素级区域(即COS),计数(即COC),或者区分不同实例(即CIS),还需要根据不同难度级别对这些实例进行排名,排名依据是它们的注视概率(即COL)。此外,关于两个视频级任务,VCOS是VCOD的下游任务,因为分割任务要求模型提供像素级分类概率。

2.2 相关的主题

接下来,我们将简要介绍显著目标检测(Salient Object Detection,SOD),它与COS类似,都需要提取目标对象的属性,但一个关注显著性,另一个关注隐含属性。

•图像级显著目标检测旨在识别图像中最具吸引力的对象,并提取其像素精确的轮廓[43]。深度显著目标检测模型中已经探索了各种网络架构,例如多层感知器[44-47]、全卷积[48-52]、胶囊网络[53-55]、变换器网络[56]和混合网络[57, 58]。同时,显著目标检测模型中也研究了不同的学习策略,包括数据高效的方法(例如弱监督的分类标签[59-63]和伪标注的无监督方法[64-66])、多任务范式(例如目标子计数[67, 68]、注视点预测[69, 70]、语义分割[71, 72]、边缘检测[73-77]、图像字幕生成[78])和实例级范式[79-82]。为了全面了解这个领域,读者可以参考关于视觉注意力[83]、显著性预测[84]、共显性检测[85-87]、RGB显著目标检测[1, 88-90]、RGB-D(深度)显著目标检测[91, 92]、RGB-T(热红外)显著目标检测[93, 94]和光场显著目标检测[95]的流行综述或代表性研究。

•视频级别的显著性目标检测(VSOD)的早期发展源于在视频目标分割(VOS)任务中引入注意机制。在那个阶段,任务场景相对简单,只包含一个在视频中移动的对象。由于移动对象往往会吸引视觉注意力,因此VOS和VSOD是等价的任务。例如,Wang等人[96]使用全卷积神经网络来处理VSOD任务。随着VOS技术的发展,研究人员引入了更复杂的场景(例如复杂的背景、对象运动和两个对象),但这两个任务仍然是等价的。因此,后续的研究工作利用了语义级的时空特征[97-100]、循环神经网络[101, 102]或离线运动线索(如光流)[101, 103-105]。然而,随着更具挑战性的视频场景的引入(包含三个或更多对象、同时的摄像机和对象运动),VOS和VSOD不再是等价的。然而,研究人员继续将这两个任务视为等价,忽视了视频场景中多对象动态下的视觉注意力分配问题,严重阻碍了该领域的发展。为了解决这个问题,2019年,Fan等人[106]引入了眼动追踪器来标记多对象运动场景中的视觉注意力变化,首次提出了VSOD任务中的注意力转移科学问题,并构建了第一个大规模的VSOD基准测试集-DAVSOD,以及基准模型SSAV,推动了VSOD进入新的发展阶段。

•评论 COS和SOD是不同的任务,但它们可以通过CamDiff方法[107]相互受益。这已经通过对抗学习[108]得到了证明,并导致了联合研究努力,如最近提出的二元图像分割[109]。在第6节中,我们将探讨这些领域未来研究的潜在方向。

3.深度学习CSU模型

本节系统地回顾了基于深度学习方法的CSU(Code-Switching Understanding)研究,基于任务定义和数据类型进行分类。我们还创建了一个名为"base2"的GitHub仓库,作为一个综合性的收集,提供该领域最新的信息。

3.1 图像级别的CSU模型

我们回顾了现有的四个图像级CSU任务:隐蔽物体分割(COS),隐蔽物体定位(COL),隐蔽实例排序(CIR)和隐蔽实例分割(CIS)。表1总结了这些回顾方法的关键特点。

3.1.1 伪装目标分割

本节讨论了以往在伪装物体分割(COS)中的两个角度上的解决方案:网络架构和学习范式。

•网络架构。通常,全卷积网络(FCNs [150])是图像分割的标准解决方案,因为它们可以接收灵活尺寸的输入并进行单次前向传播。预期地,FCN形状的框架主导了COS的主要解决方案,分为三类:

(1)多流框架,如图3(a)所示,包含多个输入流以明确学习多源表示。MirrorNet [110]是第一个尝试添加额外数据流作为生物启发式攻击的方法,可以打破伪装状态。最近的一些研究采用了多流方法来改进他们的结果,例如提供伪深度生成[149]、伪边缘不确定性[114]、对抗学习范式[108]、频率增强流[135]、多尺度[134]或多视角[141]输入以及多个主干网络[147]。与其他监督设置不同,CRNet [142]是唯一使用涂鸦标签作为监督的弱监督框架。这种方法有助于缓解有限注释数据上的过拟合问题。

(2)如图3(b)所示的自下而上和自上而下的框架,通过单次前向传递逐渐使用更深层次的特征来增强更浅层次的特征。例如,C2FNet [113] 采用这种设计来改进从粗到细级别的隐蔽特征。此外,SegMaR [136] 使用基于此策略的子网络的迭代细化网络。此外,其他研究[20、23、25、26、112、118-121、124、125、129、138-140、143-145、148]利用这种框架在各种中间特征层次上采用深度监督策略[151、152]。这种做法也被特征金字塔网络[153]采用,通过密集的自上而下和自下而上的传播结合更全面的多上下文特征,并在最终预测之前引入额外的监督信号,为更深层提供更可靠的指导。

(3)图3©所示的分支框架是一种单输入多输出的架构,由分割和辅助任务分支组成。值得注意的是,这个分支框架的分割部分可能与之前的框架有一些重叠,比如单流[21]和自底向上和自顶向下[24, 28, 33, 108, 111, 115–117, 122, 123, 125–128, 130–133, 137]框架。例如,ERRNet [123]和FAPNet [127]是联合学习隐藏对象及其边界的典型示例。由于这些分支框架与多任务学习范式密切相关,我们将提供进一步的细节。

学习范式 我们讨论COS任务的两种常见学习范式:单任务和多任务。

(1)单任务学习是COS中最常用的范式,它仅涉及隐藏目标的分割任务。基于这个范式,目前大多数工作[20, 23, 121]都集中于开发注意力模块来识别目标区域。

(2) 多任务学习引入辅助任务以协调或补充分割任务,从而实现鲁棒的COS学习。这些多任务框架可以通过进行置信度估计[108, 117, 130, 132],定位/排名[24, 33],类别预测[21]任务和学习伪装对象的深度[111, 149],边界[116, 122, 123, 126, 127, 131]和纹理[28, 115]线索来实现。

3.1.2 伪装实例排名

在这个主题上,目前的研究非常有限。

Lv等人[24]首次观察到现有的COS方法无法量化伪装的难度水平。针对这个问题,他们使用了一个眼动追踪器创建了一个新的数据集,称为CAM-LDR [33],其中包含了实例分割掩模、注视标签和排名标签。他们还提出了两个统一的框架,LSR [24]和其扩展版本LSR+ [33],以同时学习三个任务,即定位、分割和排名伪装对象。其背后的思想是,有区分度的定位区域可以引导对整个伪装对象的分割,然后通过排名任务可以推断不同伪装对象的可检测性。

3.1.3 伪装实例分割

该任务将COS任务从区域级别推进到实例级别,与COS相比,这是一个相对较新的领域。然后,Le等人[36]通过扩展先前的CAMO [21]数据集构建了一个新的CIS基准,CAMO++。他们还提出了一种伪装融合学习策略,通过学习图像上下文来微调现有的实例分割模型(例如Mask R-CNN [34])。基于实例基准,如COD10K [20]和NC4K [24],第一个单阶段变换器框架OSFormer [35]被引入到该领域,其中引入了两个核心设计:位置感知变换器和粗到细的融合。最近,Luo等人[146]提出了使用两个设计来分割伪装实例:像素级伪装解耦模块和实例级伪装抑制模块。

3.1.4 伪装物体计数

Sun等人[39]最近为社区提出了一个新的挑战,称为不可辨识目标计数(IOC),它涉及到难以从周围环境中区分的物体计数。他们创建了IOCfish5K,这是一个包含高分辨率水下场景图像和密集注释的大规模数据集,用于解决这一挑战中缺乏适当数据集的问题。他们还提出了一个名为IOCFormer的基线模型,通过将基于密度和基于回归的方法整合到一个统一的框架中来实现。

根据上述总结,COS任务正在经历一个快速发展的时期,每年都会出现大量的当代出版物。然而,对于COL、CIR和CIS任务,很少有提出的解决方案。这表明这些领域仍然未被充分探索,并为进一步研究提供了重要的空间。值得注意的是,许多先前的研究可作为参考(如显著性预测[84]、显著目标估计[68]和显著实例分割[82]),为从伪装视角理解这些任务提供了坚实的基础。

3.2 视频级别的CSU模型

视频级别的CSU任务有两种思路,包括从视频中检测和分割伪装对象。详见表2。

3.2.1 视频中的伪装物体检测

大多数研究[156, 158]将这个主题定为由于像素级注释的稀缺性而导致分割任务的退化问题。它们通常是在分割数据集(如DAVIS [161]和FBMS [162])上进行训练,但在一个视频伪装目标检测数据集MoCA [40]上评估泛化性能。这些方法一致选择提取离线光流作为分割任务的运动指导,但它们在学习策略上有所不同,例如使用真实[40, 157, 160]或合成[155, 158]数据的全监督学习以及自监督学习[156, 159]。

3.2.2 视频中的伪装物体分割

谢等人[154]提出了关于视频中伪装物体发现的首个研究工作。他们使用了一个像素轨迹循环神经网络来对前景运动进行聚类分割。然而,这项工作仅限于小规模数据集CAD [163]。最近,程等人[42]基于定位级别数据集MoCA [40],并使用边界框标签,扩展了这个领域,创建了一个大规模VCOS基准数据集MoCA-Mask,并提供了像素级掩码。他们还引入了一个两阶段的基准模型SLTNet,以隐式地利用运动信息。

根据我们以上的回顾,目前用于VCOS任务的方法仍处于初级发展阶段。在已建立的视频分割领域中,有几项并行工作(例如,自监督对应学习[164–168]、不同基于运动的任务的统一框架[169–171]),为进一步探索指明了方向。此外,考虑到高级语义理解存在研究空白,值得补充,例如伪装场景中的语义分割和实例分割。

4.CSU 数据集

近年来,针对图像和视频级别的CSU任务已经收集了各种数据集。在表3中,我们总结了代表性数据集的特征。

6.讨论和展望

根据我们的文献综述和实验分析,在本节中我们讨论了五个挑战和潜在的与CSU相关的方向。

•注释效率学习。深度学习技术在计算机视觉领域取得了显著进展。然而,传统的有监督深度学习对数据需求量大且资源消耗高。在实际场景中,我们希望模型能够在有限资源下工作并具有良好的泛化能力。因此,为计算机视觉任务开发有效的学习策略是一个有前景的方向,例如在CRNet [142]中的弱监督策略。

•领域适应。伪装样本通常是从自然场景中收集的。因此,在自动驾驶场景中部署模型以检测隐藏的物体是具有挑战性的。最近的实践表明,可以使用各种技术来缓解这个问题,例如领域适应[185, 186]、迁移学习[187]、少样本学习[188]和元学习[189]。

•高保真合成数据集。为了减轻算法偏差,增加数据的多样性和规模至关重要。人工智能生成内容(AIGC)[190]和深度生成模型(如生成对抗网络[191–193]和扩散模型[194, 195])的快速发展,使得在一般领域中创建合成数据变得更加容易。最近,为了解决多模式训练图像的稀缺性问题,Luo等人[107]提出了一种基于扩散的图像生成框架,该框架在保留原始标签的同时在伪装样本上生成显著对象。因此,模型应能够区分伪装和显著对象,以实现稳健的特征表示。

• 神经网络架构搜索。自动网络架构搜索(NAS)是一个有前途的研究方向,可以发现在给定任务上性能优越的最佳网络架构。在隐蔽情境中,NAS可以识别更有效的网络架构来处理复杂的背景场景、高度可变的物体外观和有限的标记数据。这可以导致更高效和有效的网络架构的开发,从而提高准确性和效率。将NAS与领域自适应和数据高效学习等其他研究方向相结合,可以进一步增强对隐蔽场景的理解。

这些探索方向具有推动最新技术发展的重要潜力,并值得在未来的研究中进一步探索。

• 大模型和提示工程。这个主题已经受到了广泛关注,甚至成为自然语言处理社区的一个方向。最近,任何事物模型(SAM)[196]在计算机视觉算法中引起了革命,尽管在几个隐蔽场景的非提示设置中存在局限性[197]。可以利用提示工程范式,使用经过训练的强大编码器和任务特定的调整(如任务特定提示和多任务预测头)来简化工作流程。这种方法有望成为计算机视觉社区的未来趋势。大语言模型(LLMs)为人工智能带来了新的机遇和挑战,进一步推动了人工通用智能的发展。然而,对于学术界来说,训练资源消耗大的大模型是具有挑战性的。有一种有前途的范式是将最新的深度学习CSU模型作为领域专家,并且大模型可以作为外部组件来辅助专家模型提供辅助决策、表示等。

2163

2163

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?