Broadcast

看名字就很好理解了,其实就是把同一份数据分发广播给所有人,示意图如下:

Scatter

不同于Broadcast, scatter可以将不同数据分发给不同的进程。

Gather

这个也很好理解,就是把多个进程的数据拼凑在一起。

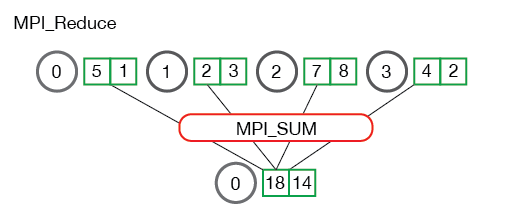

Reduce

reduce就是将多个进程中的数据按照指定的映射函数进行运算得到最后的结果存在一个进程中,例如下面两个图中的归约操作都是求和,将4个不同进程的数据归约求和后存在了第一个进程中

All-reduce

All-reduce与reduce的区别就在于后者最后的结果是只保存在一个进程中,而All-reduce需要每个进程都有同样的结果。所以All-reduce一般包含scatter操作,所以有时候也会看到reduce-scatter这种说法,其实reduce-scatter可以看成是all reduce的一种实现方式

参考

- https://python-parallel-programmning-cookbook.readthedocs.io/zh_CN/latest/chapter3/14_Collective_communication_using_broadcast.html

- https://mpitutorial.com/tutorials/mpi-reduce-and-allreduce/

366

366

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?