点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信:CVer5555,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

作者:Latte拿铁(来源@知乎)

https://zhuanlan.zhihu.com/p/687763586

GiT是一个多任务视觉模型,跨越五个代表性基准进行联合训练,无需特定任务的微调。它在通用性能上建立了一个新的基准,并促进了任务之间的相互增强,导致与孤立训练相比显著的改进。

GiT: Towards Generalist Vision Transformer through Universal Language Interface

代码:https://github.com/Haiyang-W/GiT

论文:https://arxiv.org/abs/2403.09394

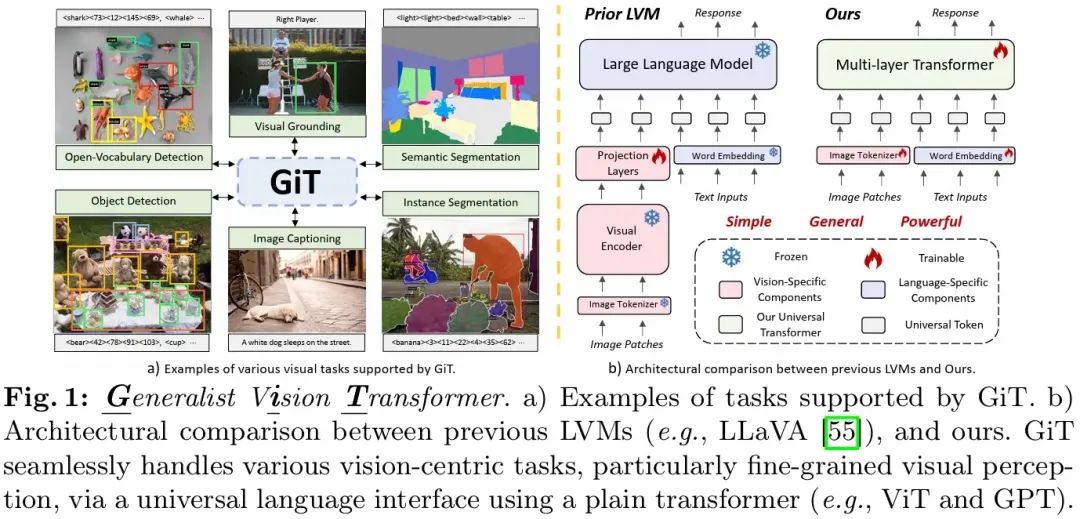

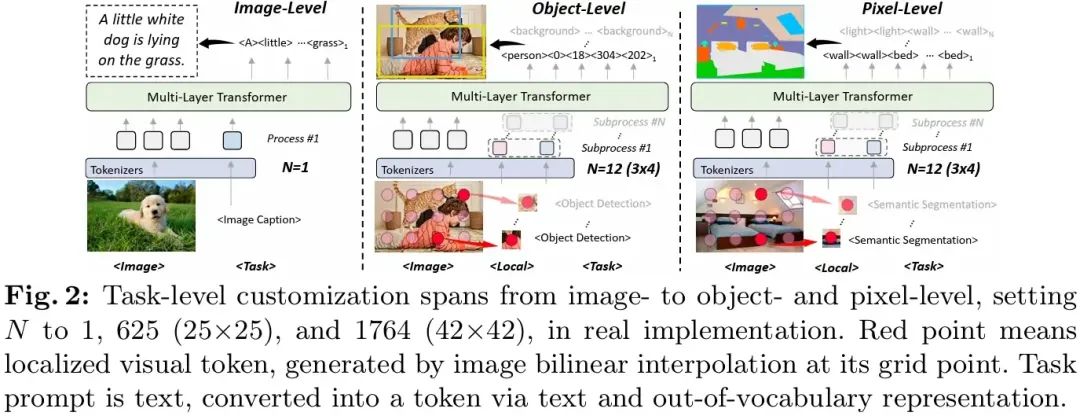

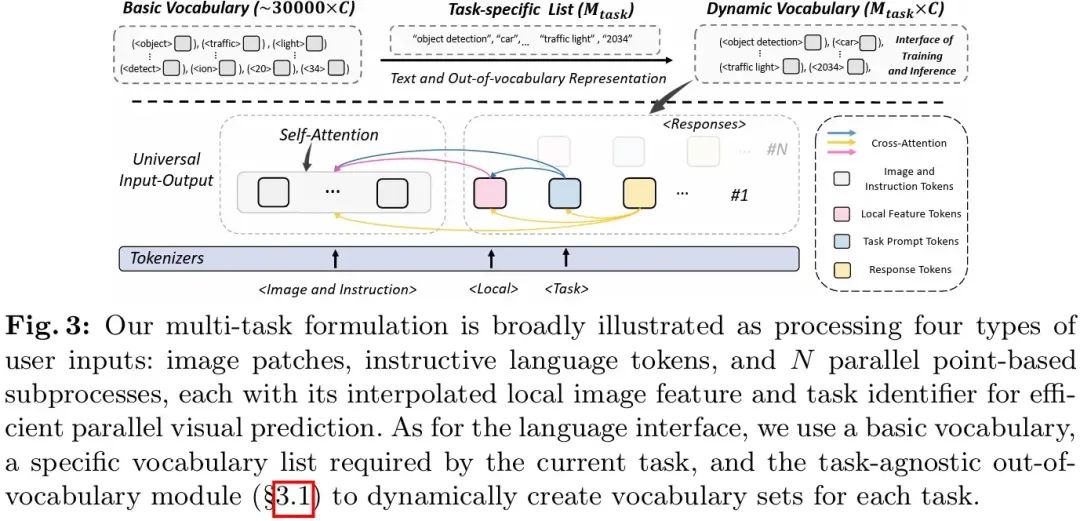

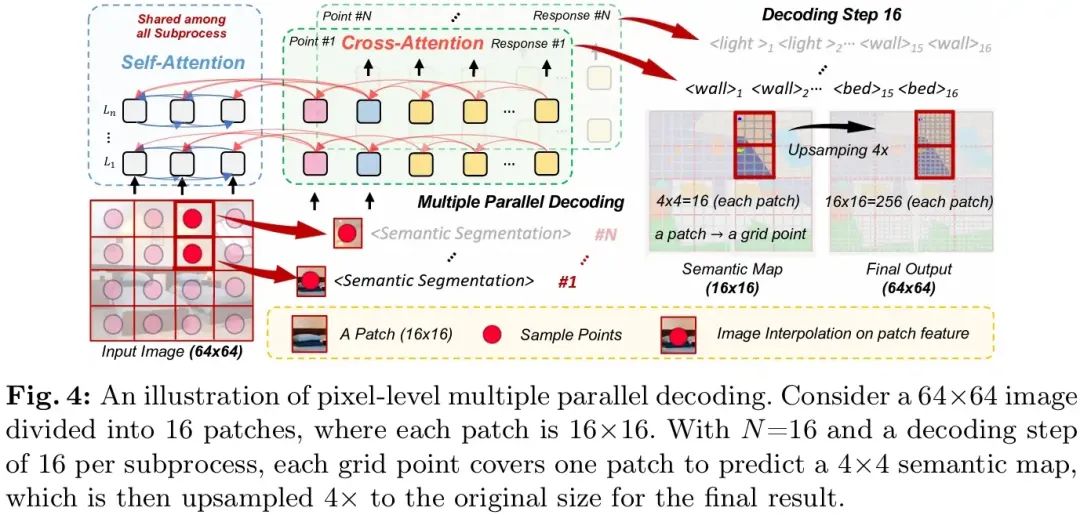

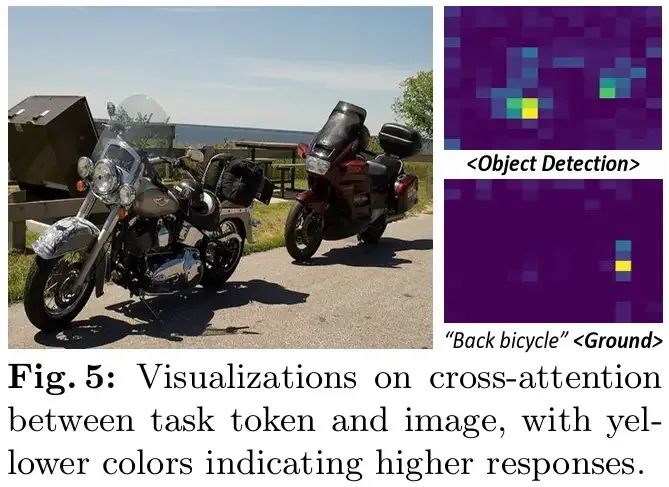

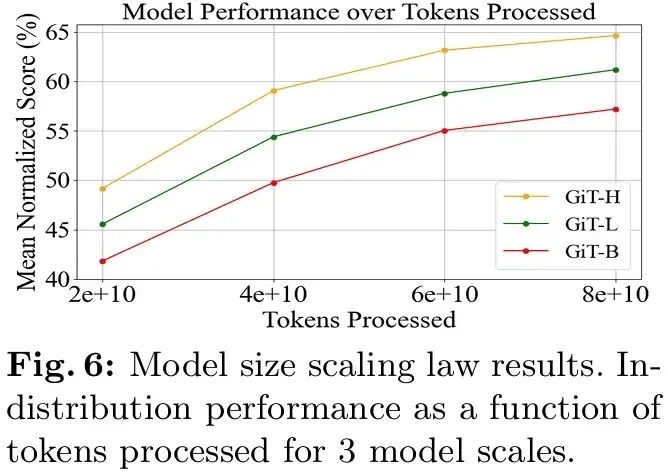

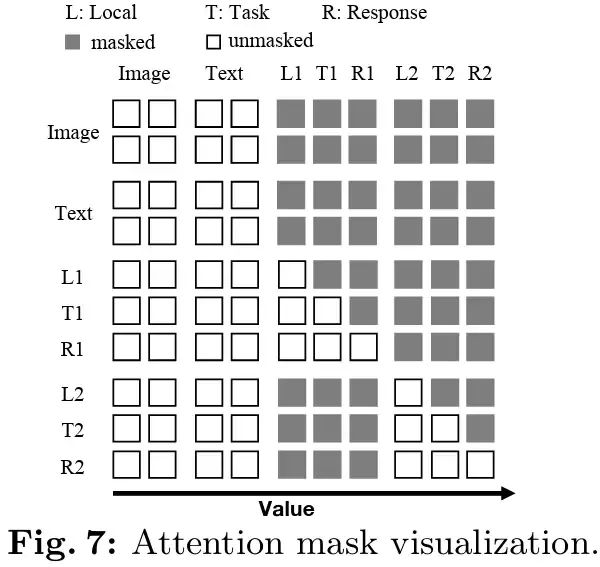

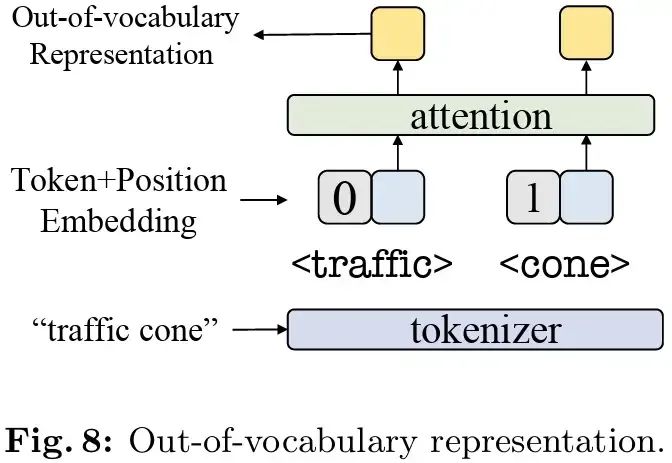

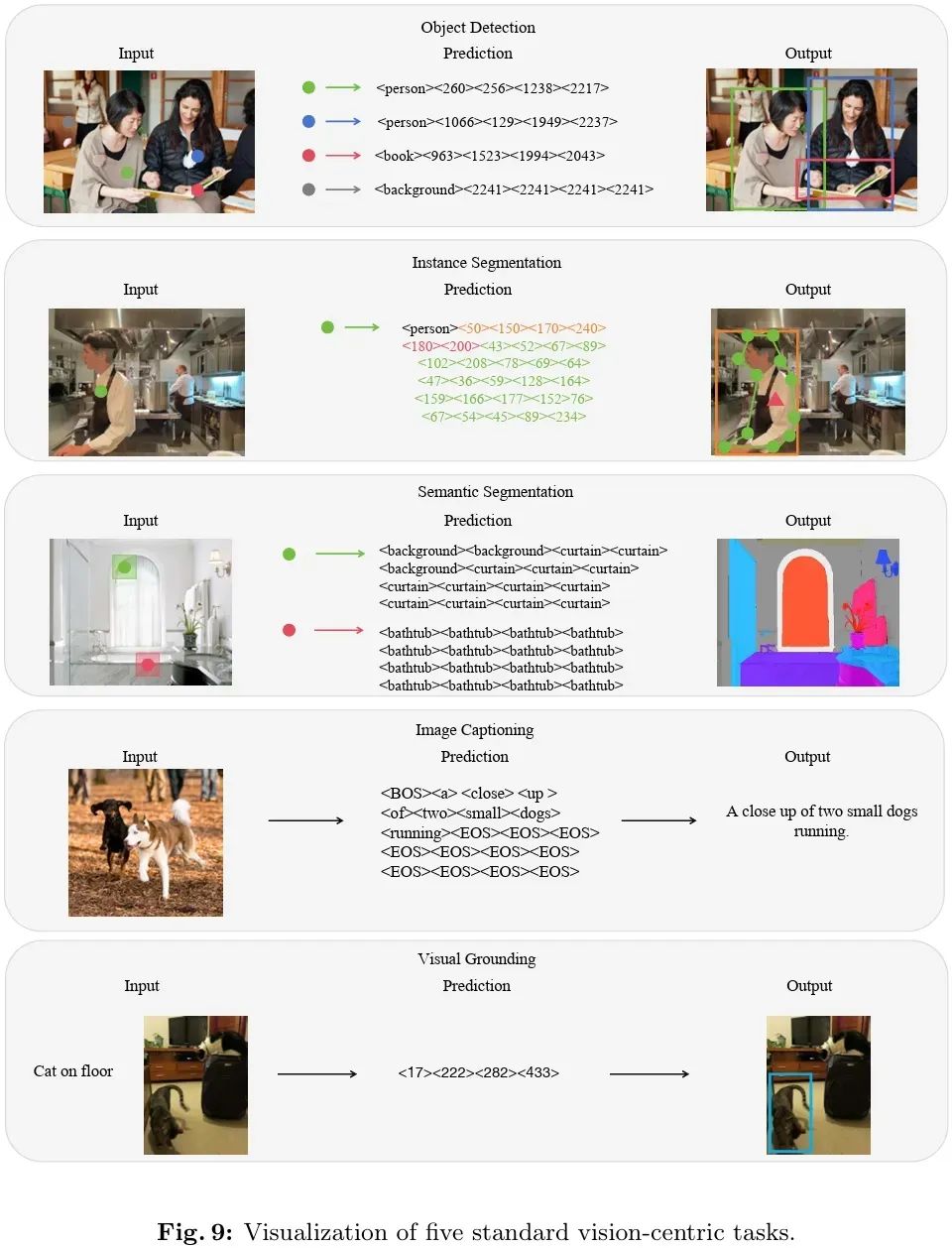

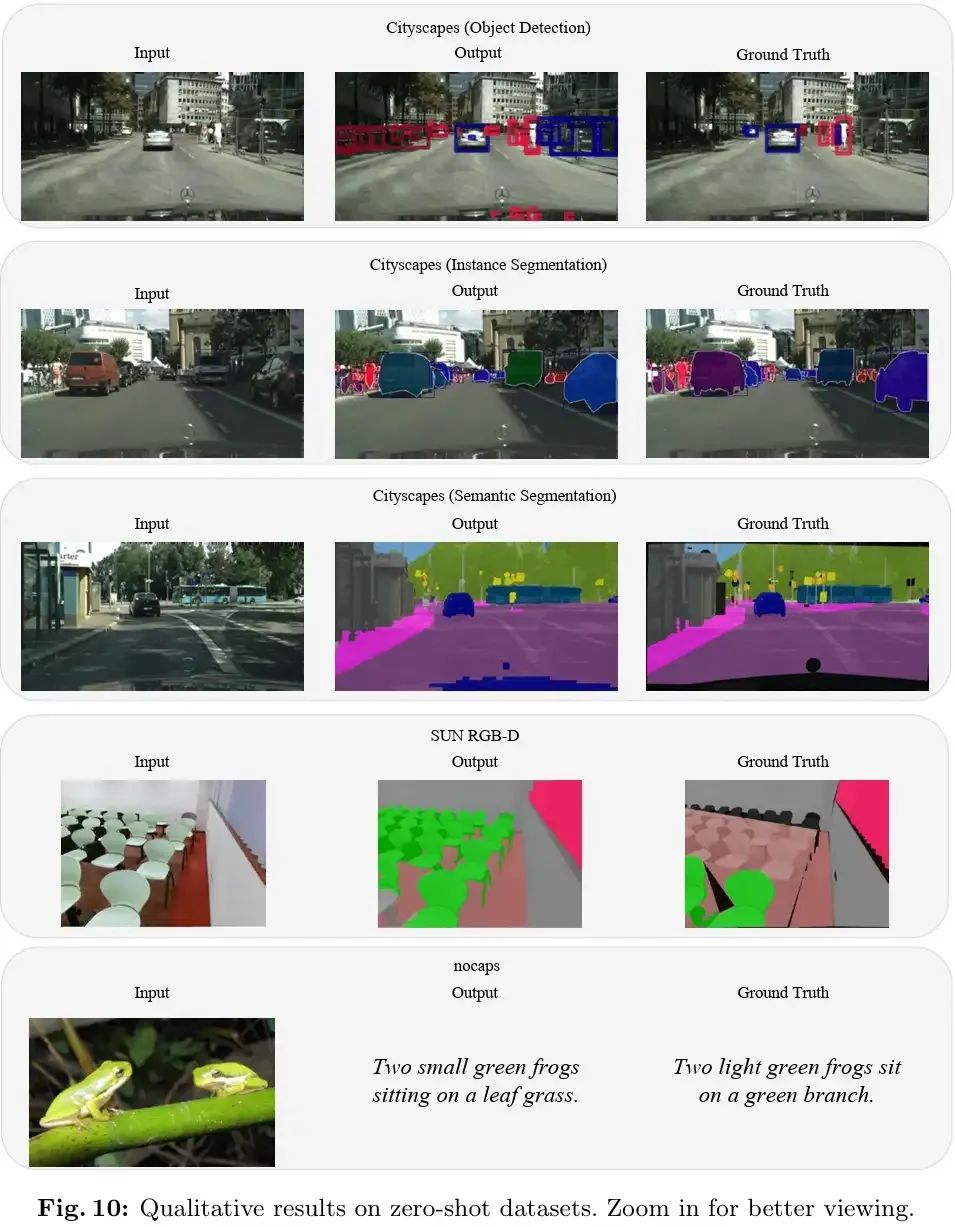

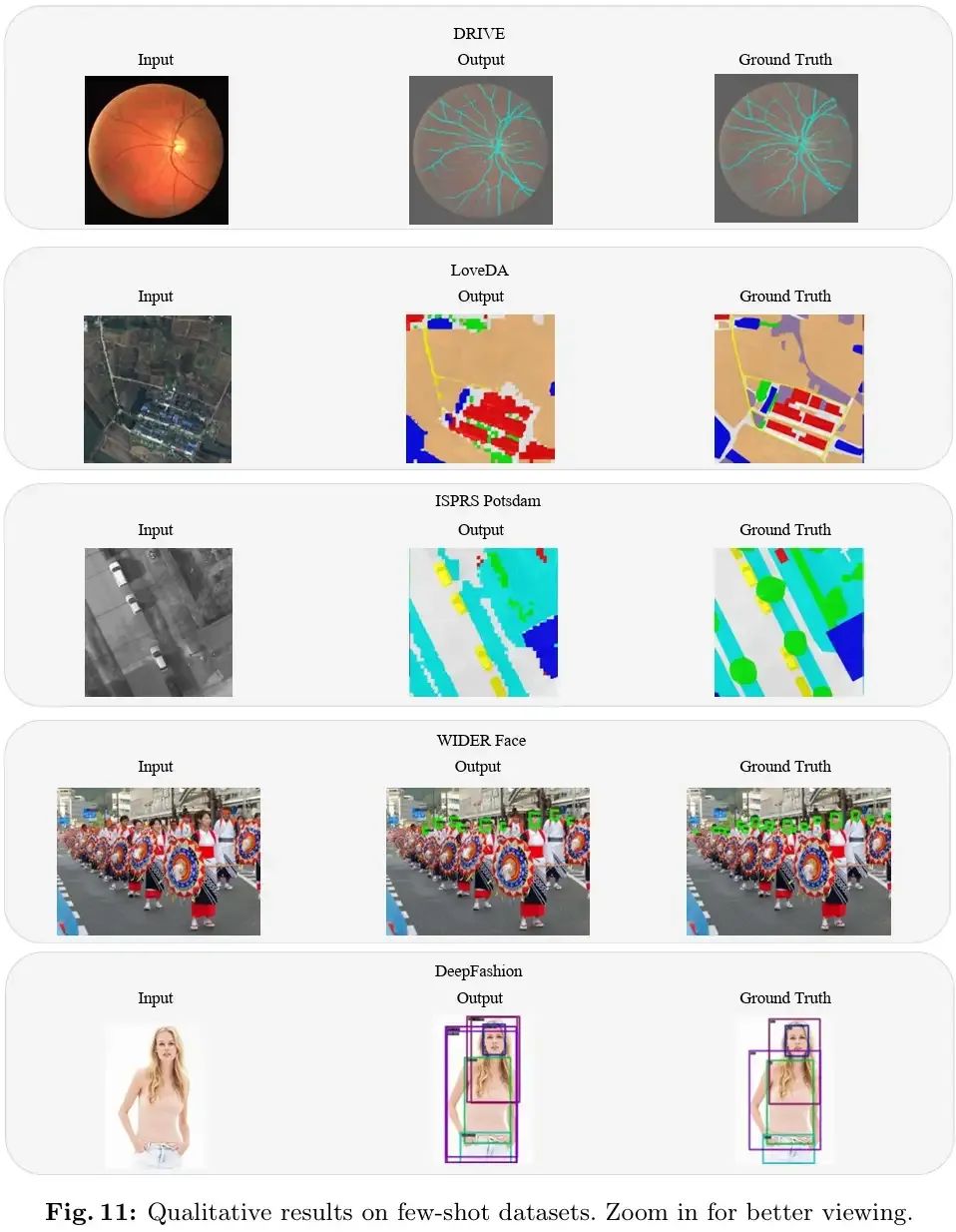

本文提出了一种简单而有效的框架,名为GiT,仅通过基本的ViT即可同时应用于各种视觉任务。受到在大型语言模型(LLMs)中广泛使用的多层Transformer架构(例如GPT)的普适性的启发,我们试图扩大其范围,使其成为一个强大的视觉基础模型(VFM)。然而,与语言建模不同,视觉任务通常需要特定的模块,比如用于检测的边界框头和用于分割的像素解码器,这极大地阻碍了在视觉领域应用强大的多层Transformer。为了解决这个问题,我们设计了一个通用的语言接口,使成功的自回归解码能够灵活统一各种视觉任务,从图像级理解(例如字幕生成),到稀疏感知(例如检测),再到密集预测(例如分割)。基于以上设计,整个模型仅由ViT组成,没有任何特定的添加,提供了显著的架构简化。GiT是一个多任务视觉模型,跨越五个代表性基准进行联合训练,无需特定任务的微调。有趣的是,我们的GiT在通用性能上建立了一个新的基准,并促进了任务之间的相互增强,导致与孤立训练相比显著的改进。这反映了LLMs中观察到的类似影响。通过对27个数据集进行进一步丰富的训练,GiT在各种任务上取得了强大的零样本结果。由于其简单的设计,这一范式有望缩小视觉和语言之间的架构差距。

| Subjects: | Computer Vision and Pattern Recognition (cs.CV) |

| Cite as: | arXiv:2403.09394 [cs.CV] |

动机

受到在大型语言模型中广泛使用的多层Transformer架构的启发,如GPT。

希望将这种普适性应用于视觉任务,构建一个强大的视觉基础模型。

方法

提出了一种名为GiT的简单而有效的框架。

设计了一个通用的语言接口,使得自回归解码能够灵活统一各种视觉任务。

整个模型仅由ViT组成,没有任何特定的添加,实现了架构的显著简化。

结果

GiT是一个多任务视觉模型,跨越五个代表性基准进行联合训练,无需特定任务的微调。

在通用性能上建立了一个新的基准,并促进了任务之间的相互增强,导致与孤立训练相比显著的改进。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer5555,即可添加CVer小助手微信,便可申请加入CVer-Mamba或者Transformer微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer5555,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集近万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

234

234

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?