点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信:CVer2233,助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪必备!

转载自:极市平台 | 作者丨王淏辰@知乎(已授权)

来源:https://zhuanlan.zhihu.com/p/19997220245

导读

探讨CrossFormer在多模态大模型中的创新设计,特别是其如何通过跨尺度交互解决多模态任务中的尺度差异问题,为多模态领域的发展提供了新的思路和方法。

今天介绍我们在多模态大模型领域的一篇原创工作:Reconstructive Visual Instruction Tuning

arXiv Paper: https://arxiv.org/pdf/2410.09575

Project Page: https://haochen-wang409.github.io/ross/

GitHub Code: https://github.com/haochen-wang409/ross

Huggingface Checkpoint: https://huggingface.co/HaochenWang/ross-qwen2-7b

目前 Ross 已被 ICLR 2025 接收,相关代码已开源,有任何问题欢迎在 GitHub 提出。

TL; DR

我们针对多模态大模型的视觉部分设计了重建原图形式的监督信号,该监督能够显著提升模型细粒度理解能力以及减轻幻觉。我们认为这是多模态大模型的 MAE 时刻,如何针对多模态大模型设计更好的 visual pre-text task 是后续研究的重点。

1. Motivation

在当今的多模态学习领域,多模态大模型尽管希望处理的是视觉数据,但其核心训练过程却几乎完全依赖于文本监督,即 “images --> CLIP --> LLM <== _text supervision_” 的架构。

这种做法缺乏对原始视觉信号的充分利用,模型的性能也很大程度上受限于被视觉表征的好坏。

为了突破这一瓶颈,我们提出了一种全新的方法——**Reconstructive Visual Instruction Tuning (Ross)**。

Ross 引入了视觉监督。它让大型多模态模型(LMMs)直接从输入图像中学习,通过重构图像来指导自身的优化过程。这种方式不仅充分利用了图像本身的丰富细节,还能够显著提升模型对细粒度视觉特征的理解能力。

2. Method

既然输入的图像本身就蕴含着大量的细节信息,为什么不直接利用它们来指导模型的学习呢?通过重构输入图像作为监督信号,我们鼓励模型保持对低级细节的关注,从而增强了其细粒度的理解能力,并减少了幻觉现象的发生。

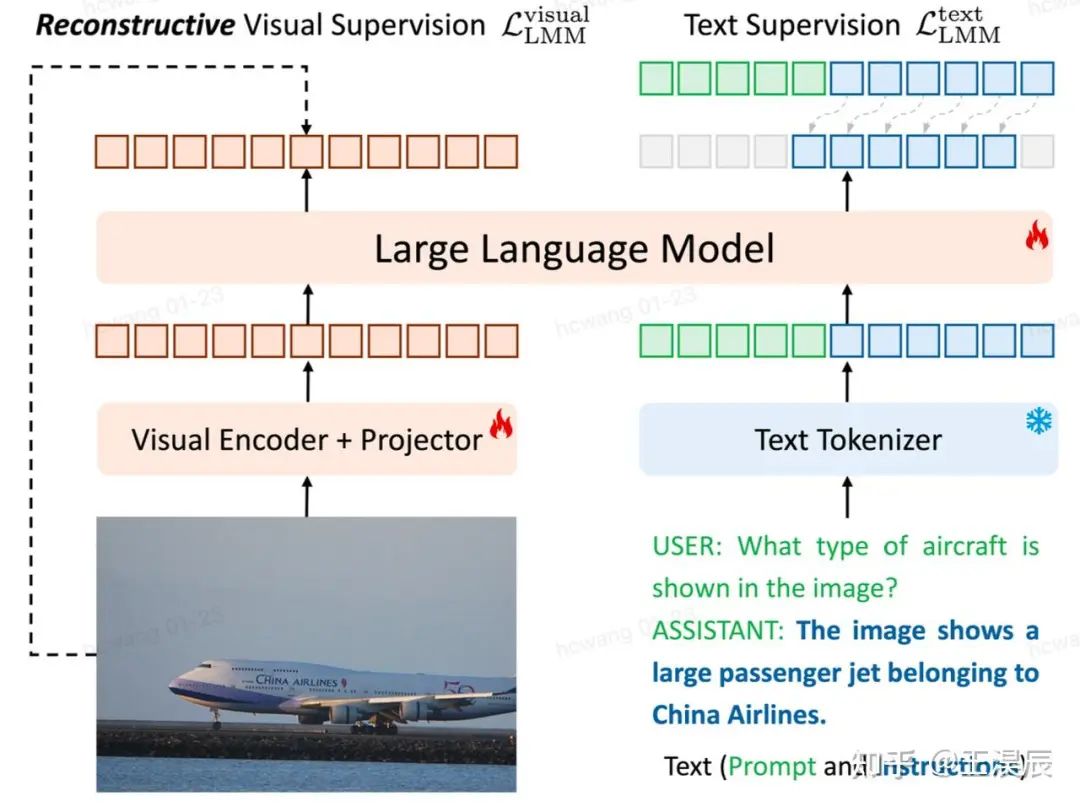

上图展示了 Ross 的 high-level idea。不同于传统的多模态大模型只利用了右半部分的 text supervision,Ross 引入了左半部分的 visual supervision。

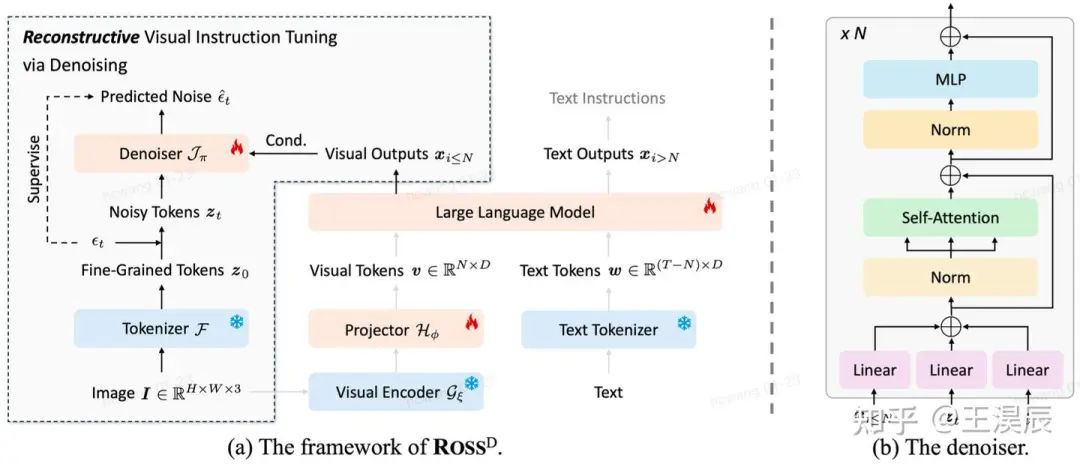

在这个过程中,自然图像的空间冗余性,难以为 LLM 直接提供有意义的监督信号。为此,我们系统性地研究了 (1) 重建目标 (2) 重建损失,最终得到了一个巧妙的解决方案:采用去噪目标来重构隐特征,如下图所示。

3. Experiments

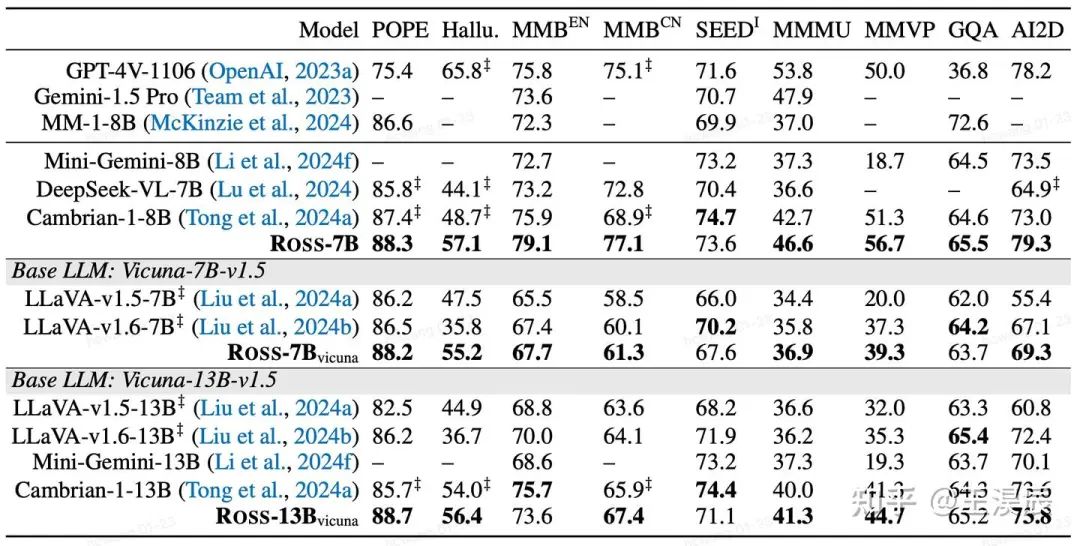

Ross 在不同的 visual backbone + LLM 上,在多数情况都能获得显著的性能提升,特别是在 MMVP 这类细粒度理解任务上

Ross 与 SOTA 方法的比较,仅仅使用一个 SigLIP,Ross 就能超越 Cambrian-1-8B 这个合并了 CLIP+SigLIP+ConvNeXt+DINOv2 的方法

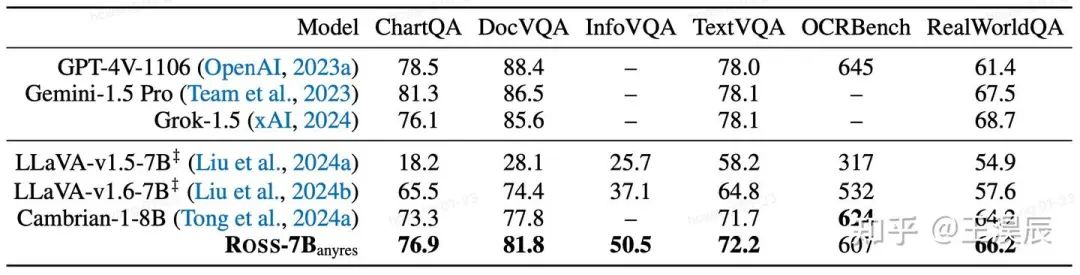

引入 anyres 技巧后,Ross 在高分辨率 benchmark 上也能取得优越的性能

4. In-Depth Analysis

绝对的数字并不是最关键的,我们更应该关注为什么 Ross 这类视觉监督能 work。我们得出了以下的结论:

引入视觉监督能带来更高的 attention values,多模态大模型更加看图了

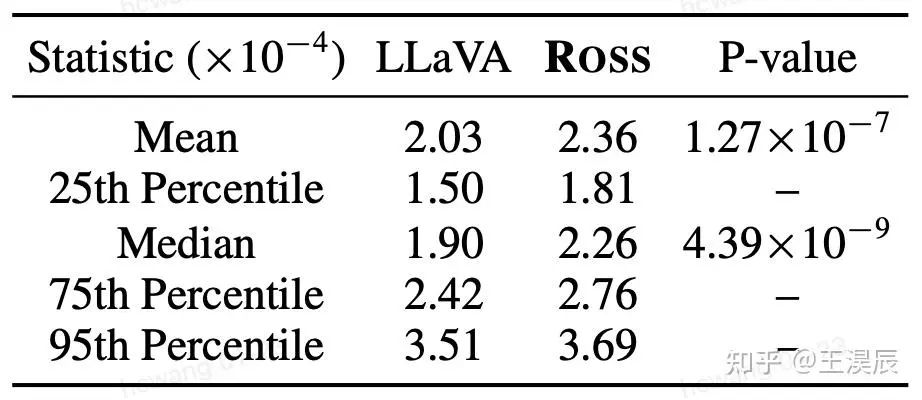

Ross 和 LLaVA 对于视觉 token 的 attention value 对比,Ross 的 attention values 显著高于 LLaVA 的

引入视觉监督能带来更合理的 attention map,多模态大模型更能关注到正确的区域

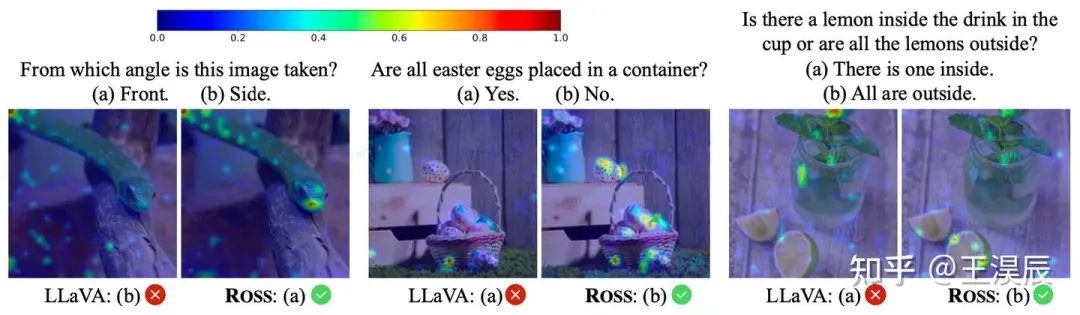

Ross 对 visual tokens 的 attention map 更合理,更能关注到问题相关的区域

引入视觉监督能让模型的特征包含足够的细粒度信息,把 frozen Ross-7B 的 feature 作为 condition,仅将 denoiser 在 ImageNet-1K 上 fine-tune 5 个 epoch,就能重建出图!

原图 (左) 和重建结果 (右)。Ross-7B 的特征可以被完美的映射回 RGB space!

其中,最后一点是我们认为最有趣的发现,该结果表明,image --> SigLIP --> Qwen2 之后得到的特征,通过 Ross 这样的训练后,竟然还能被映射回原始的 RGB pixel space。这说明 Ross 对于图像信息的压缩较少,保留了细粒度理解所需要的细节信息。

5. Discussion and Future Work

我们认为 Ross 的成功,是多模态大模型的 MAE 时刻,如何针对多模态大模型设计更好的 visual pre-text task 将是后续研究的重点,LMM 的范式不应该只是 text 端的 next-token-prediction!

当然,Ross 还有很多非常 straightforward 的拓展,例如拓展至生成领域,真正做到生成帮助理解。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer2233,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer2233,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

6180

6180

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?