第2 章模型评估与选择

2 .1 经验误差与过拟合

通常我们把分类错误的样本数占样本总数的比例称为“错误率”(error rate ),即如果在m 个样本中有a 个样本分类错误,则错误率E = a /m ;相应的,1-E称为 “精度”(accuracy),即 “精度= 1-错误率”。

更一般地,我们把学习器的实际预测输出与样本的真实输出之间的差异称为“误差”(error),学习器在训练集上的误差称为 “训练误差”(training error)或 “经验误差”(empirical error),在新样本上的误差称为“泛化误差”(generalization error)

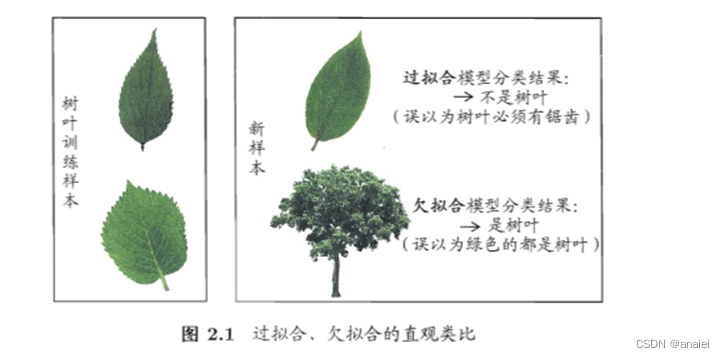

过拟合的意思是说模型的学习能力过于强大,以至于把训练样本中所包含的不太一般的特性都学到了,这样就会导致泛化性能下降。这种现象在机器学习中称为“过拟合”(overfitting)。与 “过拟合”相对的是“欠拟合”(underfitting),这是指对训练样本的一般性质尚未学好。

💡过拟合欠拟合的直观类比:

2.2 模型评估方法

模型评估需要一个“测试集”(testing set)来测试学习器对新样本的判别能力,然后以测试集上的“测试误差”(testing error)作为泛化误差的近似。也要考虑吧测试样本尽量不在训练集中出现、未在训练过程中使用过。

2.2.1留出法

“留出法”(hold-out)直接将数据集。划分为两个互斥的集合,其中一个集合作为训练集S ,另一个作为测试集T。需注意的是,训练/测试集的划分要尽可能保持数据分布的一致性,避免因数据划分过程引入额外的偏差而对最终结果产生影响。

2.2.2 交叉验证法

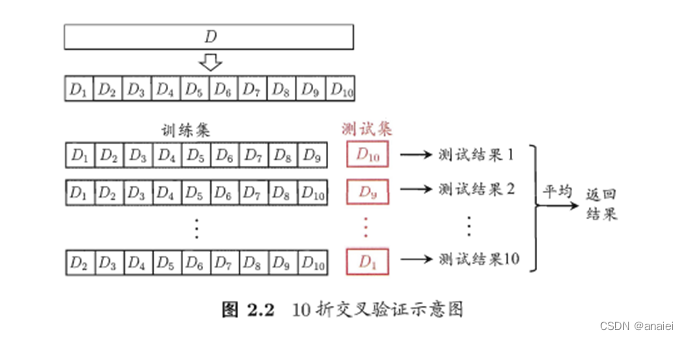

“交叉验证法”(cross validation)先将数据集D划分为k个大小相似的互斥子集。然后,每次用k-1个子集的并集作为训练集,余下的那个子集作为测试集。把交叉验证法称为“k 折交叉验证”(k-fold cross validation), k 最常用的取值是10,此时称为10折交叉验证。

💡10折交叉验证的示意图:

2.2.3自助法

每次随机从D数据集。中挑选一个样本,将其拷贝放入D数据集中,然后再将该样本放回初始数据集D 中,使得该样本在下次采样时仍有可能被采到。显然,D中有一部分样本会在中多次出现,而另一部分样本会在D不出现。

D\D` 用作测试集,而我们仍有数据总量约1 /3 的,没在训练集中出现的样本用于测试。这样的测试结果,亦称 “包外估计”。

💡优点:自助法在数据集较小、难以有效划分训练/测试集时很有用。

2.2.4调参与最终模型

在进行模型评估与选择时,除了要对适用学习 算法进行选择,还需对算法参数进行设定,这就是通常所说的“参数调节”或简称“调参”(parameter tuning).

为了加以区分,模型评估与选择中用于评估测试的数据集常称为“验证集” (validation set)

我们通常把学得模型在实际使用中遇到的数据称为“测试数集”(test set)。

2 . 3 性能度量

衡量模型泛化能力的评价标准,这就是性能度量(performance measure).

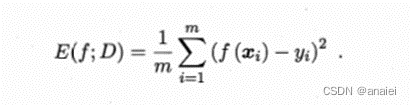

回归任务最常用的性能度量是“均方误差”(mean squared error)MSE

2.3.1错误率与精度

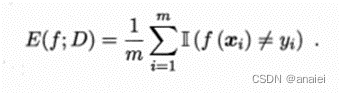

这是分类任务中最常用的两种性能度量,既适用于二分类任务,也适用于多分类任务。

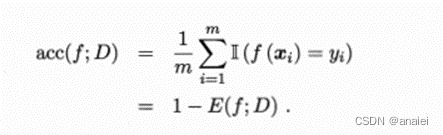

错误率是分类错误的样本数占样本总数的比例,对样例集D。

精度则是分类正确的样本数占样本总数的比例。对样例集D。

2.3.2 查准率、查全率与F1

错误率和精度虽常用,但并不能满足所有任务需求。

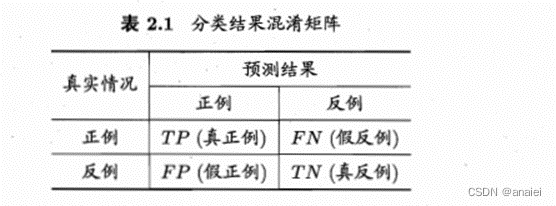

在信息检索、Web搜索等应用中经常出现,例如在信息检索中,我们经常会关心“检索出的信息中有多少比例是用户感兴趣的”“用户感兴趣的信息中有多少被检索出来了”、“查准率”(precision)与“查全率”(recall)是更为适用于此类需求的性能度量。

对于二分类问题,则显然有TP + FP + TN + FN = 样例总数

查准率P 与查全率R 分别定义为

一般来说,查准率高时,查全率往往偏低;而查全率高时,查准率往往偏低。

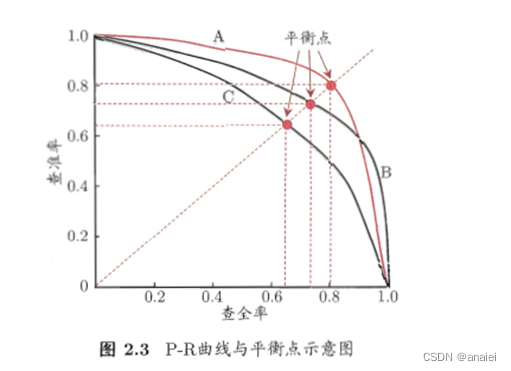

比较学习器好坏,以查准率为纵轴、查全率为横轴作图,就得到了“查准率-查全率”曲线,简“P-R曲线”

“平衡点”(Break-Event Point,简 称 BEP)就是这样一个度量,它是“查准率=查全率”,时的取值。

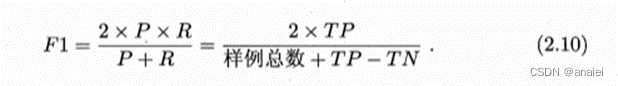

但 BEP还是过于简化了些,更常用的是F1度量

很多时候我们有多个二分类混淆矩阵,例如进行多次训练/测试,每次得到一个混淆矩阵。

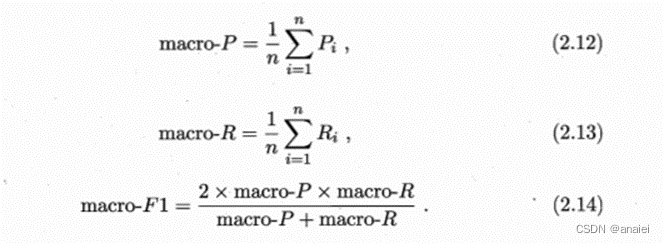

一 种直接的做法是先在各混淆矩阵上分别计算出查准率和查全率,记为(P1,R1),(P2,R2),…(Pn,Rn)再计算平均值,这样就得到“宏查准率”(macro-P)、“宏查全率”(macro-R),以及相应的“宏Fl”(macro-Fl)

2.3.3 ROC与AUC

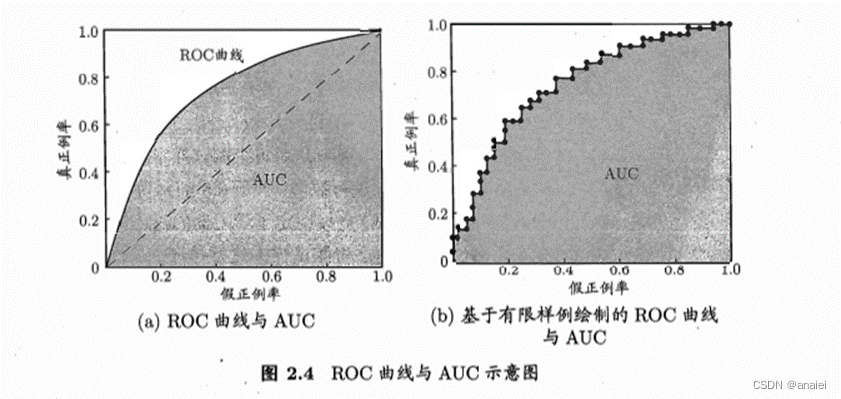

在不同的应用任务中,我们可根据任务需求来采用不同的截断点,例如若我们更重视“查准率”,则可选择排序中靠前的位置进行截断;若更重视“查全率”,则可选择靠后的位置进行截断。ROC曲线则是从这个角度出发来研究学习器泛化性能的有力工具。

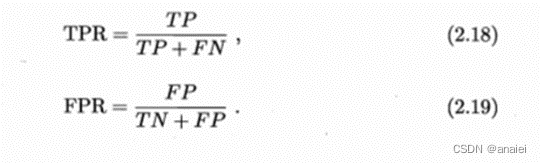

ROC曲线的纵轴是“真正例率”(True Positive Rate ,简称 TPR ) , 横轴是“假正例率”(False Positive Rate,简称FPR)

AUC可通过对ROC曲线下各部分的面积求和而得

1119

1119

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?