Tensorboard是一个非常好用的深度学习可视化工具,能够将训练过程loss变化、模型结构等可视化显示,方便我们了解细节,在使用TensorFlow框架时经常用到。TensorboardX则是适用于PyTorch框架的可视化工具,使用方法基本类似。

本文主要解决使用PyTorch和TensorboardX出现的一些问题。

1. 出现“Found more than one “run metadata” event with tag step1. Overwriting it with the newest event.”等问题

在使用PyTorch和TensorboardX时,我们需要先定义一个writer

writer = SummaryWriter(logdir='./log')

然后通过

writer.add_graph(Model,(dummyInput,))

writer.add_scalars('Train_loss', {"train_loss": loss.data.item()}, niter)

写入需要可视化的数据,然后在命令行通过如

tensorboard --logdir ./log --port 9999

以及其他所需要的参数启动,浏览器访问对应的host:port就可以看到可视化结果。

但有时候我们会遇到类似:

“Found more than one graph event per run, or there was a metagraph containing a graph_def, as well as one or more graph events. Overwriting the graph with the newest event.” 或 “Found more than one “run metadata” event with tag step1. Overwriting it with the newest event.” 等的警告信息,而且很可能添加的scalar也看不到了

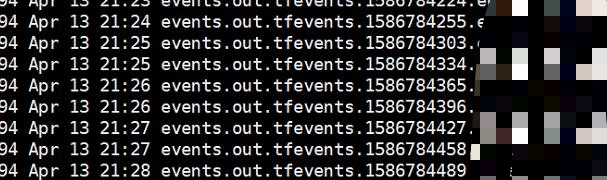

这个时候我们可以查看保存log的位置,一般都会有多个event数据,如:

这种情况可能是因为writer被多次打开写入又关闭造成的,每次重新打开writer写入的数据就会放在新的events内。

这种情况可能是因为writer被多次打开写入又关闭造成的,每次重新打开writer写入的数据就会放在新的events内。

我个人遇到这种情况是由于一种代码习惯,比如:

with writer:

writer.add_scalars('Train_loss', {"train_loss": loss.data.item()}, niter)

这种with的方式,当代码中有多个需要add_scalars的地方时,就会造成保存的log包含许多events,最终可视化出错。

实际上并不需要每次add_scalars后都关闭,

for e in epochs:

writer.add_scalars('Train_loss', {"loss1": loss1.data.item()}, e)

'''

balabala

'''

writer.add_scalars('Train_loss', {"loss2": loss2.data.item()}, e)

writer.close()

直接使用writer写入log,程序结束时调用close关闭即可,这样最后就只有一个events文件了。

2. 可视化多个网络模型问题

这个问题常常在一个拥有多个网络、而且彼此之间不连接(没有用sequential layer组合连接起来),比如GAN网络,generator和discriminator是各自独立的,这种情况如果要想在一次训练过程中保存多个模型,就需要多次调用writer.add_graph(),但实际操作我们会发现,多次调用最终的可视化结果只会保留最后一次的模型graph。目前TensorboardX确实不支持多次使用writer.add_graph()。这一点可以参考github的对应issue:TensorboardX add_graph() multiple times

这也与Tensorboard的实现有关,可以看到作者也在关注这一问题,有兴趣的小伙伴也可以前往链接看看一些目前可行的方案。

8771

8771

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?