人工神经网络(Artificial Neural Network,ANN)也简称为神经网络(NN),它是一种模仿生物神经网络(动物的中枢神经系统,特别是大脑)的结构和功能的数学模型或计算模型。

训练一个神经网络通常需要提供大量的数据,我们称之为数据集。数据集一般被分为三类,即训练集(Training Set)、验证集(Validation Set)和测试集(Test Set)。

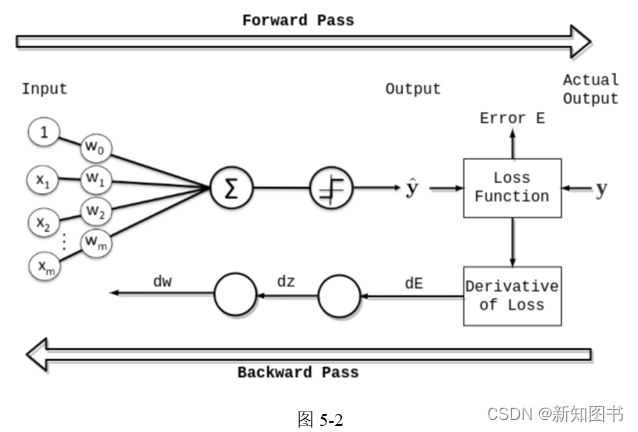

一个Epoch就等于使用训练集中的全部样本训练一次的过程。所谓训练一次,指的是进行一次正向传播(Forward Pass)和反向传播(Backward Pass),如图5-2所示。

当一个Epoch的样本(也就是训练集)数量太过庞大的时候,进行一次训练可能会消耗过多的时间,并且每次训练都使用训练集的全部数据是不必要的。因此,我们需要把整个训练集分成多个小块,也就是分成多个Batch来进行训练。一个Epoch由一个或多个Batch构成,Batch为训练集的一部分,每次训练的过程只使用一部分数据,即一个Batch。我们称训练一个Batch的过程为一个Iteration。

PyTorch提供了torch.nn库,它是用于构建神经网络的工具库。torch.nn库依赖于autograd库来定义和计算梯度。nn.Module包含神经网络的层以及返回输出的forward(input)方法。

以下是一个简单的神经网络的构建示例:

#######pytorch-nn-demo1.py###############

import torch

import torch.nn as nn

import torch.nn.functional as F

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

# 输入图像channel:1,输出channel:6,5×5卷积核

self.conv1 = nn.Conv2d(1, 6, 5)

self.conv2 = nn.Conv2d(6, 16, 5)

# 全连接层

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

# 使用2×2窗口进行最大池化

x = F.max_pool2d(F.relu(self.conv1(x)), (2, 2))

# 如果窗口是方的,只需要指定一个维度

x = F.max_pool2d(F.relu(self.conv2(x)), 2)

x = x.view(-1, self.num_flat_features(x))

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

def num_flat_features(self, x):

size = x.size()[1:] # 获取除batch维度外的其他维度

num_features = 1

for s in size:

num_features *= s

return num_features

net = Net()

print(net)

结果输出如下:

Net(

(conv1): Conv2d(1, 6, kernel_size=(5, 5), stride=(1, 1))

(conv2): Conv2d(6, 16, kernel_size=(5, 5), stride=(1, 1))

(fc1): Linear(in_features=400, out_features=120, bias=True)

(fc2): Linear(in_features=120, out_features=84, bias=True)

(fc3): Linear(in_features=84, out_features=10, bias=True)

)

以上就是一个简单的神经网络的构建方法。首先定义了一个Net类,这个类继承自nn.Module。然后在__init__方法中定义了网络的结构,在forward方法中定义了数据的流向。在网络的构建过程中,我们可以使用任何张量操作。需要注意的是,backward函数(用于计算梯度)会被autograd自动创建和实现。你只需要在nn.Module的子类中定义forward函数。PyTorch的一个重要功能就是autograd,它是为方便用户使用,而专门开发的一套自动求导引擎,能够根据输入和前向传播过程自动构建计算图,并执行反向传播。

本文节选自《PyTorch深度学习与企业级项目实战》,获出版社和作者授权发布。

本文介绍了人工神经网络的基本概念,详细阐述了数据集的训练集、验证集和测试集划分,以及在PyTorch中如何使用torch.nn库构建和训练神经网络,包括批量处理(Batch)和反向传播的过程。以一个简单的Net类为例,展示了如何利用autograd进行自动求导和梯度计算。

本文介绍了人工神经网络的基本概念,详细阐述了数据集的训练集、验证集和测试集划分,以及在PyTorch中如何使用torch.nn库构建和训练神经网络,包括批量处理(Batch)和反向传播的过程。以一个简单的Net类为例,展示了如何利用autograd进行自动求导和梯度计算。

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?