©PaperWeekly 原创 · 作者|董汉德

学校|中国科学技术大学硕士生

研究方向|信息检索

摘要

近些年来,推荐系统的偏差越来越受到研究者的关注。训练推荐模型的数据大多为观测所得,而非实验所得,这意味着数据中存在大量的偏差,直接拿模型拟合数据而忽略这种偏差将会导致性能欠佳。

该论文提出了一种基于元学习(meta-learning)的去偏方法,该方法包括两部分:1)总结归纳出了一种通用的去偏框架,该框架能够处理所有推荐系统中的偏差,将寻找最优去偏策略问题转化为设置框架中的去偏参数问题;2)利用少量的无偏数据作为监督信息,采用元学习的策略来学习框架中的去偏参数从而实现自适应的纠偏。

论文题目:

AutoDebias: Learning to Debias for Recommendation

收录会议:

SIGIR 2021

论文链接:

https://arxiv.org/abs/2105.04170

代码链接:

https://github.com/DongHande/AutoDebias

研究背景

推荐系统所用的数据中,偏差广泛存在,常见的偏差包括:

1. 选择偏差(selection bias):用户倾向于选择喜欢的物品进行交互;

2. 一致性偏差(conformity bias):用户的对物品的评价会受到群体意见的影响;

3. 曝光偏差(exposure bias):用户只被曝光在推荐系统展示的物品上并只与这些物品产生交互;

4. 位置偏差(position bias):用户和物品的交互情况可能被物品在推荐列表中的位置所影响。

目前的去偏算法主要可以分成三类:

1. 反倾向分数:估计数据被观测到的倾向性分数,并在每条数据样本利用倾向分数的倒数重加权;

2. 数据填充:由于观测到的数据往往是整个用户-物品矩阵中一个很小的有偏子集,可以通过对矩阵的合理填充来去偏;

3. 生成模型:假设数据的因果生成过程,通过优化整体的概率生成模型以挖掘出用户的真实兴趣。

这些方法能起到一定的去偏效果,然而其也具有如下的局限性:

1. 缺乏普适性:现有的去偏方法都是针对某一种/两种特定的偏差设计的,然而,现实数据中的偏差往往是多种并存的,在这中场景下现有方法无法取得很好的效果;

2. 缺乏自适应能力:现有方法往往依赖于专家的假设,例如假设倾向分数、矩阵填充值。然而数据中的偏差往往隐含着复杂的模式,不易被专家察觉;且偏差的模式也会随着时间的变化而变化,靠专家察觉偏差的模式不仅费时费力,而且往往具有滞后性。因此如何设计出普适的、自适应调整的去偏方法具有重要意义。

方法介绍

方法介绍共分为三部分:去偏框架的建立、建模去偏参数、学习去偏参数。

3.1 去偏框架的建立

要想建立一个通用的去偏框架,了解偏差内在的原因是必要的。该文章指出:推荐系统中的偏差可以定义为对于经验风险函数的估计的期望和真实理想的风险函数之间的差异。

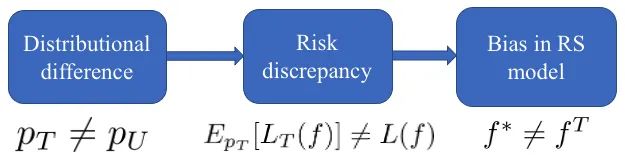

在推荐系统中,训练数据往往是观测所得,即生成训练数据的概率分布和生成测试数据的概率分布存在一定的不一致,这种不一致将会导致对于经验风险函数估计的期望和真实的风险函数存在差异,进而导致根据训练数据学习出的模型与最优模型之间的差异。整个过程可以用如图 1 表示:

▲ 图1 推荐系统中偏差的定义

其中, 代表生成训练集的分布, 代表生成测试集的分布; 表示模型训练的经验风险函数,其中 为训练集中的训练数据,满足分布 ;

AutoDebias 是一种基于元学习的推荐系统去偏方法,它建立了一个通用的去偏框架,通过学习去偏参数来适应不同类型的偏差,如选择偏差、一致性偏差等。该方法使用少量无偏数据进行监督,提高了推荐系统的性能和公平性。

AutoDebias 是一种基于元学习的推荐系统去偏方法,它建立了一个通用的去偏框架,通过学习去偏参数来适应不同类型的偏差,如选择偏差、一致性偏差等。该方法使用少量无偏数据进行监督,提高了推荐系统的性能和公平性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

994

994

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?